AWS Summit 2025 1일차

AWS Summit 2025 Seoul 1일차 기록

2025년, 올해도 어김 없이 AWS Summit 2025 Seoul이 5월에 진행되었습니다. 4만명이 등록을 하였고, 130개의 강연과 60개 이상의 고객 혁신 사례가 50여개의 스폰서와 함께 준비된 행사였습니다.

누군지 잘 모르겠지만.. (유명한 사람이겠죠?) DJ의 현란하고 신나는 음악을 들으며, 또한 AWS의 아이돌 Nova(?)의 KPOP 스타일의 음악을 시작으로 AWS Summit 2025의 키노트가 시작됩니다.

올해도 어김없이 기조연설은 언제나처럼 AI로 시작이 되었습니다.

지금 AI와 관련된 산업트렌드는 54%의 조직이 생성형 AI를 최우선 투자 항목으로 선택했으며, 63%는 이미CAIO를 보유하고 있으며, 26%는 2026년까지CAIO고용을 유지한다고 합니다. 또한 94%의 기업이 이미 생성형 AI를 도입하였습니다.

그리고 현재 AWS와 이 많은 기업들이 생성형 AI를 함께 한다고 합니다.

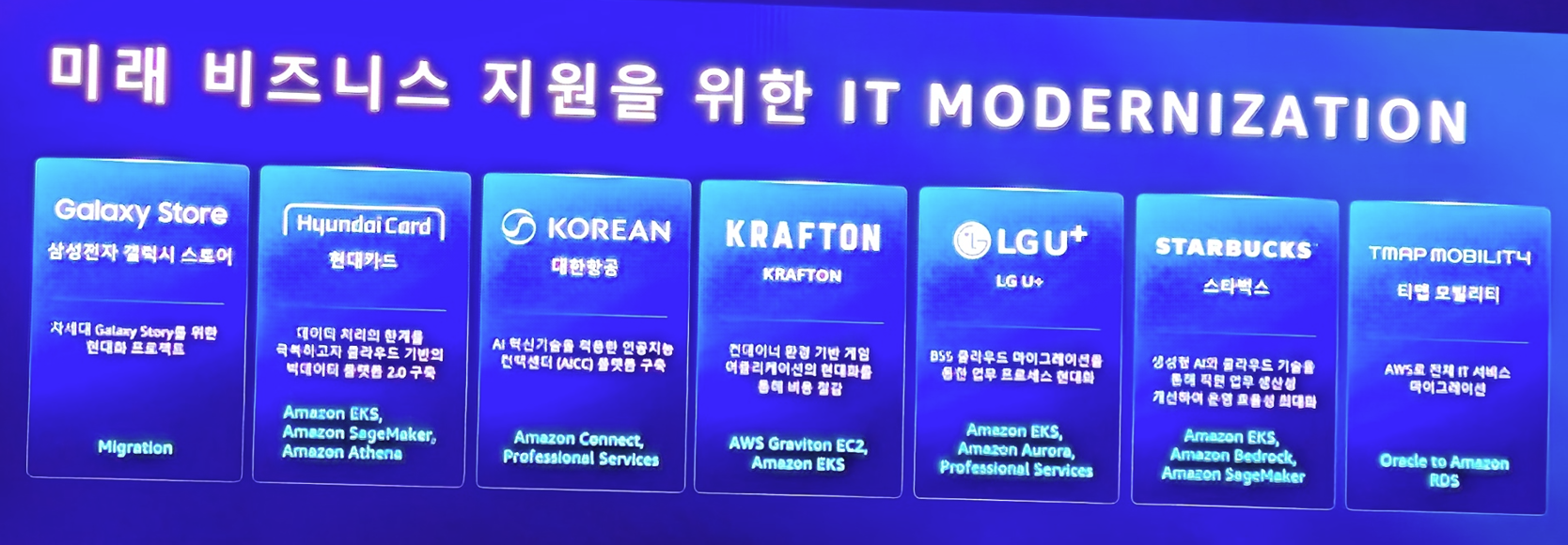

또한 AI 뿐만 아니라 여전히 Application 현대화에 아래와 같은 기업들이 AWS를 통해 일을 하고 있다고 합니다.

사실 언제나 기조 연설은 AWS의 서비스들의 소개와 현재 AWS가 나아갈 일들에 대한 소개이죠

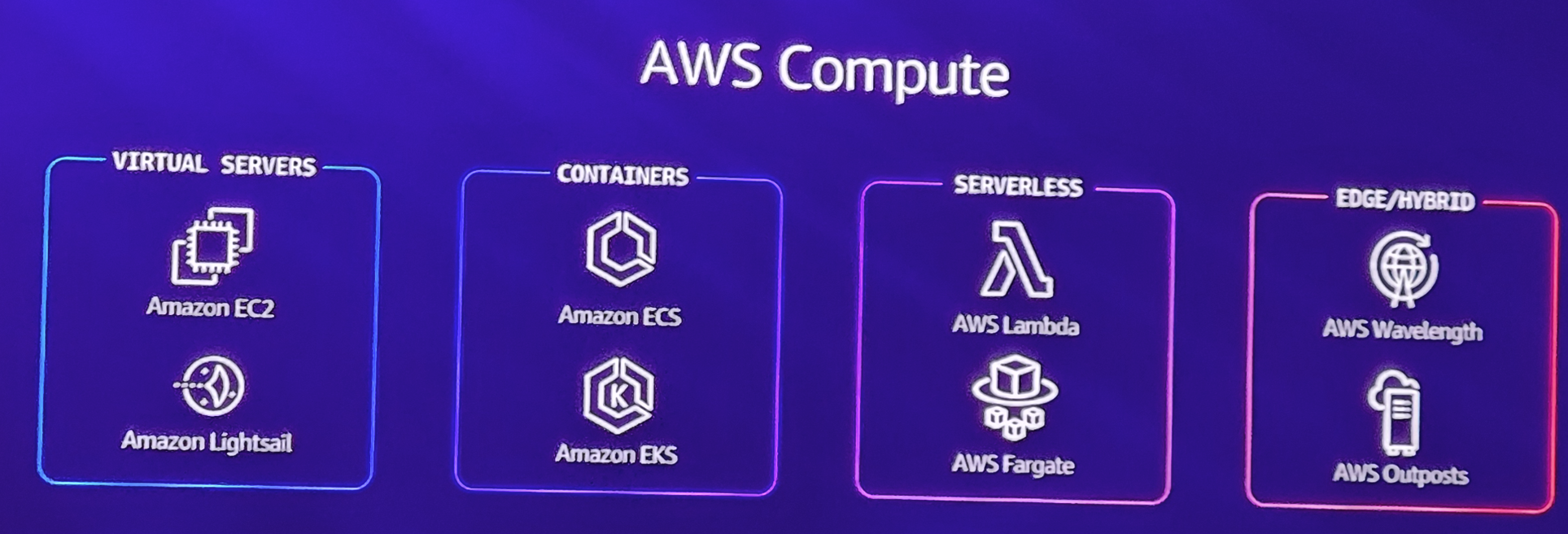

AWS의 대표 서비스들의 소개와 함께

자신들이 직접 만든 HW인 GRAVITON에 대한 소개

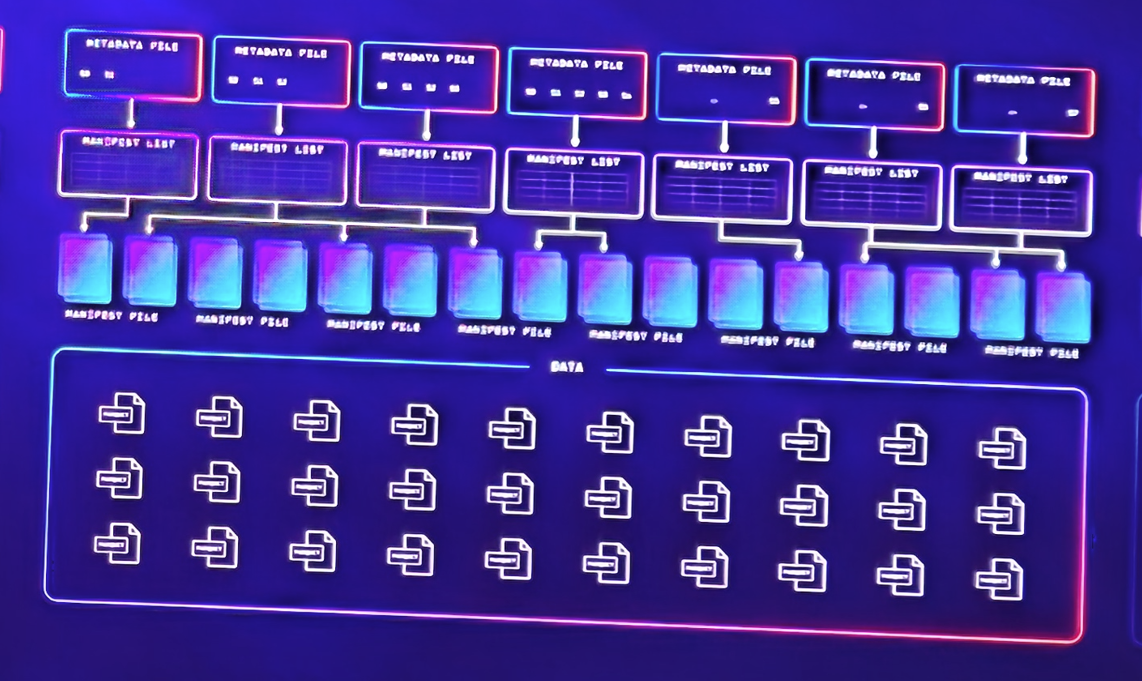

그리고 자신들이 확보한 수많은 클라우드 운영 경험과 데이터들

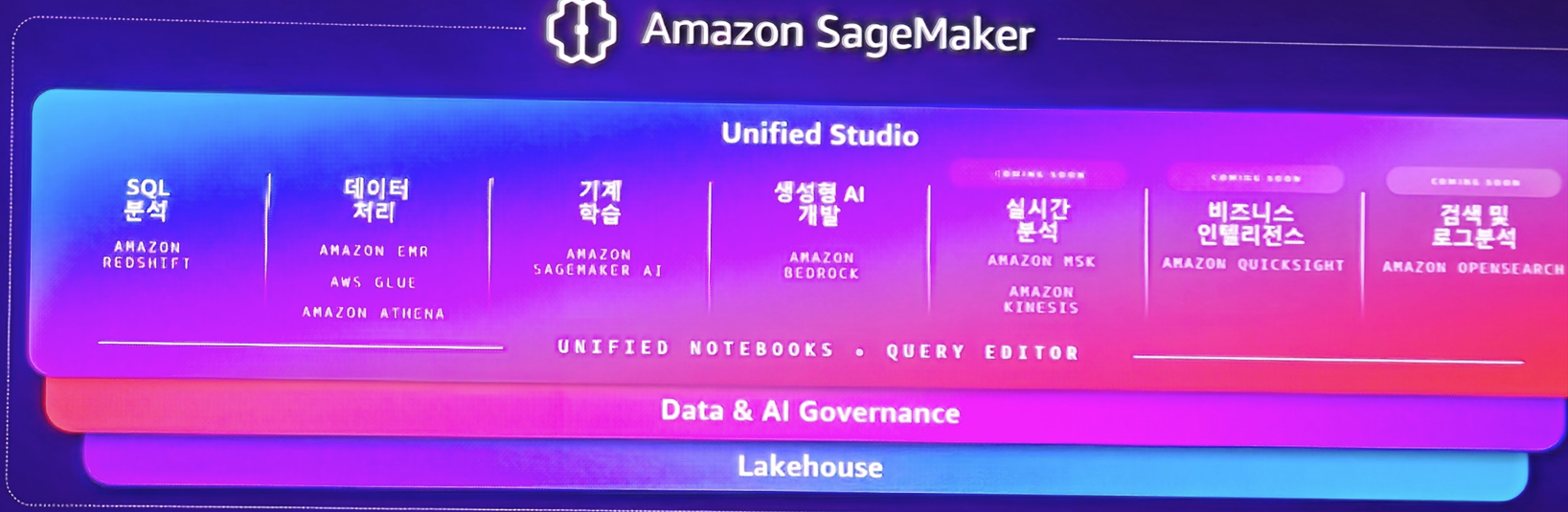

그리고 AI 시대를 위한 데이터 관리 기술 소개와 함께

AWS의 AI 핵심 기술인 Sage Maker에 대한 소개가 이루어졌습니다.

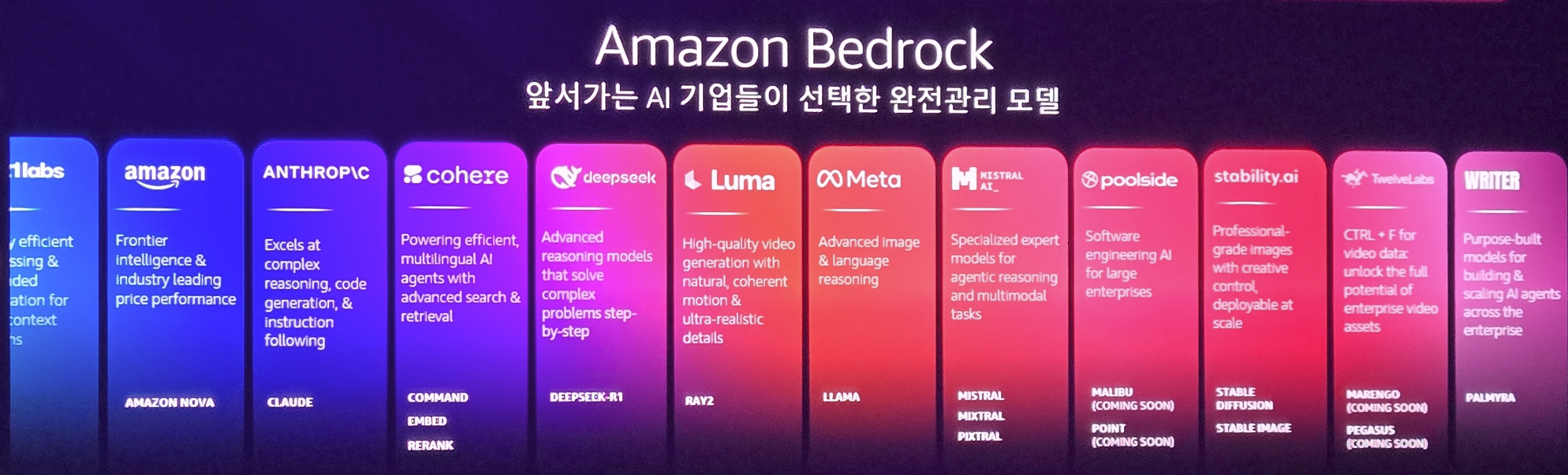

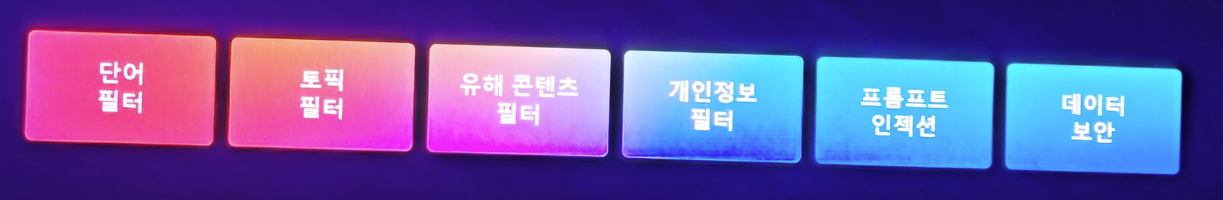

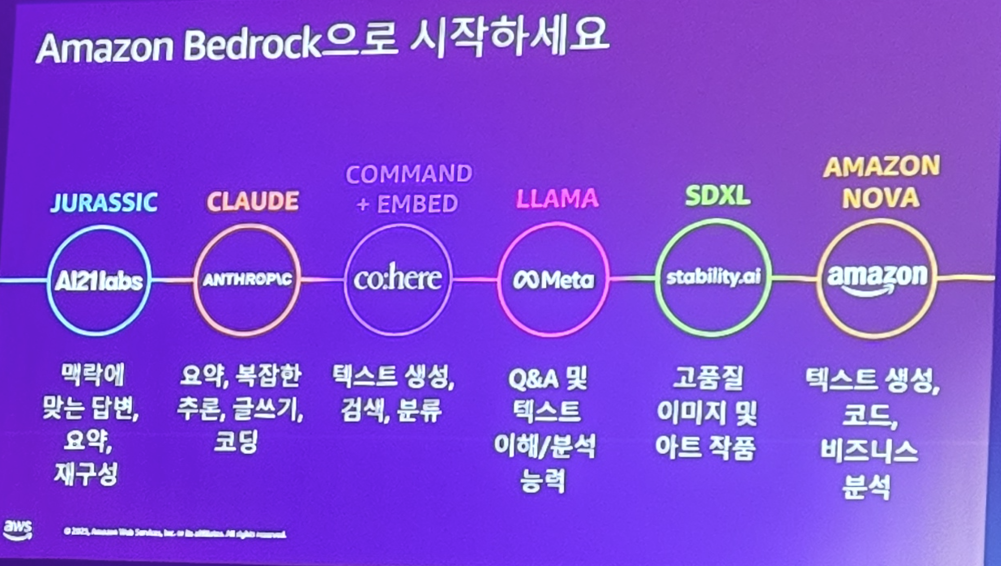

또한 Sage Maker만큼 중요한 Bedrock에 대한 소개도 있었습니다. 멀티 모델을 위한 솔루션으로 오픈소스 모델 및 Amazon 자신들의 서비스인 Nova 모델들에 대해서도 소개가 있었습니다.

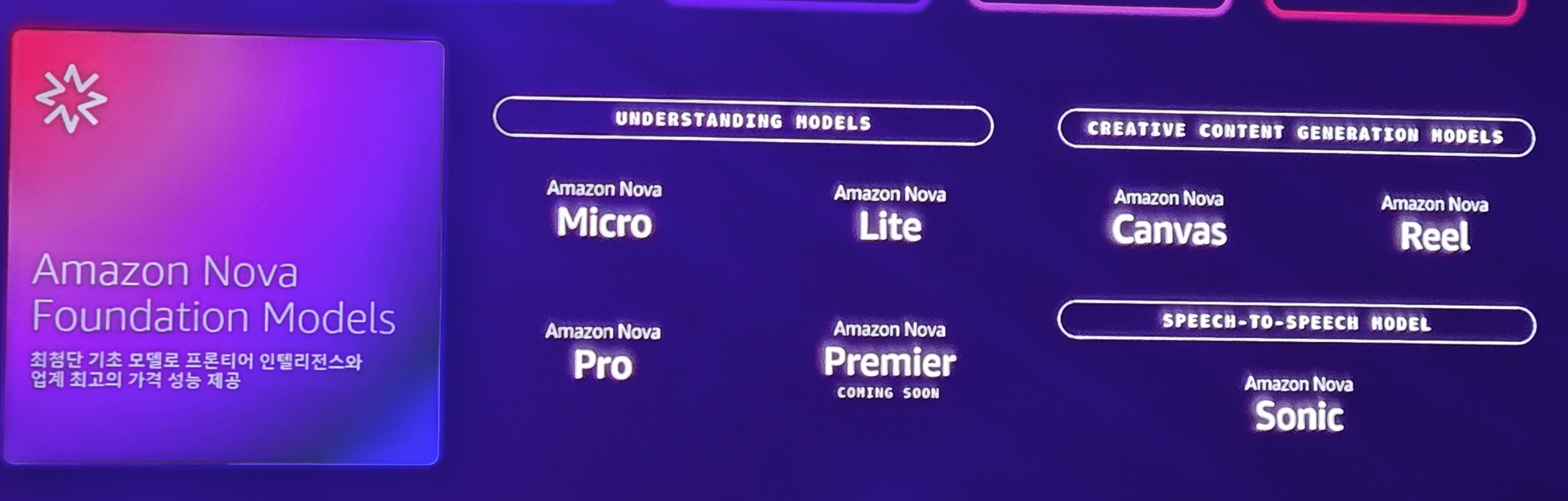

AWS는 멀티모달 및 추론을 위한 다양한 자체 모델을 Bedrock을 통해 제공하고 있으며 이미지 생성 모델, 음성 생성 모델등 자신들의 AI 서비스를 확장해나가고 있습니다.

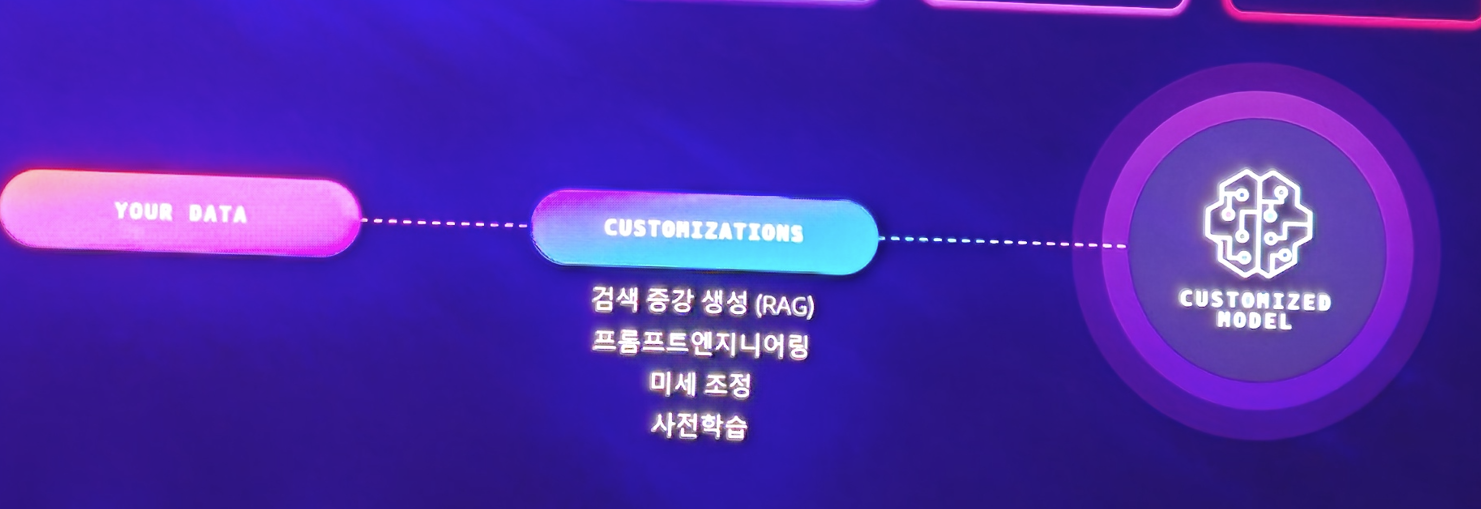

또한 이 Nova를 활용하여 기업들 스스로 자신들만의 커스텀 모델을 만들 수 있는 서비스를 제공한다고 합니다.

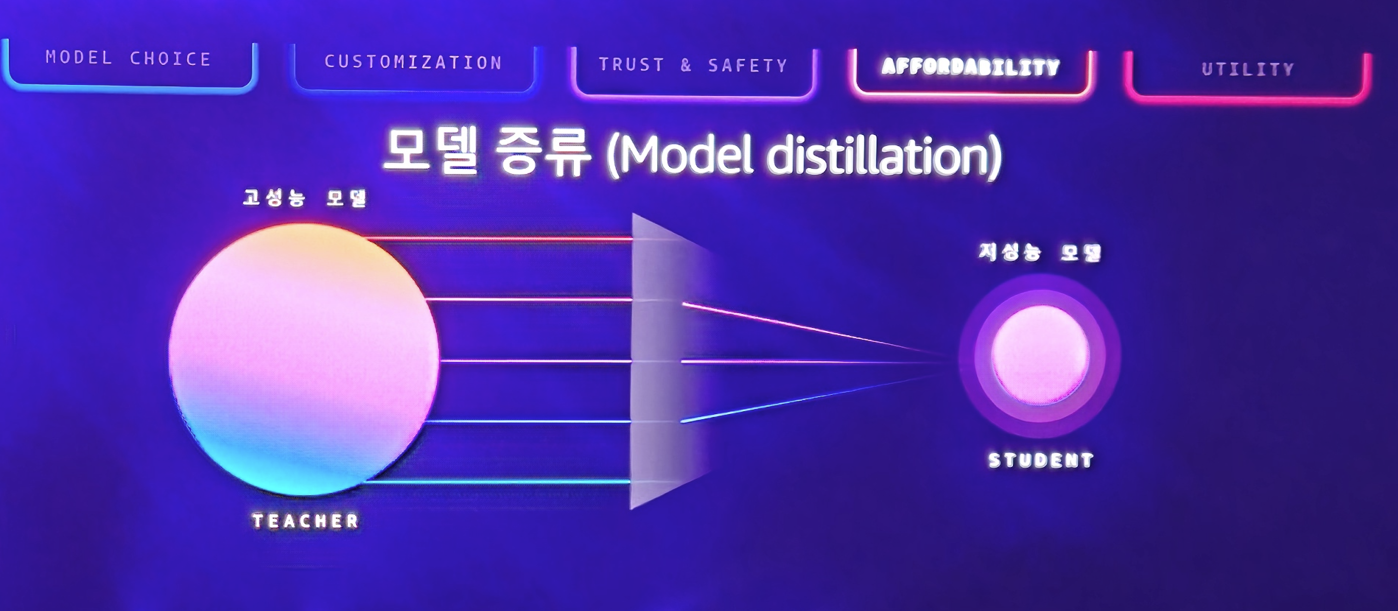

그리고 점점 커지는 AI 모델들을 다시 증류하여, 더 적은 전기와 자원을 소모하는 증류 모델들을 활용할 수 있게 하여, 고객들이 더 다양한 효율적인 선택을 할 수 있게 인프라를 제공합니다.

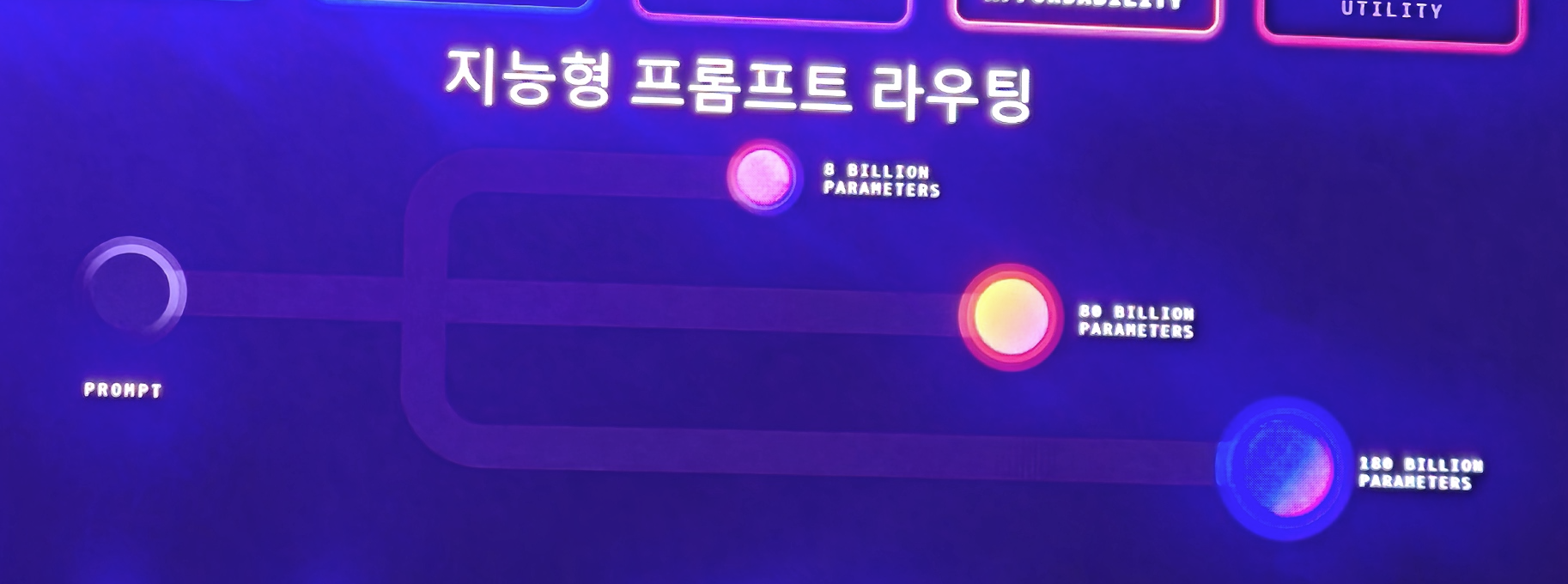

그래서 이러한 다양하게 제공하는 모델에 대해 적절히 라우팅을 하여 효율적인 모델 사용을 할 수 있게 되는거죠

또한 이러한 모델 제공뿐만 아니라, 이 모델들이 출력하는 결과에 대해 환각을 제거하거나 법적 이슈가 될 문제를 필터할 수 있는 기술 가드레일도 함께 제공한다고 합니다.

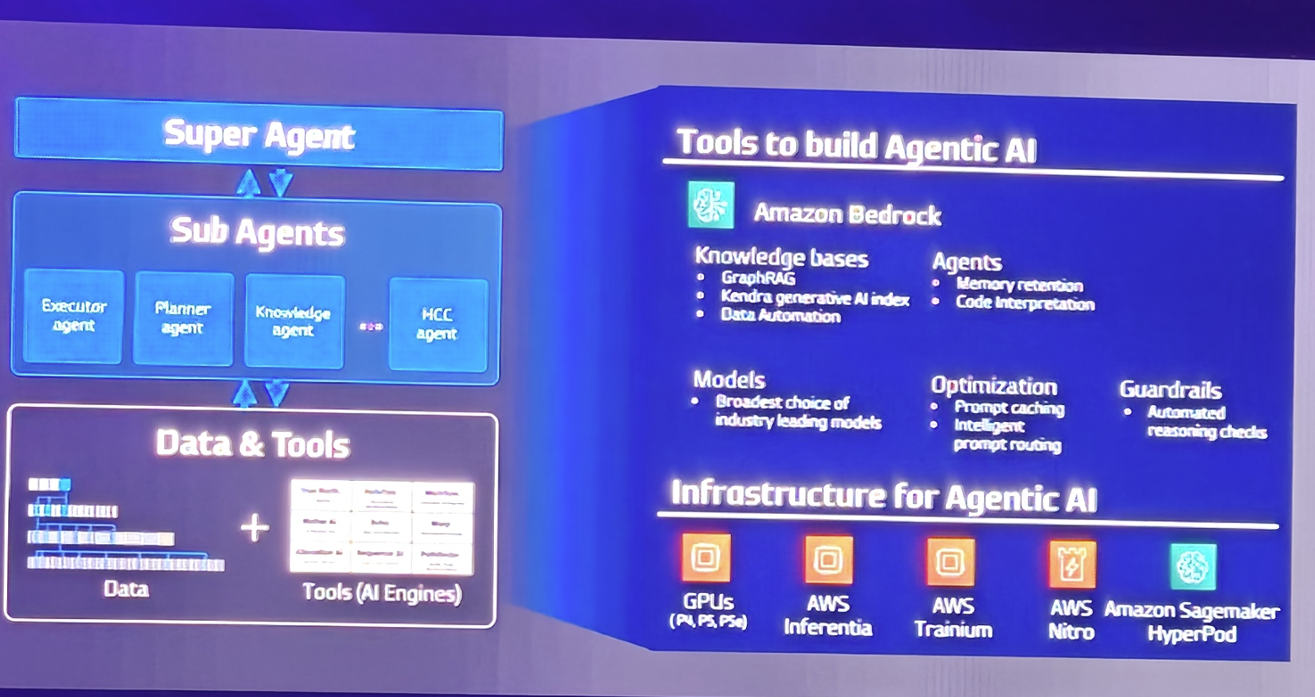

그리고 요즘 시대에 맞게 AI Agent 기술을 소개하며

Bedrock을 통해 이 모든것이 가능하다고 하며 소개를 마칩니다.

이후 대표 키노트로 현대카드와 트웰브랩스가 나옵니다.

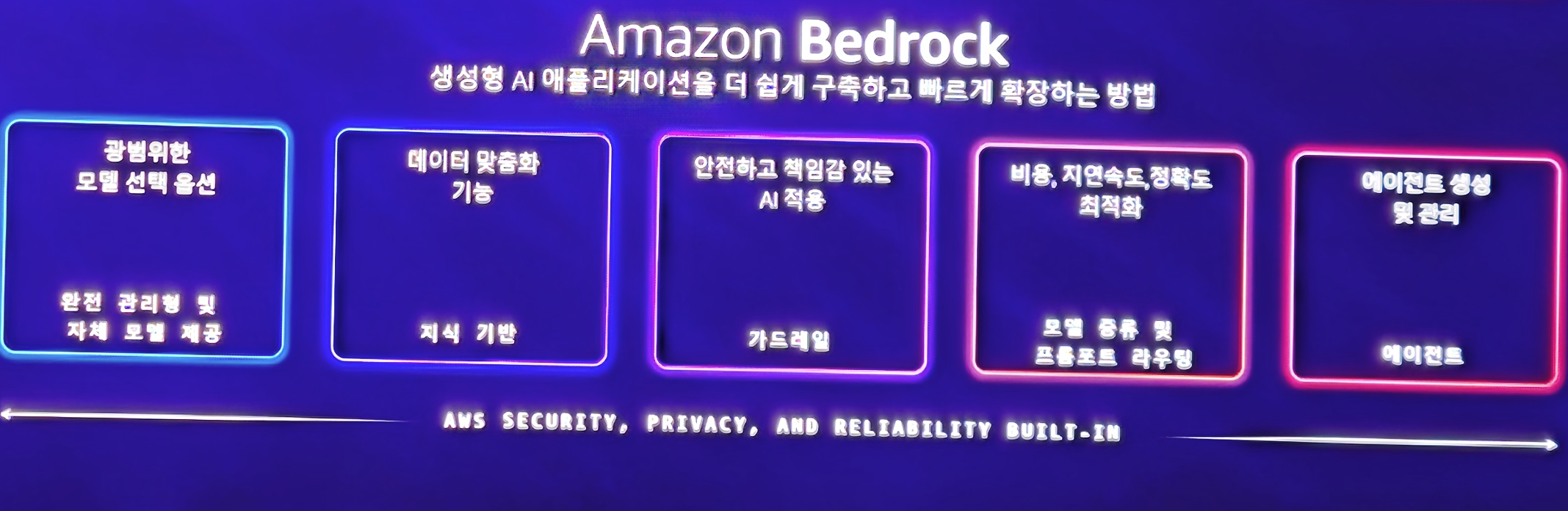

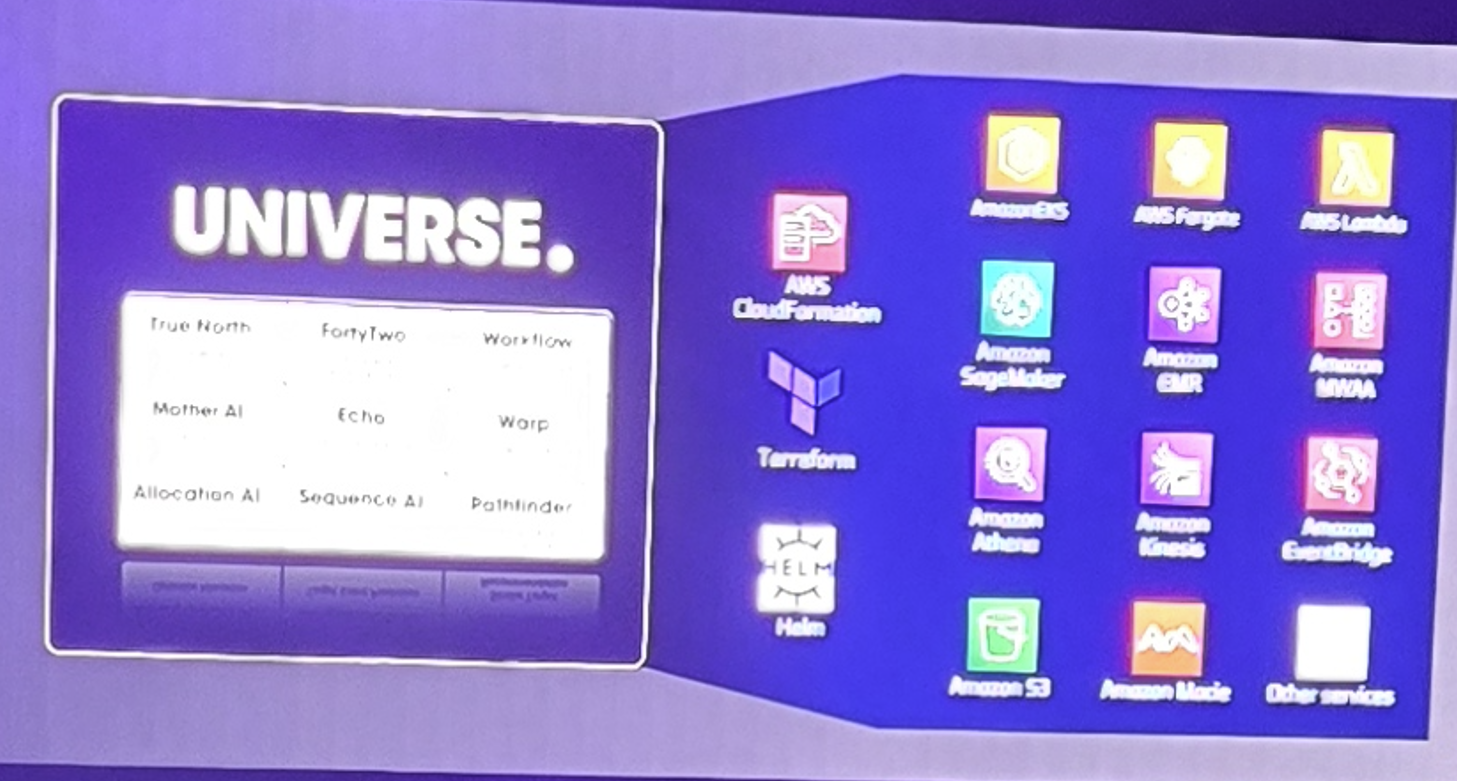

먼저 현대 카드는 자신들의 AI 플랫폼이자 생태계인 UNIVERSE 에 대해 소개를 합니다.

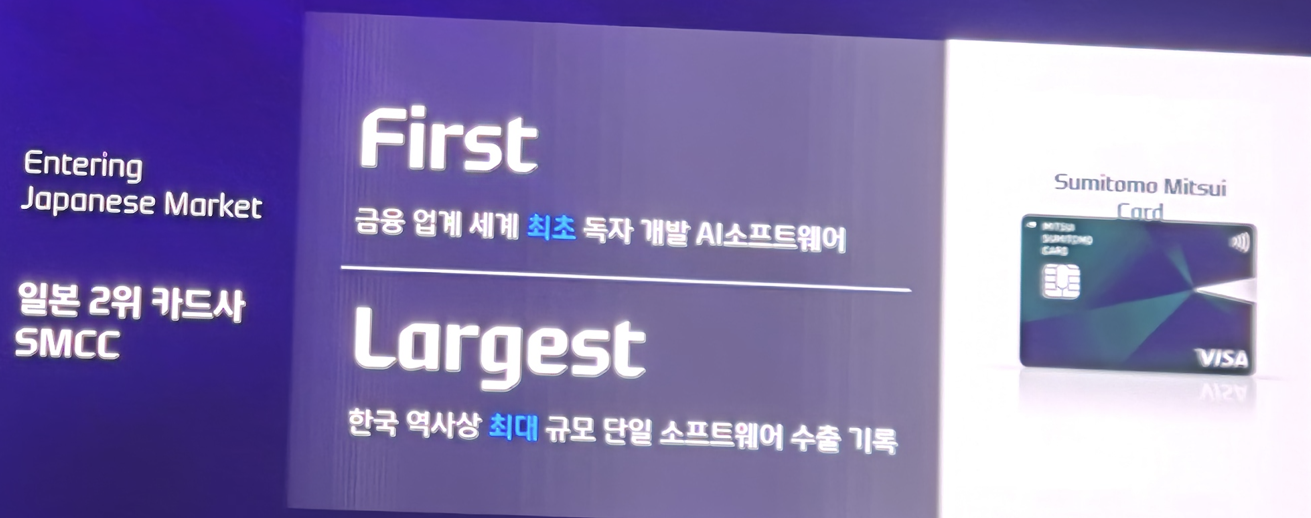

현대카드에서는 시작은 데이터 분석 및 AI를 위한 자신들의 서비스로 만들었지만, 이를 플랫폼화하는 결정을 하였고, 이 플랫폼의 가치를 인정 받아 해외 수출까지 하였는데요

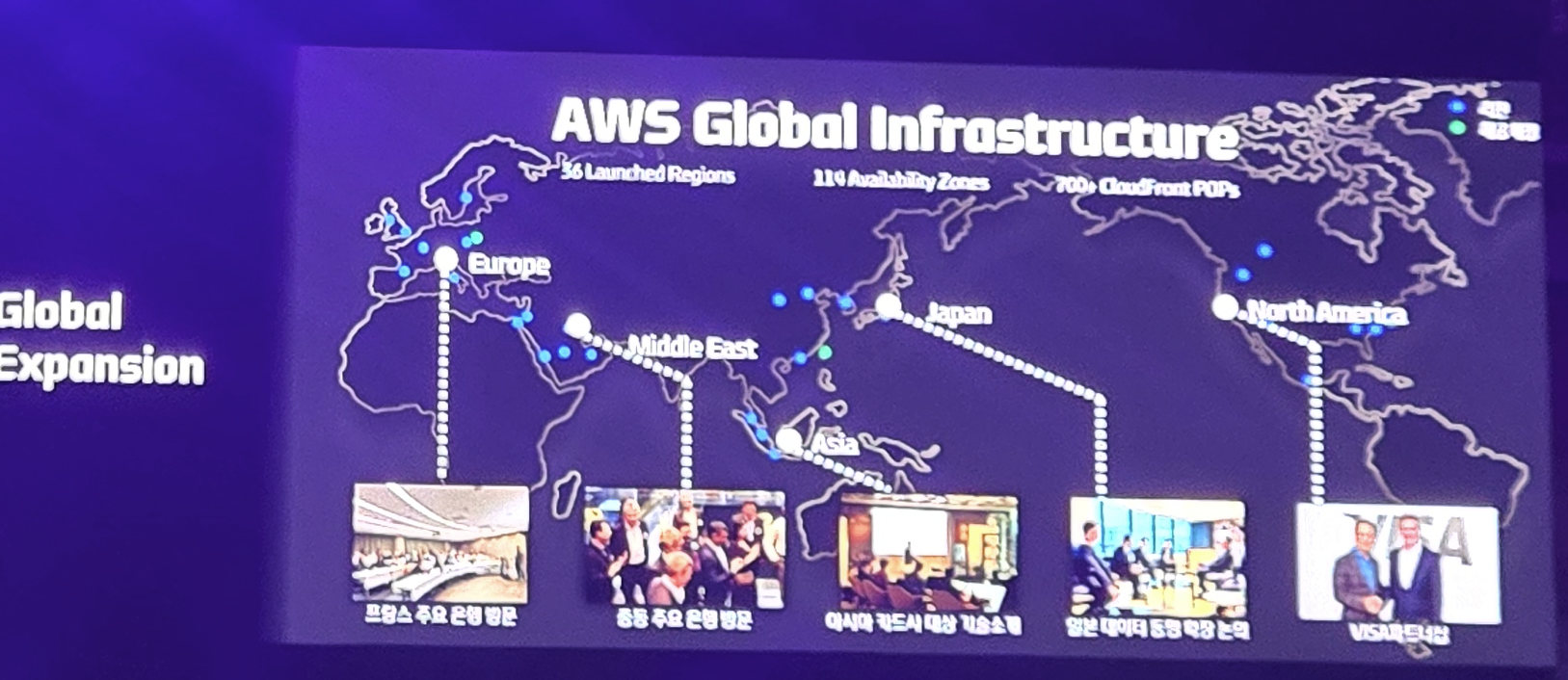

이러한 AI 플랫폼은 일본의 2위 카드사인 SMCC에 수출을 하였고, 한국 역사상 최대 규모 단일 소프트웨어 수출 기록을 이뤘다고 합니다. 카드를 주무기로 하는 금융 기업이 이런 IT 실적을 이룬다니 대단하지 않나요?

이러한 성공적인 IT 비즈니스는 결국 글로벌 수출까지 할 정도라니..

그리고 요즘 시대의 대세인 AI Agent도 도입을 하여 이 플랫폼을 지속 발전한다고 하였습니다.

현대카드의 눈부신 IT 발전에 박수를 치고 싶네요! 또다른 비즈니스를 창출 했으니깐요

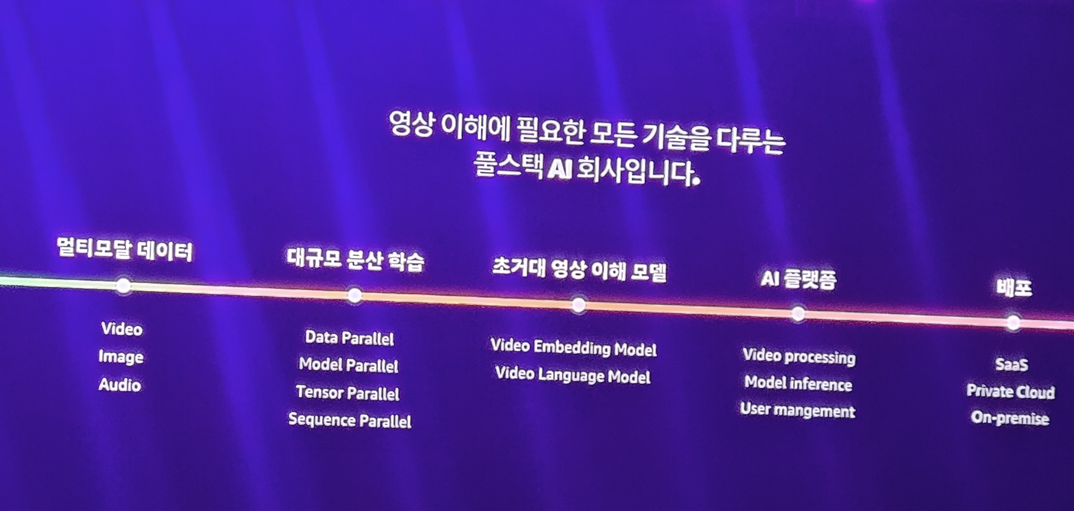

두번째로 트웰브랩스에서 발표가 이루어집니다.

세계가 인정하는 스타트업이자, 동영상 추론 모델을 만들고 있는 트웰브랩스

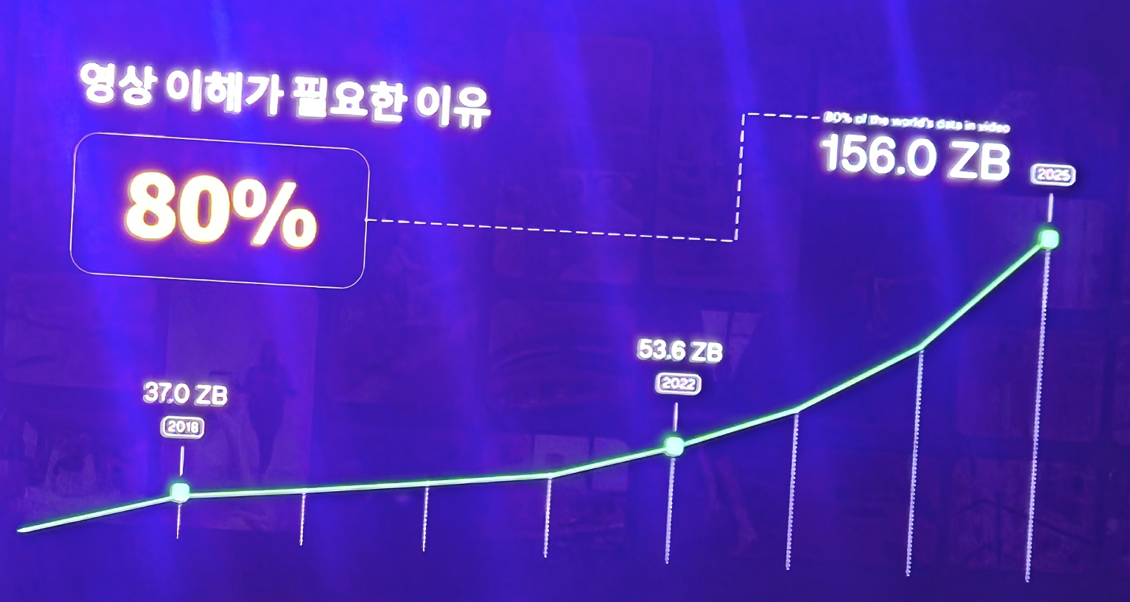

세상의 데이터의 80%는 영상 데이터이며, 이러한 영상 데이터를 위한 AI 모델이 필요하다고 생각하여 이 회사를 만들었다고 합니다.

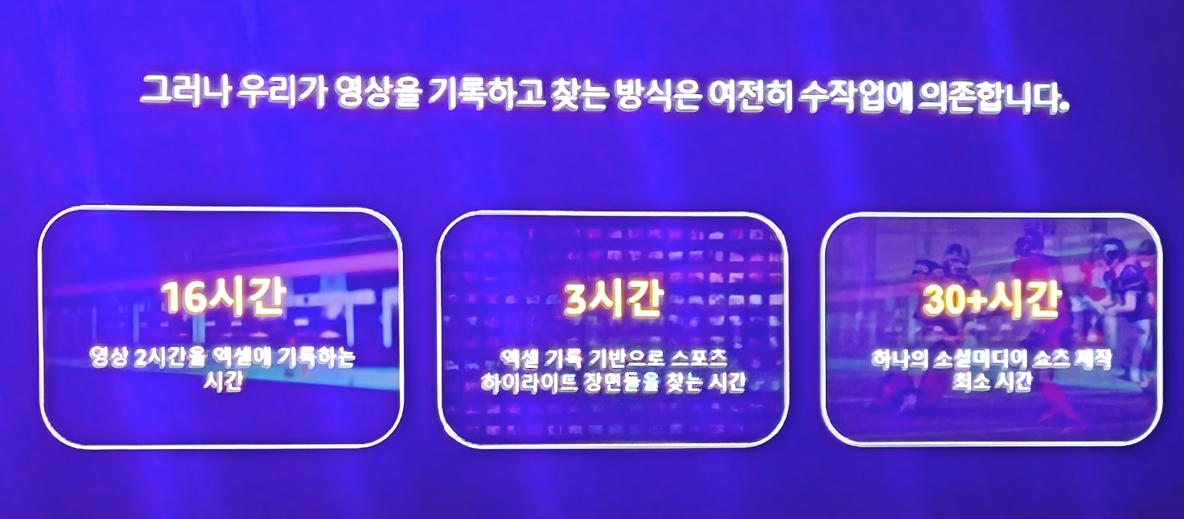

아직도 미디어/방송 기업들은 영상 분류 및 작업에 대해 많은 시간을 할당하는데

이러한 기업들을 위해 아래와 같은 AI를 제공하는 모델을 만들었다고 합니다.

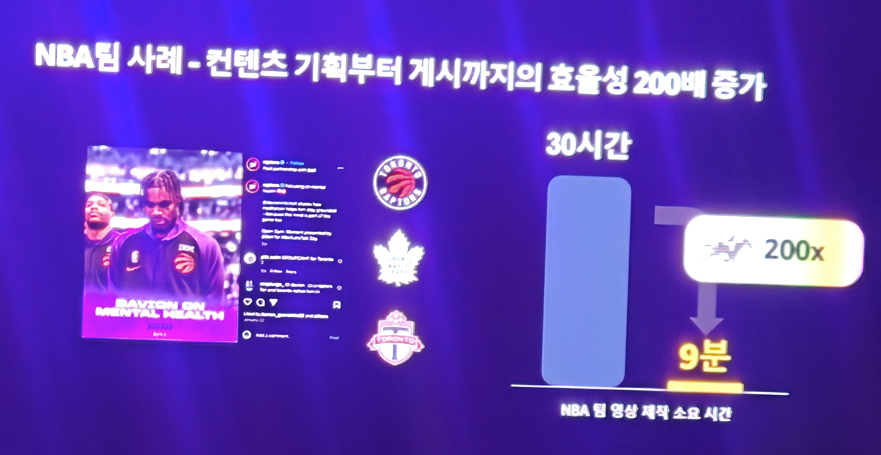

이러한 영상 전용 AI 모델의 기술력은 인정 받아 NBA팀의 홍보 컨텐츠 제작에서 비약적인 효율을 지원할 수 있다고 하네요

이외에도 수많은 스포츠 기업들의 분석을 도와주는 서비스를 만드는등 .. 미래가 창창한 기업이라는 것을 알 수 있었습니다. 물론 이러한 모든 서비스는 AWS 위에서 동작할 수 있었다며 AWS에 대한 찬사도 계속 나왔네요 ^^;

이외에도 직접 발표자가 나오진 않았지만 AWS는 쿠팡과 협업을 하여 인프라를 구축하여 3개월동안 70개의 Java 어플리케이션을 Agent Code Transform을 진행해줬다던가

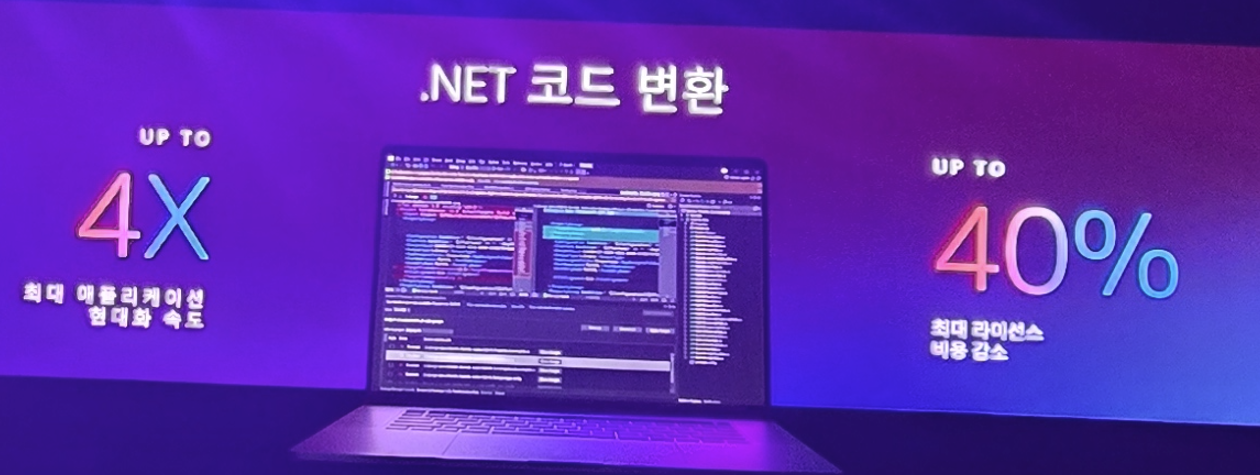

단 다섯명의 개발자로 .net 기반의 어플리케이션 코드 변환(현대화)을 원래 같았으면 몇년 걸릴 일을 세달만에 해줬다던가

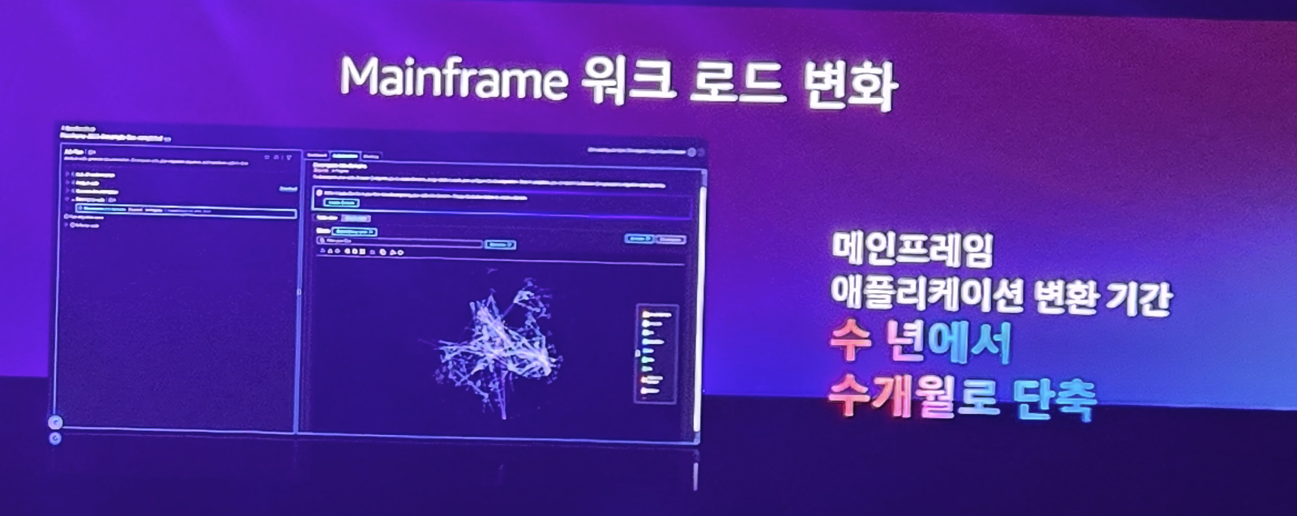

기업 내 private cloud를 aws로 전환하는데 수년 걸리는 네트워크 이전 작업을 Agent를 이용하여 수개월만에 마이그레이션 해줬다던가..

Agent Transform의.. 과거였다면 상상도 할 수 없는 엄청난 생산성과 속도를 자랑하며 키노트를 마칩니다.

이후부터는 세션에 대한 내용입니다. 제가 처음 들었던 세션은

여행 goes AI! AWS 생성형 AI 없이는 살아남을 수 없어!

갑자기 왠 여행? 할 수 있지만 여행 산업에서 어떻게 AI 를 도입하는지 궁금해서 한번 들어보기로 하였습니다.

Chatgpt 등장 이후, LLM의 등장은 여기저기 산업에 혁명을 일으키고 있습니다. 그리고 이러한 혁명중 가장 크게 영향을 받는게 여행 업계라고 합니다.

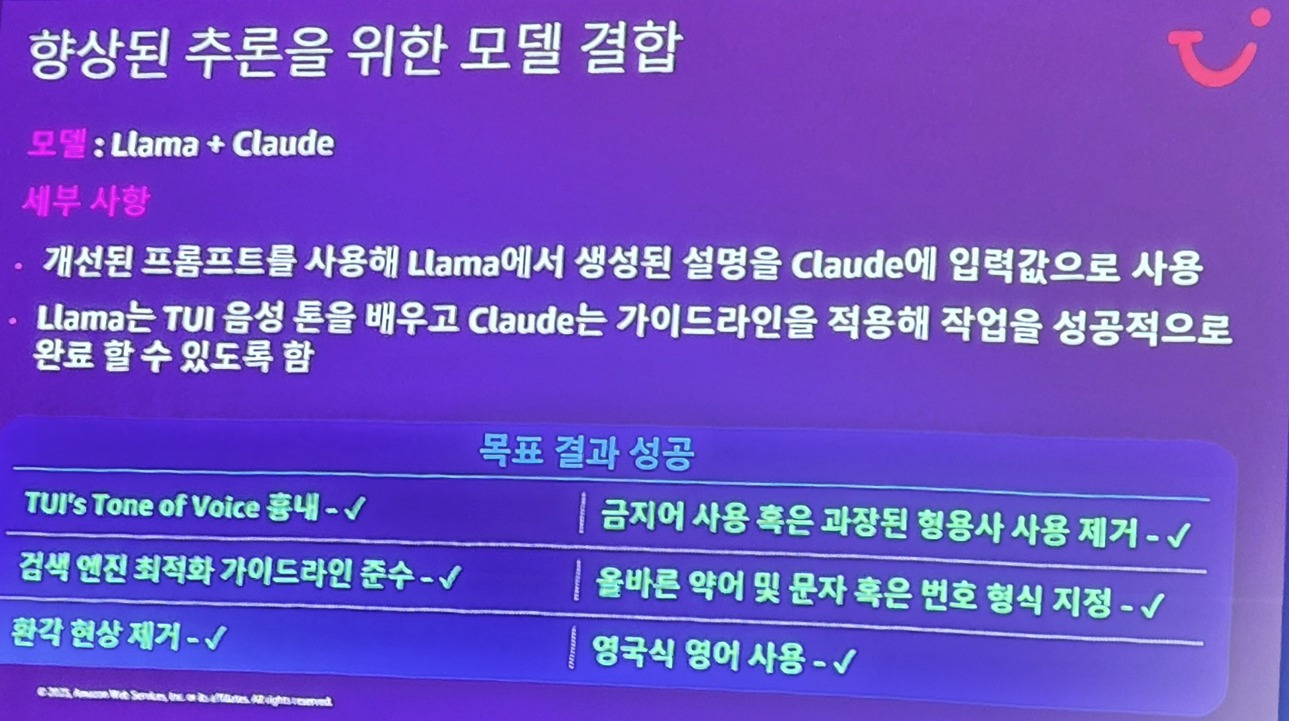

현재의 AI 기술들은 아래와 같이 제공되는데

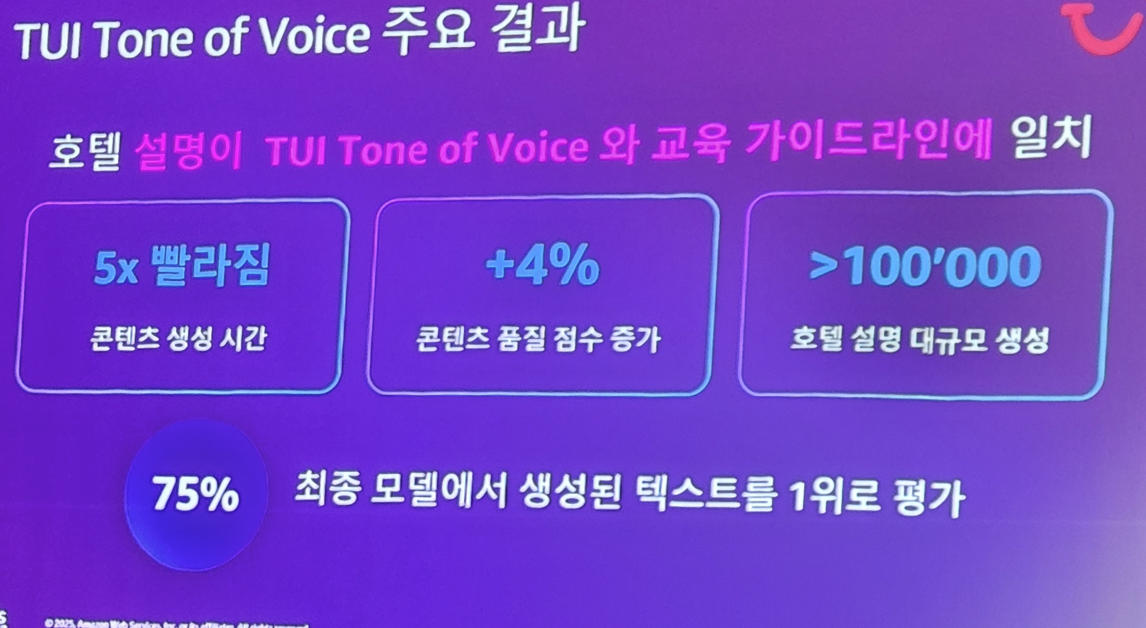

호텔의 경우 AI 기반의 음성 가이드를 제작할 수 있으며,

이렇게 생성된 컨텐츠의 경우 직원들의 내부 평가에서도 1위를 할정도로 퀄리티도 훌륭하다고 합니다.

또한 수많은 고객의 VOC에 대해서도 AI로 더 적은 인력으로 더 좋은 품질의 서비스 제공이 가능해지죠.

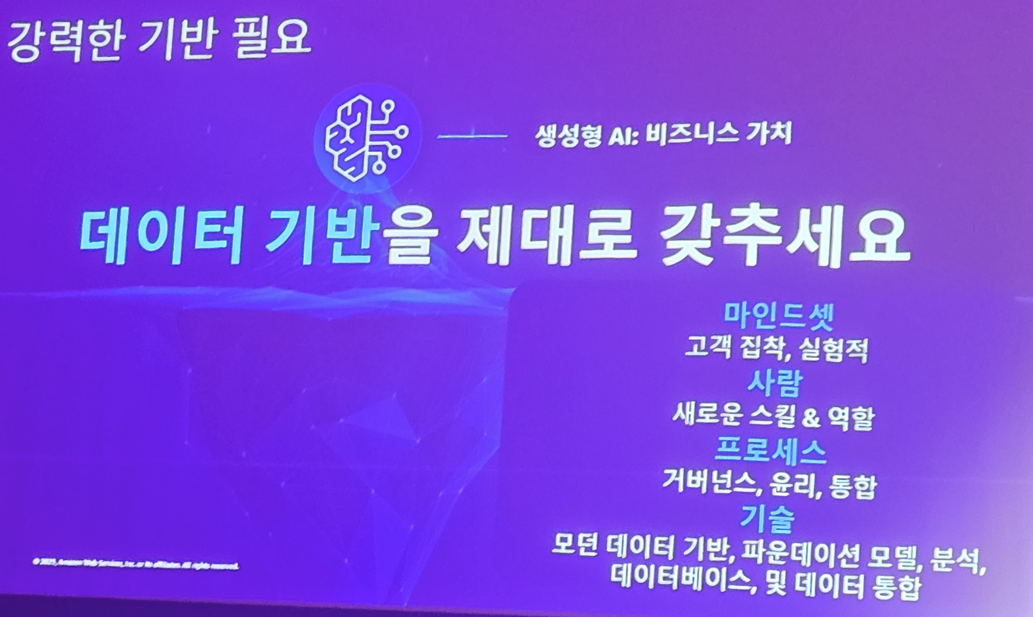

하지만 이런게 그냥 되는게 아닙니다. 여행/관광 비즈니스를 하는 기업이 자체적으로 보유한 잘 정제된 수많은 고객 데이터와 비즈니스 데이터가 AI와 만나 시너지를 발휘해야 하는거죠

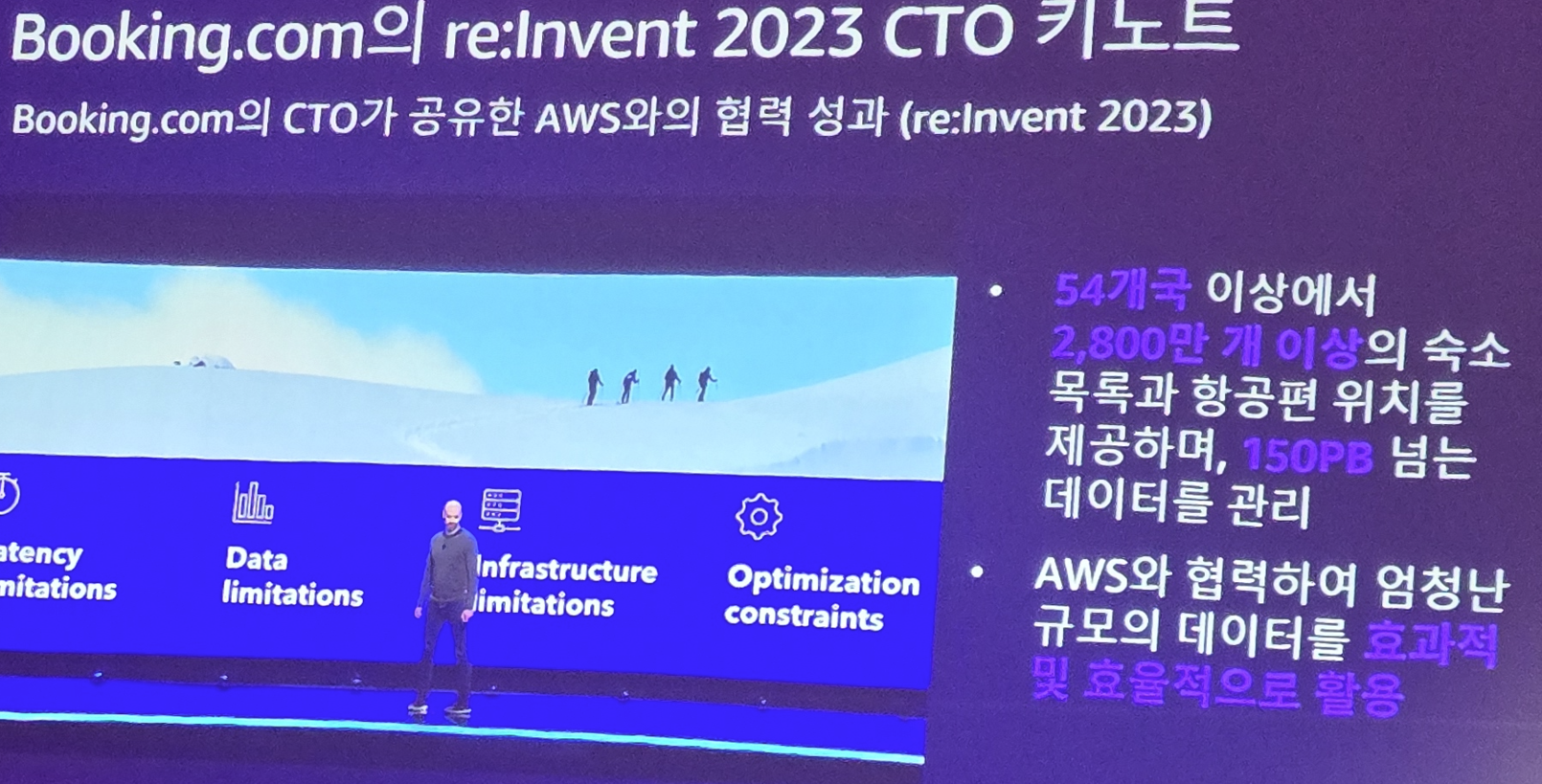

우리가 잘 아는 booking.com만 하더라도 54개국의 2800만개의 숙소 목록과 항공편 위치를 제공하며, 150PB라는 엄청난 규모의 데이터를 관리한다고 합니다. (물론 이런 모든 인프라는 AWS로..)

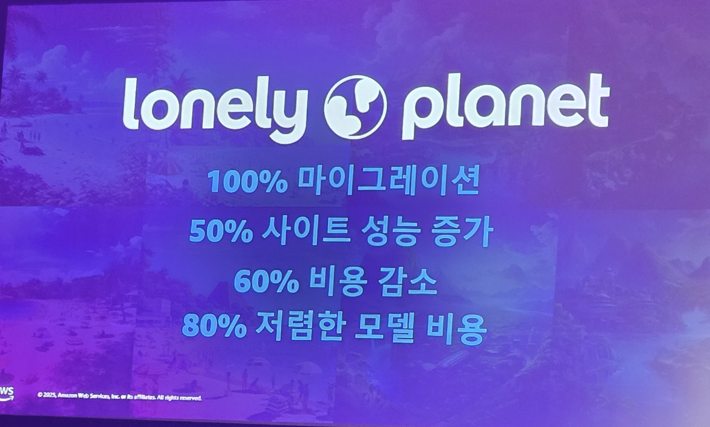

그리고 요즘은 모든 여행 비즈니스가 IT로 시작해서 (플랜, 관리, 결제등) IT로 끝나기 떄문에 IT 개발 및 운영도 중요한데, 유럽에서 유명한 Lonely&planet은 이러한 IT 서비스를 AWS로 마이그레이션하여 50%의 사이트 성능 향상, 60%의 비용 감소, 80%의 저렴한 모델 사용이 가능해졌다고 하네요

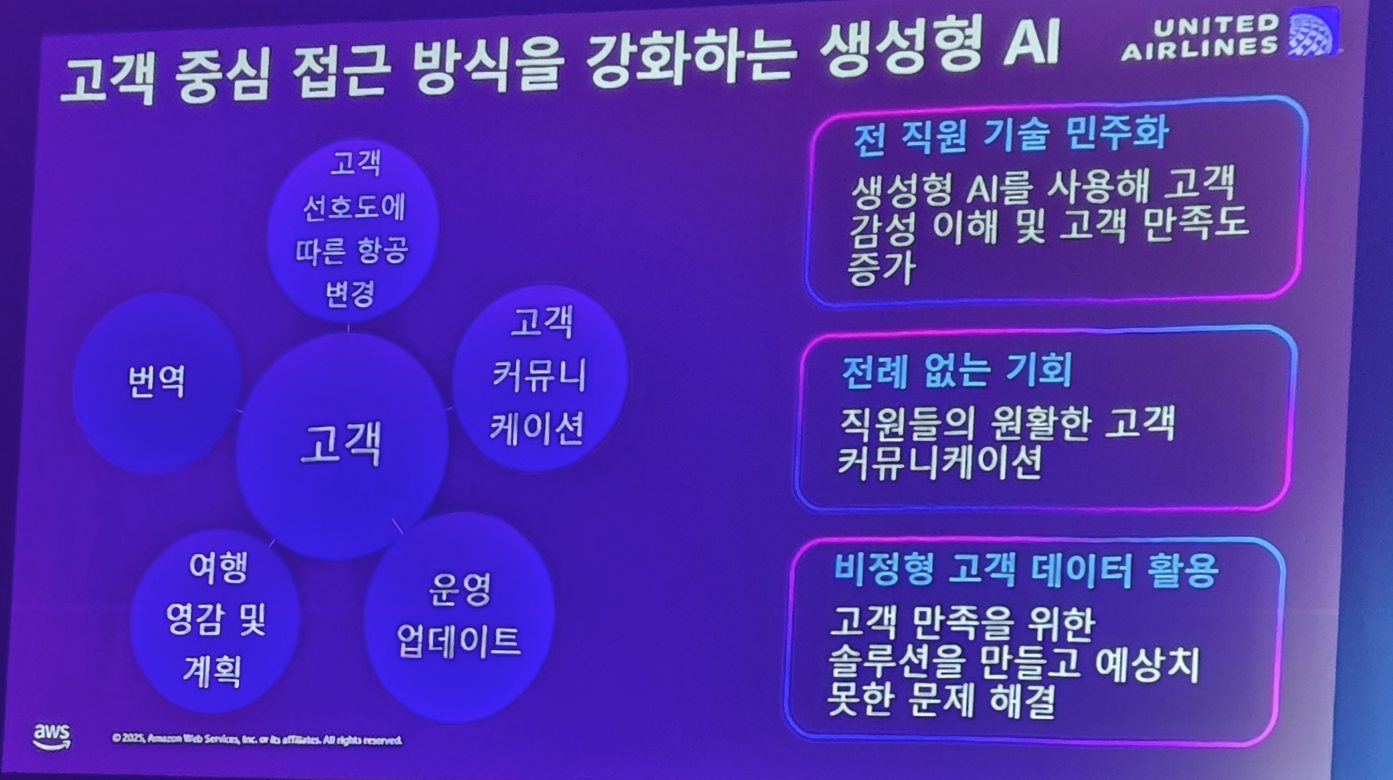

그리고 미국의 항공사인 United Airline은 고객과의 커뮤니케이션을 위해 AI를 적극 사용하여 서비스의 품질 향상 및 비용 효율화를 이루고 있다고 합니다.

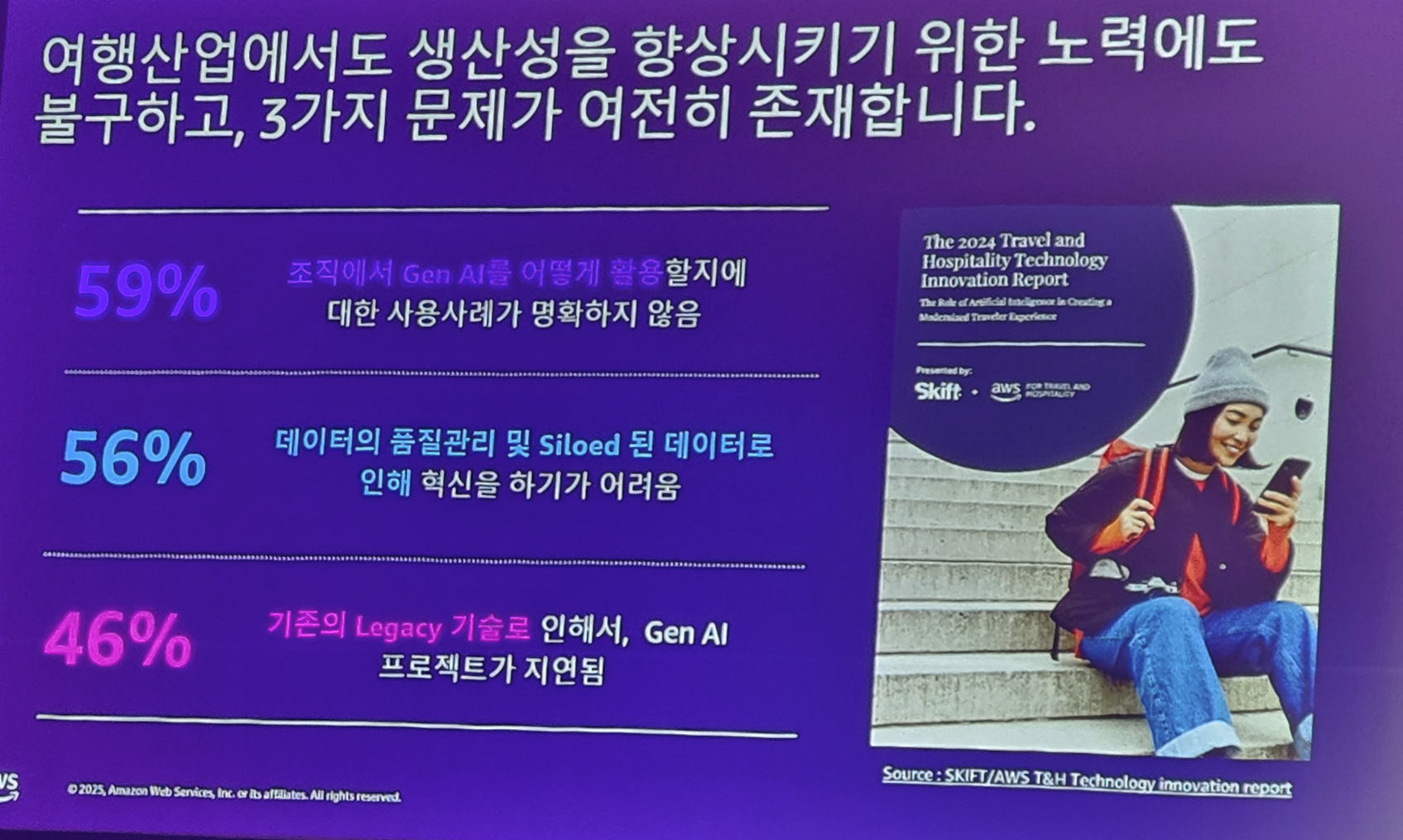

이처럼 많은 여행 기업들이 클라우드 기술과 AI 기술을 도입하여 생산성 향상을 꽤 하지만 여전히 많은 기업들은 손쉽게 전환을 못합니다. 왜냐하면 다음과 같은 이유인데요

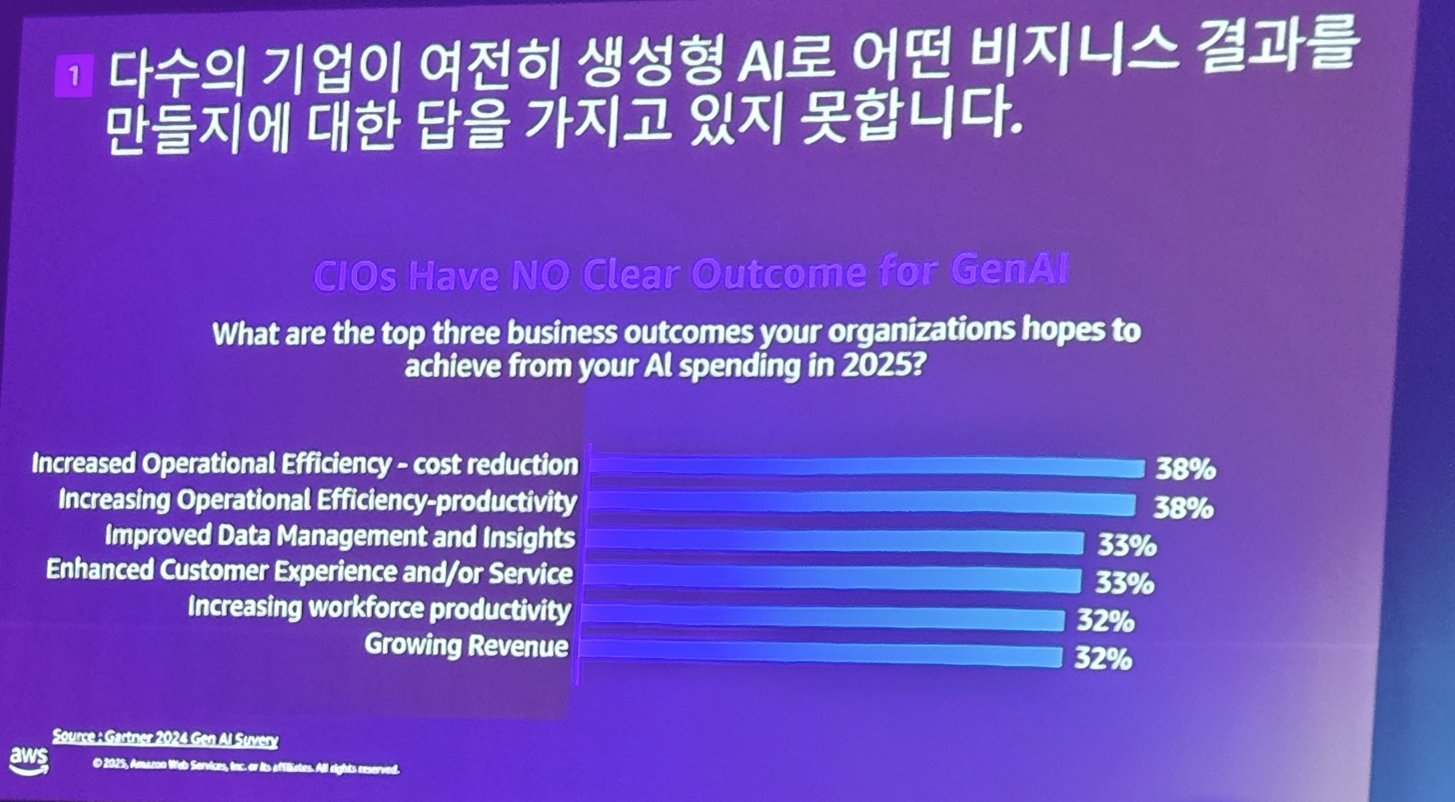

여행 기업들의 경영진들은 AI가 정말 핫하고 유망한건 알지만 자신들의 비즈니스에 정말 잘 어울리지 아직 확신이 없는것이죠

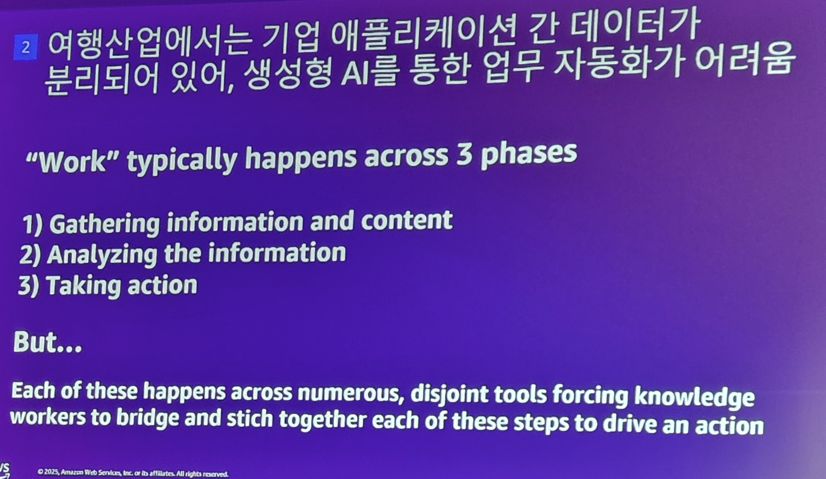

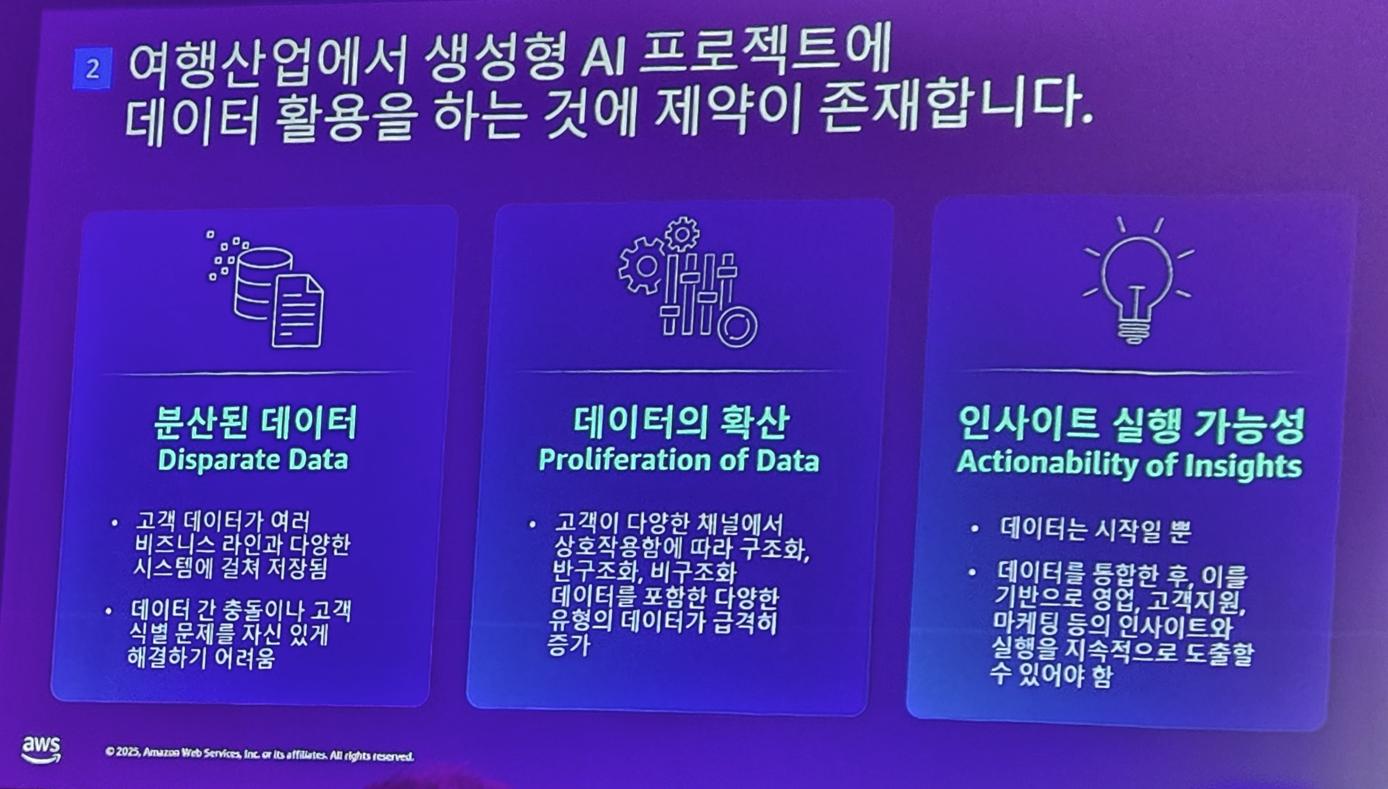

또한 역사가 오래 된 만큼 자신들의 데이터와 서비스들이 파편화되어 분리되어 있다보니 AI 도입을 통한 자동화도 쉽지 않다고 합니다.

그리고 단순히 데이터만 다루기에 AI 도입하기에는 여행 산업의 비즈니스는 해야 할일이 너무 많죠

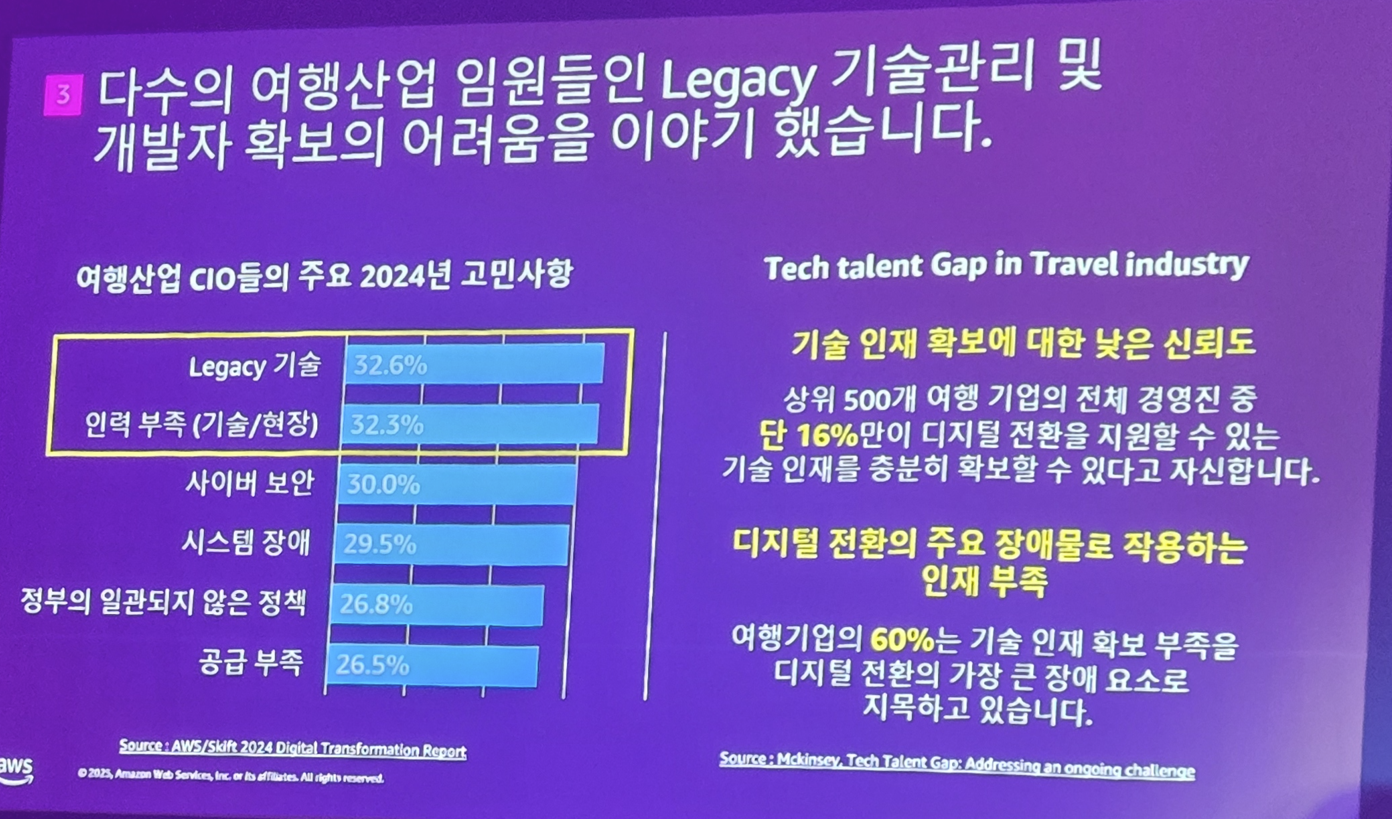

그리고.. 이게 좀 현실적이면서도 전 살짝 웃음(?) 포인트였는데.. 여행 기업에는 이런 일들을 달성할 수 있는 "고급 개발자" 채용이 어렵다고 합니다.

아무래도.. 요즘 이런쪽 분야의 IT 개발자 연봉이 좀 썌긴 하죠 ^^;; 물론 연봉을 떠나서 개발자들도 자신의 회사를 선택하는 입장이다보니... 여행 기업에는 다소 선택을 안하기도 하겠구요

그래서 AWS는 이러한 비즈니스 기업들을 위해 AI 도입을 더 추천합니다.

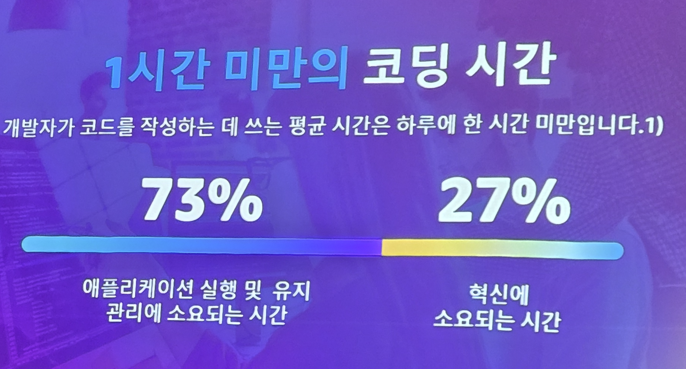

실제로 개발자의 하루 일과는 23%만이 생산성 있는 개발 활동을 하고 나머지 73%는 유지보수 및 관리에 많은 시간을 할애하게 되는데

기업에서 AI 및 AI Agent 기술을 적극적으로 도입하게 되면 이러한 작업 시간들을 크게 단축시킬 수 있게 되는거죠

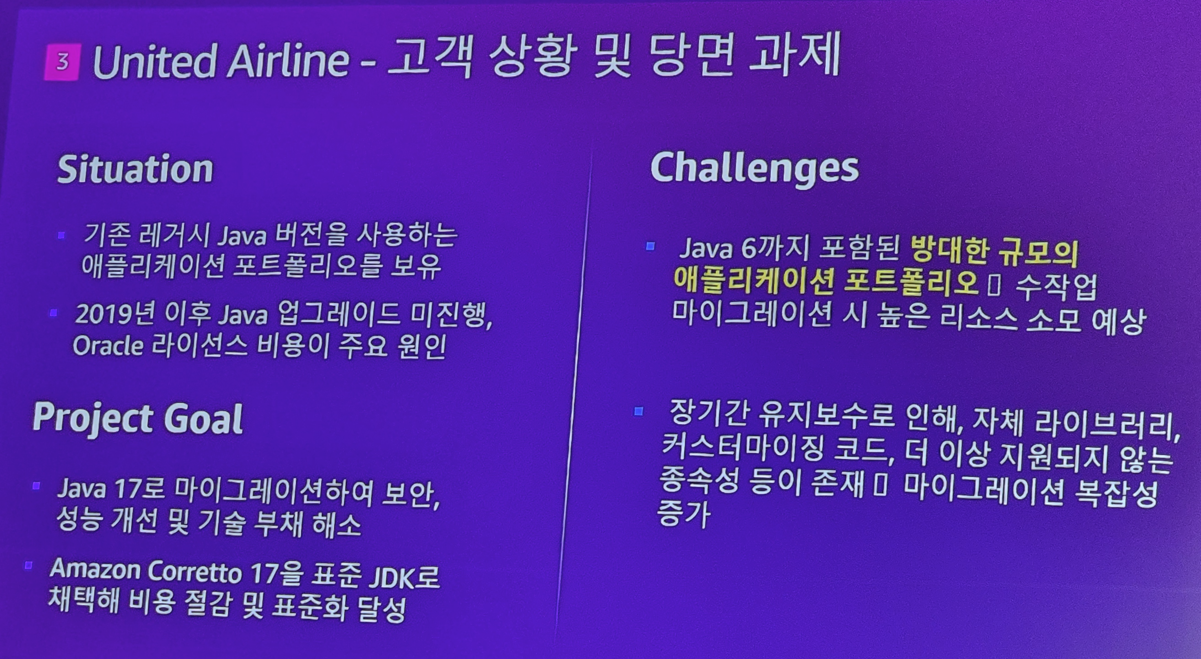

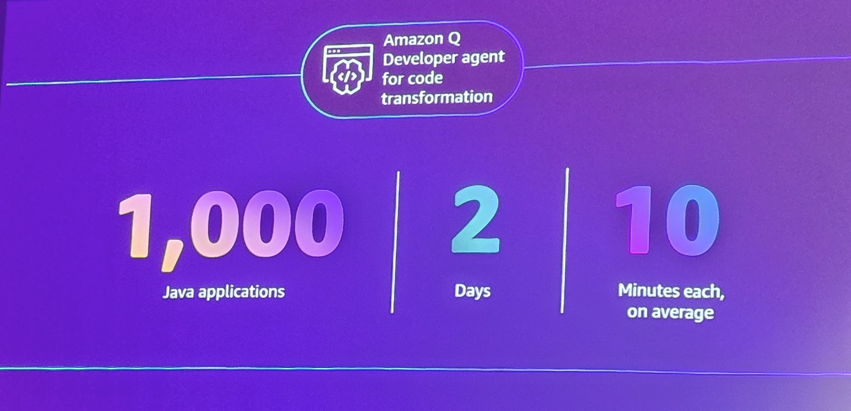

실제로 United Airlne은 Legacy 시스템들이 JAVA 1.6을 쓰고 있었고, 이를 현대화하기에 위해 많은 고민이 있었는데 AWS의 마이그레이션을 위한 Agent 도구를 사용하여 1000개의 JAVA 어플리케이션을 이틀동안 모두 마이그레이션 하였다고 합니다. (사람이 했으면 얼마나 걸렸을지...)

어마무시하죠? 이런 어마무시한 내용을 소개하면서 발표자는 자신이 정말 마음에 드는 멘트라며 하버드 교수인 "karim Lakhani"의 말을 합니다.

AI는 인간을 대체하지 않지만, AI를 활용하는 인간은 AI 없이 일하는 인간을 대체할 것입니다.

이렇게 첫번째 세션을 마치고.. 맛있는 점식 식사를 한 후.......

두번째 세션을 시작을 들었습니다.

NEXON은 어떻게 대규모 클라우드 접근관리를 더 안전하고 간편하게 개선하였나?

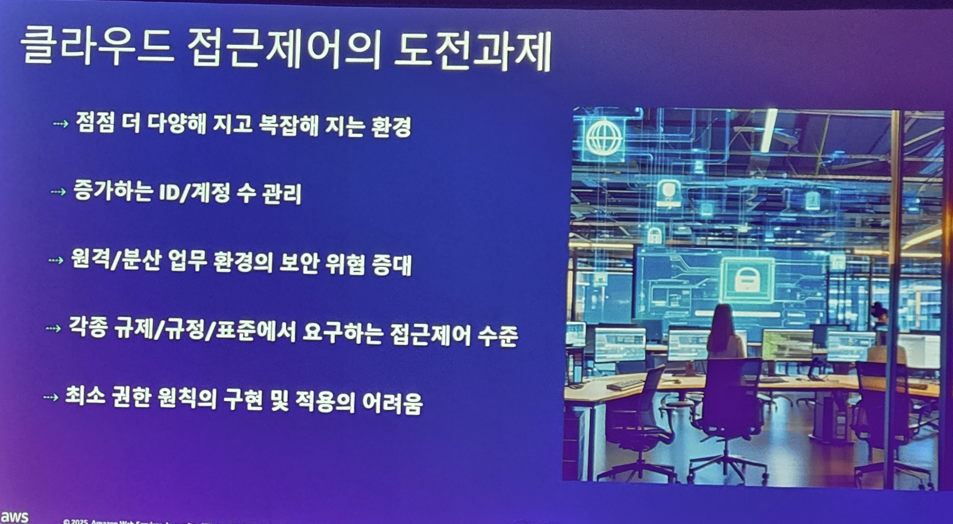

요즘은 수많은 서비스들이 넘치고.. 수많은 클라우드를 사용하게 되는데.. 이러다보니 이런 도전들을 직면하게 됩니다.

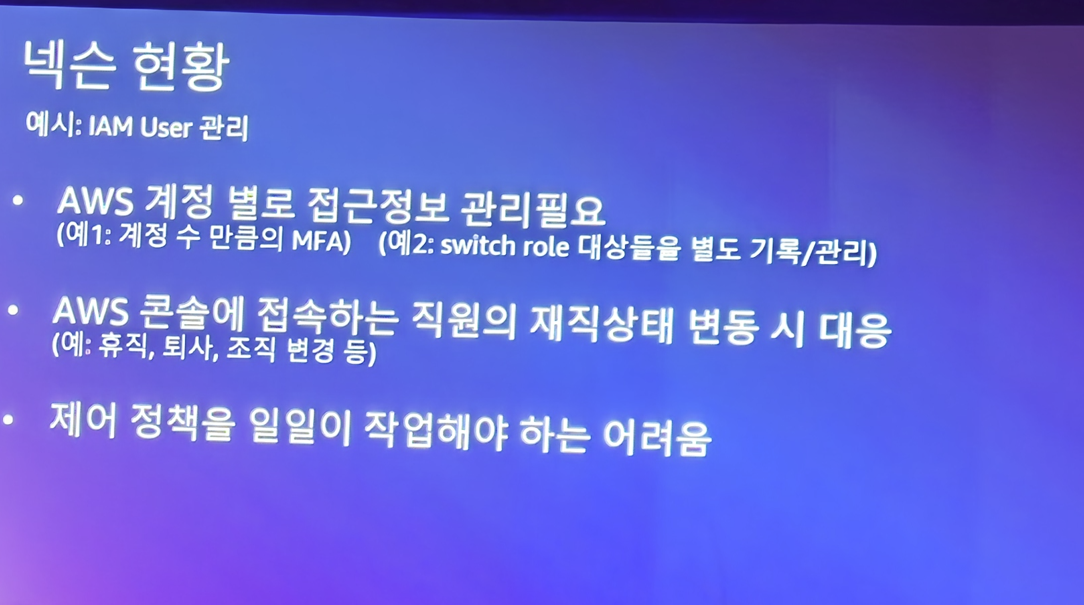

이러한 문제는 넥슨도 크게 직면한 문제인데..

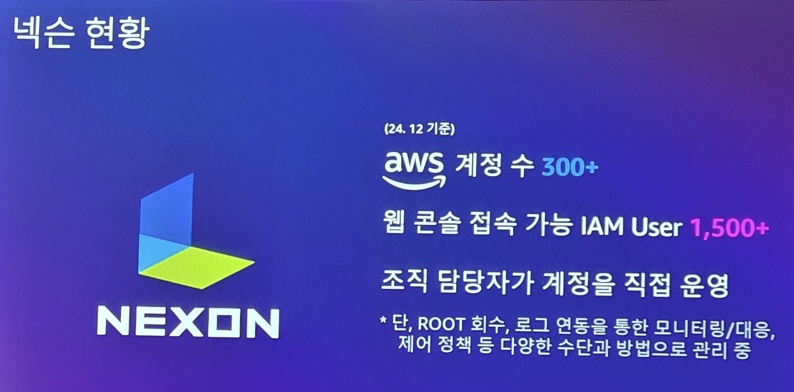

게임 회사인 넥슨은 AWS 계정만 300개이상 넘으며, 이를 접속하는 사용자도 1500명이 넘습니다. 이러한 계정 관리는 보안에서 매우 중요한 요소인데.. 문제는 관리가 참 어렵다는게 문제입니다.

IT 기업에서는 수많은 사람들이 입사/퇴사 하는데.. IT 계정 관리자는 너무 힘들죠

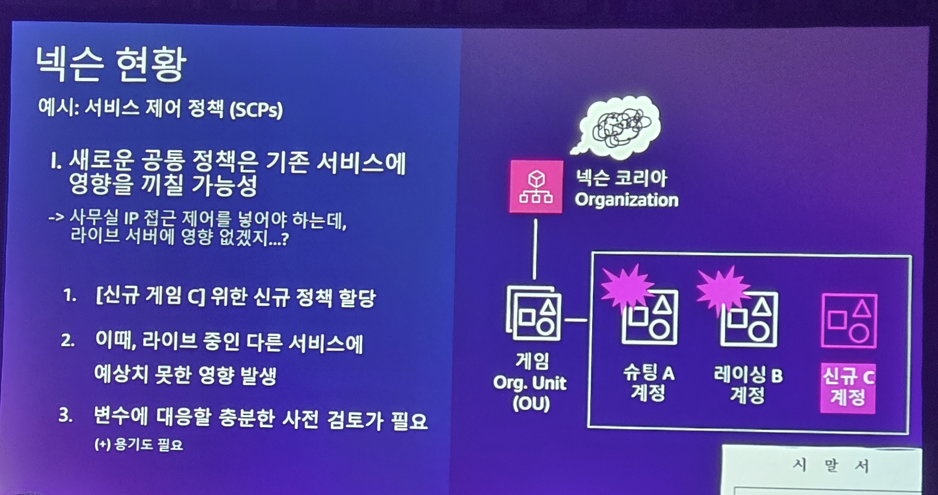

이러한 계정 관리 업무는 조금만 잘못해도.. 시말서 각입니다. 왜냐하면 정책 관리가 쉬운 일이 아니기 떄문이죠

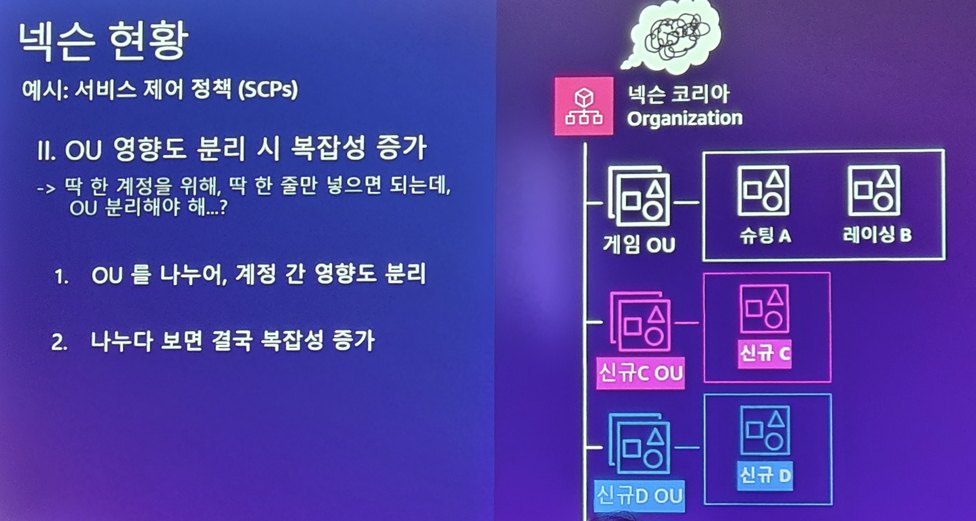

그래서 이러한 계정 관리를 좀 더 효율적으로 하기 위해 OU를 도입하지만... 이것 조차도 나중가면 엄청난 복잡도로 인해.. 결국 관리자를 미쳐버리게 만듭니다.

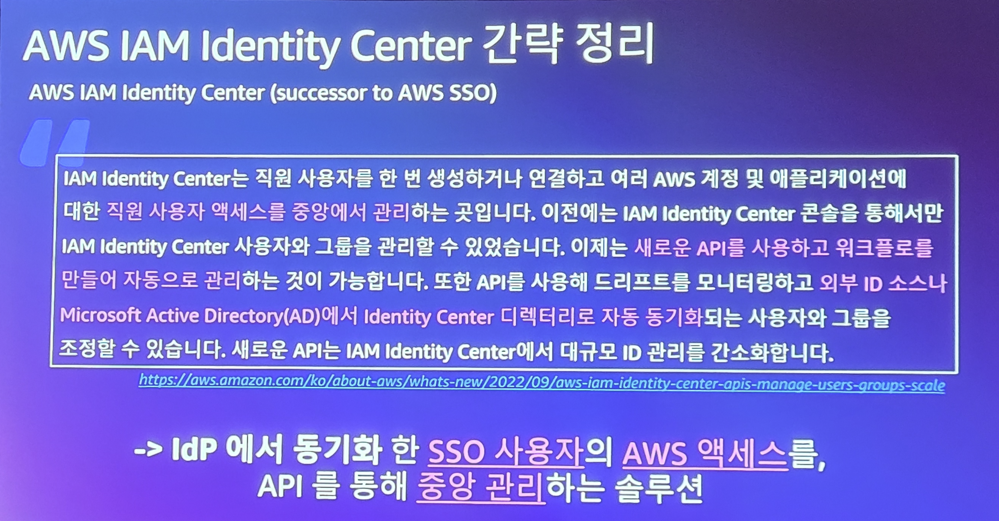

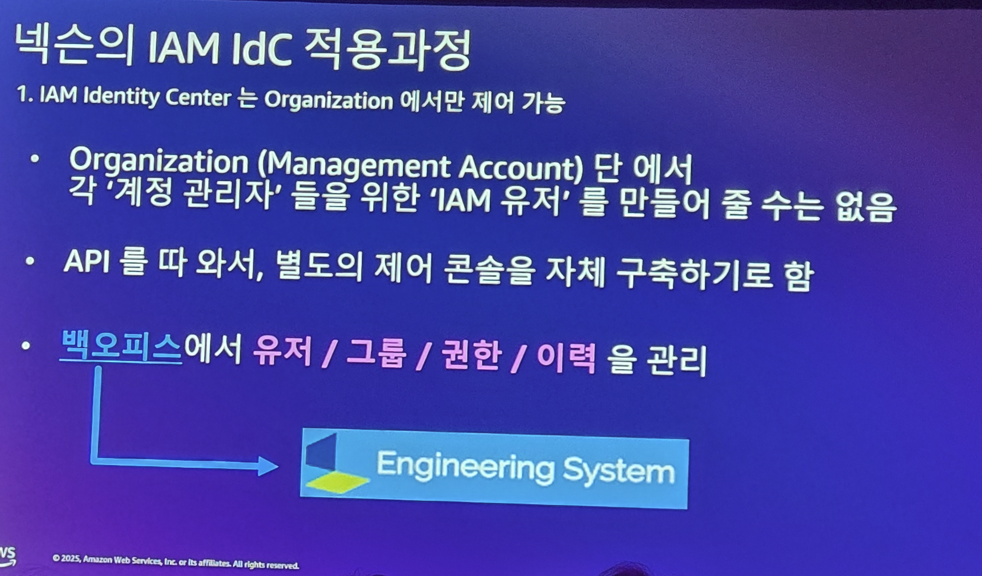

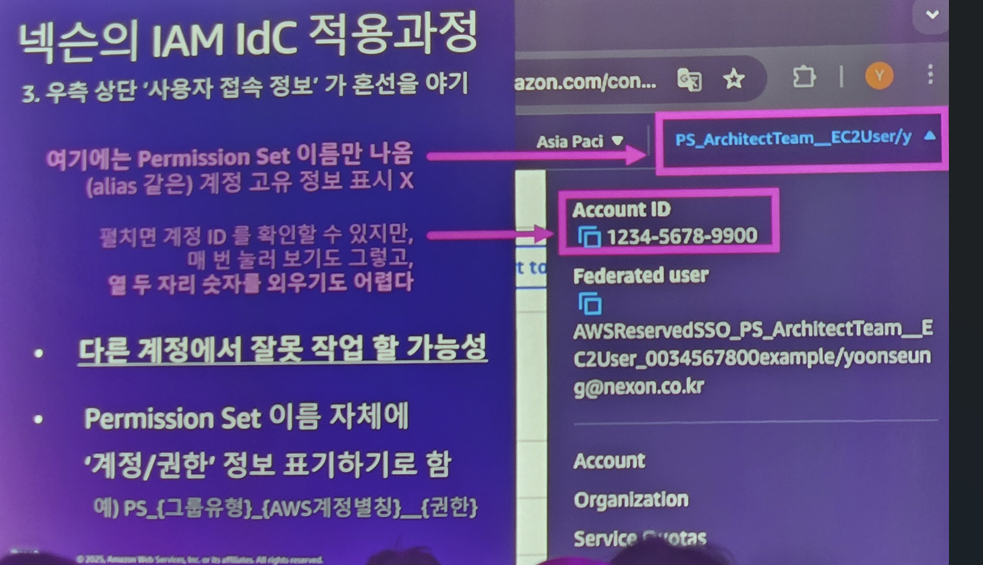

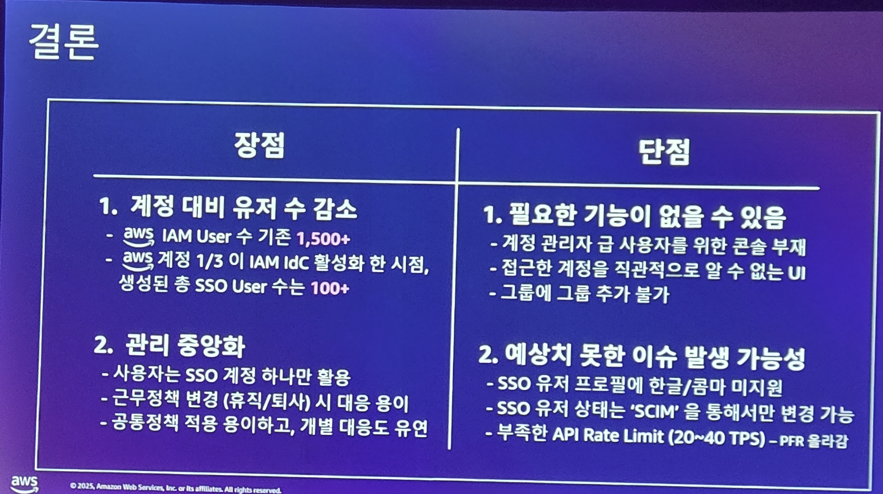

그래서 넥슨을 AWS의 IAM Identity Center를 도입합니다.

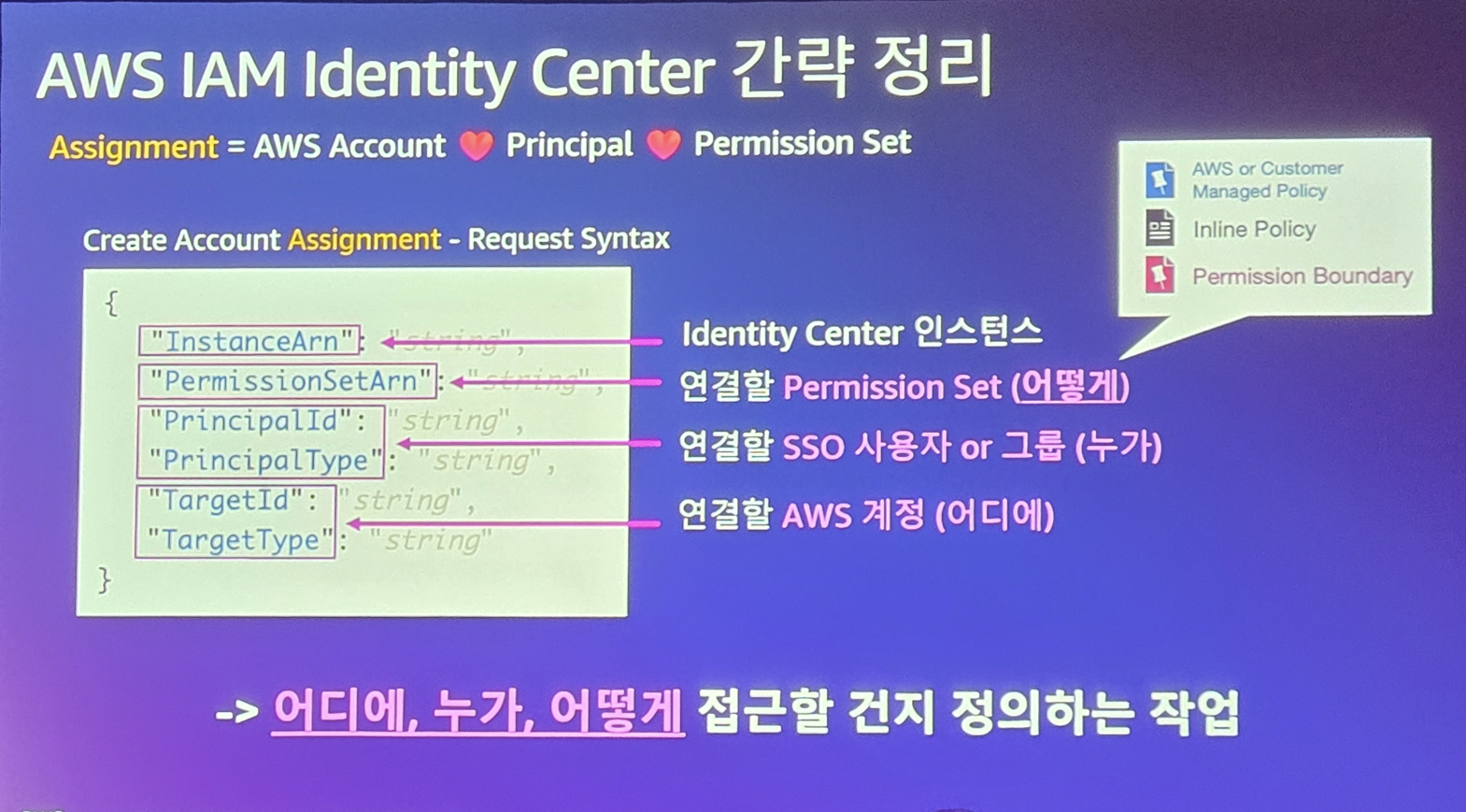

복잡한 사용자 자격증명 관리에 API 서비스를 이용하여 커스터마이징해서 관리한다는것이죠 잘 정리된 인스턴스는 "어디에, 누가, 어떻게" 접근할지를 정의하는데

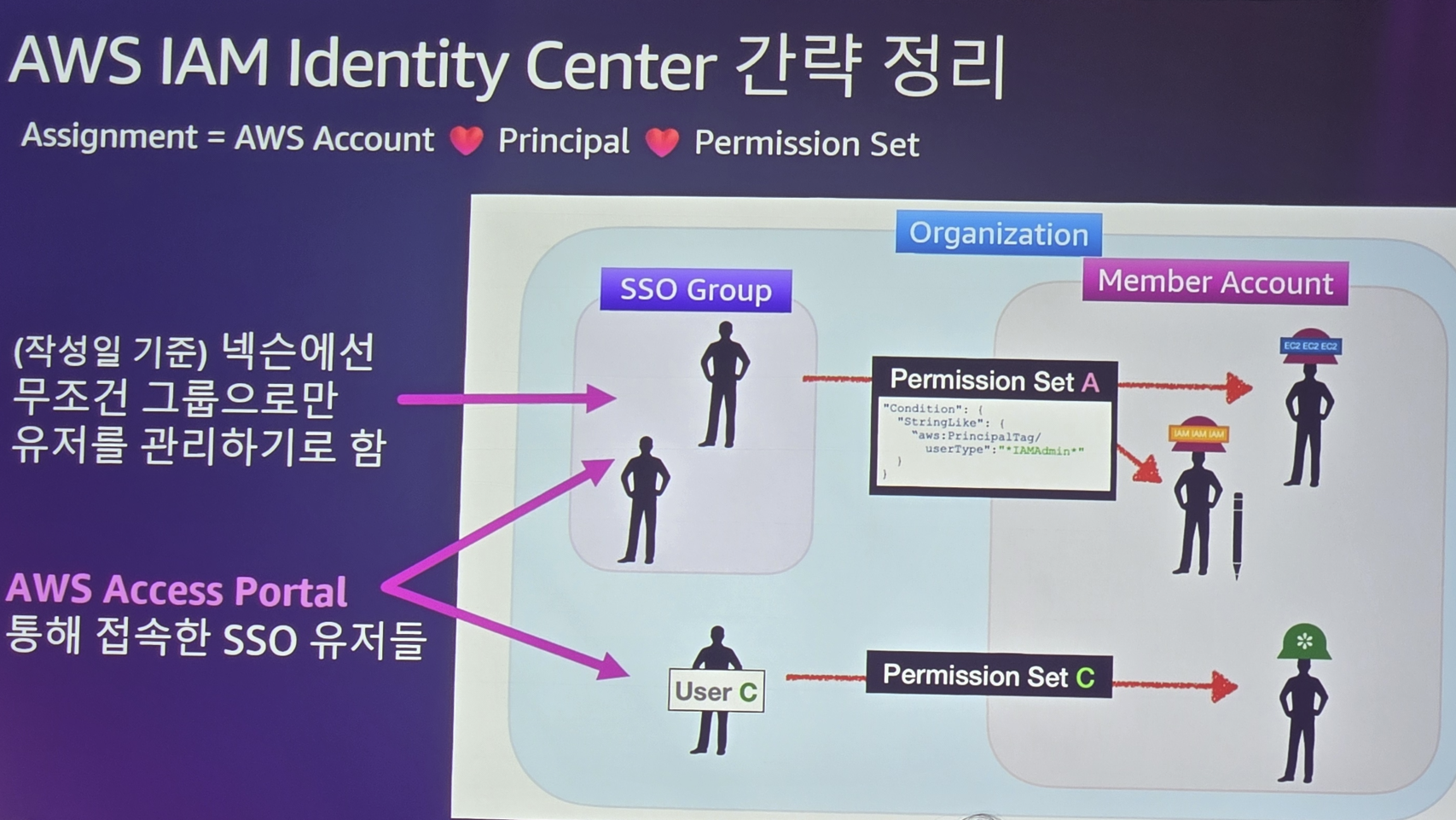

AWS Access Portal을 통해 접속 SSO 유저들에게 그들을 위한 Permission Set을 Member Account에 넥슨이 정한 룰에 맞게 할당하게 됩니다.

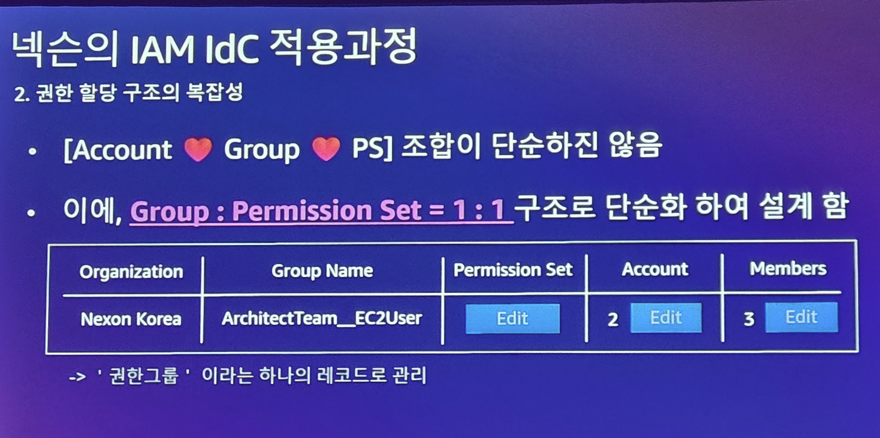

그런데 이러한 할당을 위해 넥슨은 AWS IAM의 기본 기능만으로는 원하는대로 할 수 없어, 이를 API로 자신들만의 백엔드를 구현을 하였고

관리자들이 직접 쉽게 관리할 수 구조를 디자인 하였습니다.

이렇게 함으로써 넥슨은 수많은 내부 개발자(관리자)들에게 찬사를 받았다고 합니다. 이게 그만큼 까다로우면서도, 노가다스러운 관리였는데.. 직관적이며 효율적으로 할 수 있게 된거죠

GitLab의 완전한 DevSecOps에 보안과 governance를 구축

AI가 대세인 AWS를 제가 꾸준히 가는 이유는 제가 듣고자 하는 DevOps 세션도 꽤 있기 떄문입니다. 지금 현업이기도 하구요. 그래서 이 세션을 안들을래야 안들을수가 없었죠

물론 스폰서 세션이라서.. GItlab의 광고 세션이기도 합니다.

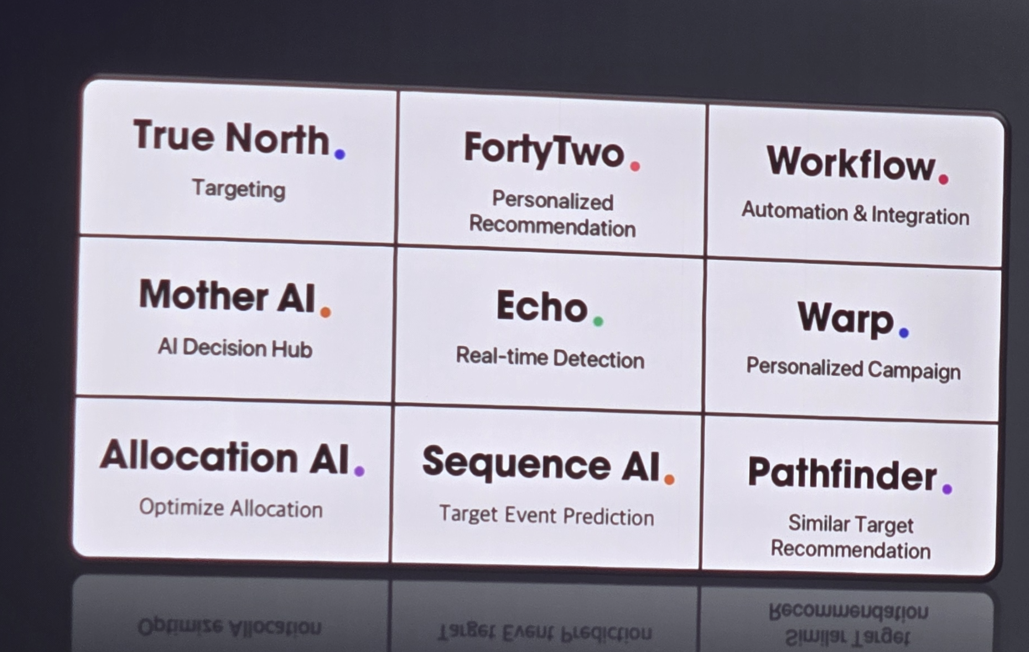

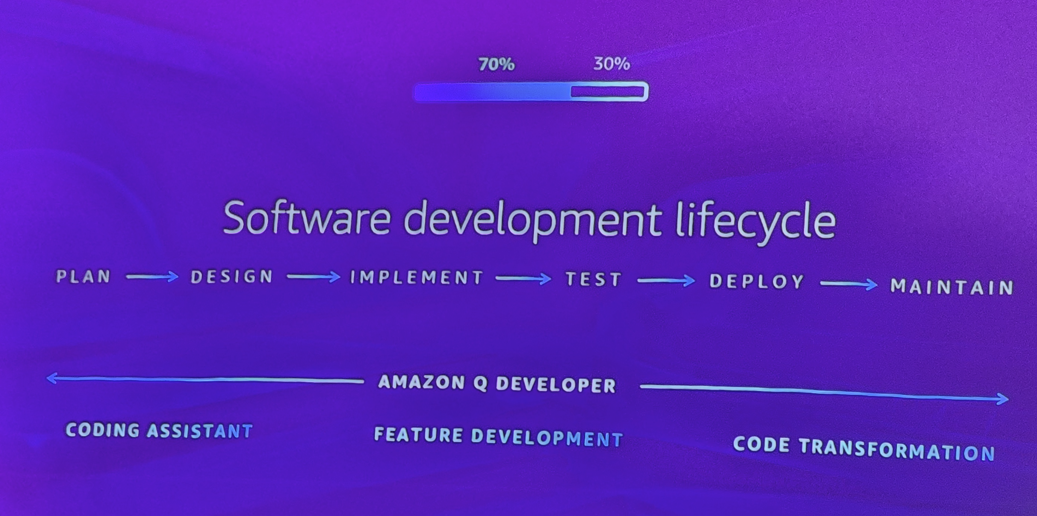

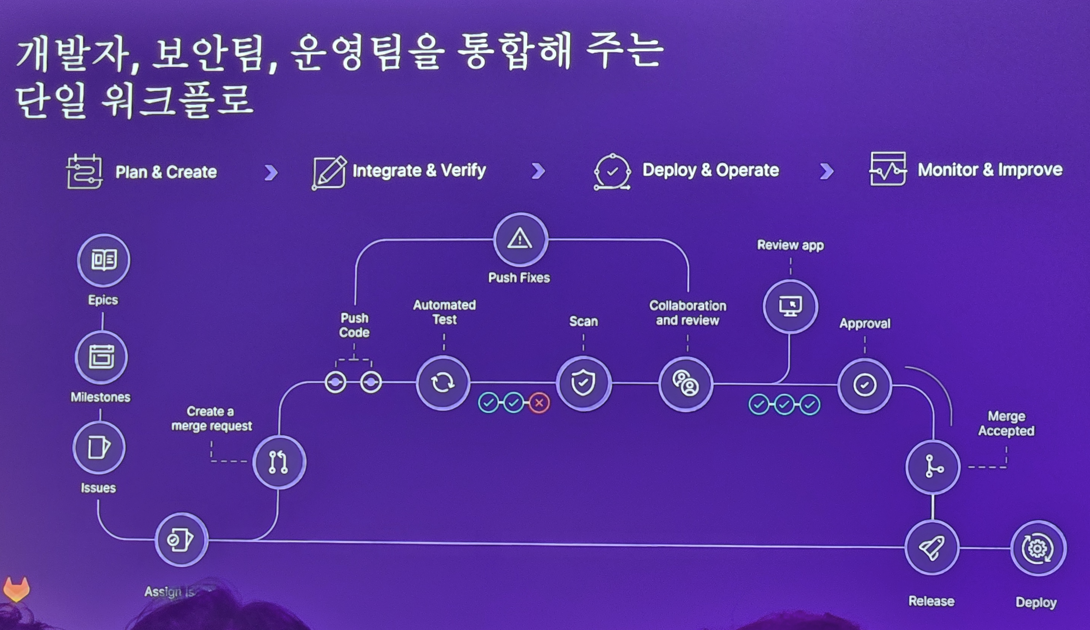

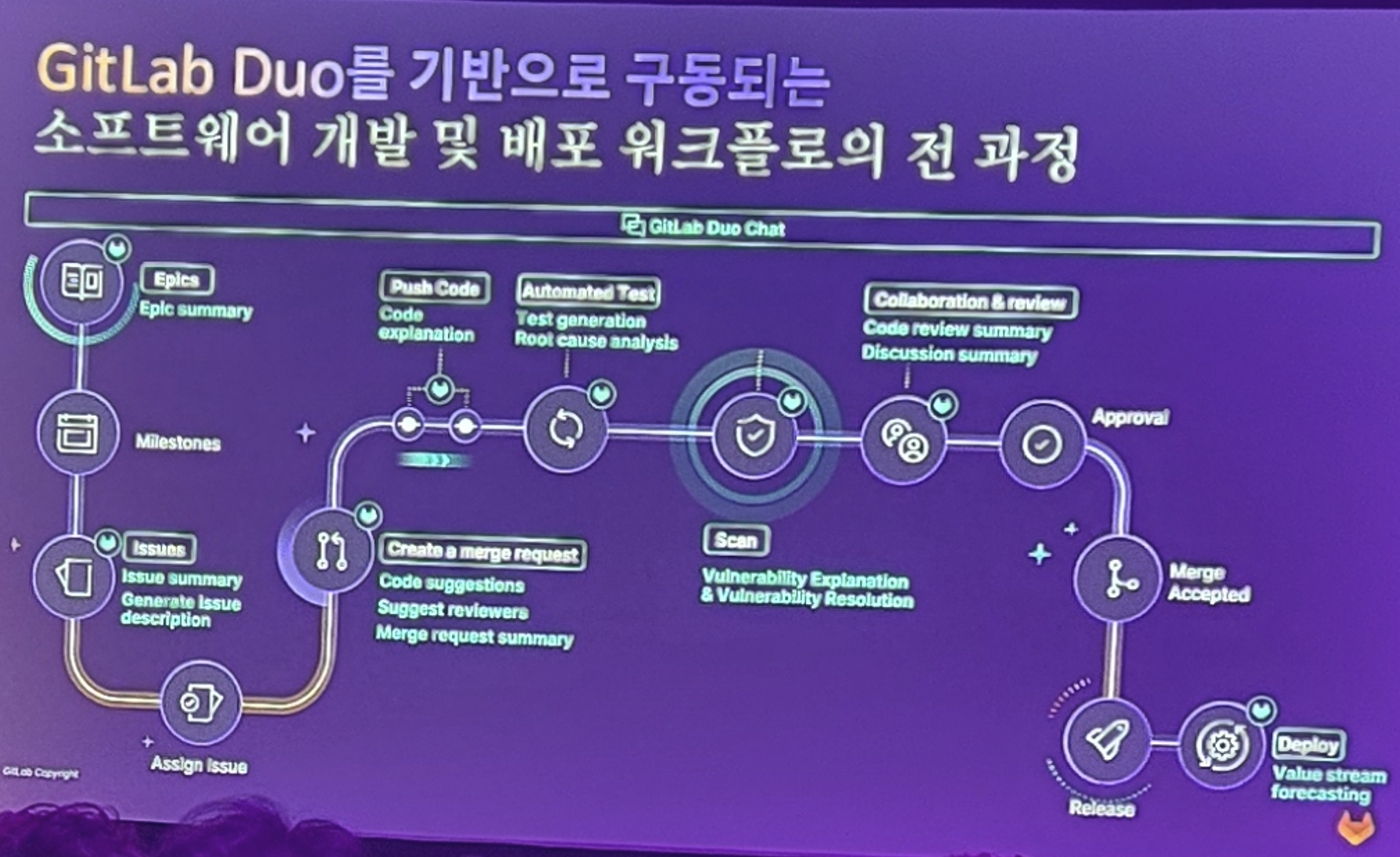

우리 개발의 SDLC를 소개하며

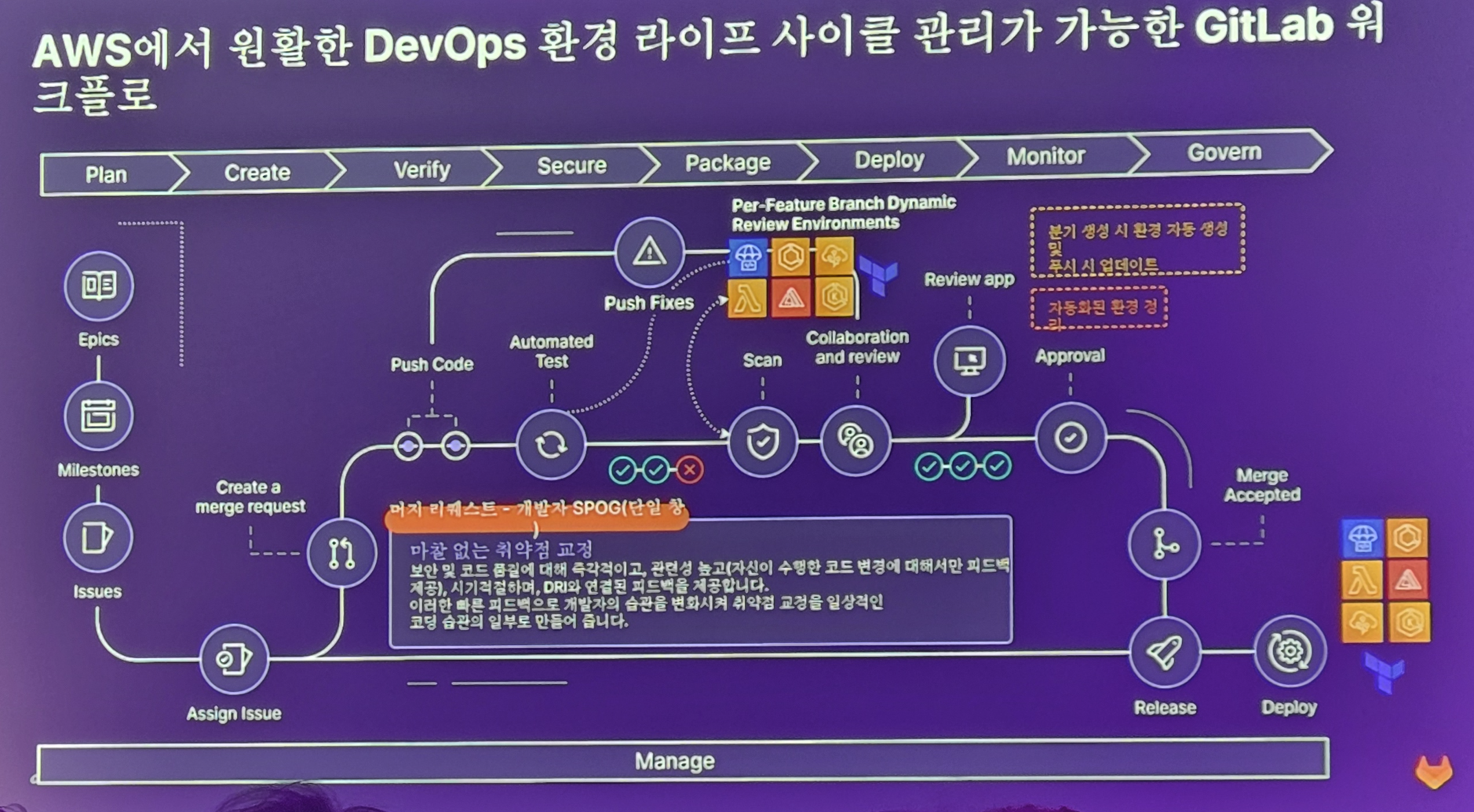

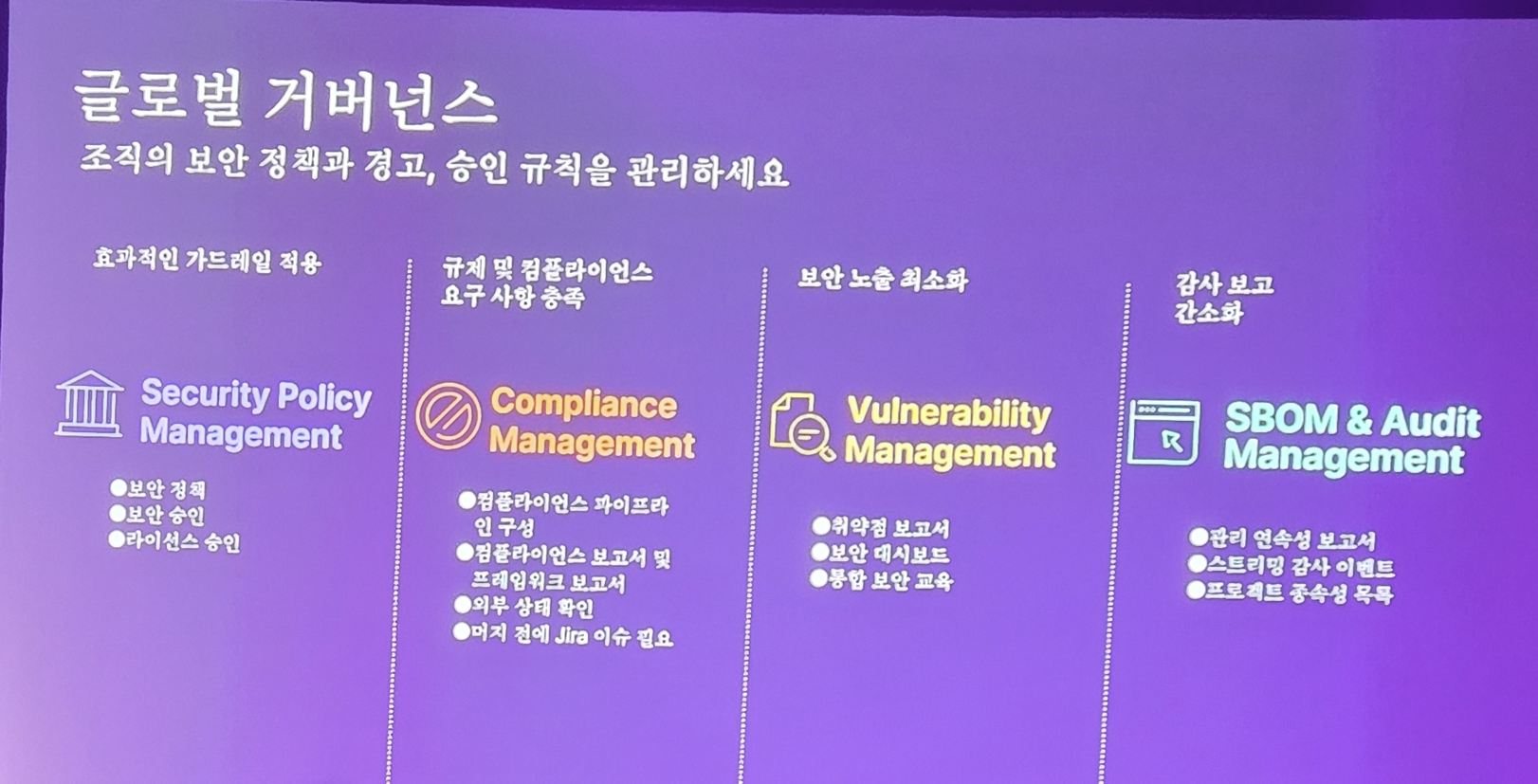

Gitlab은 이러한 Workflow를 AWS와 함께하여 아래와 같이 효율적으로 도입할 수 있다고 소개를 합니다.

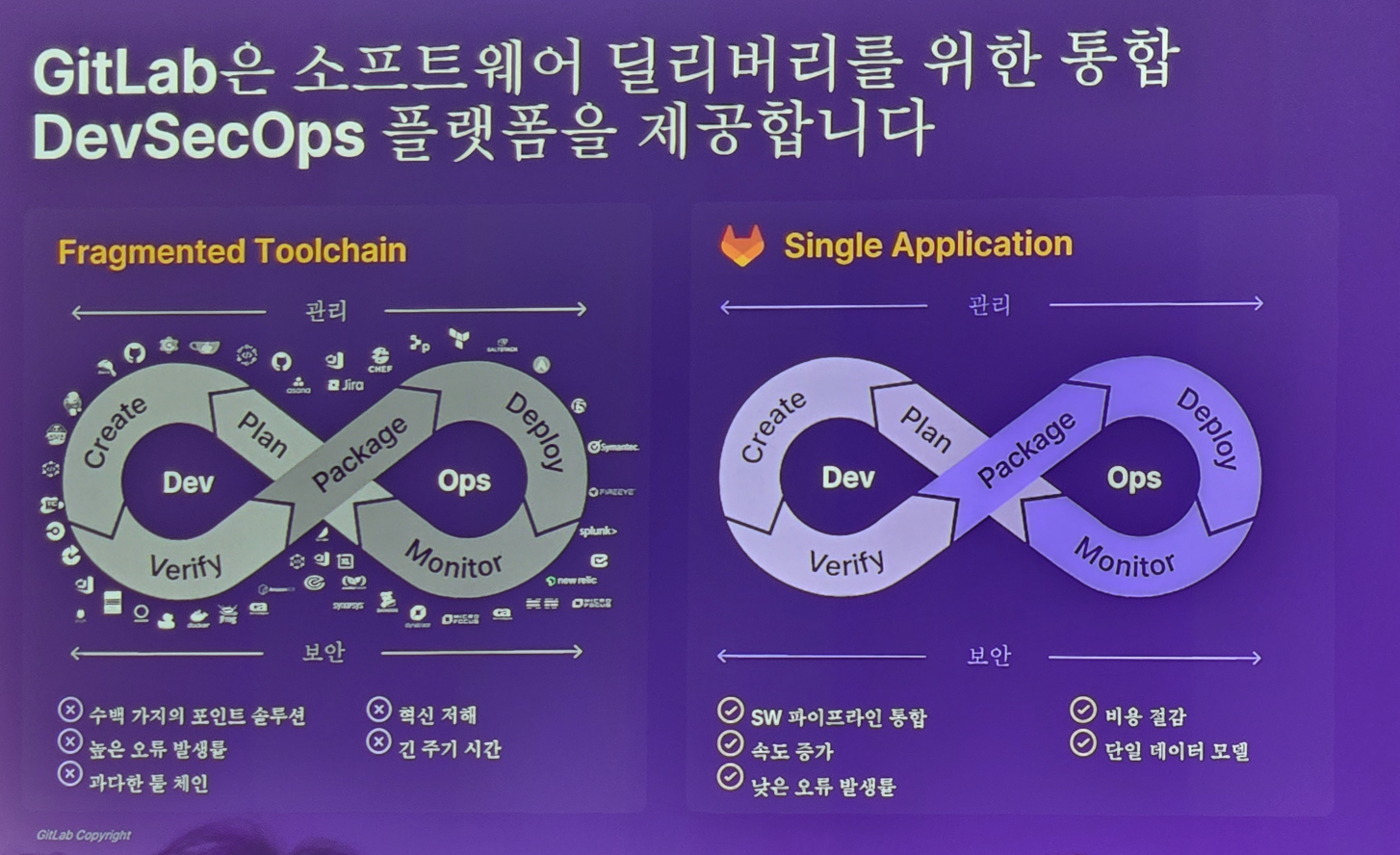

그리고 여러 도구를 거칠 필요 없이 GItlab 하나로 DevSecOps를 실천할 수 있다고 소개를 합니다.

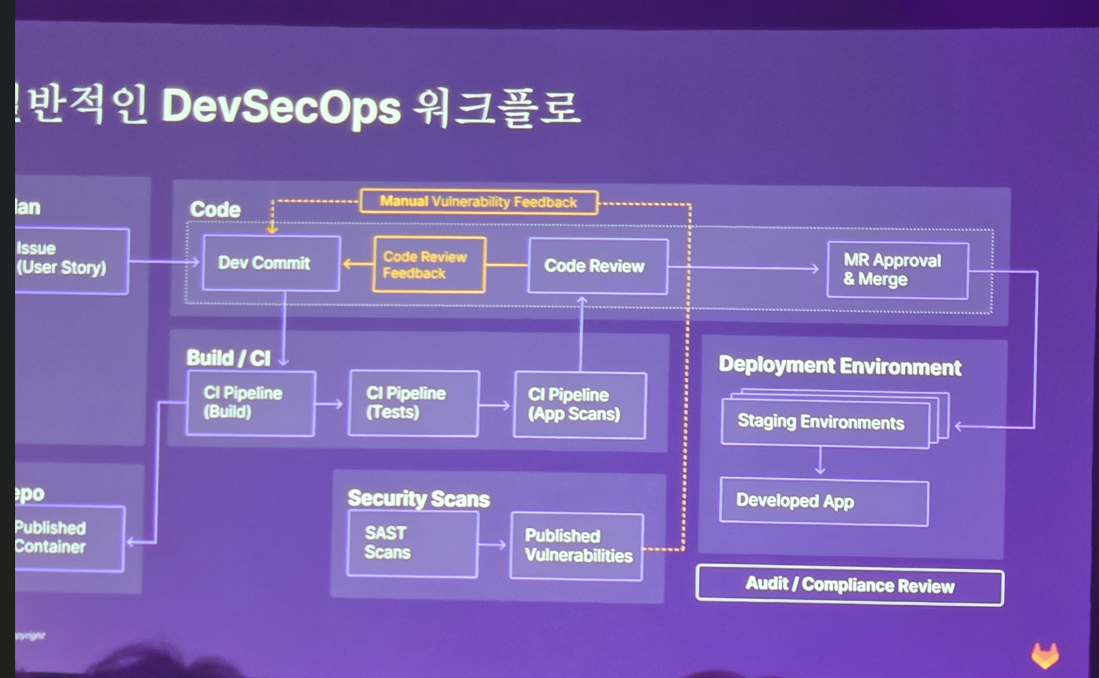

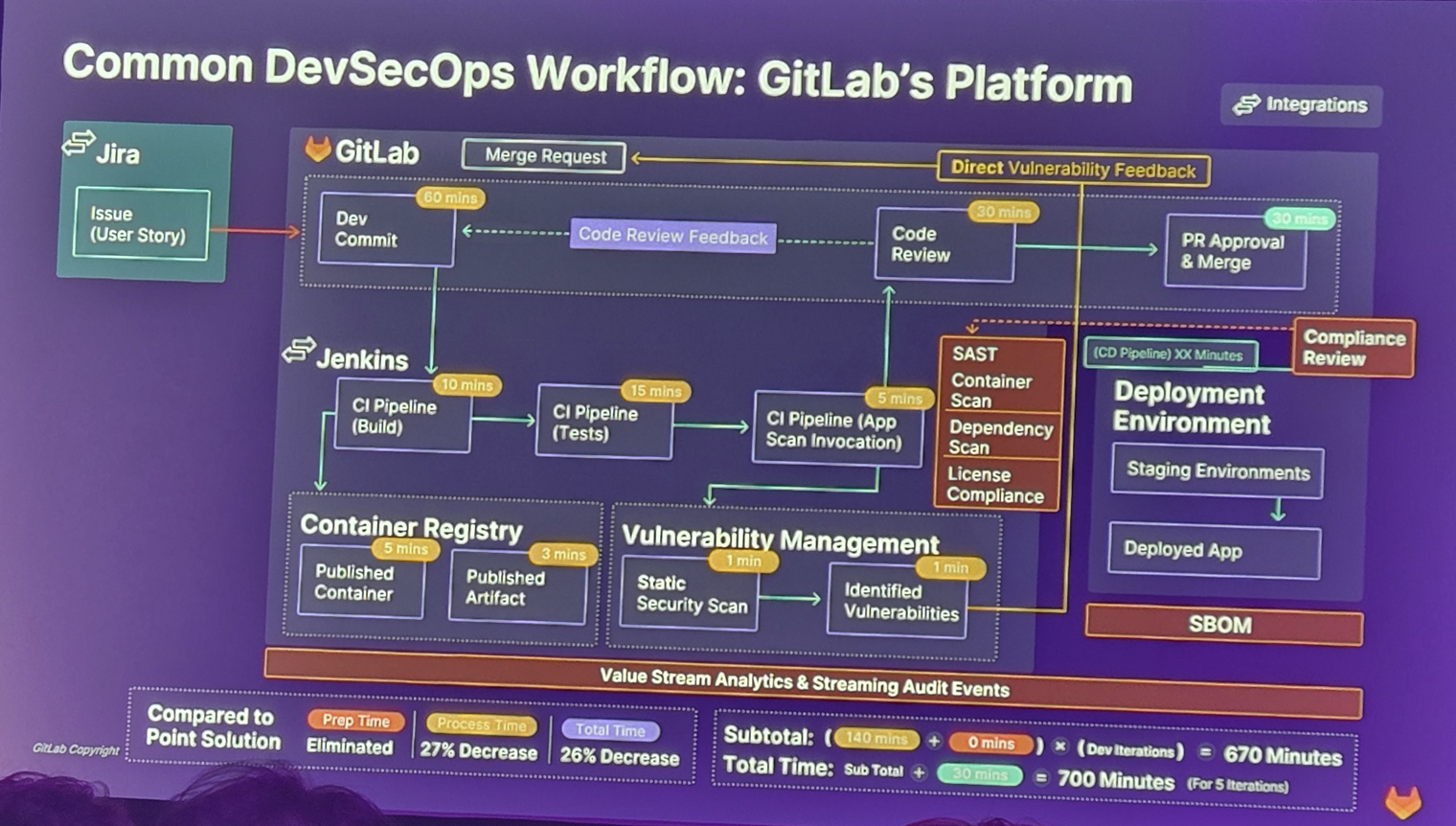

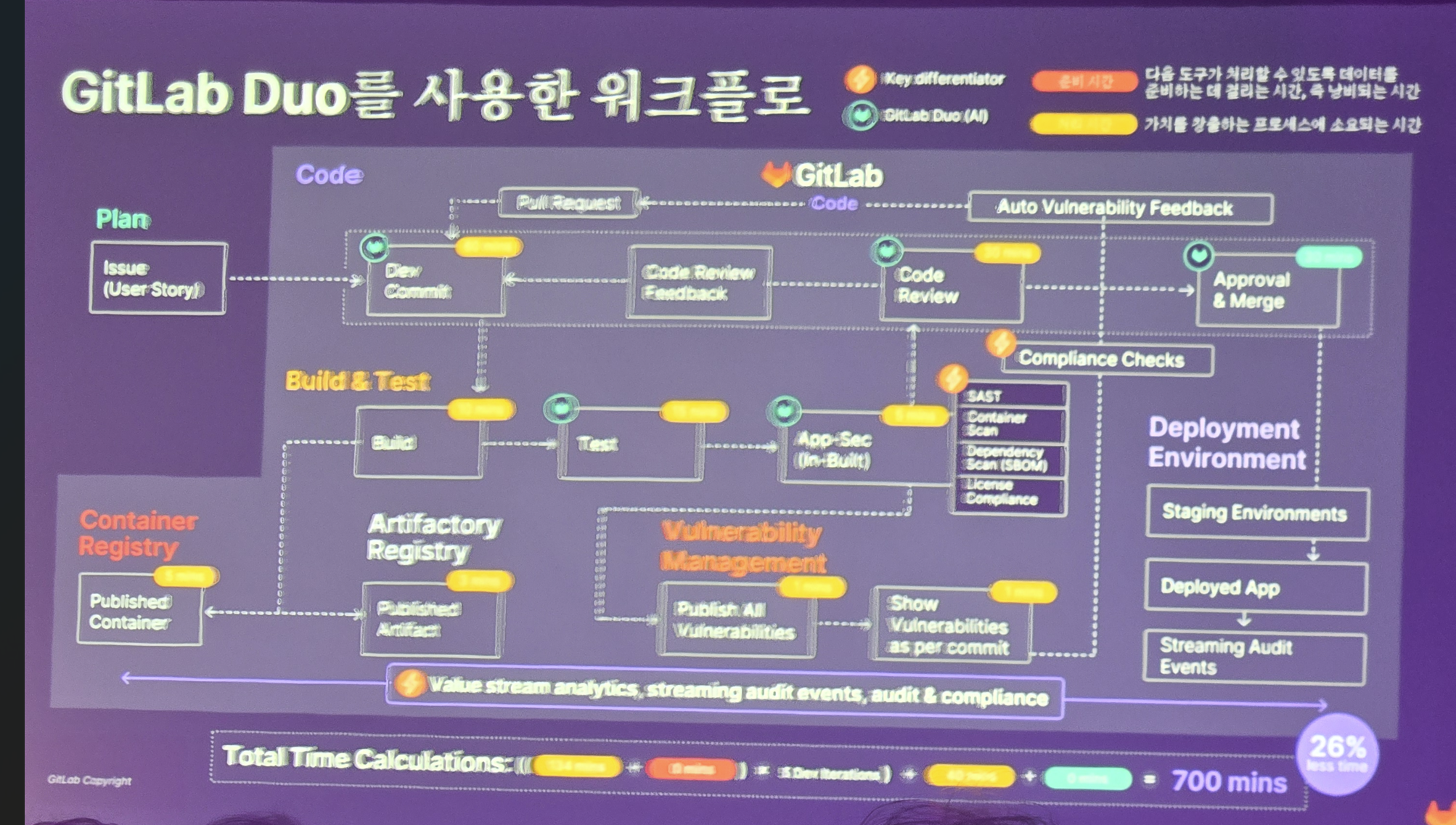

우리의 일반적인 DevSecOps 워크플로는 아래와 같은데 (사진이 잘렸네요 ㅠㅠ)

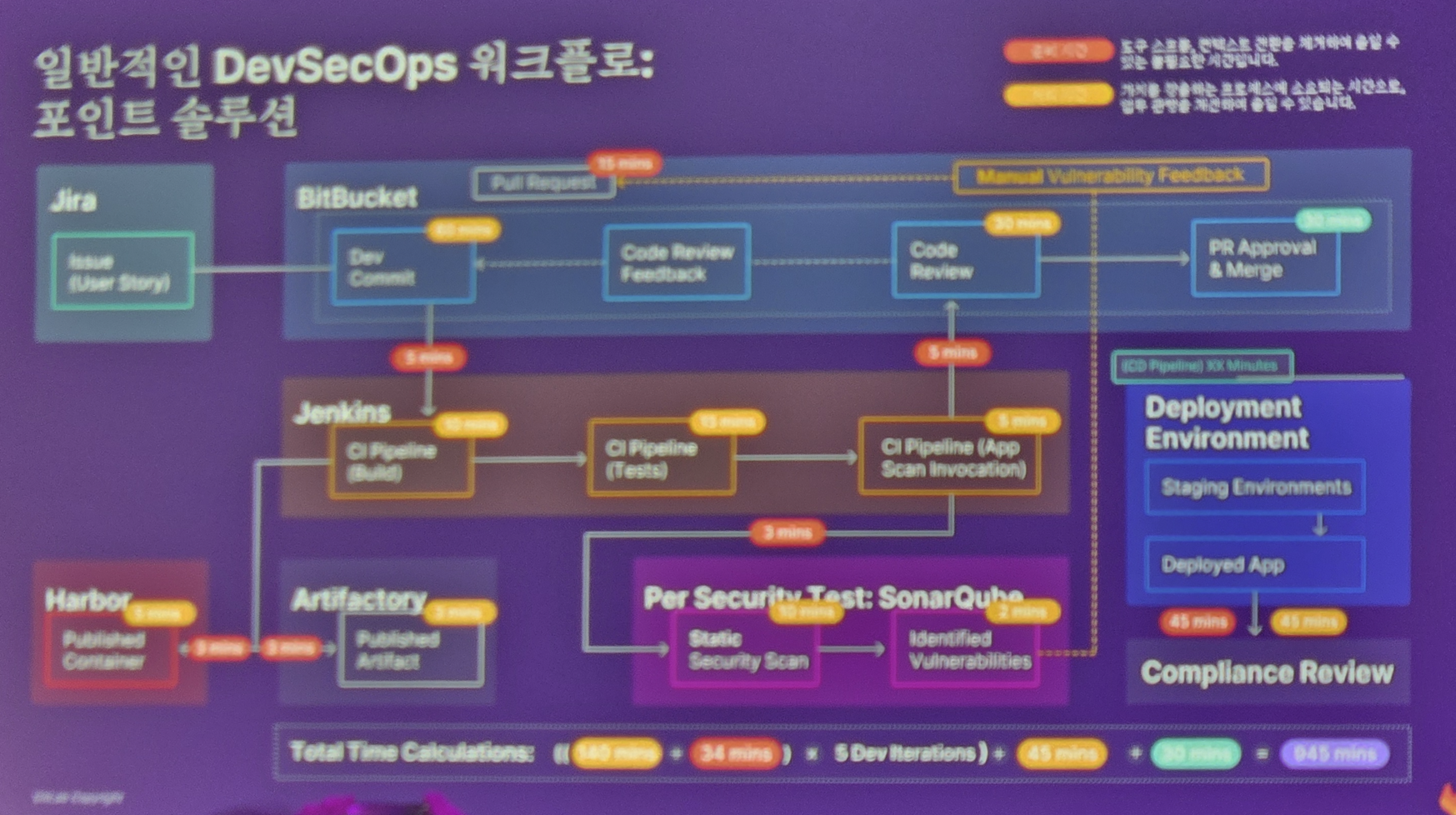

일반적으로 이러한 업무를 다양한 도구들로 하게 되면 (여기에서는 Jira, Bitbucket, Jenkins, Harbor등의 도구를 사용한 예네요.) 945분의 작업이 걸리겠지만

GitLab의 단일화된 All in One Application 서비스를 사용하면 670분으로 단축할 수 있다고 합니다. (이건 그들의 광고 멘트이니 그렇다고 받아줍시다 ^^;;)

물론 다소 과장된 멘트이긴 하지만, 그만큼 설득력 있는 이유는 AI와 여러 통합된 접근법과 솔루션의 기능들이 이를 가능하게 해주는데요

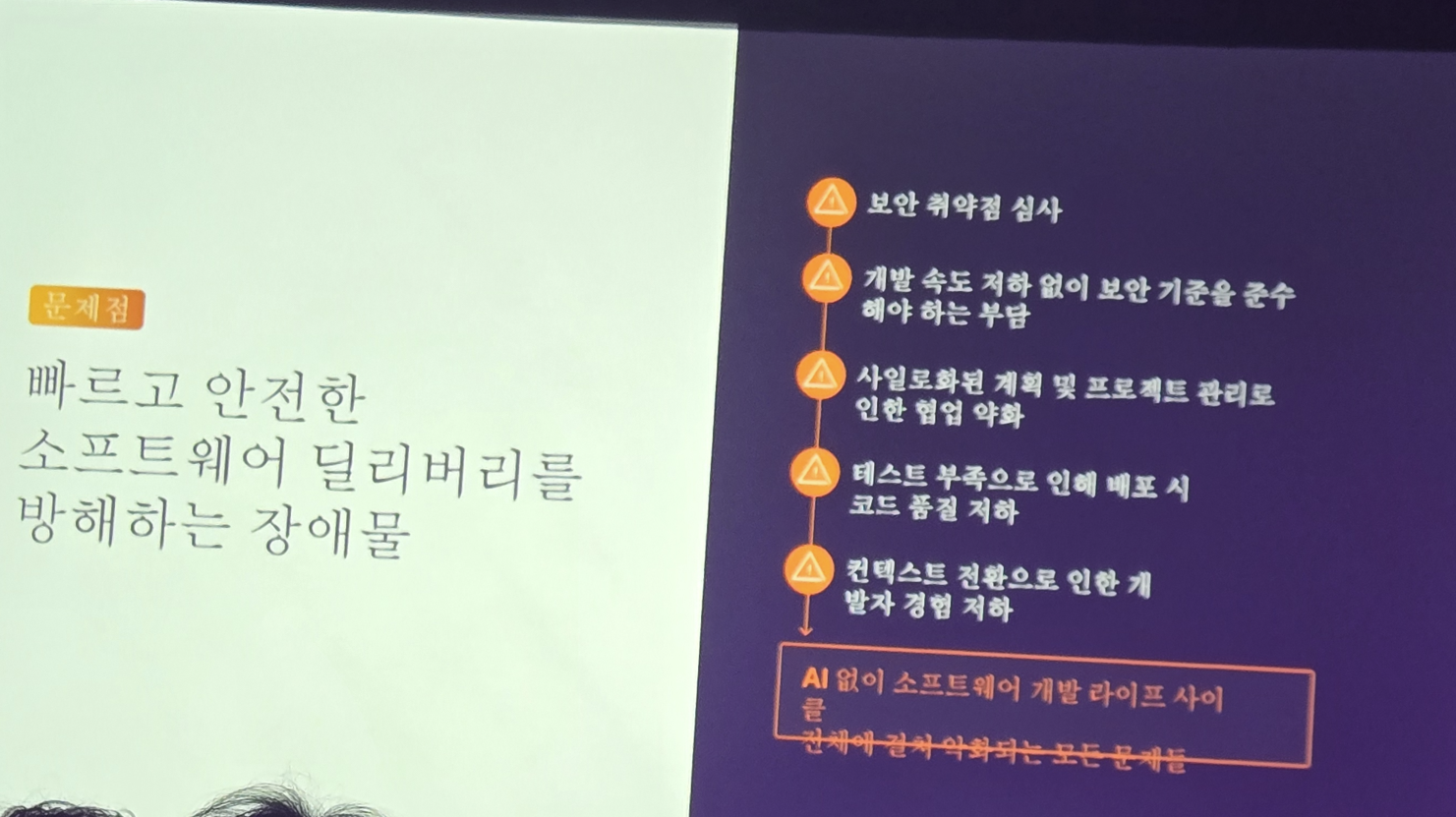

소프트웨어 배포를 지연시키는 요소들이 다음과 같은데

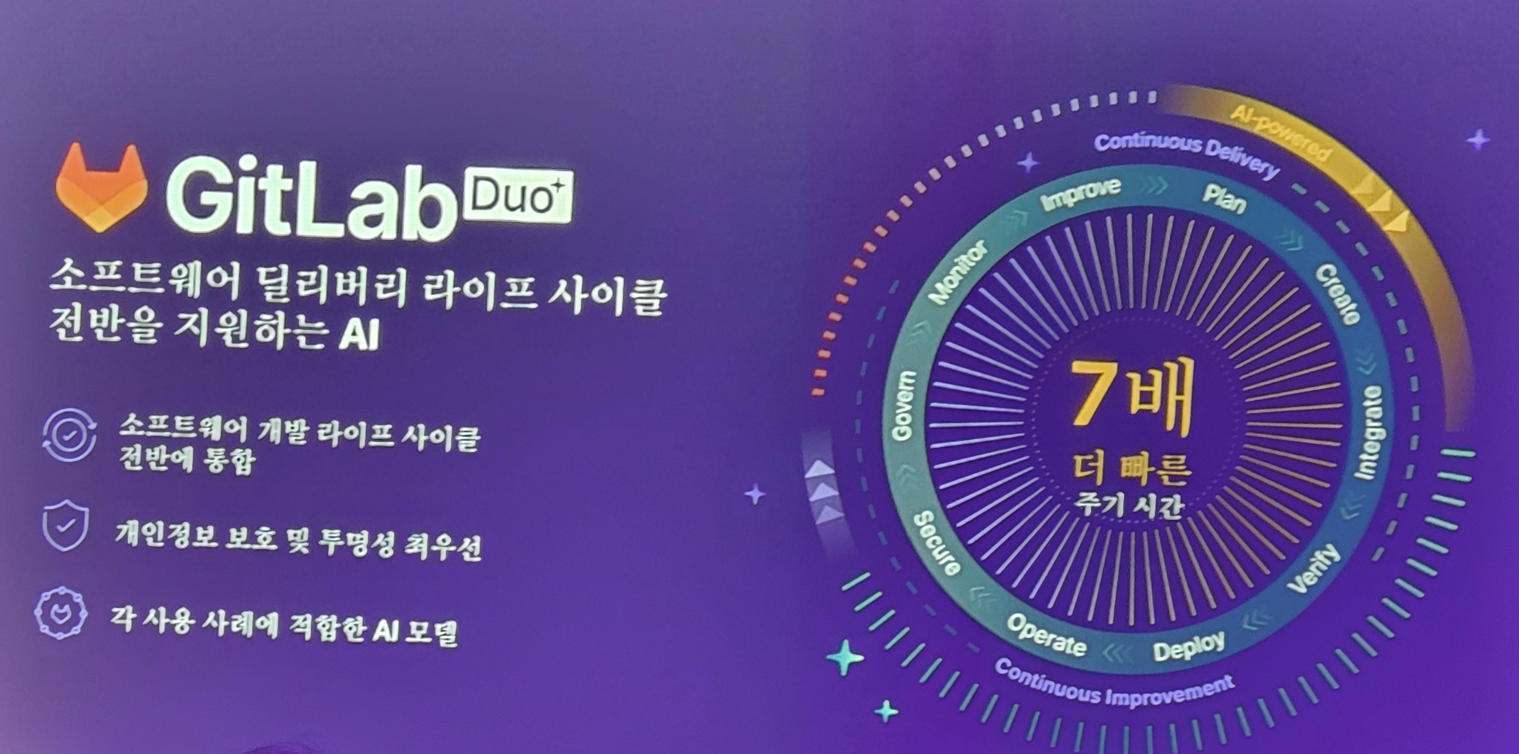

AI가 함께하는 GitLab Duo를 통해 이런 시간을 단축하게 되며

개발 전 과정에서 어시스턴트를 제공하여 효율적으로 일을 할 수 있게 합니다.

그리고 이런 AI 기반의 Gitlab DUO를 더 적극적으로 쓰면 기존의 DevSecOps에 더 많은 생산성, 효율, 보안 강화등을 달성할 수 있게 됩니다.

사실 많이 광고 같은 세션이긴 하지만.. 관련 업무를 하는 입장에서 요즘 현대화된 DevSecOps를 어떻게 GItLab같은 유명한 도구가 다루는지 알 수 있는 세션이었습니다.

하나은행의 디지털혁신: AWS 랜딩존 구축과 '아이부자' 서비스 구현 사례를 통한 클라우드 도입 여정

DevOps가 제 주요 관심사인 만큼 그 다음 세션은 금융 기업에서의 DevOps 및 Cloud 도입에 대한 내용을 듣게 되었습니다.

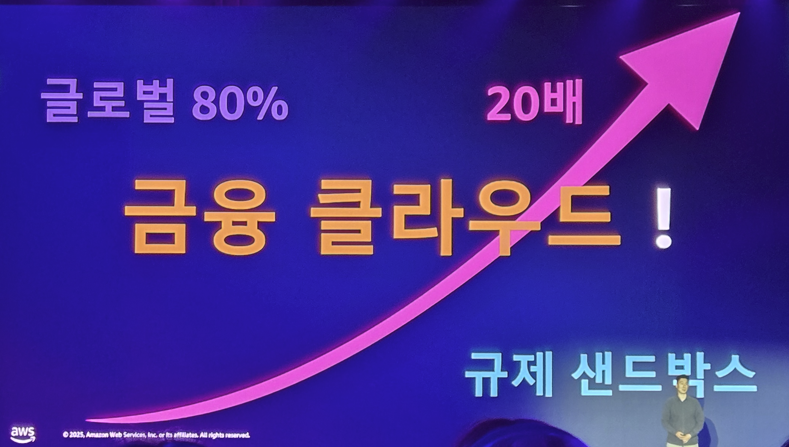

금융 기업은 정부의 규제 샌드 박스로 인해 IT 서비스 도입이 쉽지 않다고 합니다. 하지만 그럼에도 금융 클라우드는 급성장하고 있는데요

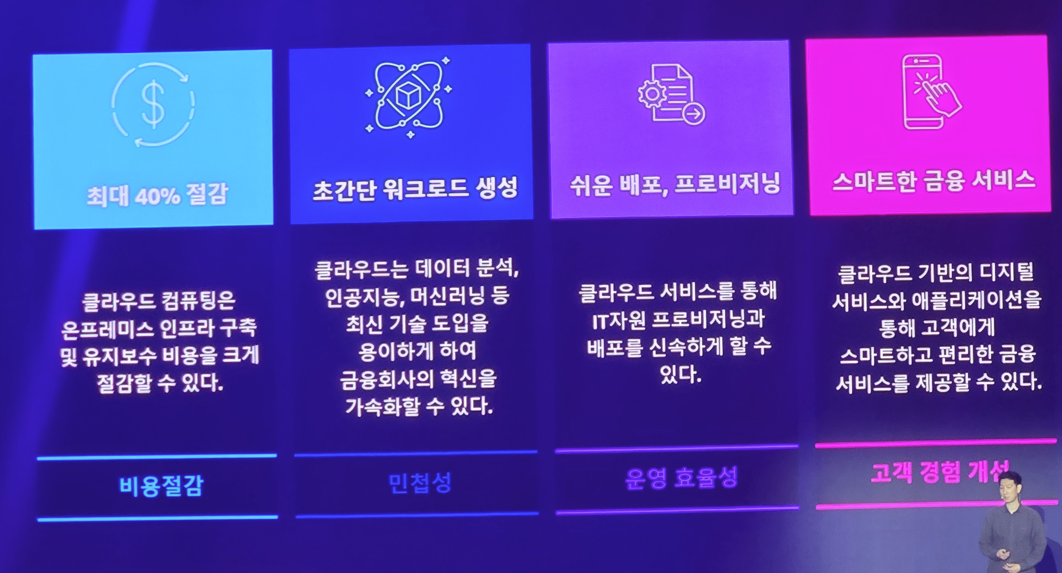

클라우드가 갖는 이런 장점들을 금융업도 도입을 안할 수 없기 떄문입니다.

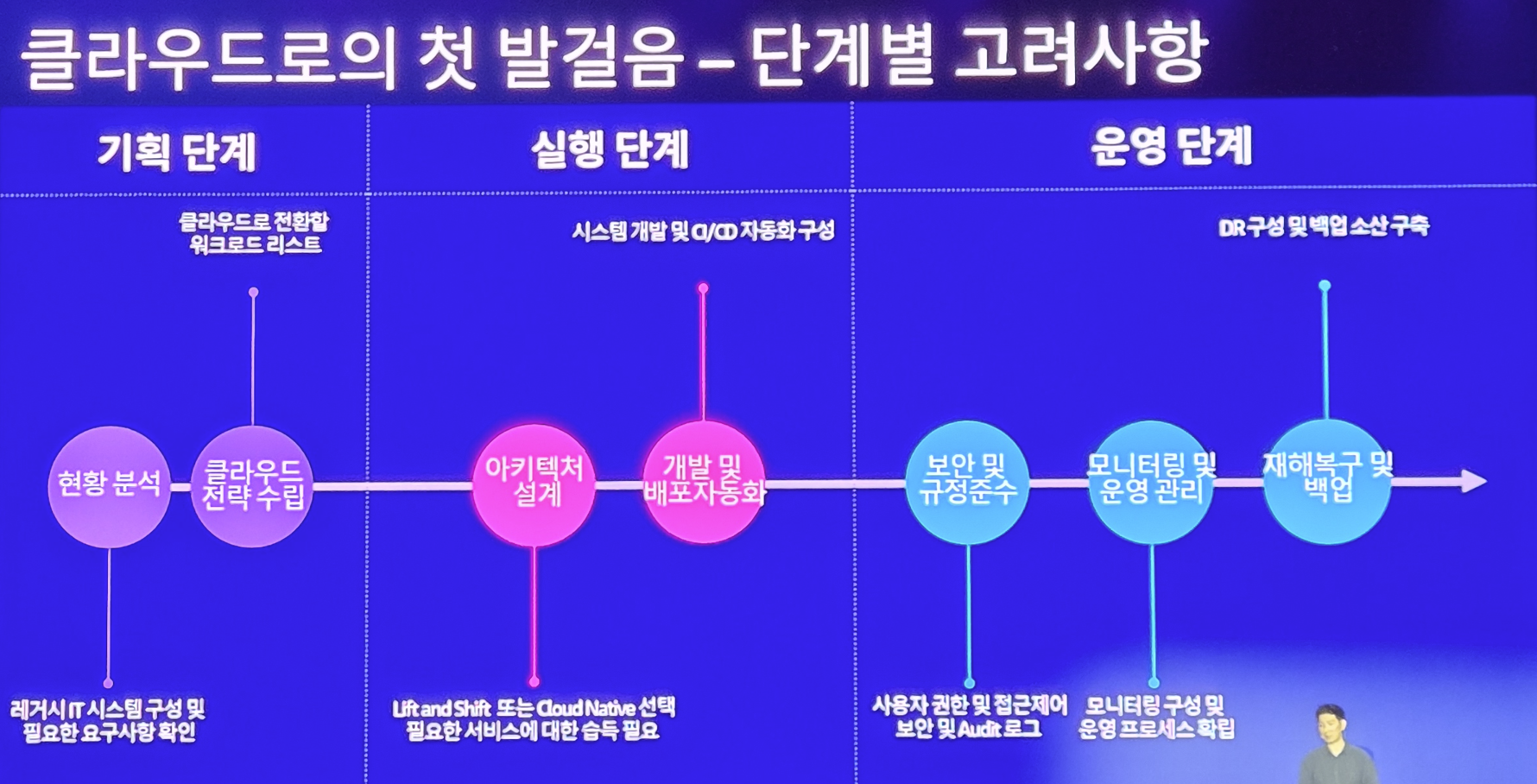

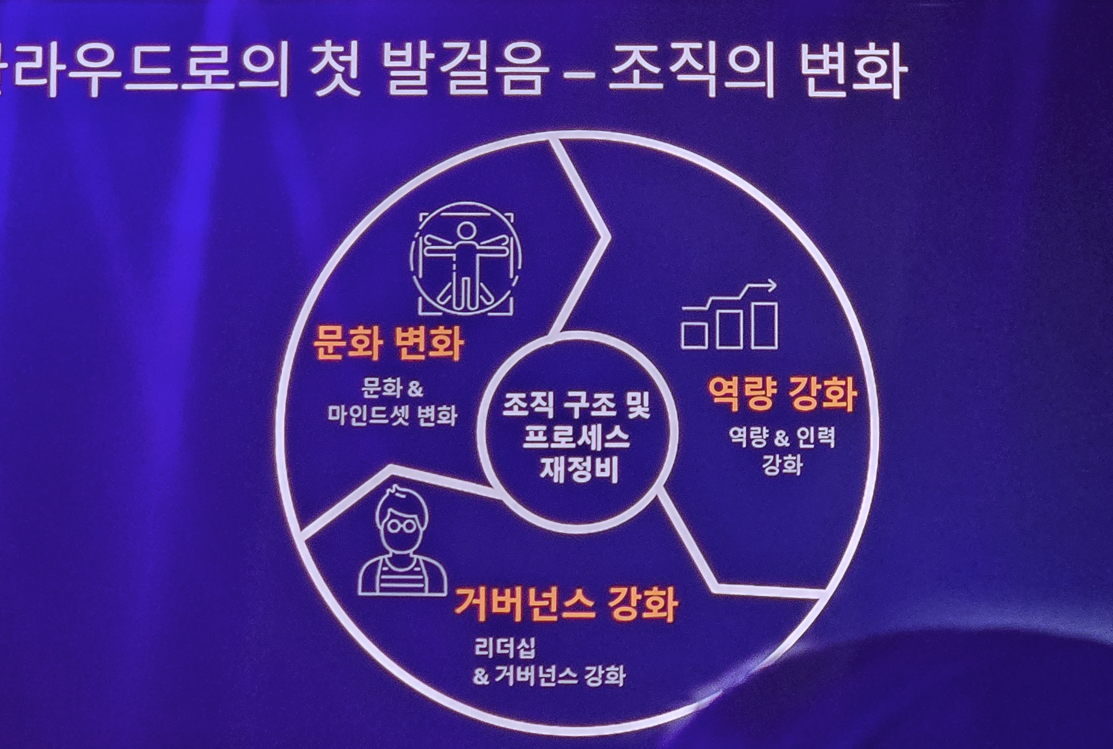

하나 은행도 이러한 현대적인 흐름에 맞춰 계획을 세우고 클라우드 기반의 일하는 문화를 만들려고 준비를 하게 됩니다.

이러한 클라우드 전환은 정말 기업 입장에서 큰 각오와 문화 도입, 경영진의 의지가 중요한데

하나은행은 AWS를 이용하여 이러한 클라우드 전환 및 MSA 중심의 DevOps 전환을 준비하게 됩니다.

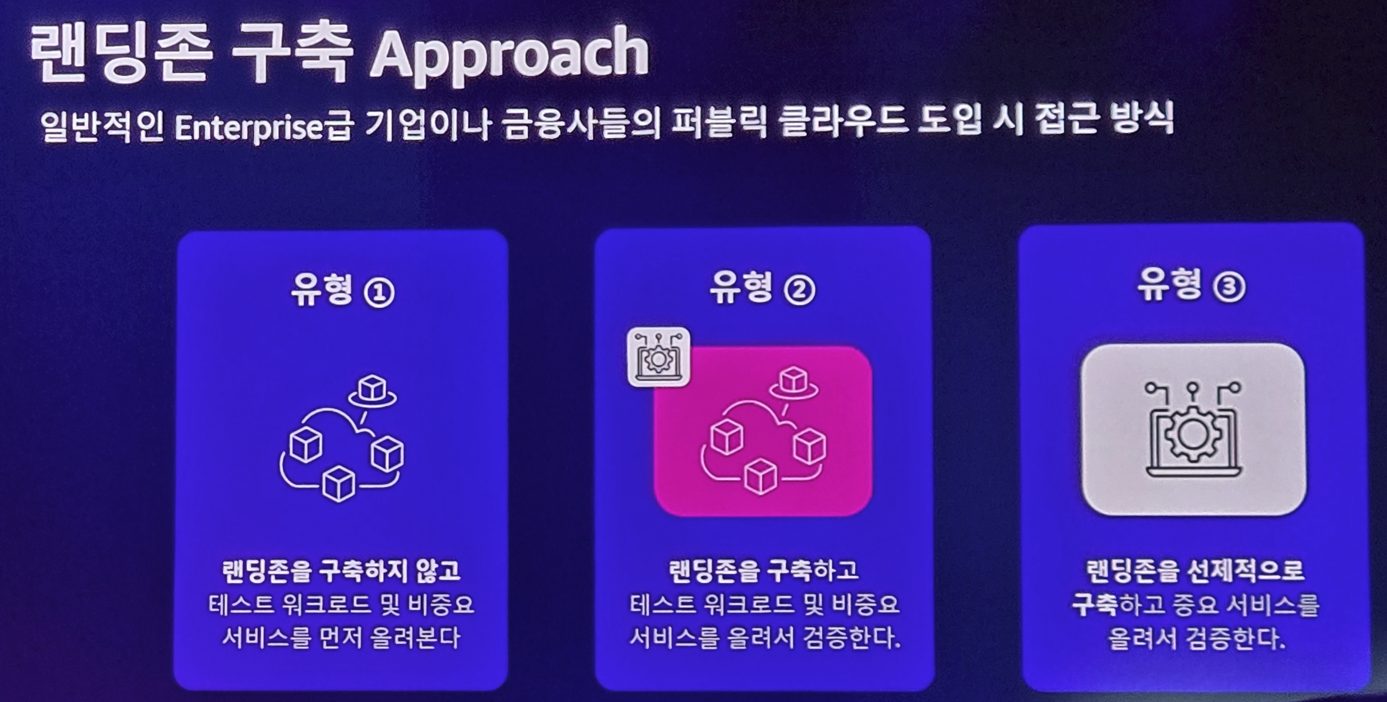

그리고 하나은행은 이런 도입에 있어.. 보통의 기업들이 리스크가 두려워 비중요 서비스나 테스트 워크로드 단계를 밟아가며 차근차근 접근하는 방법과 다르게 과감하게 랜딩존을 바로 구축하고 중요 서비스를 바로 올리는 계획을 세우게 됩니다.

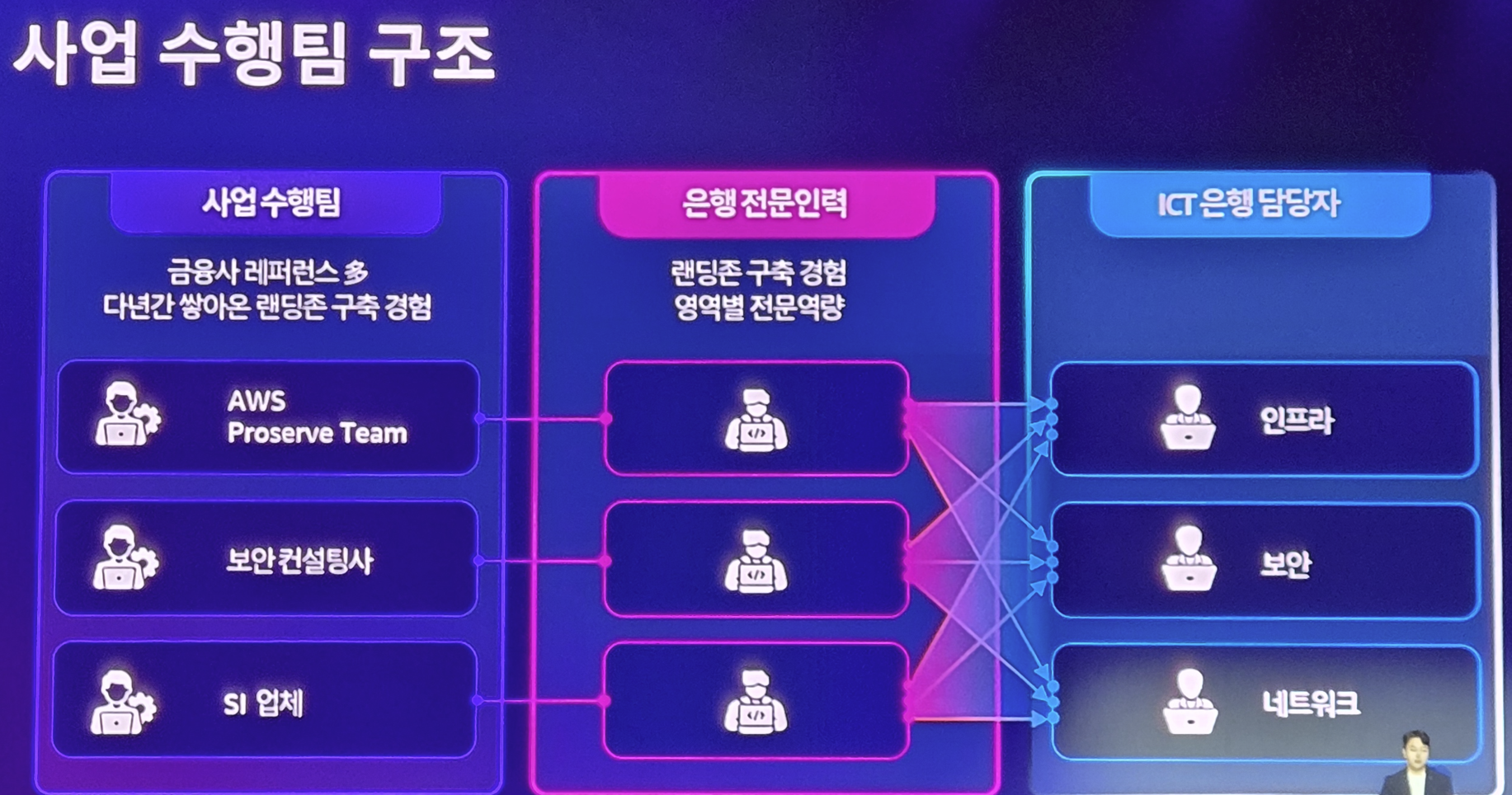

그리고 원활한 업무를 위한 커뮤니케이션 체계를 구축하고

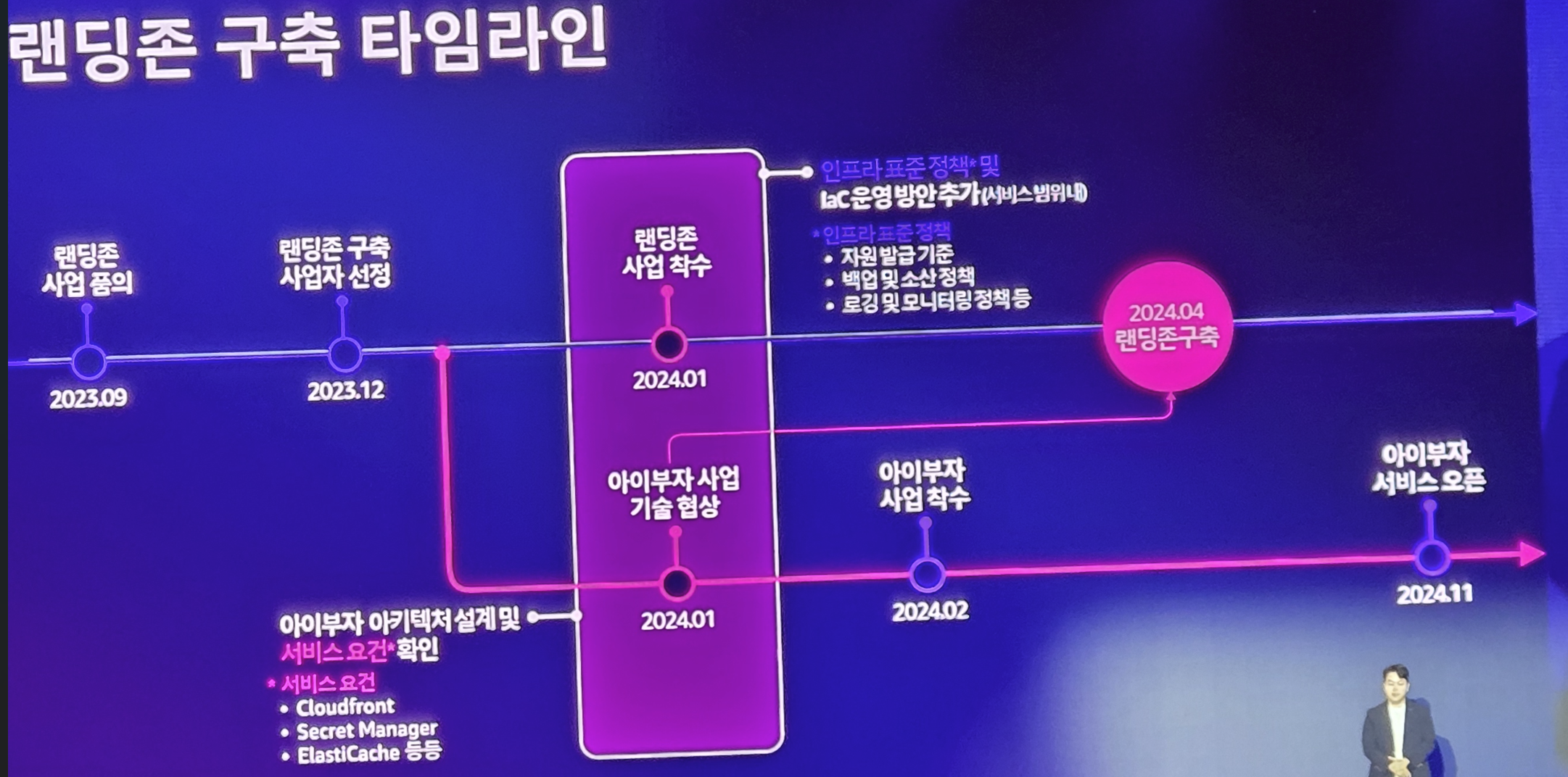

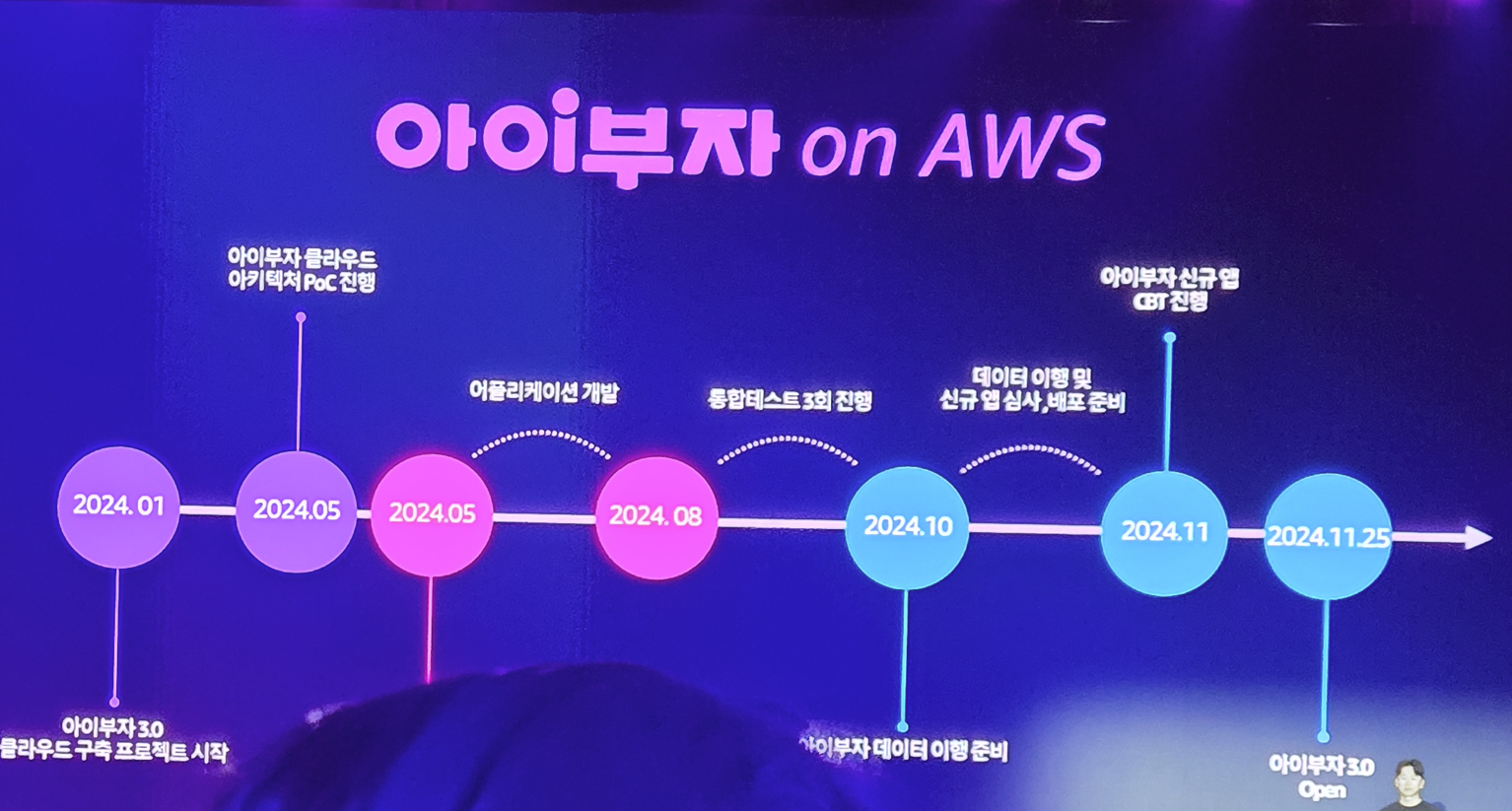

24년 1월에 사업을 착수, 3개월만에 랜딩존을 구축하고 9개월만에 첫 서비스를 런칭하게 됩니다.

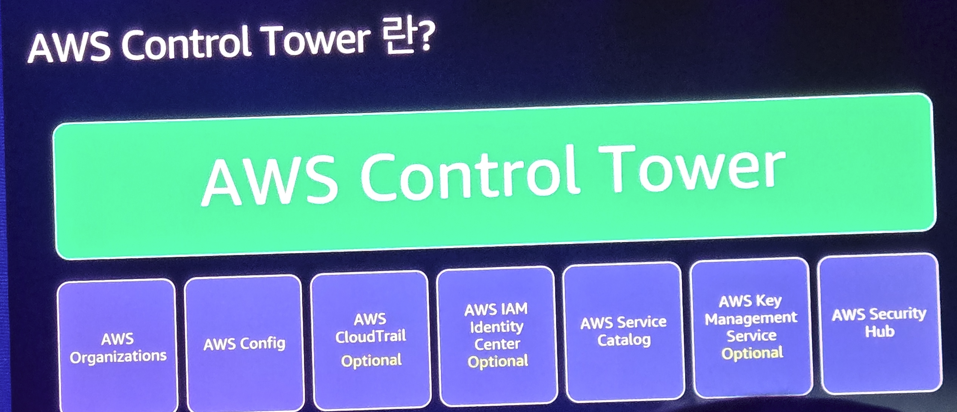

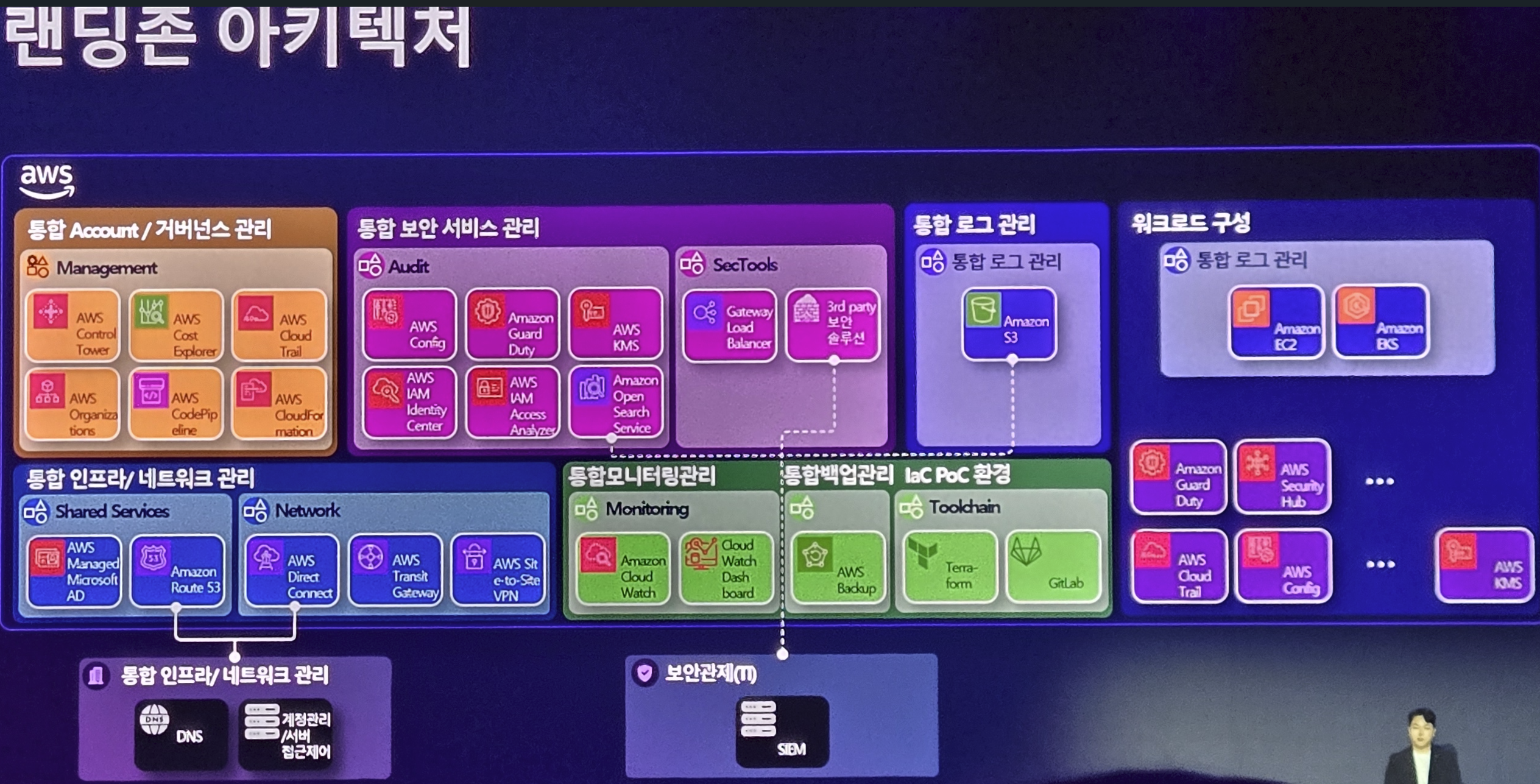

그들은 이 랜딩존 구축을 모두 AWS 서비스를 기반으로 진행하였으며

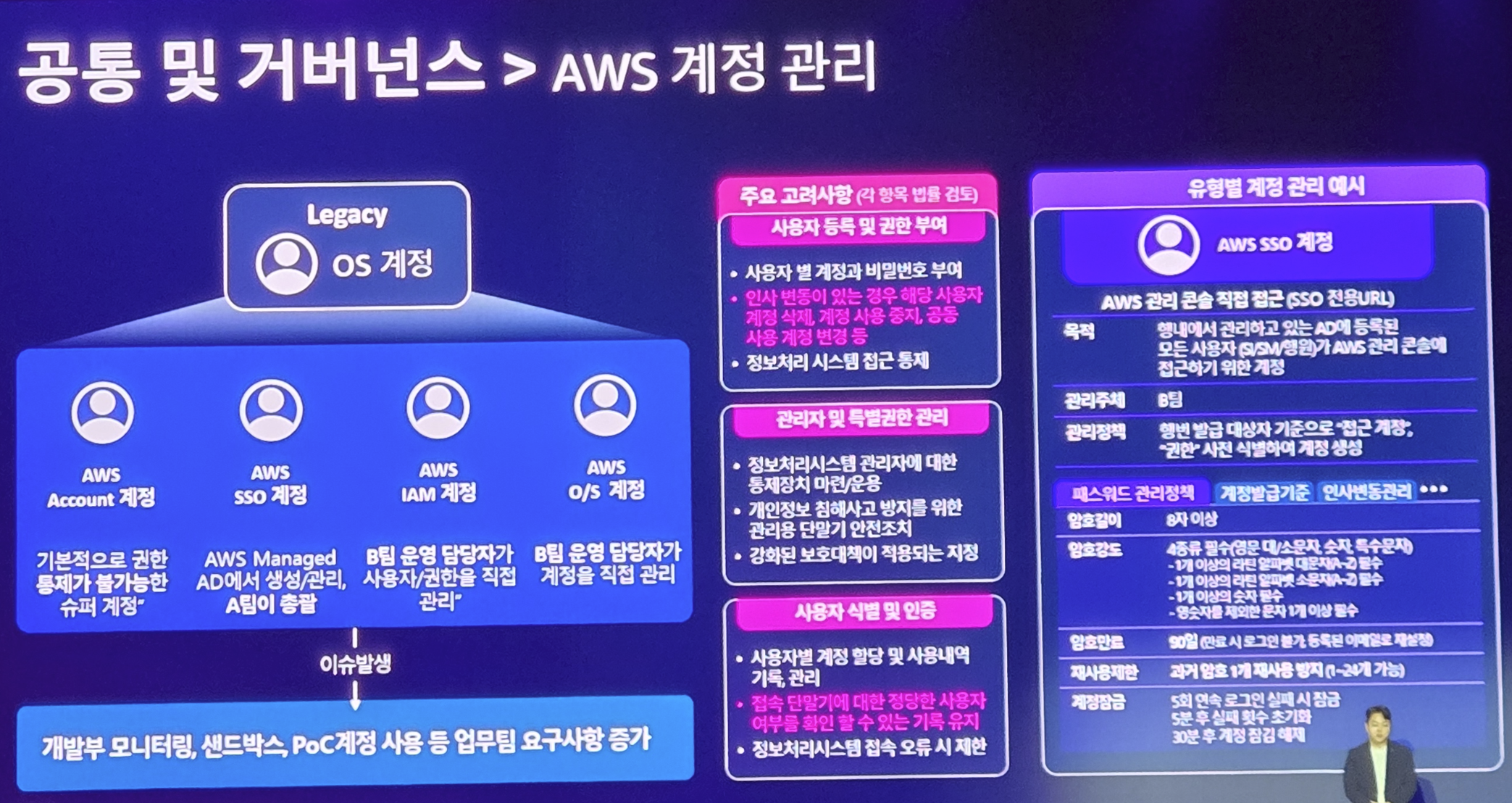

사용자 계정 관리 정책을 세우고

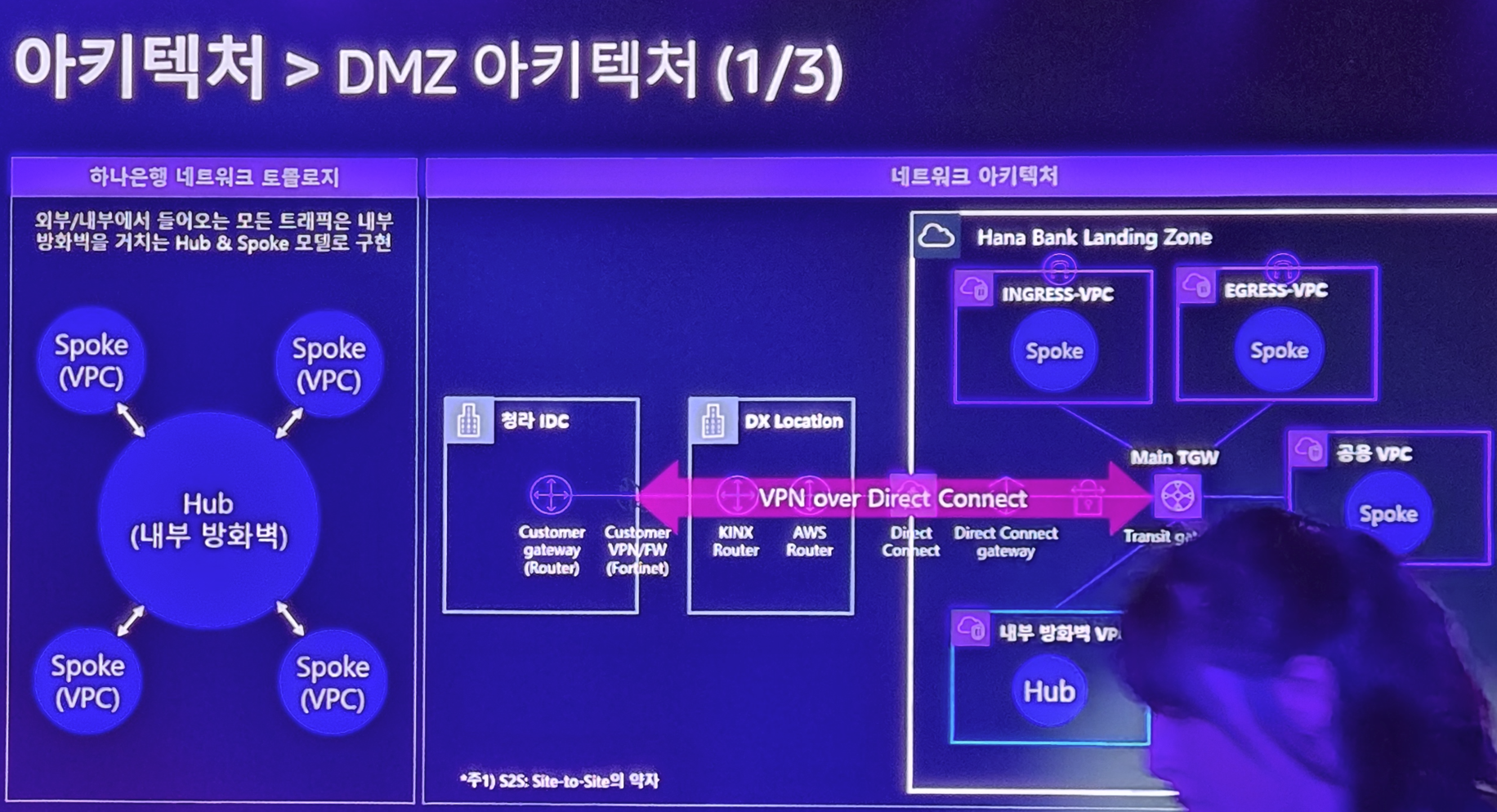

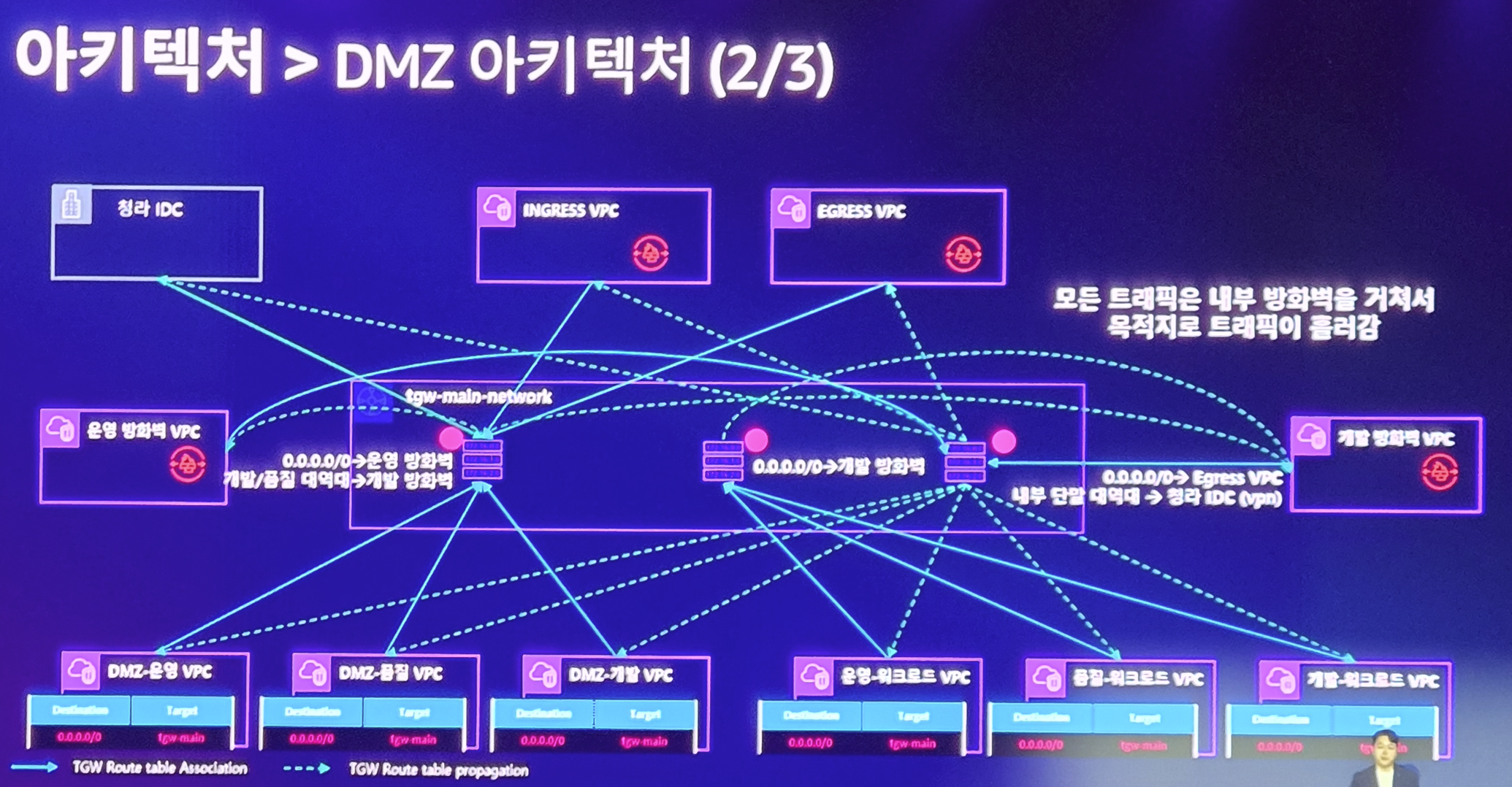

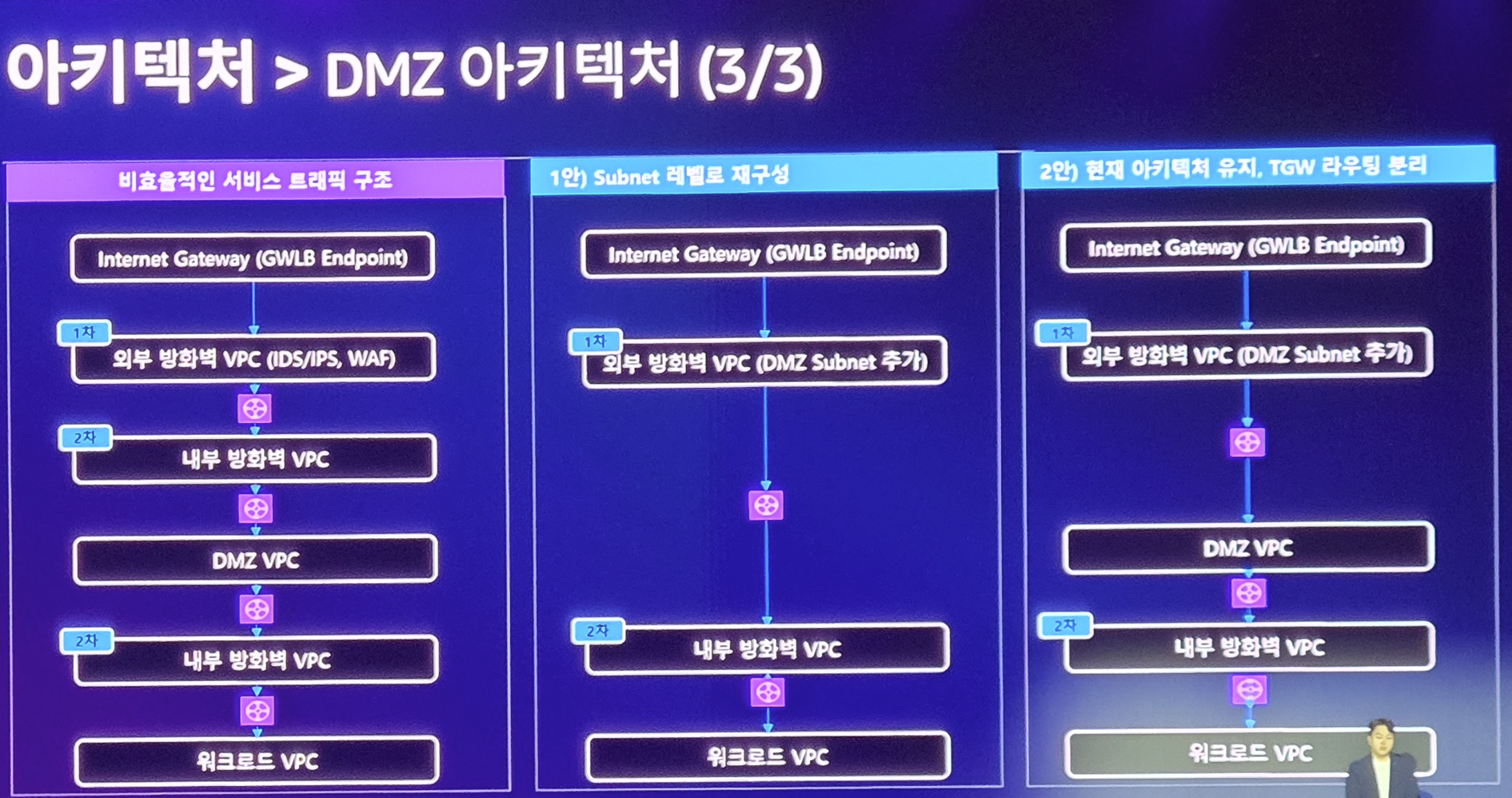

AWS 기반의 네트워크를 구성하였으며

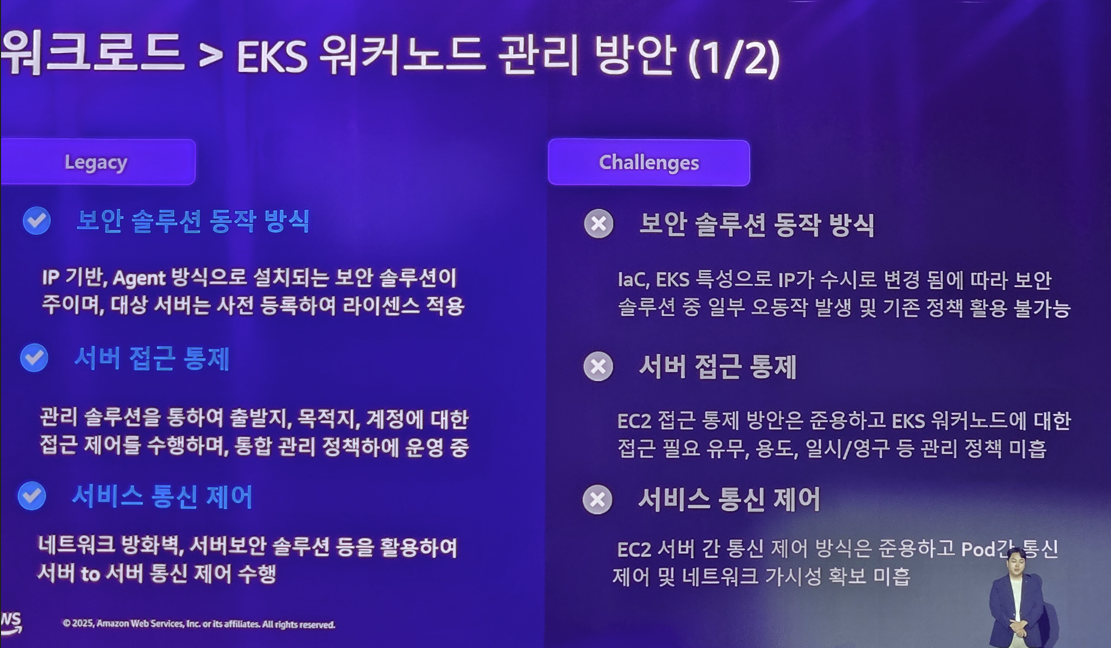

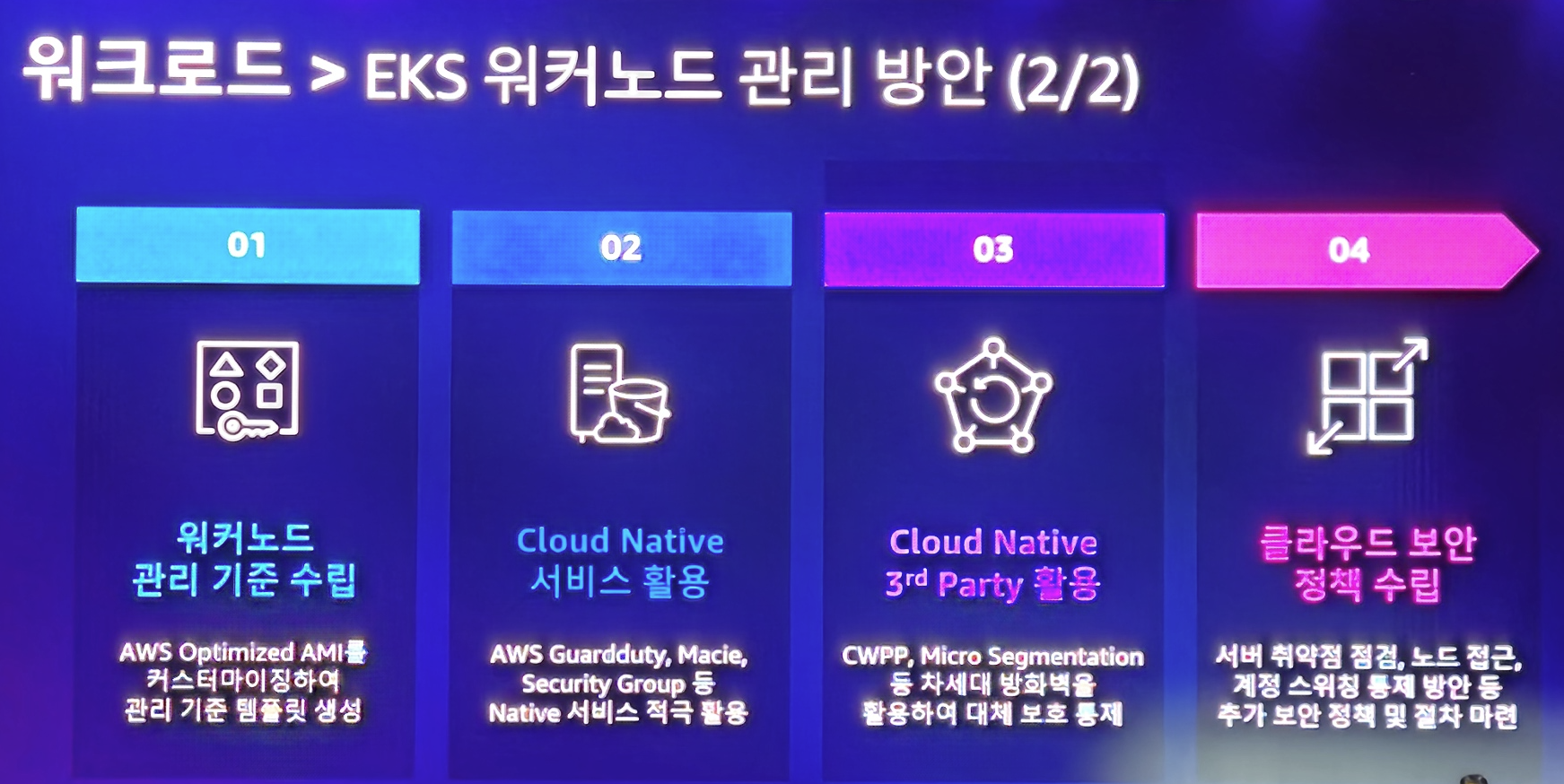

이러한 복잡도 높은 클라우드 인프라에 대한 보안팀의 걱정을 위해 체계적인 워크 로드 관리 방안을 적용하였습니다.

이를 통해 금융업에 적용된 아주 높은 수준의 보안 요구 사항을 달성할 수 있었으며 빠르게 개발 및 서비스 확장이 가능해지게 됩니다.

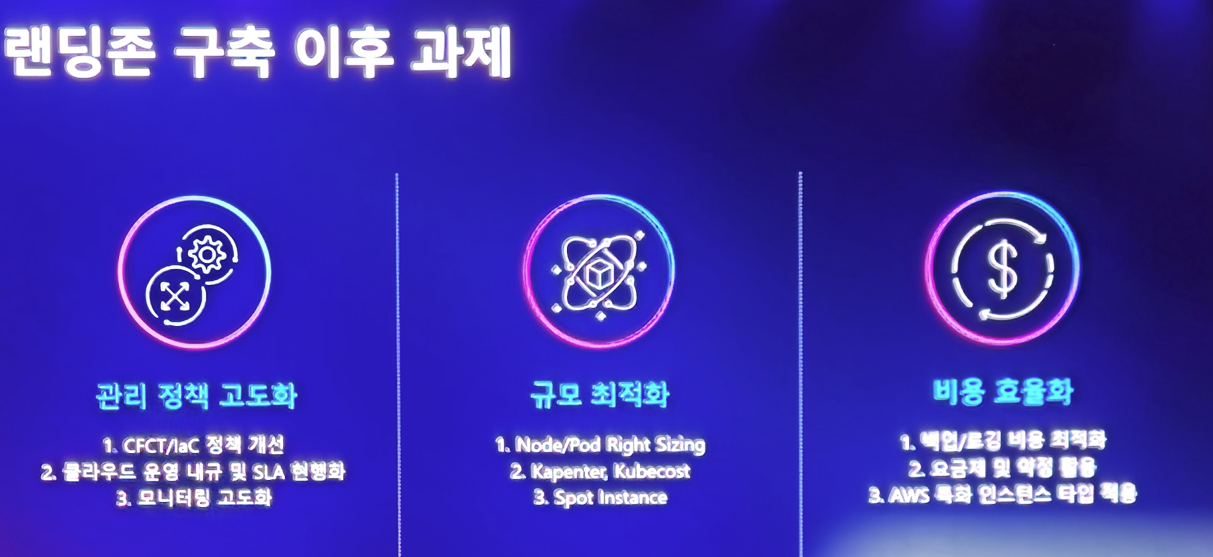

그럼에도 아직 해야할 과제가 많지만.. 이 또한 AWS와 함께 극복할거라 하네요

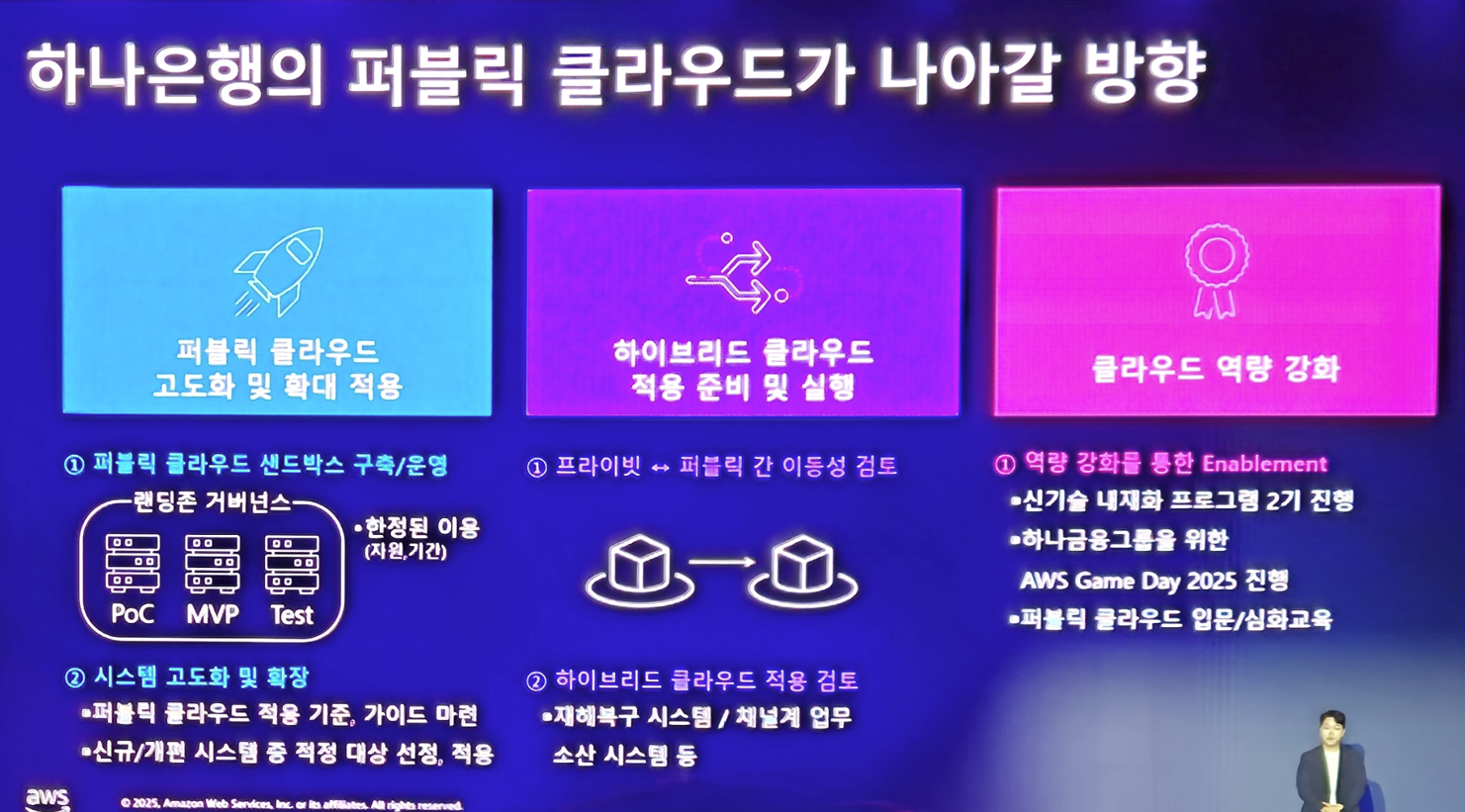

모든것을 퍼블릭 클라우드에 다 이룰 수 없기 때문에 (금융업 특성상) 하이브리드 클라우드 도입을 위해 준비중이라고 합니다.

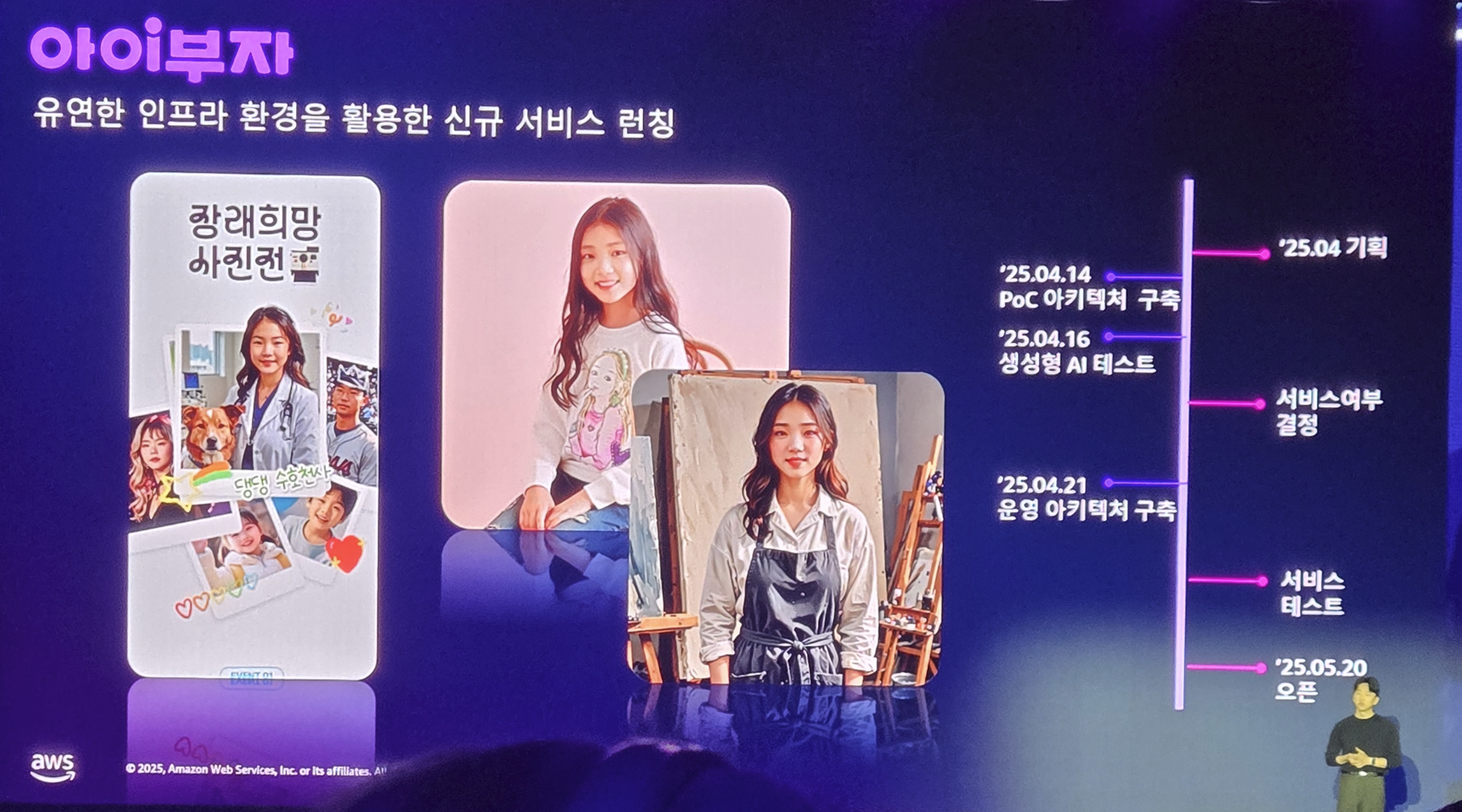

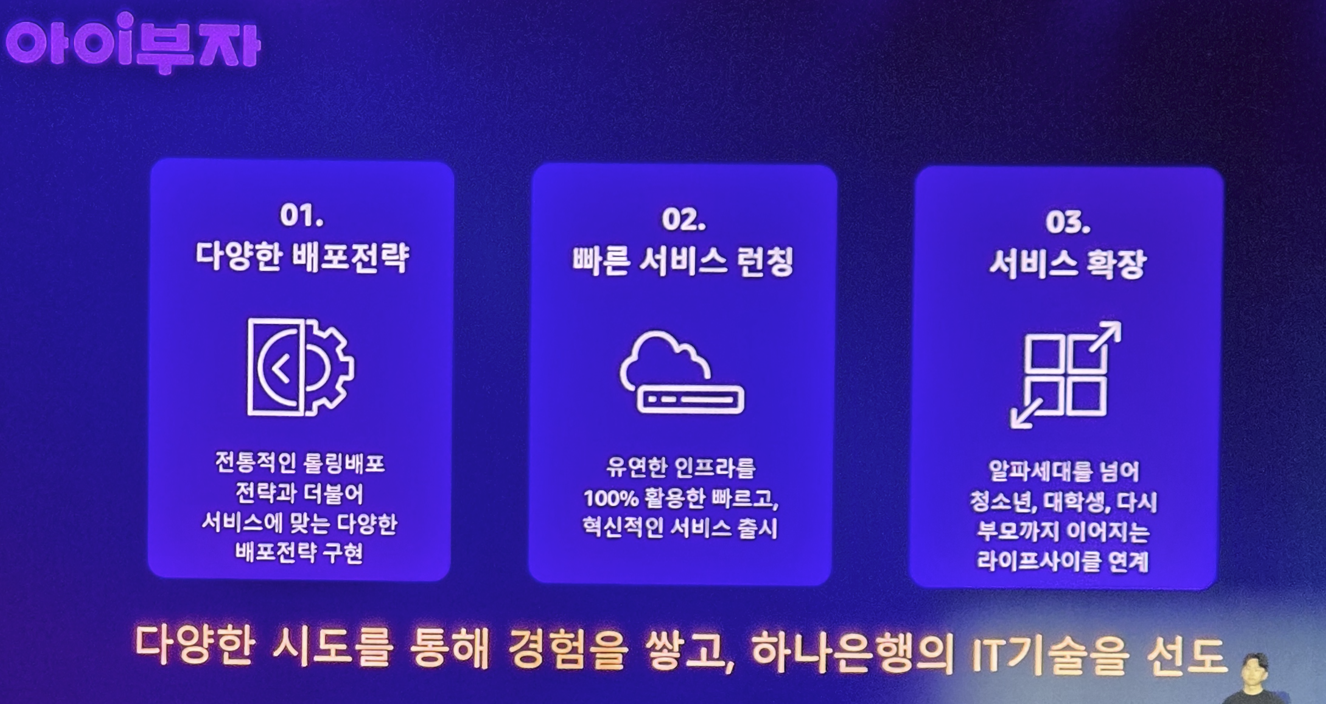

그리고 발표자가 바뀌면서 이러한 인프라 위에서 어떻게 빠르게 서비스를 만들었는지 소개를 하는데 그 서비스는 "아이부자" 라는 서비스입니다. 아이부자 서비스는 1월에 프로젝트를 시작해서 3개월간의 개발을 진행한 후 2달간의 테스트와 1달간의 심사를 통해 서비스를 런칭하게 됩니다. 굉장히 빠른 흐름이죠?

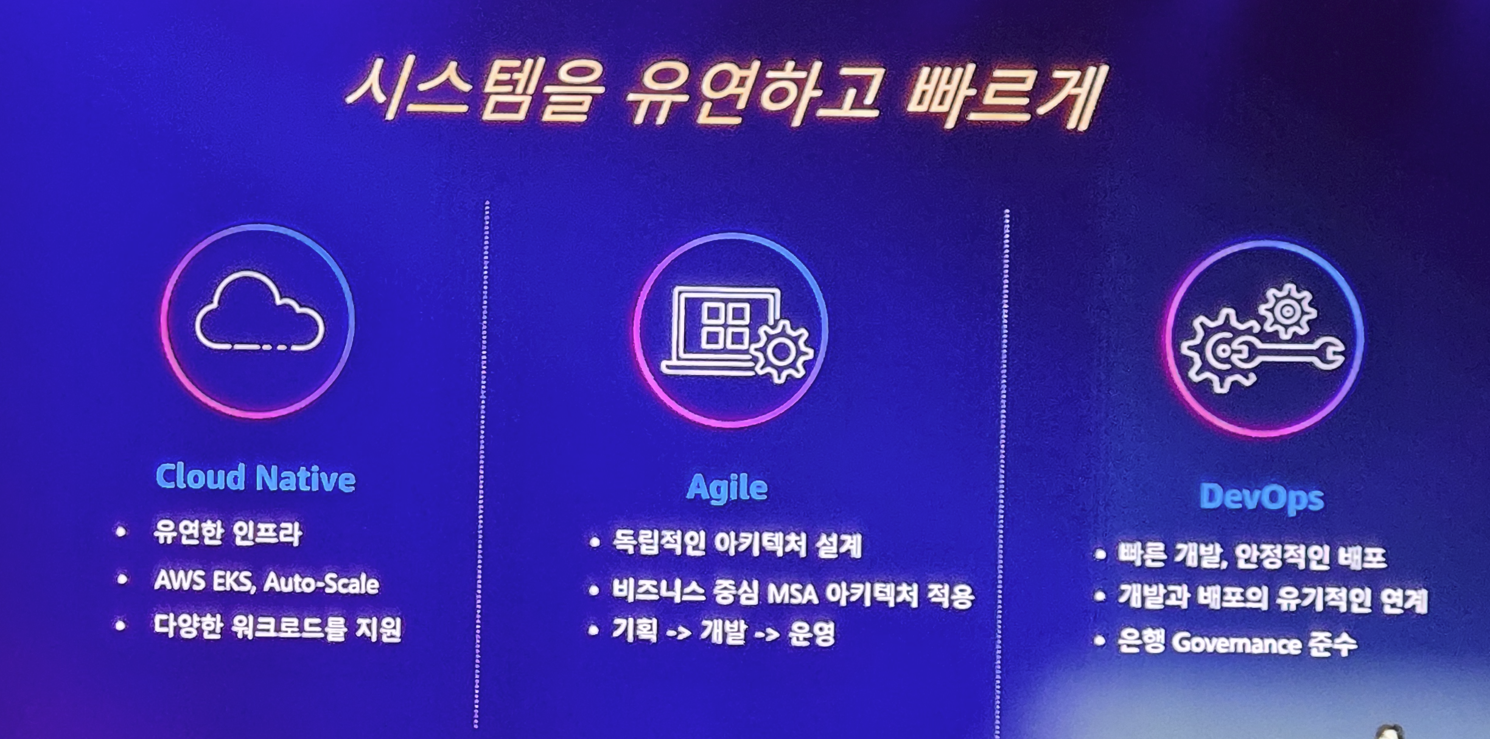

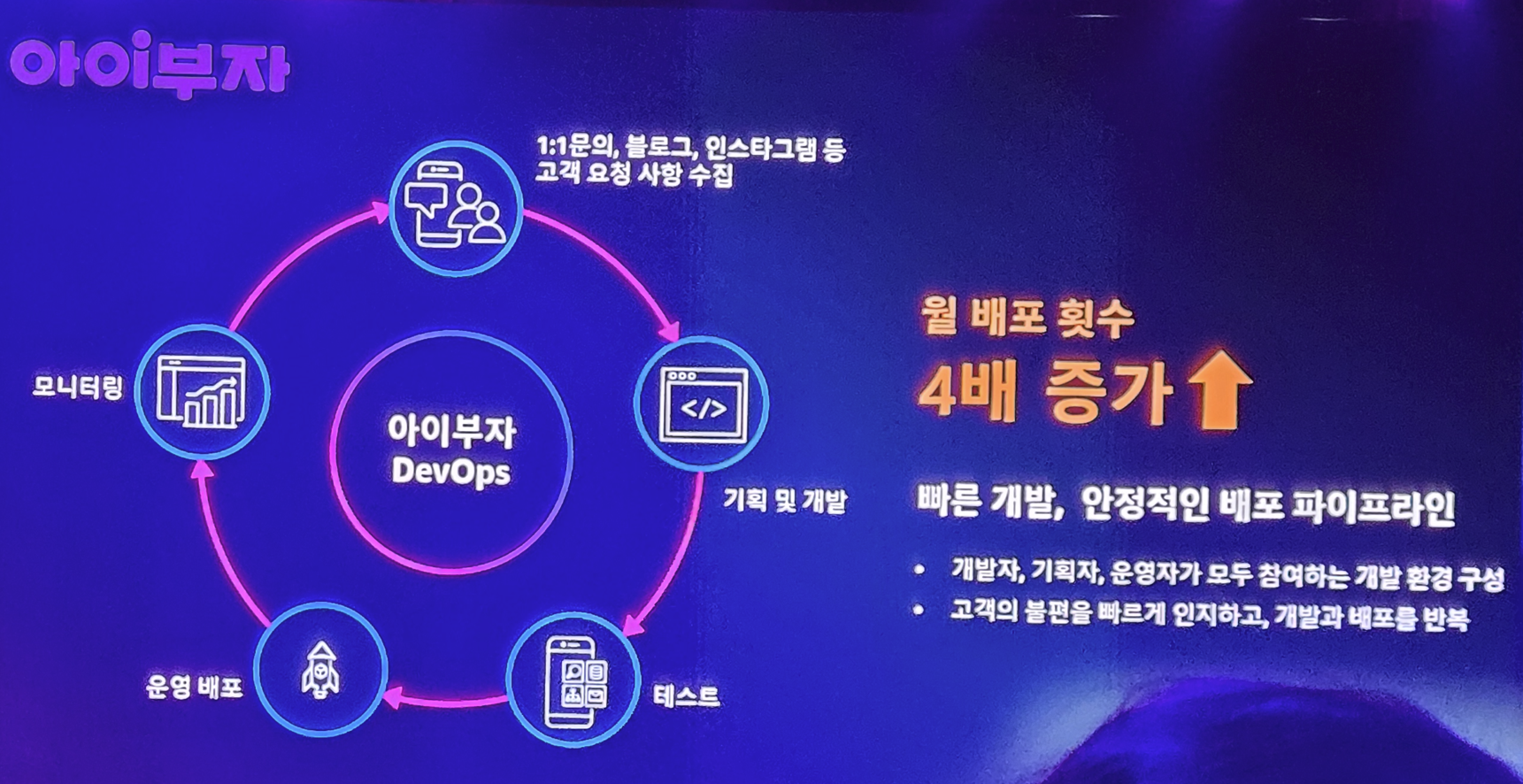

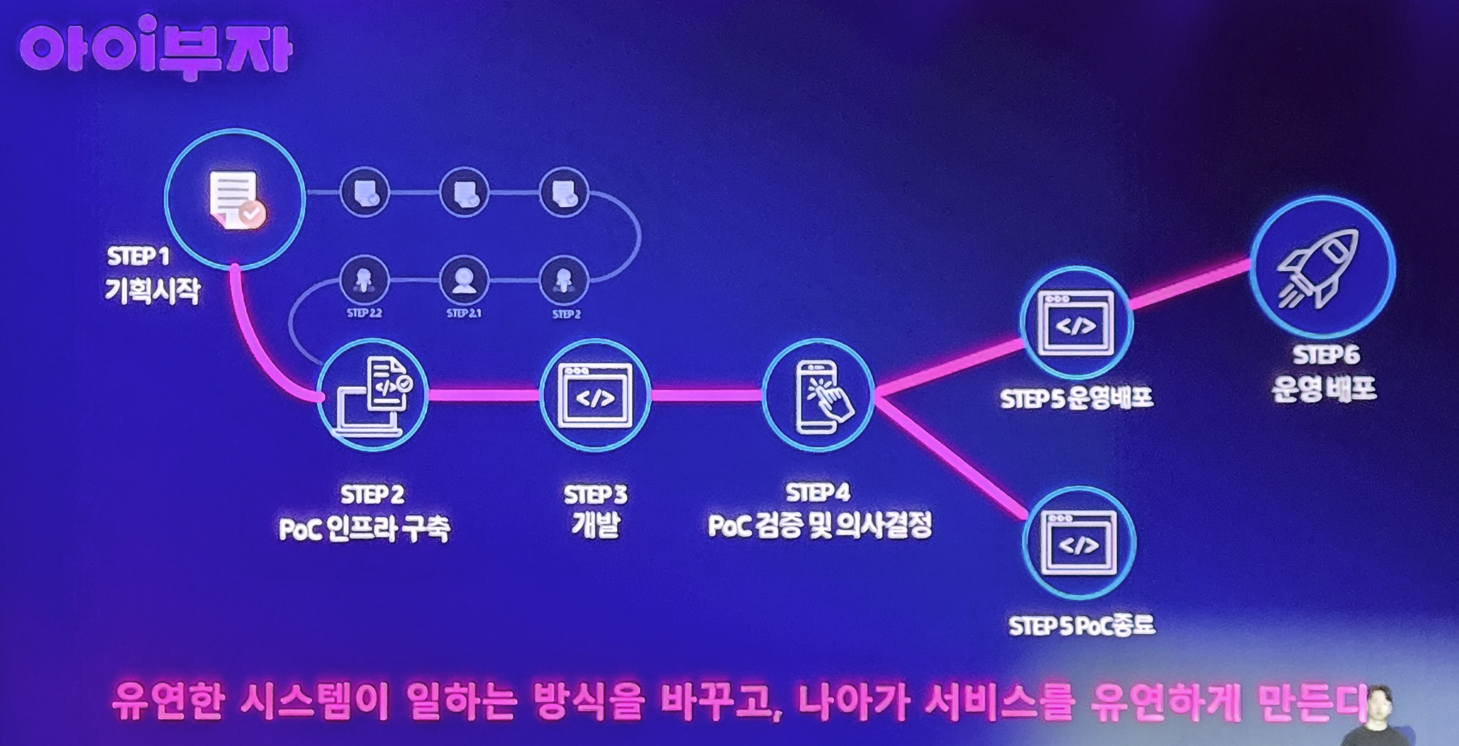

이렇게 가능할 수 있었던 이유는 AWS를 통한 Cloud Native 인프라로 다양한 워크로드를 손쉽게 개발자들은 활용할 수 있었고, 비즈니스 중심의 MSA 아키텍처 도입으로 기획->개발->운영까지 아주 빠르게 진행될 수 있었으며, DevOps를 통하여 개발과 배포/운영이 유기적으로 진행되어 (깐깐한 은행업의 거버넌스도 만족하면서) 빠르게 진도를 나아갈 수 있었다고 합니다.

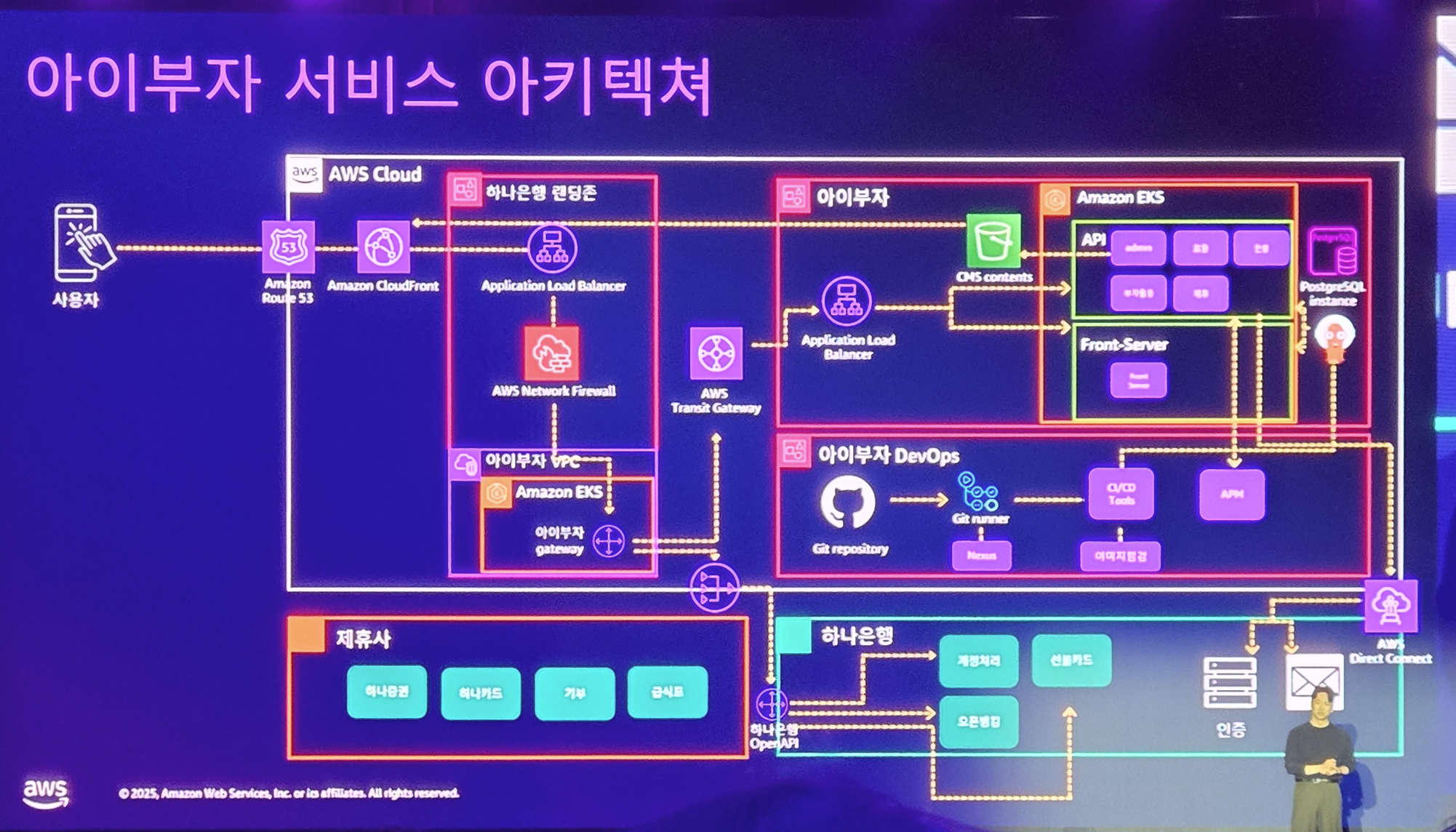

사용자를 위한 모바일 어플리케이션 개발은 단순히 앱만 만들면 되는게 아니라 그앱이 동작하게 하기 위한 백엔드 서비스들이 필요합니다.

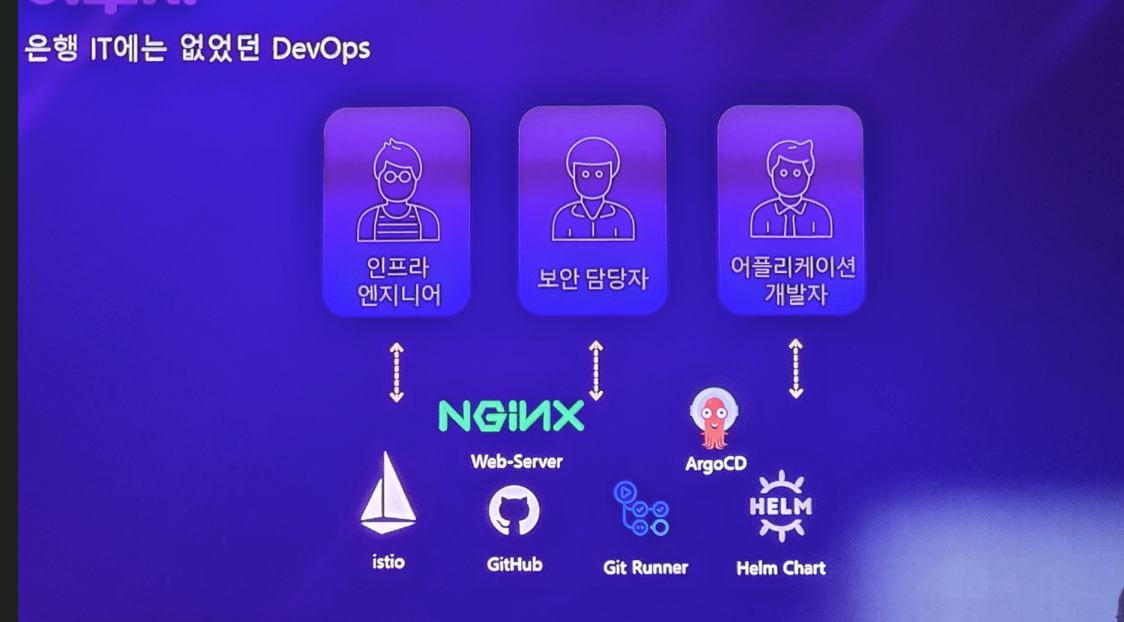

하나은행의 DevOps 생태계는 백엔드 서비스들은 Kubernetes 로 운영되며, GitHub Actions와 ArgoCD로 서비스가 배포됩니다. 그리고 이러한 서비스들을 위한 네트워크 관리는 모두 AWS의 네트워크 서비스를 통해 이루어지며, AWS의 모니터링 도구를 통해 운영을 효율적으로 할 수 있게 됩니다.

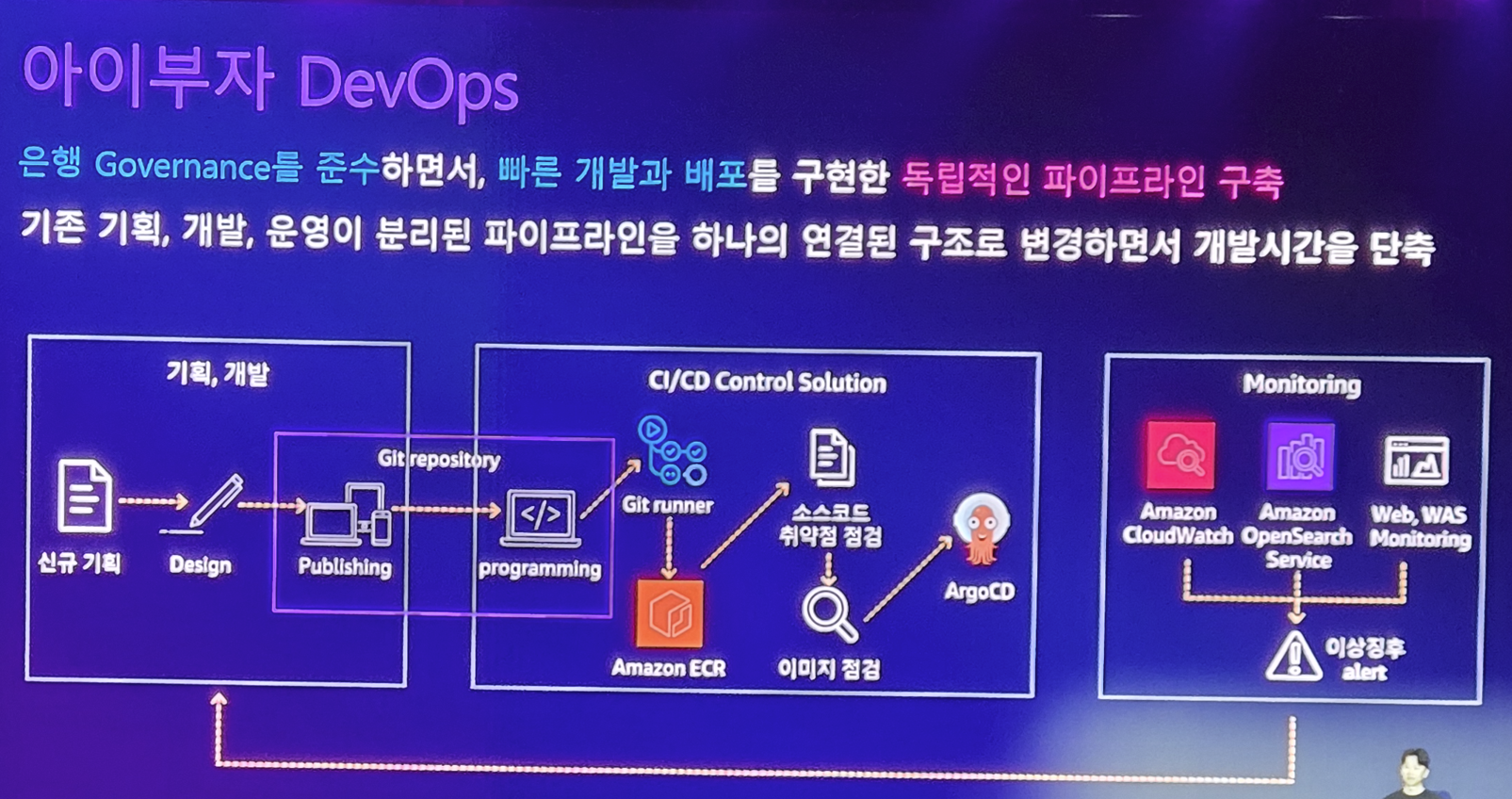

은행 Governance를 준수한다는건 굉장히 빡빡하고 엄격한 보안을 필요로 합니다. 이러한 과정을 개발자가 직접 하나하나 하다보면 너무 많은 시간이 걸리게 되며.. 결국 단시간 내 개발을 할 수 없게 되겠죠? 이러한 과정은 GitHub Actions 중심의 CI/CD 파이프라인을 통해 자동화되어 개발자의 시간을 크게 단축 시킬 수 있게 됩니다. 또한 기획, 개발, 운영이 따로 놀던 파이프라인이 하나의 연결된 구조로 통합이 되어 기획팀/개발팀/운영팀이 한몸처럼 일을 할 수 있게 되었습니다.

운영팀 입장에서는 고객의 VOC 및 서비스 모니터링에서 나오는 현장 이슈에 대해서.. 빠르게 개발팀에게 피드백을 주고, 그게 바로바로 개발이 되어 반영이 되다보니.. 기존의 전통적인 배포보다 4배는 빠른 속도로 서비스가 배포되어 서비스의 완성도가 올라가게 됩니다.

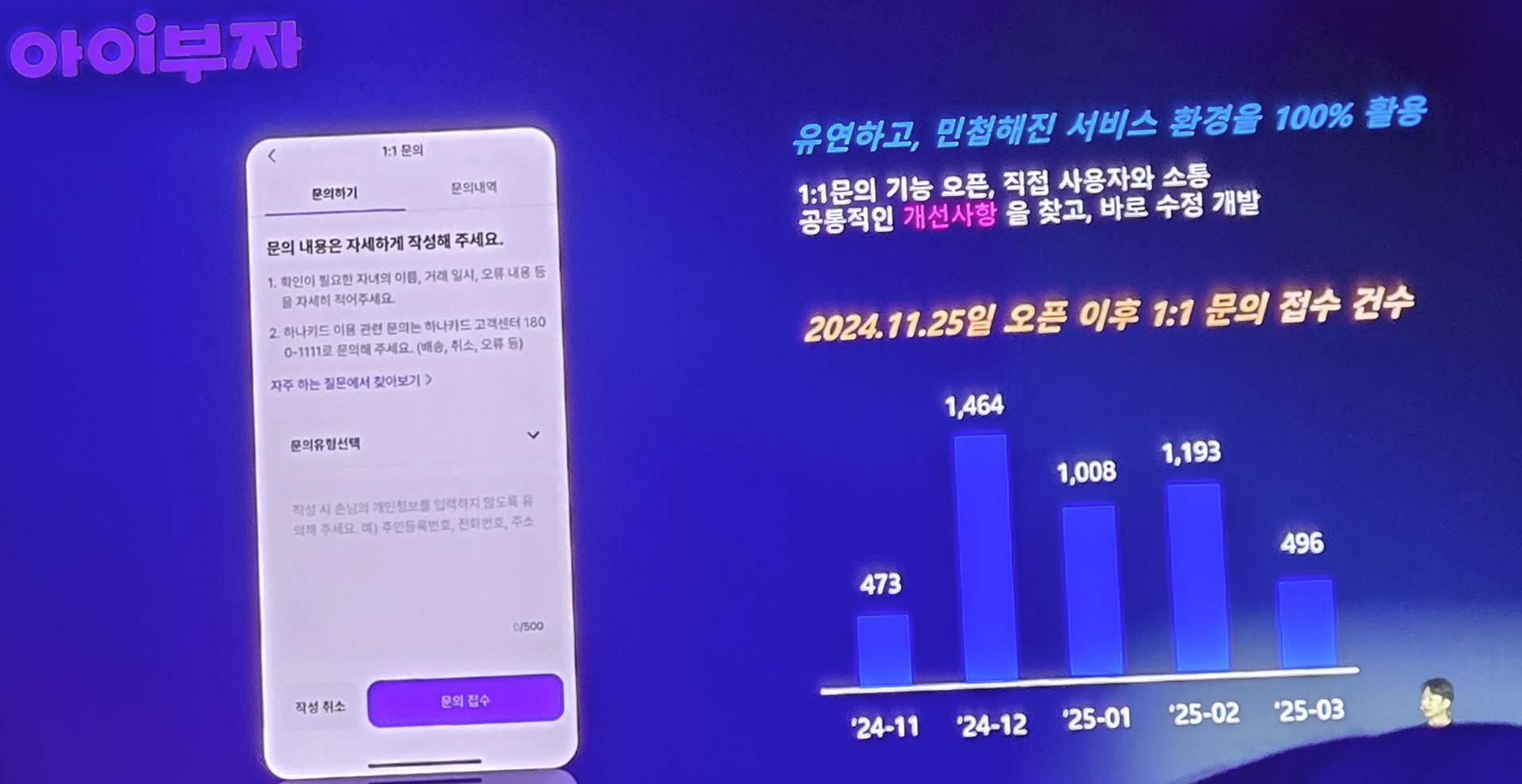

이렇게 완성도 있는 빠르고 반복적인 개발/배포는 결과적으로 운영팀의 고통을 덜어주게 되는것이죠

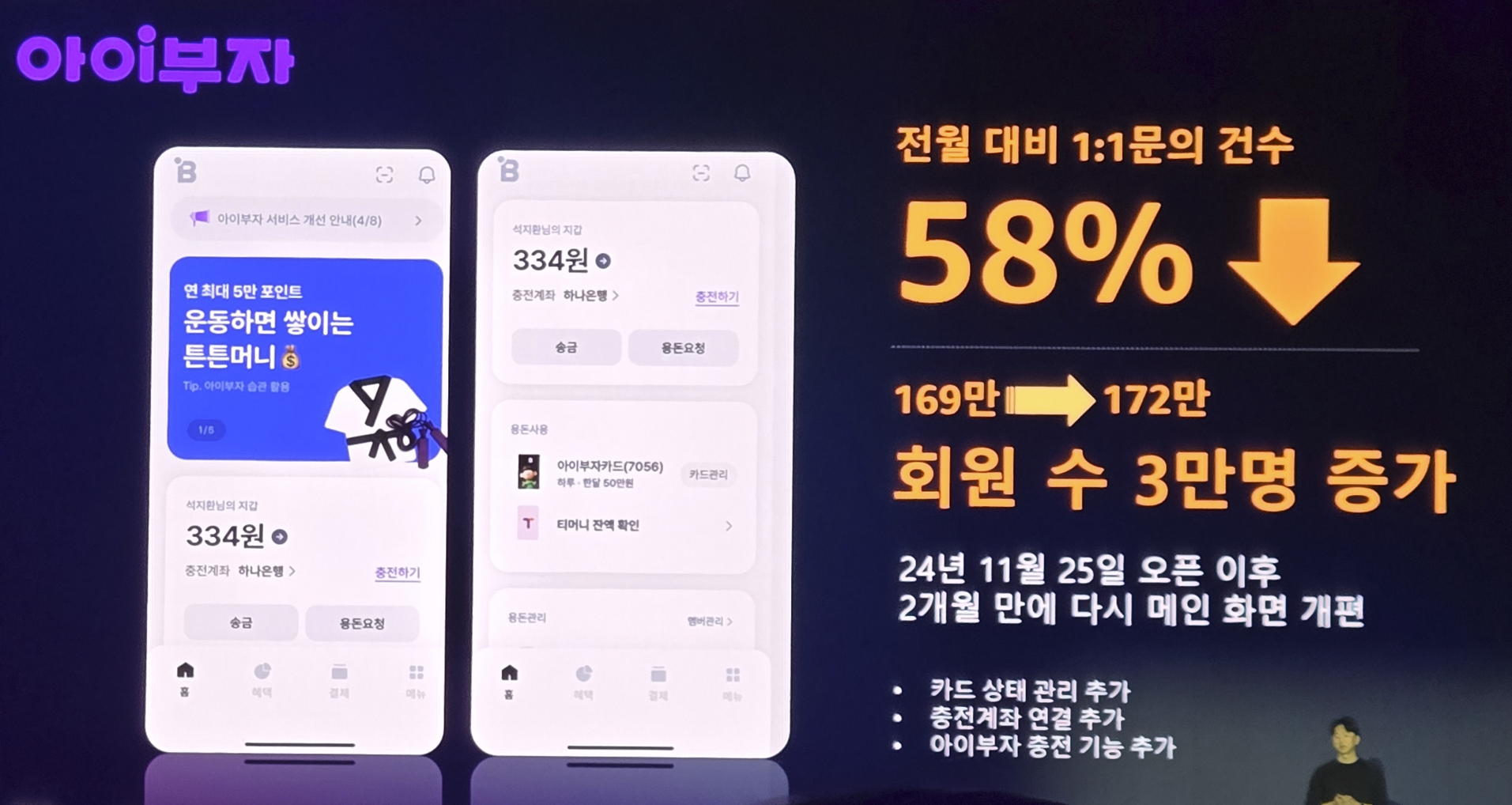

이는 단순히 운영팀만 좋은게 아니라 고객 입장에서도 완성도 있는 서비스, 빠르게 확장되는 서비스를 만나게 되기 때문에... 결과적으로 회원수 증가라는 만족할만한 경영성과도 얻게 됩니다.

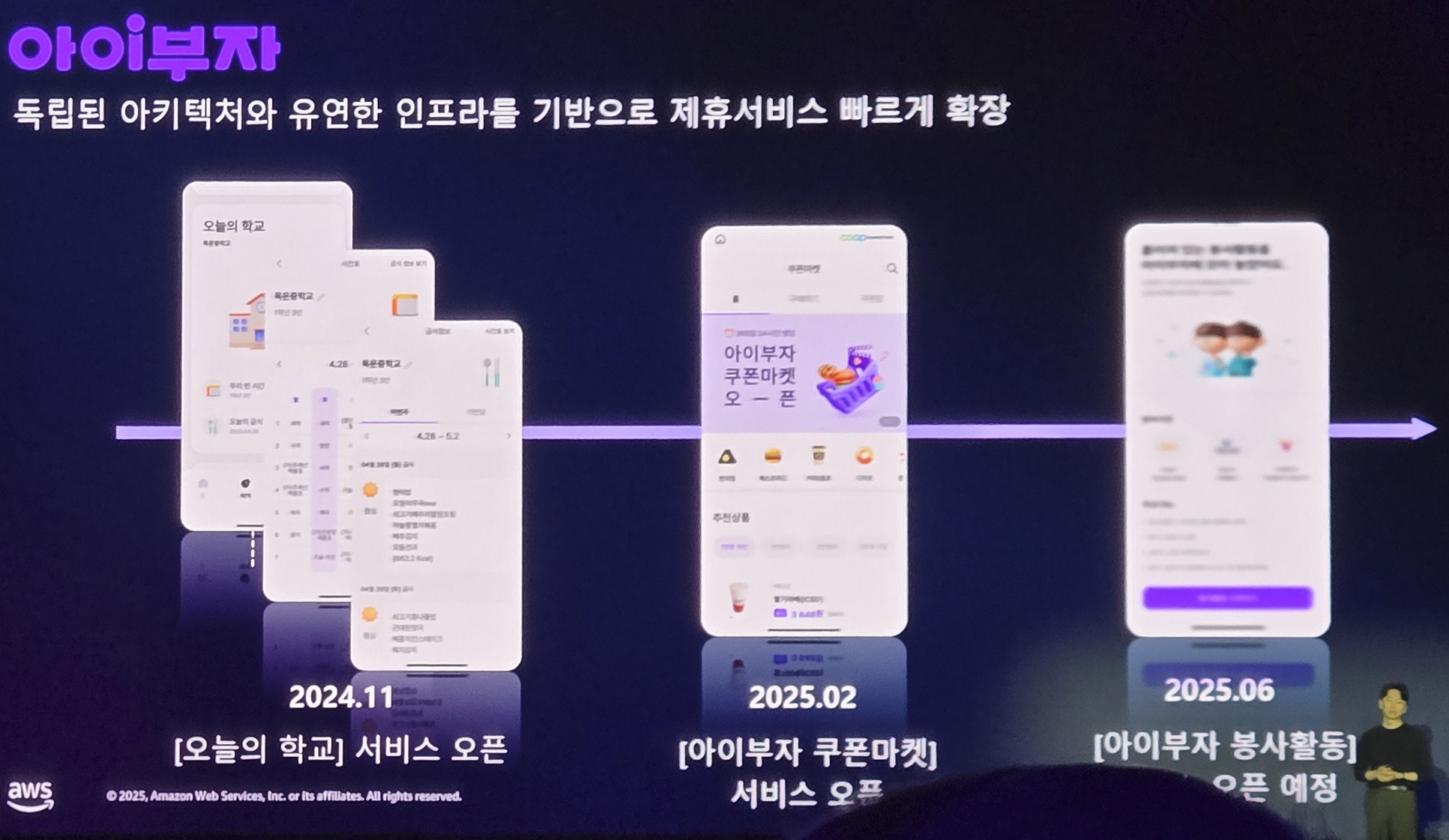

그리고 잘 만든 DevOps 인프라와 문화는.. 그 다음 서비스를 만드는데 굉장히 큰 가속을 붙여주게 되어 하나은행은 연계서비스를 3~4개월마다 만들게 됩니다.

또한 탄탄한 인프라를 바탕으로 요즘 시대의 화두인 ai 도입도 손쉽게 가능해지게 되었죠

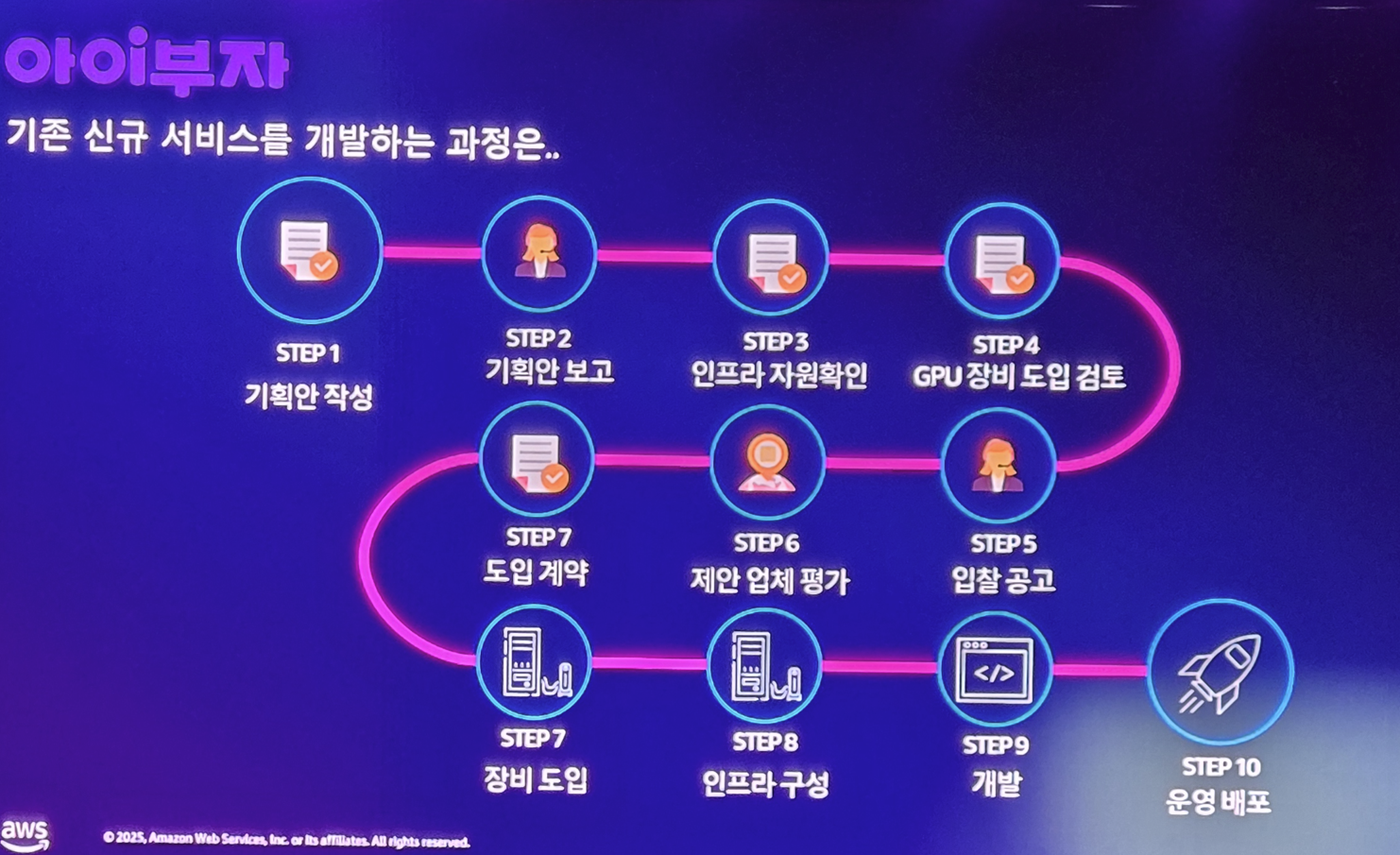

이게 얼마나 대단한거냐면.. 과거 하나의 서비스가 만들어지기까지 이 엄청난 과정이 필요 했고, 이렇게 겨우 만든 서비스도 추가 개선 및 배포하는데도 엄청난 오랜 시간이 걸렸습니다.

하지만 유연한 시스템과 문화는 결국 일하는 방식을 바꾸게 되었고, 서비스도 유연해져서 고객의 만족도를 크게 올릴 수 있게 되었습니다

사실 이건 당연한 이야기입니다. 금융업도 요즘 it 회사가 되가고 있는데.. DevOps를 안할래야 안할 수 없겠죠? 이들도 이제는 istio를 통한 서비스 메시를 활용하고, github actions, argo, helm 등을 활용하여 gitops 기반의 서비스를 배포합니다.

서비스 메시의 도입으로 다양한 배포 전략이 가능하며, 고속으로 서비스 확장을 하니.. 또한 이러한 반복적인 서비스개발/배포 경험은 그 다음 서비스를 만드는데 또 가속화될 수 있는 경험의 재료가 되니.. 하나은행의 서비스는 지금도 계속 발전하고 있다고 합니다.

생성형 AI 시대의 클라우드 혁신: 삼성전자와 에이블리의 FinOps에서 Agentic AI까지

다음 주제는 삼성전자의 FinOps 와 에이블리의 ML 거버넌스 플랫폼에 대한 소개입니다. 둘다 비용 효율화 주제를 가져온 만큼... 그래서 묶어서 발표를 하게 된것 같습니다.

먼저 AWS 관계자가 발표를 합니다.

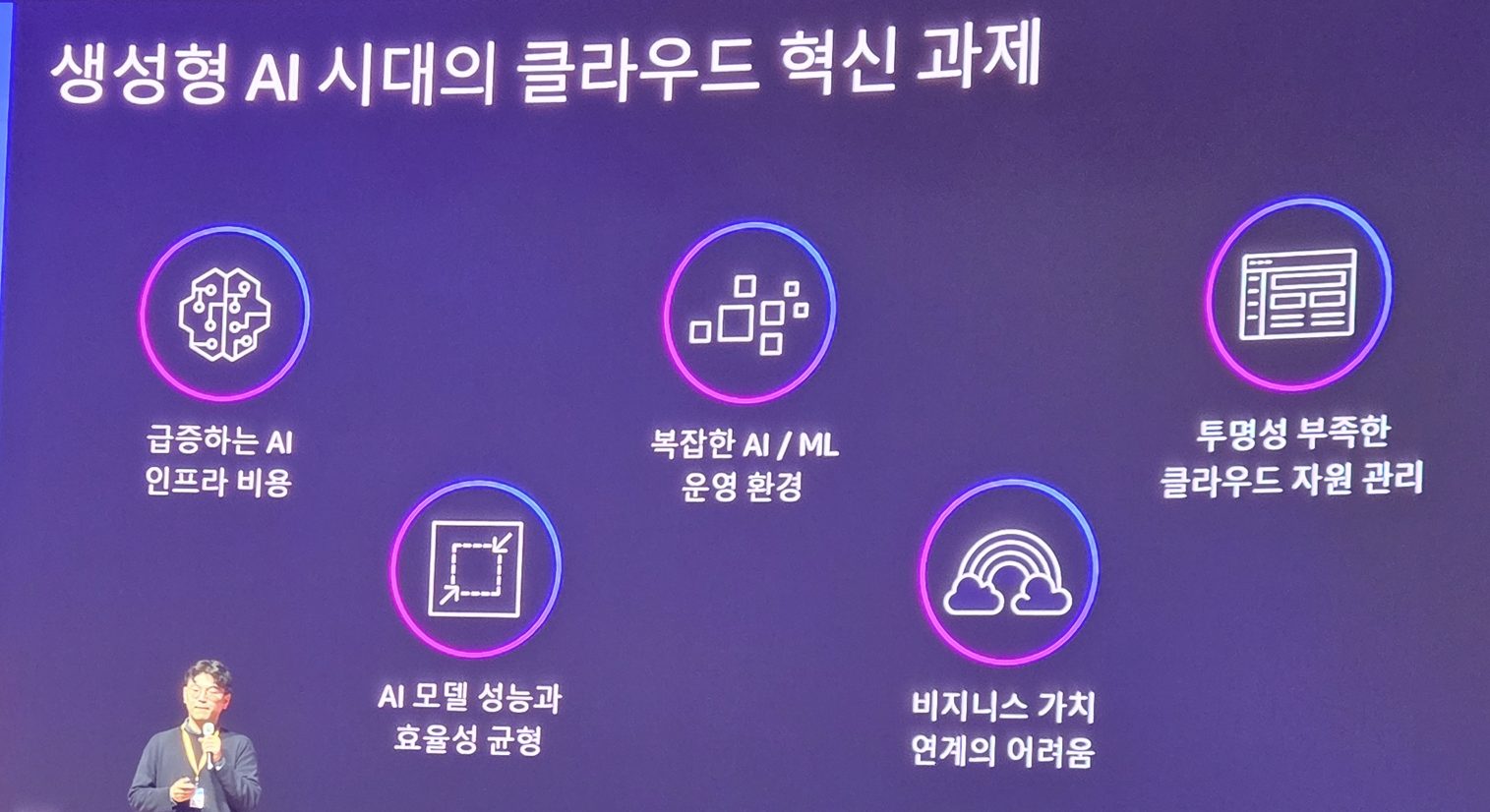

생성형 AI 시대에서 클라우드 혁신은 매우 중요한 문제입니다. AI Agent 까지 도래하면서 AI 비용은 급증하는데.. 클라우드는 이 수요를 감당하면서 쓰기에는 너무 비싸거든요.

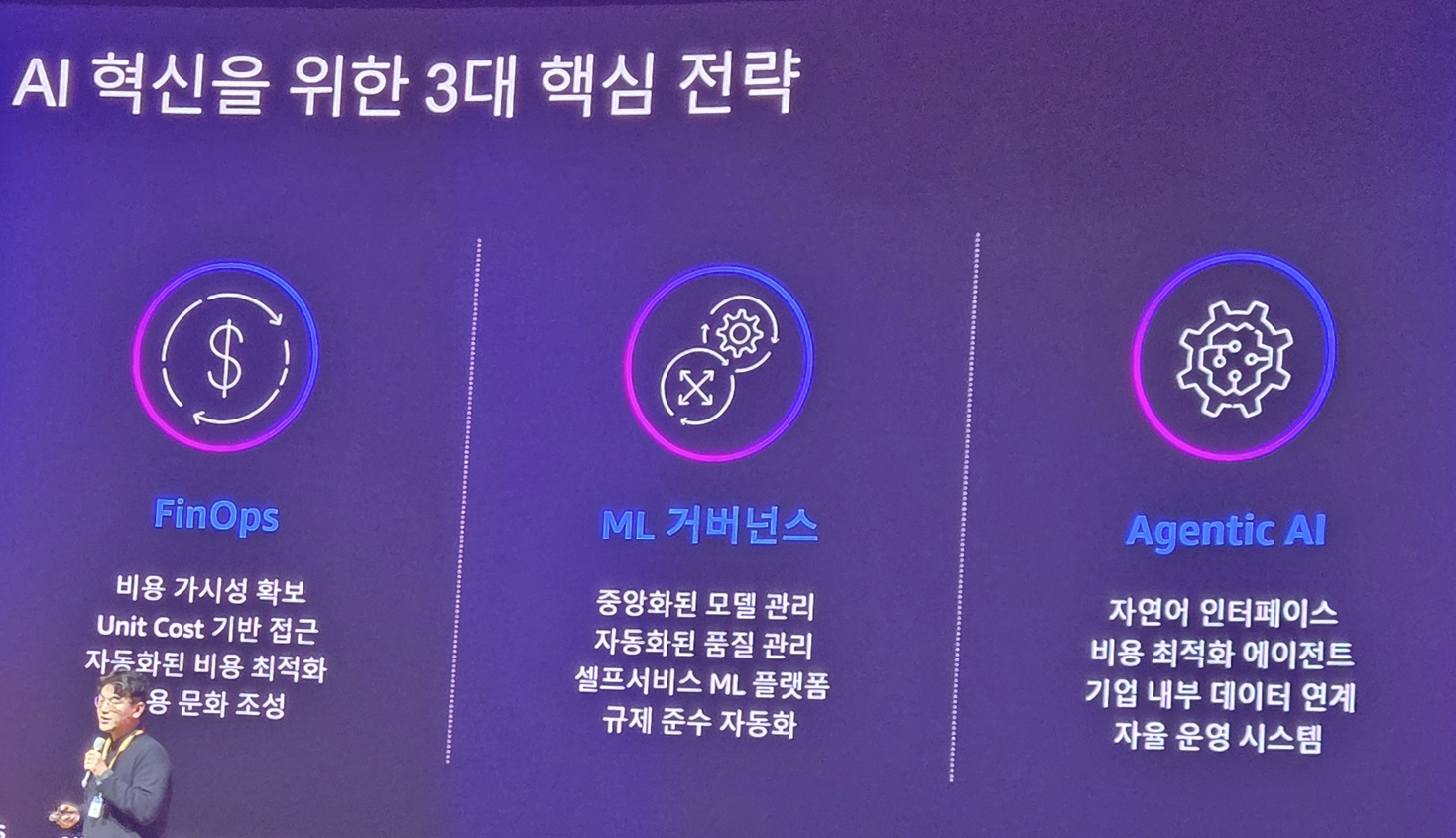

그래서 올해부터는 AI 만큼 중요한게 FinOps입니다.

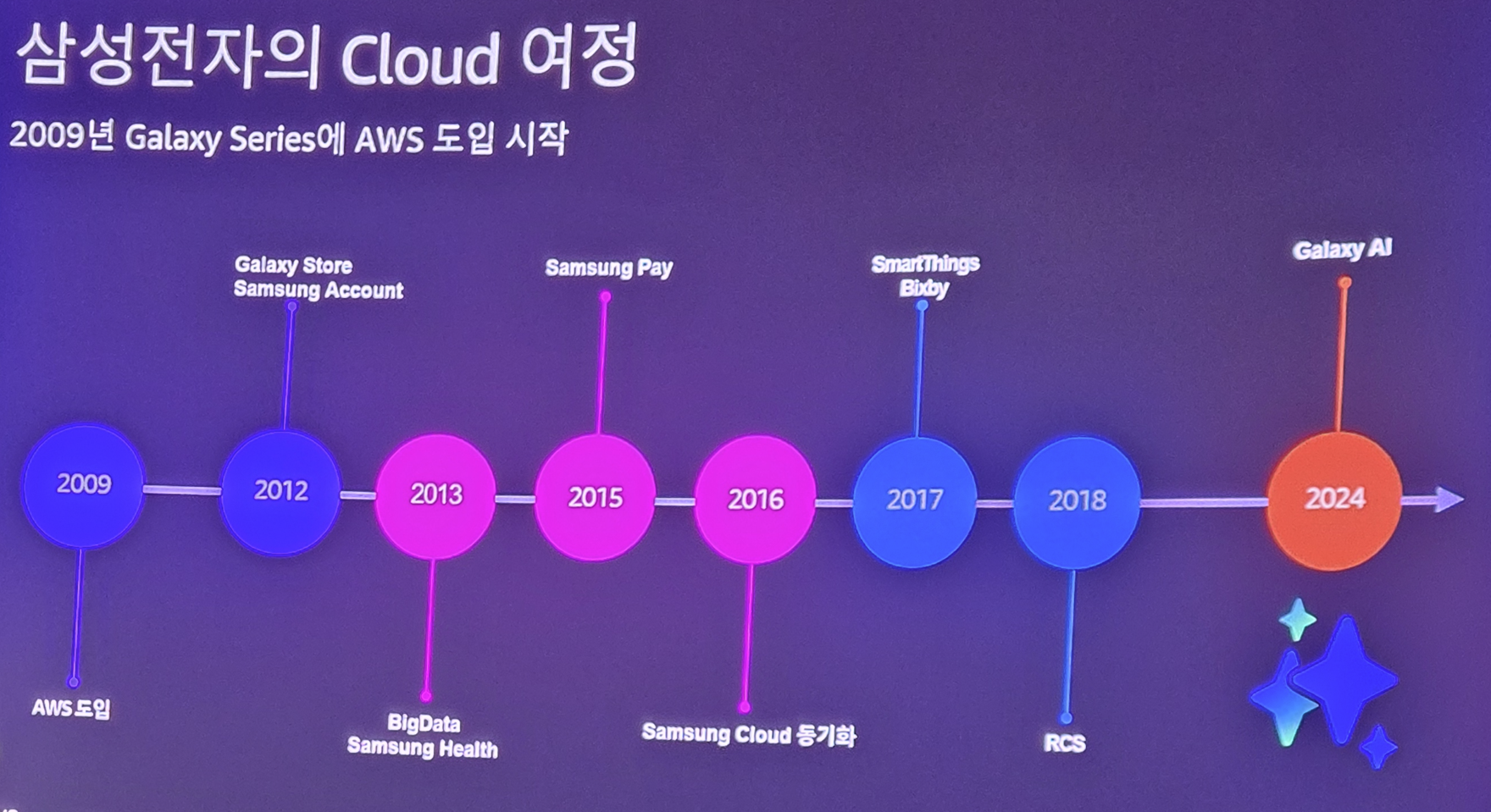

삼성전자는 클라우드를 2009년에 도입하고 스마트폰 서비스에 적극 사용하고 있었는데 이 클라우드 사용 비용은 2024년에 AI가 도입되면서 폭증하게 됩니다.

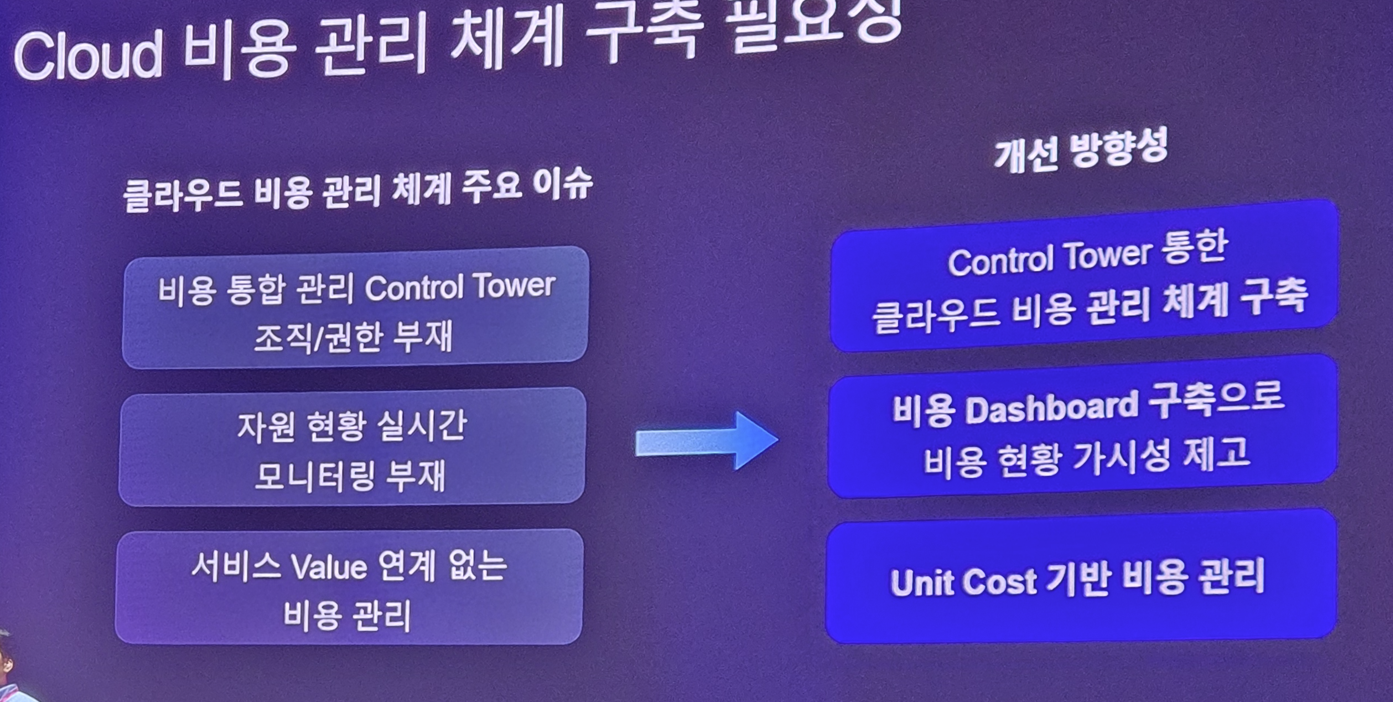

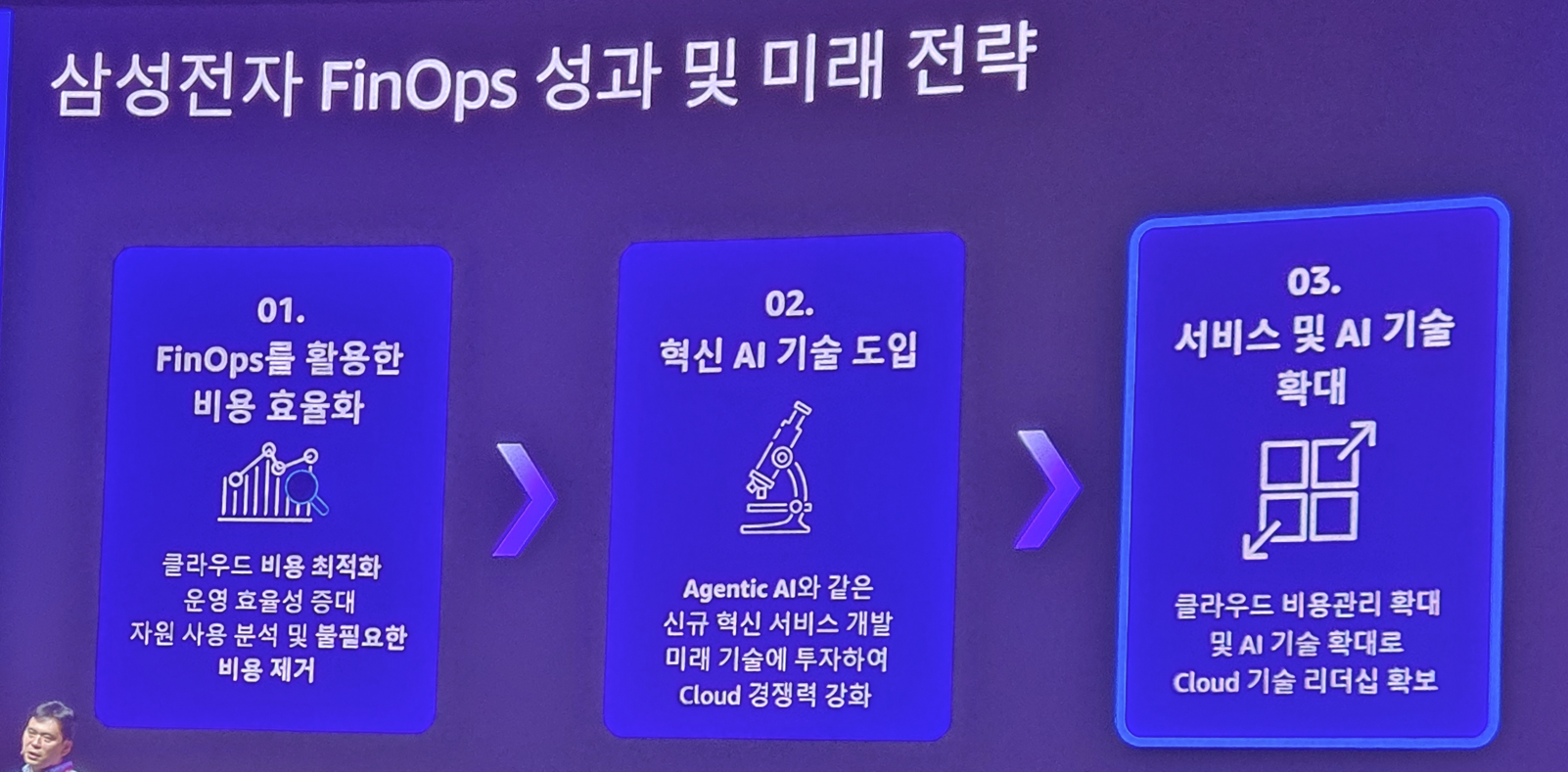

그래서 어떻게 이것을 효율화할 수 있을까? 라는건 큰 화두가 되었죠. 그래서 삼성전자는 FinOps에 대한 계획을 세웁니다.

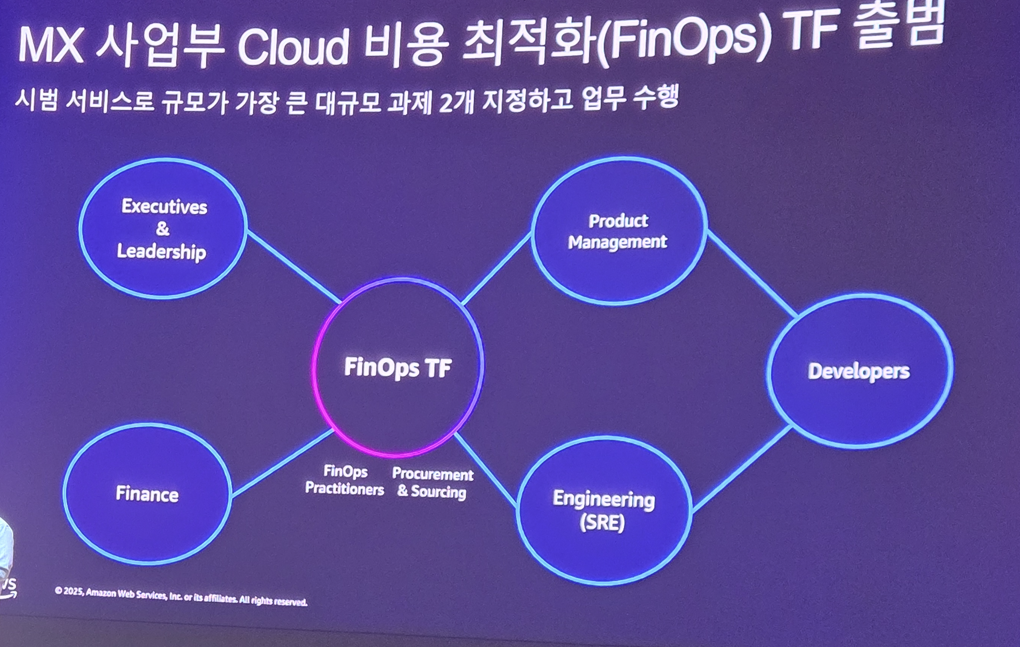

먼저 시범 서비스를 적용할 서비스 2개를 선정하고 이를 진행하기 위한 TF를 출범합니다. 여기에는 경영진과 재무팀/지원팀, SRE팀, 제품팀, 개발팀이 모두 포함되었죠

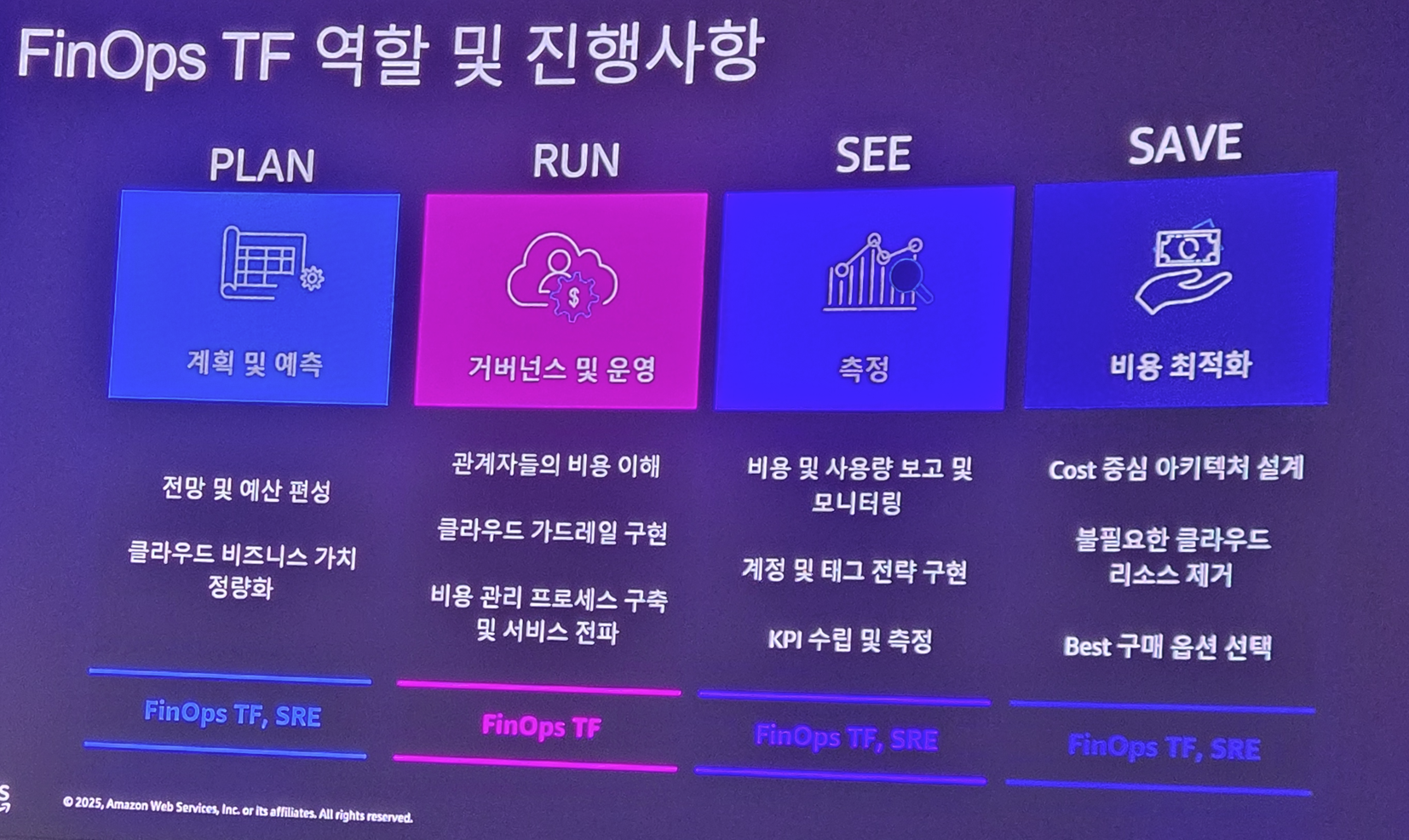

FinOps TF는 각 팀마다 역할을 분배하여 비용 관리 프로세스를 계획하고 실행하며, 결과를 지속 모니터링 하여 비용 효율화를 달성하게 됩니다.

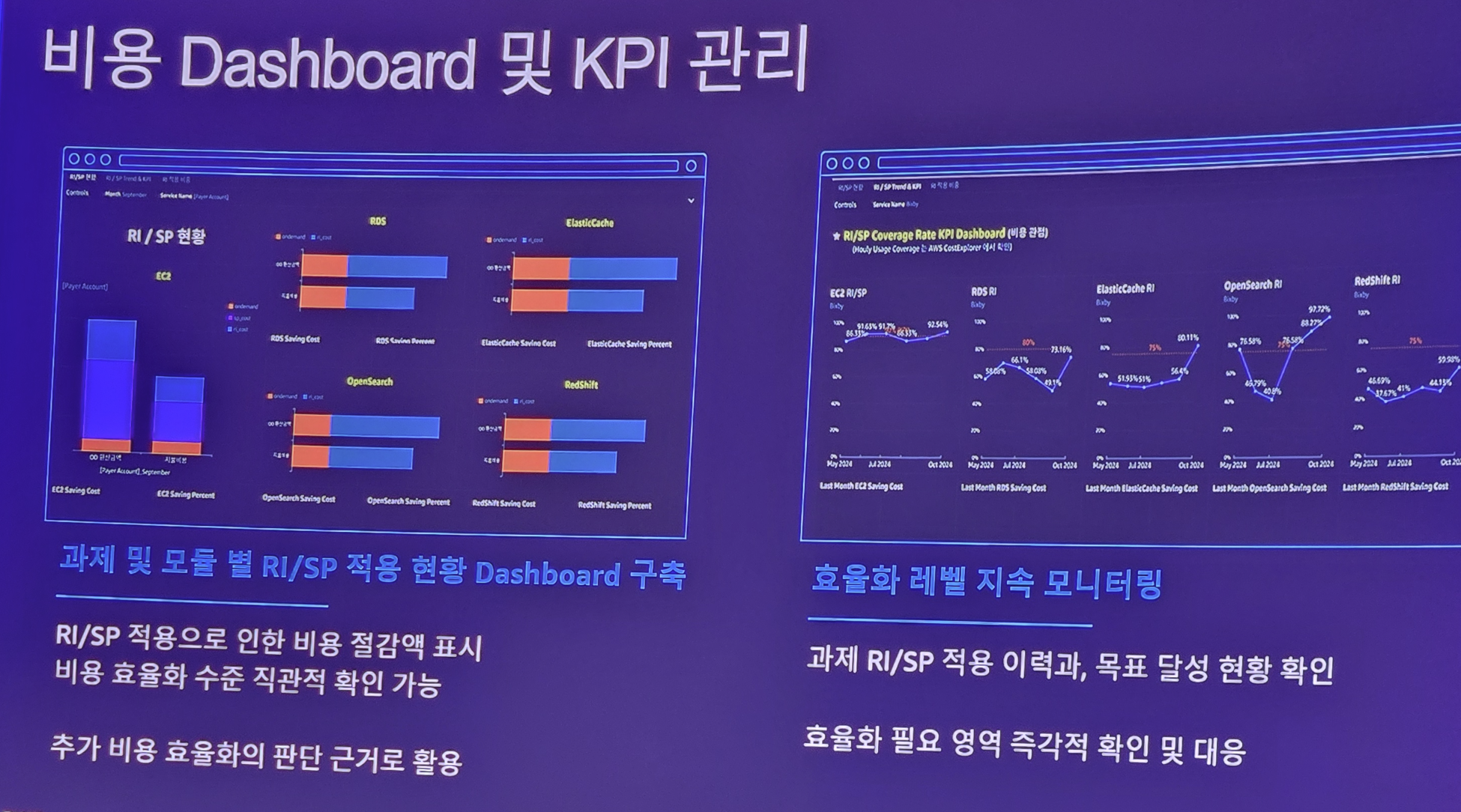

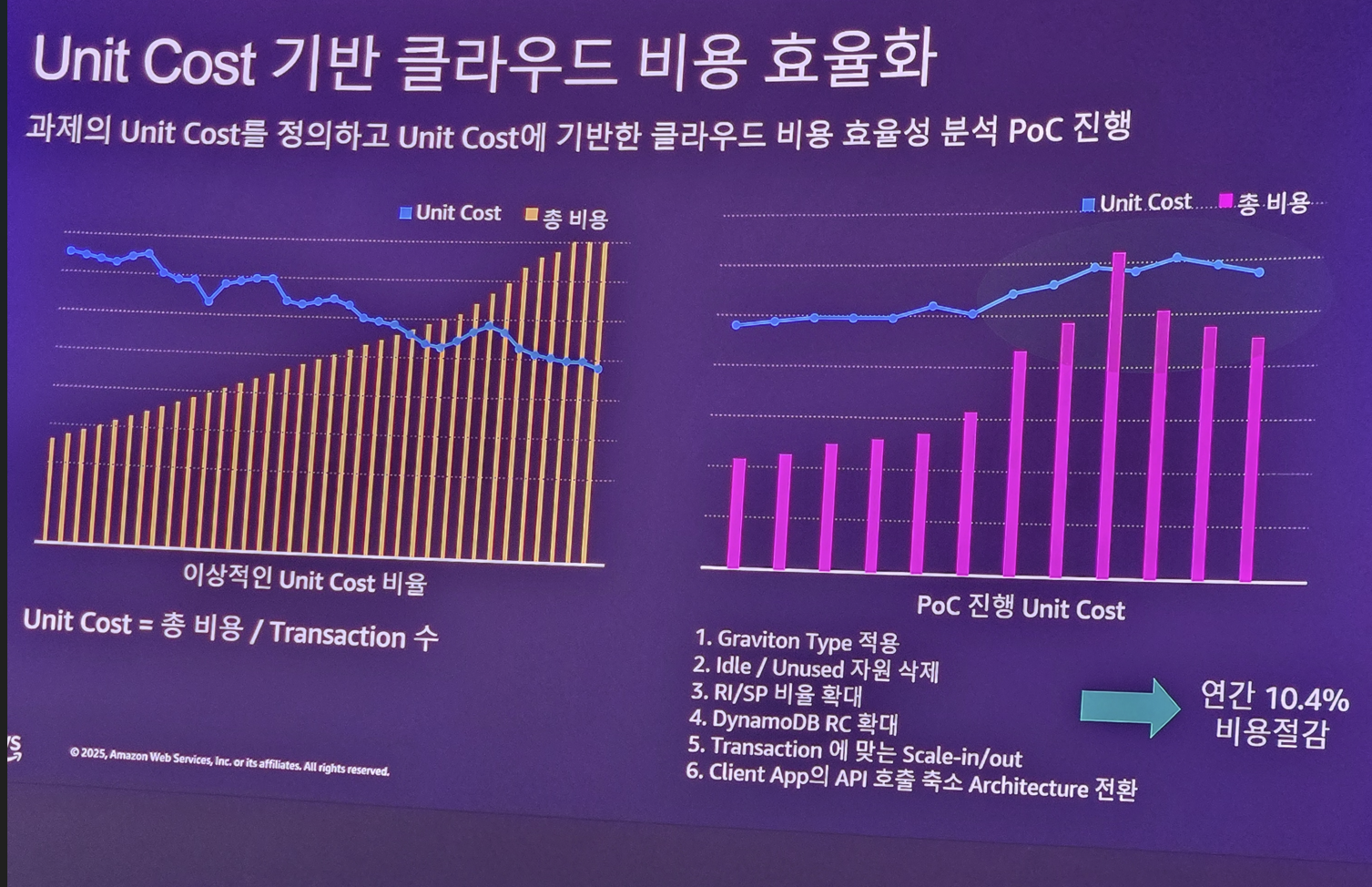

어떤 Workload를 쓰는게 더 비용을 아낄 수 있을지, 저활용 자원은 무엇인지, 어떤게 과도하게 비용을 유발하는지를 모니터링 대시보드를 구축하여 지속적으로 관찰하고 KPI로 관리를 하게 됩니다.

이러한 분석을 통해 결과적으로 연간 10%의 비용 절감을 달성할 수 있게 됩니다.

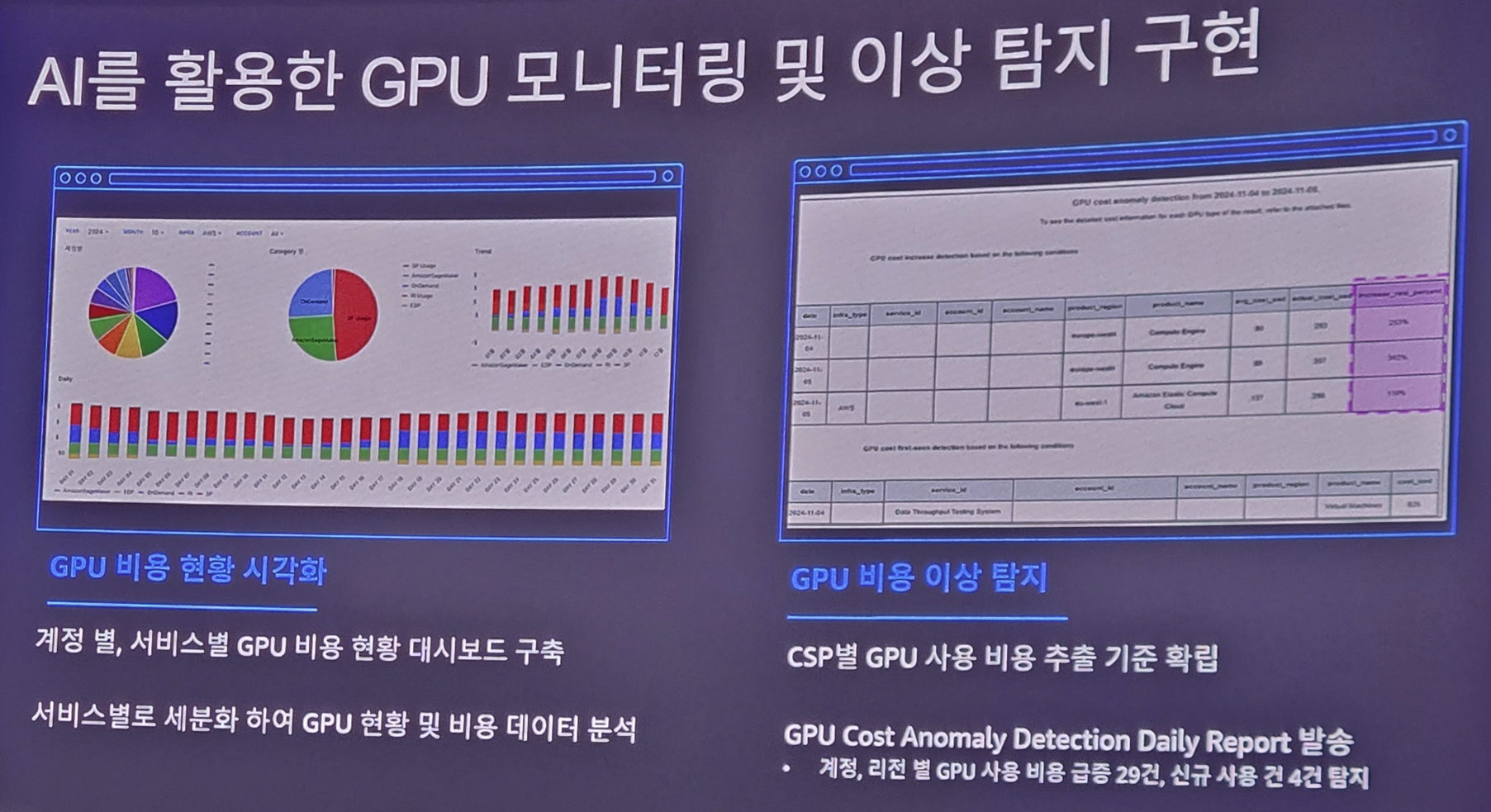

이러한 성과에 힘입어.. AI 시대가 되면서 GPU 사용이 크게 증가하게 되는데, 이러한 GPU 리소스에 대한 FinOps도 도입을 하게 됩니다.

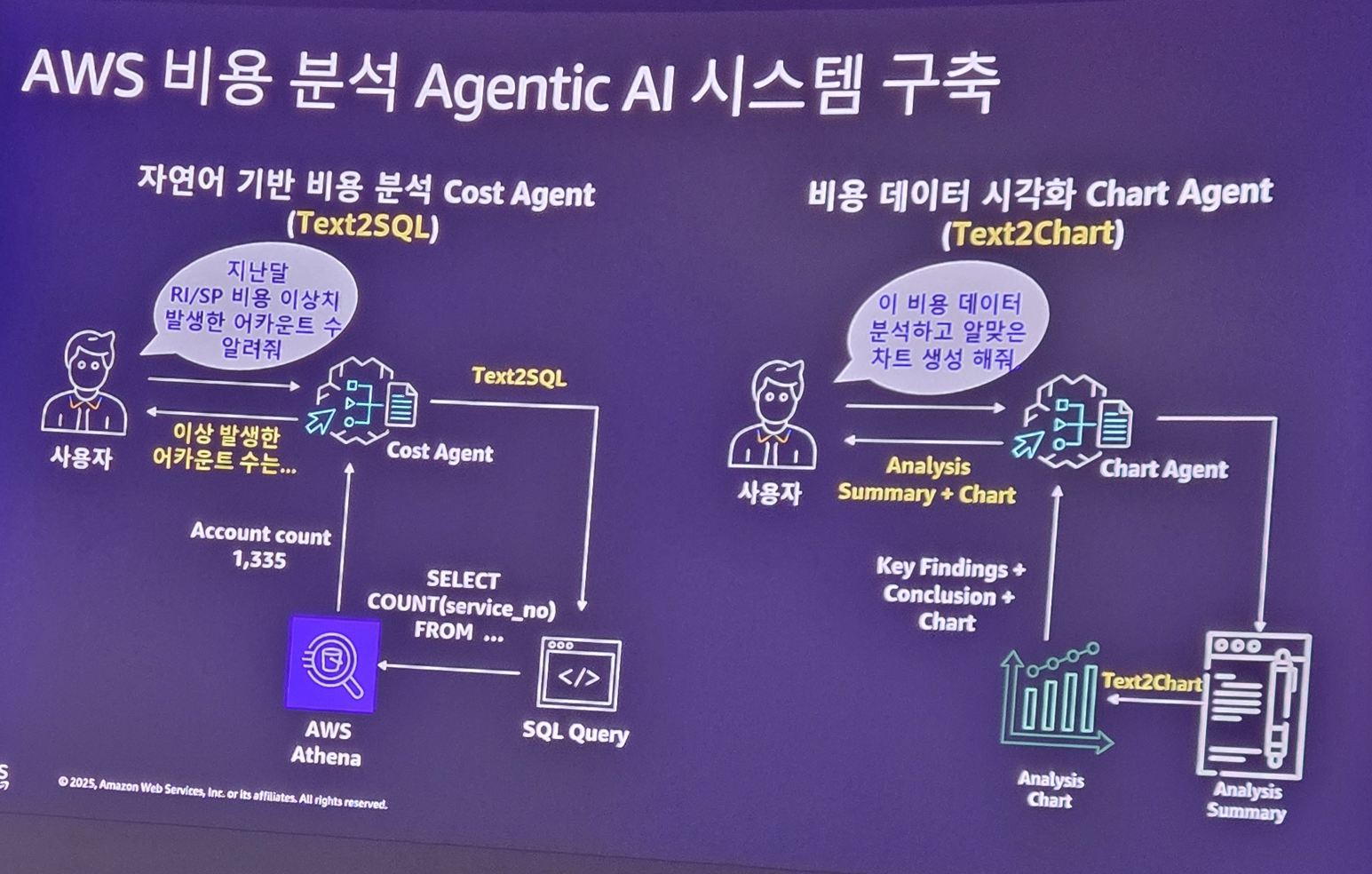

또한 FinOps를 좀 더 효율적으로 하기 위해 Agent와 Chat을 도입하게 됩니다.

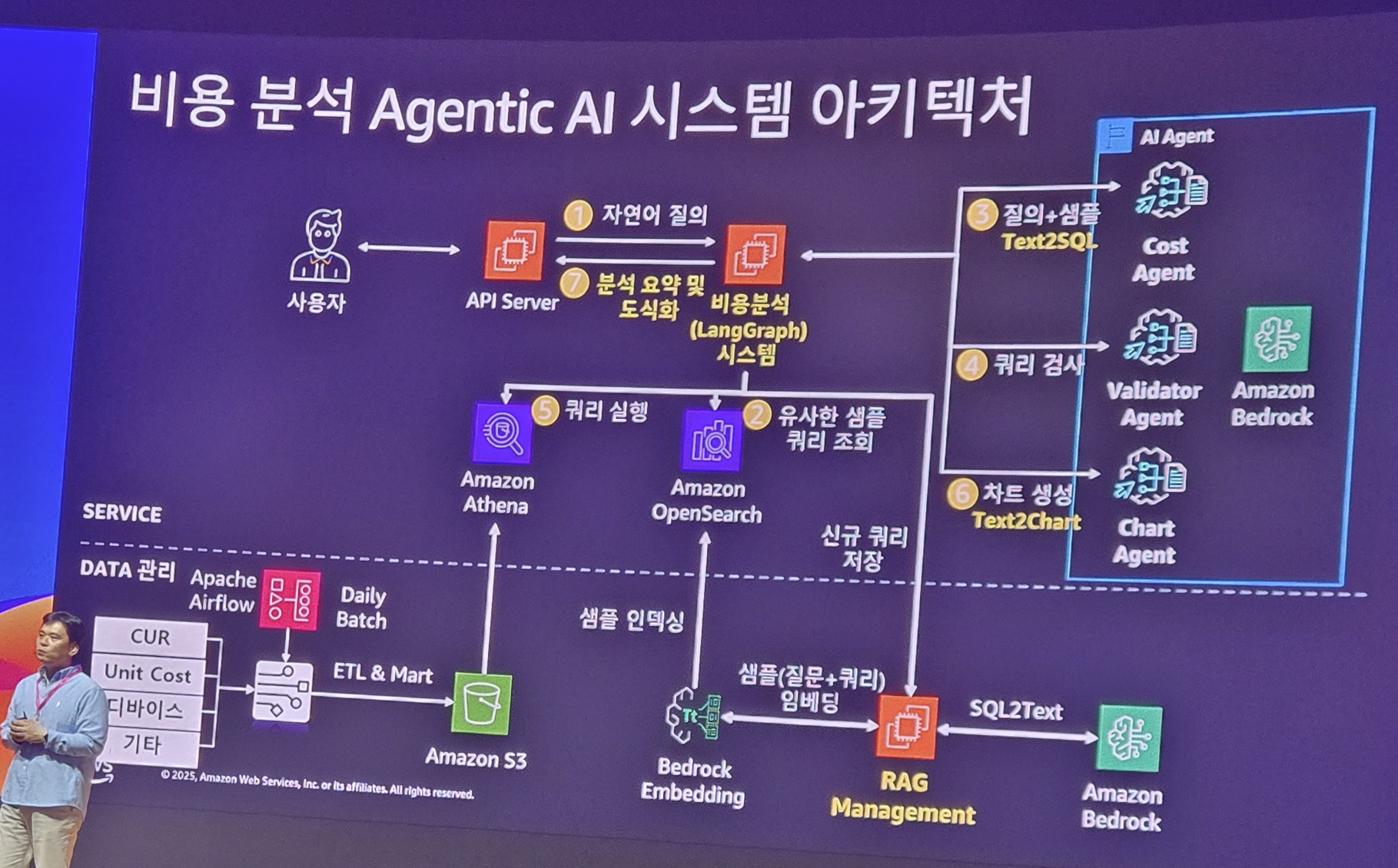

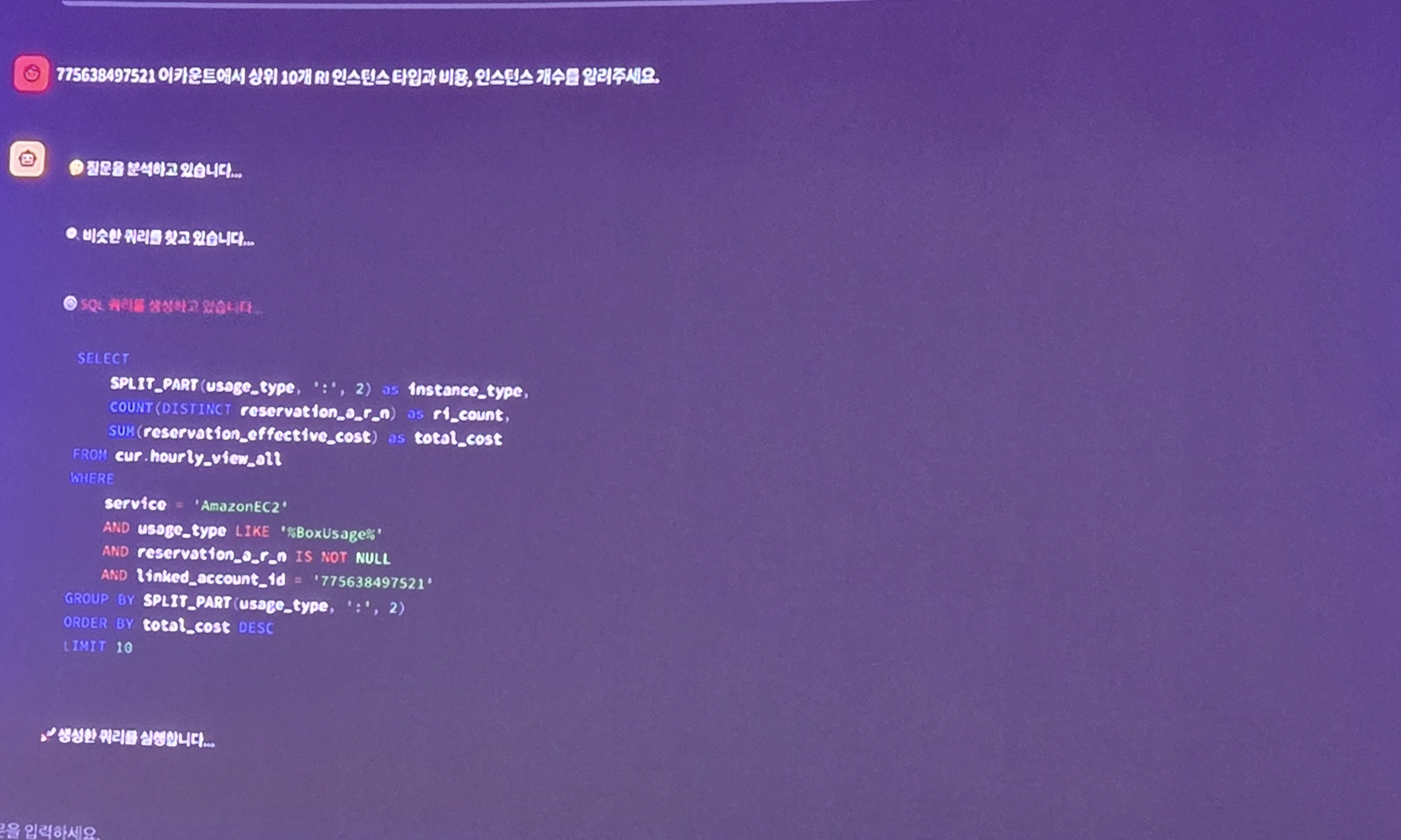

AWS 위에 올라간 비용 분석 시스템은 다음과 같은 아키텍처를 가지는데요.

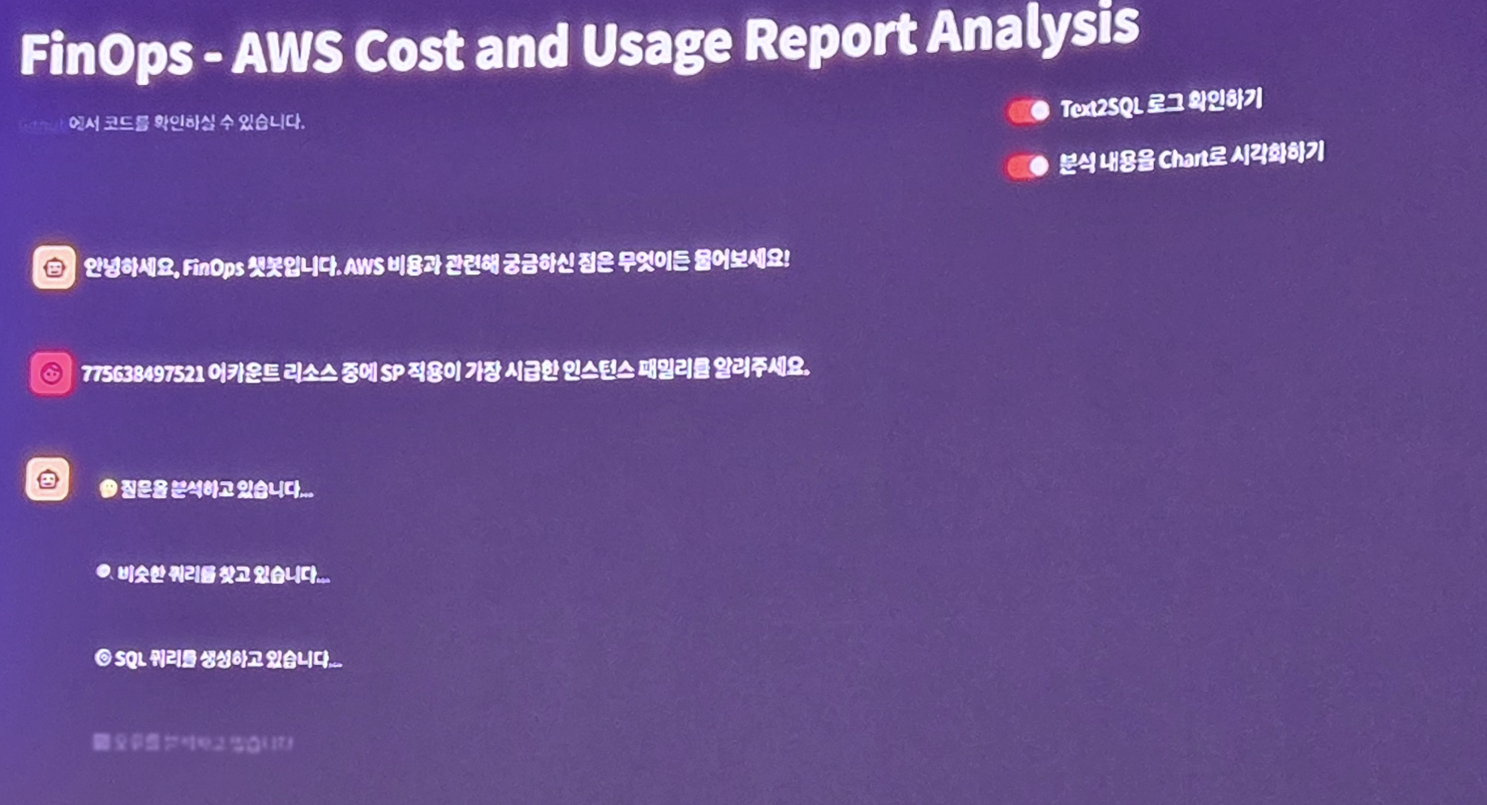

이러한 아키텍처 위에 올라간 Demo 서비스는 다음과 같습니다.

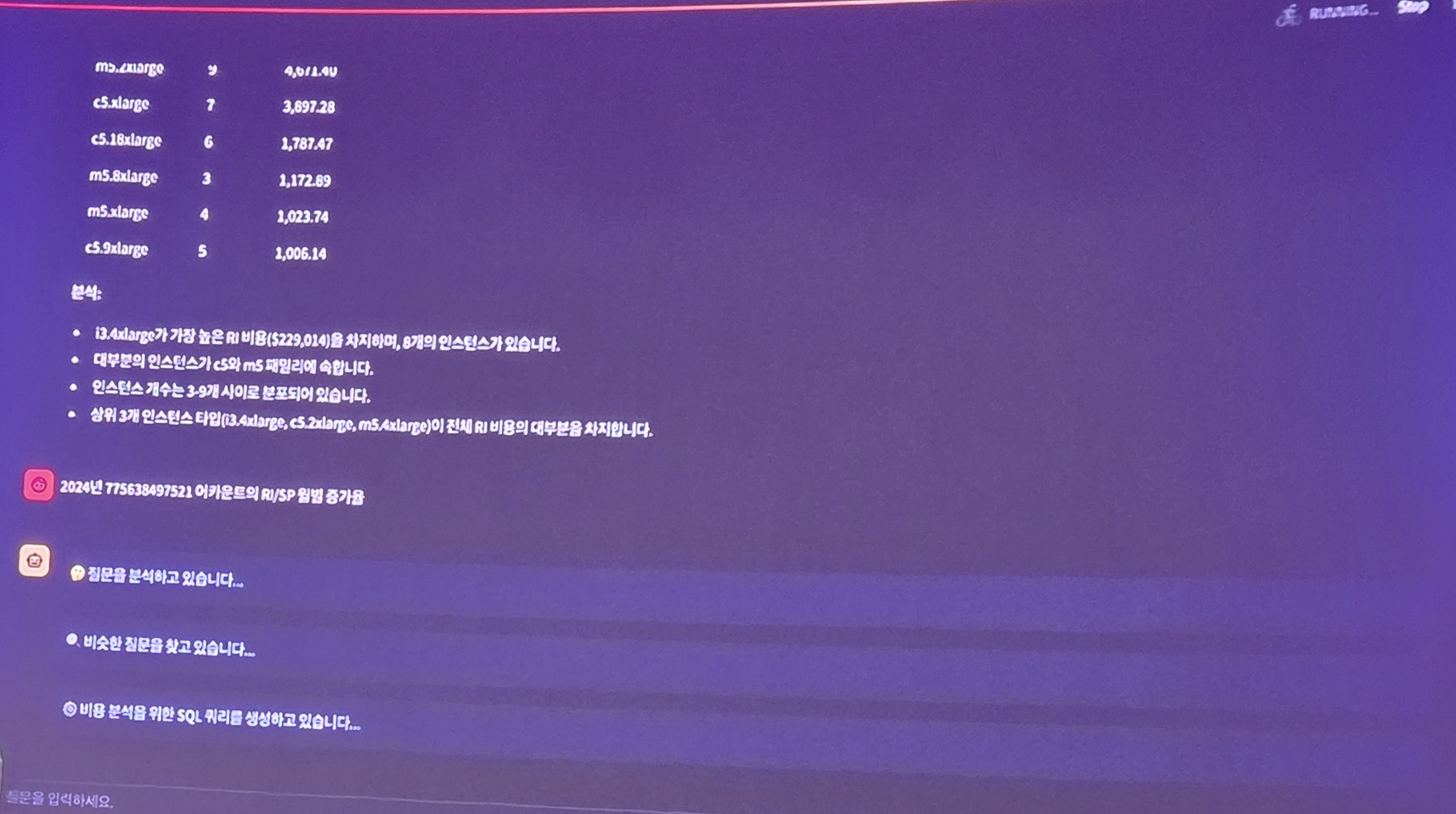

Chat 기반의 인터페이스로 FinOps 운영자는 자연어로 질의를 하면 LLM을 통해 답변을 받습니다.

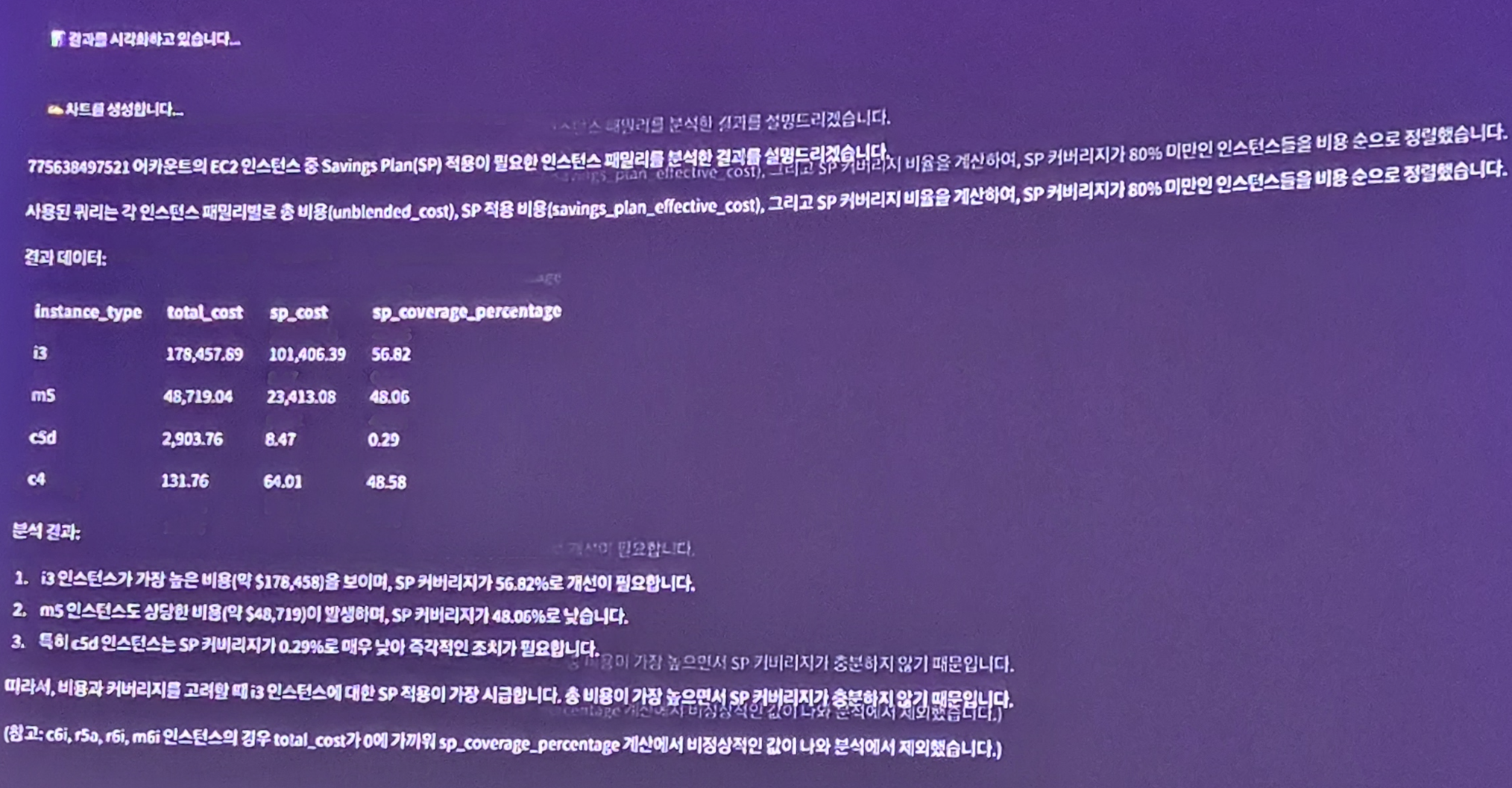

실제 필요한 데이터를 표로 리턴 받기도 하며..

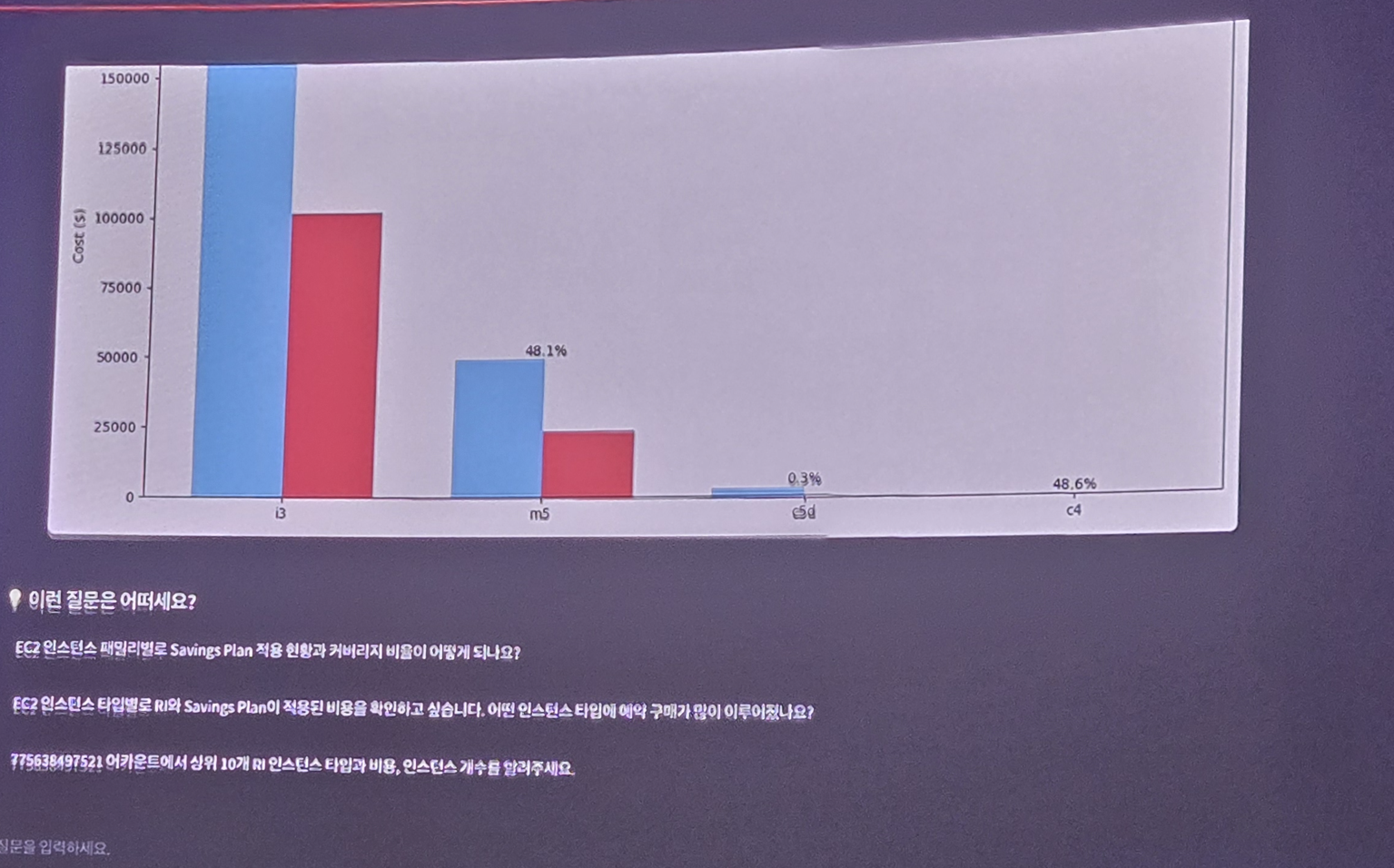

필요하다면 시각화된 차트로 정보를 조회할 수도 있습니다. 또한 추천할 만한 다음 질문도 선택할 수 있게 됩니다.

또한 사용자 요청에 맞는 적절한 DB 쿼리를 탐색하여 그 쿼리를 수행하여 필요한 데이터를 얻을 수 있게 됩니다.

이러한 FinOps는 매우 반복적이고, 많은 도구를 거쳐야 하지만 이렇게 자연어 기반의 Chat은 그 과정을 대폭 줄여주기 때문에 운영자는 다양한 인사이트와 취합 정보를 손쉽게 얻을 수 있습니다.

삼성전자는 이러한 기술을 바탕으로, 미래 전략도 세웠는데.. 앞으로 어떻게 발전할지 궁금하네요

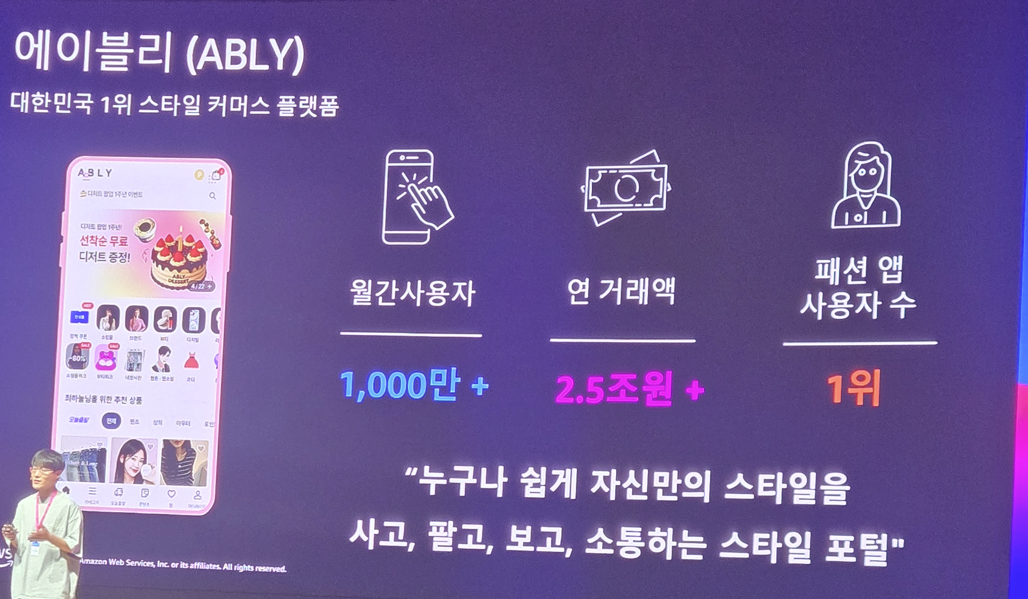

다음은 에이블리사의 발표입니다. 에이블리는 급성장하는 스타일 커머스 플랫폼입니다.

유저마다 다른 사용자 경험을 제공하기 위해 AI를 사용한다고 합니다.

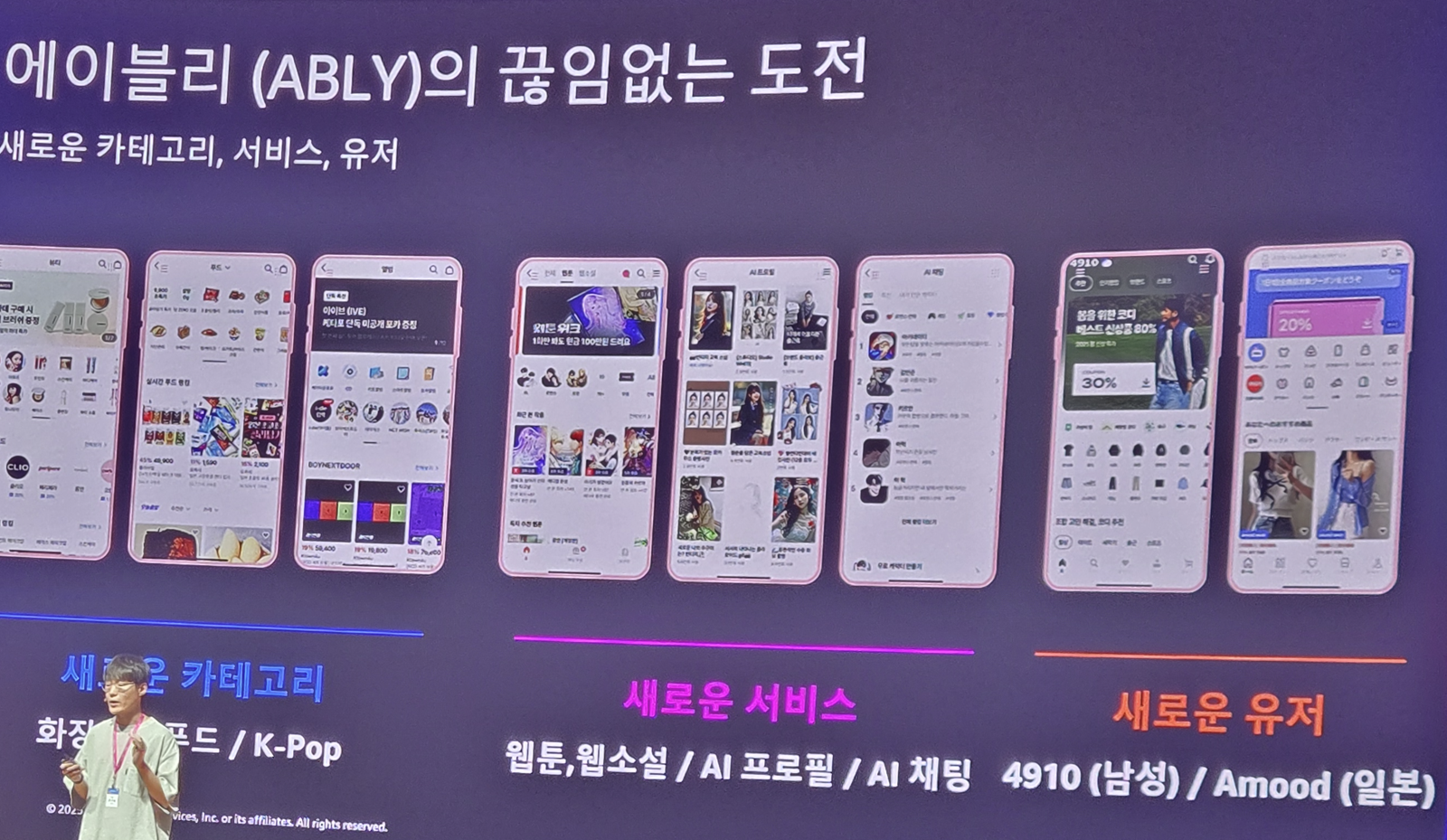

또한 AI 기반의 서비스를 지속적으로 만들어 다양한 도전을 시도하고 있다고 하는데

이러한 서비스 도전이 가능한건 탄탄한 인프라와 아키텍처가 있어서이죠

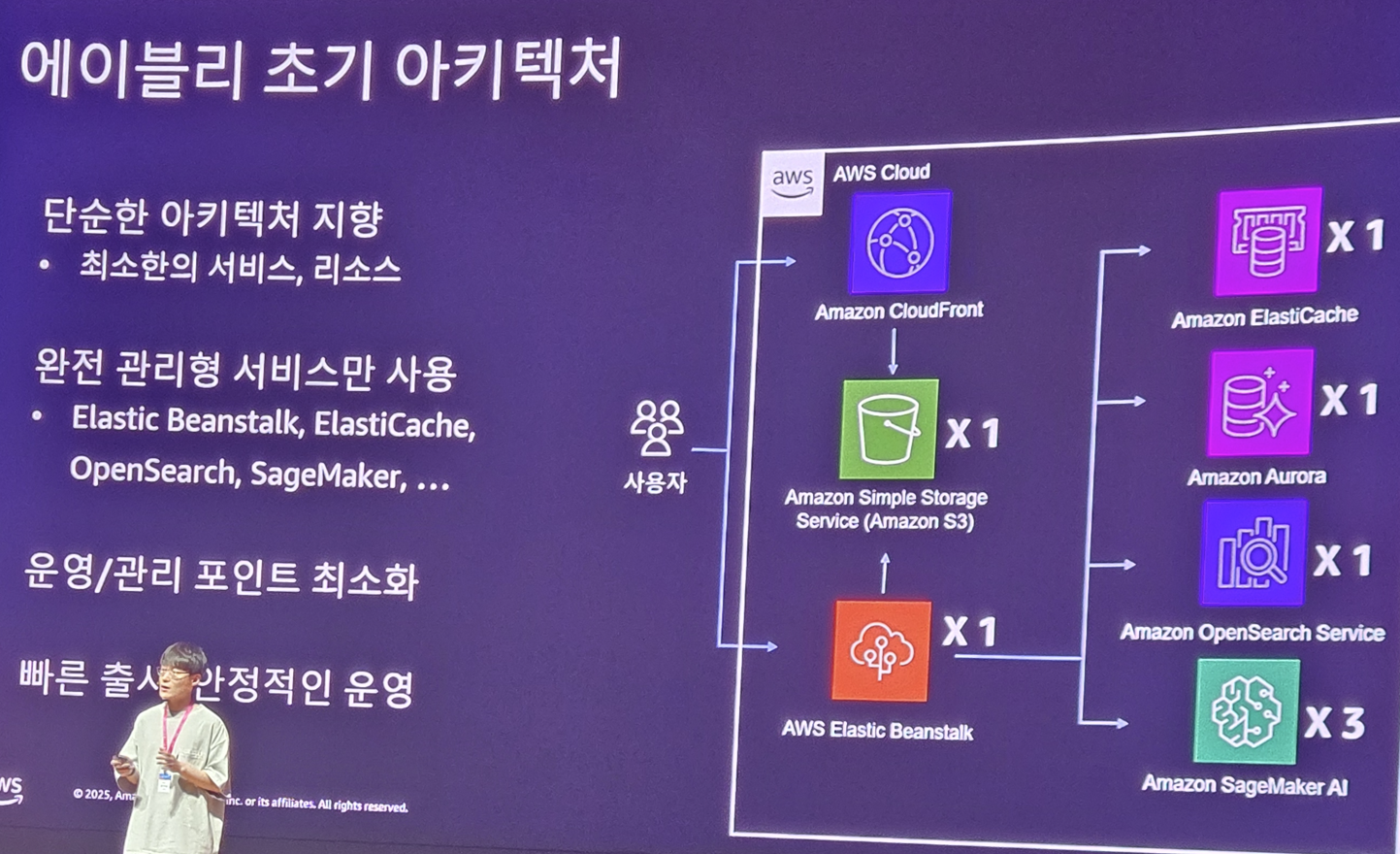

사실 서비스 초창기에는 아래와 같이 단순하였습니다.

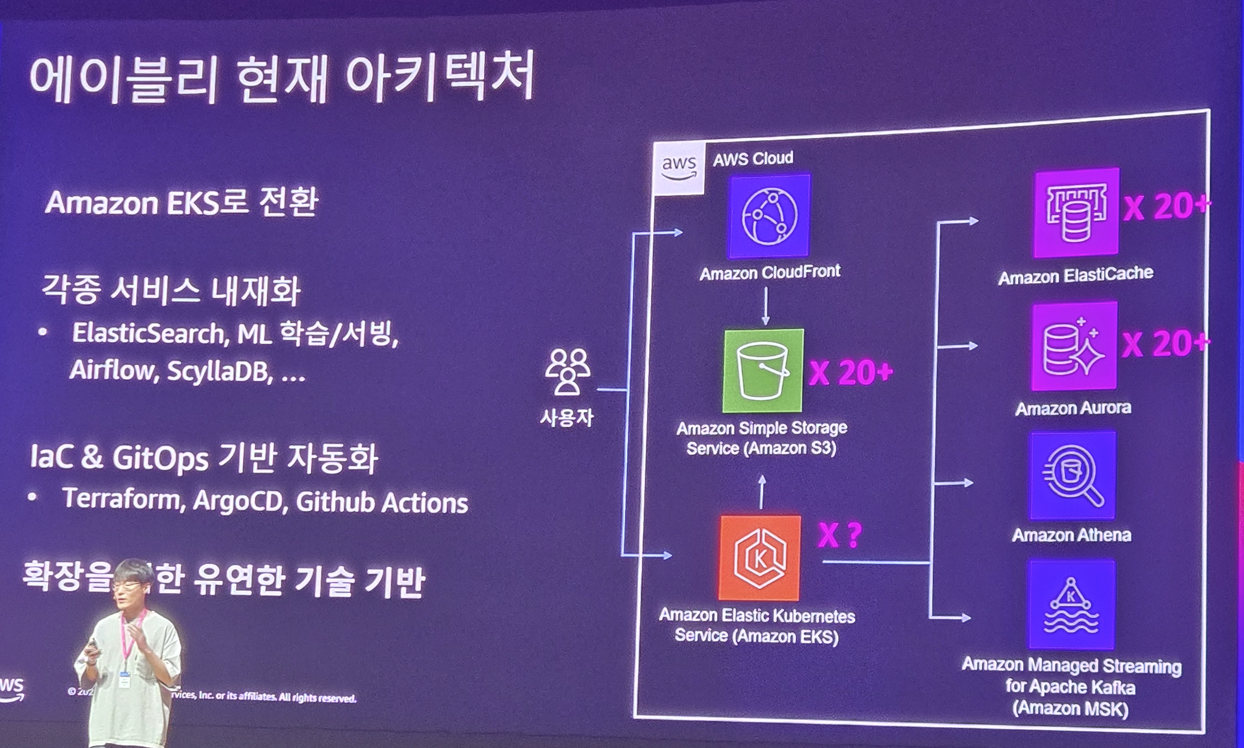

근데 점점 시간이 지날수록 덩치가 커지게 됩니다. 운영 요소가 너무 증가하게 되는데요. 이러한 문제를 극복하기 위해 IaC 및 GitOps를 도입하게 됩니다. 또한 EKS로 전환을 하여 MSA 기반으로 아키텍처를 개선하게 되죠. 그리고 각종 서비스들을 내재화시킵니다.

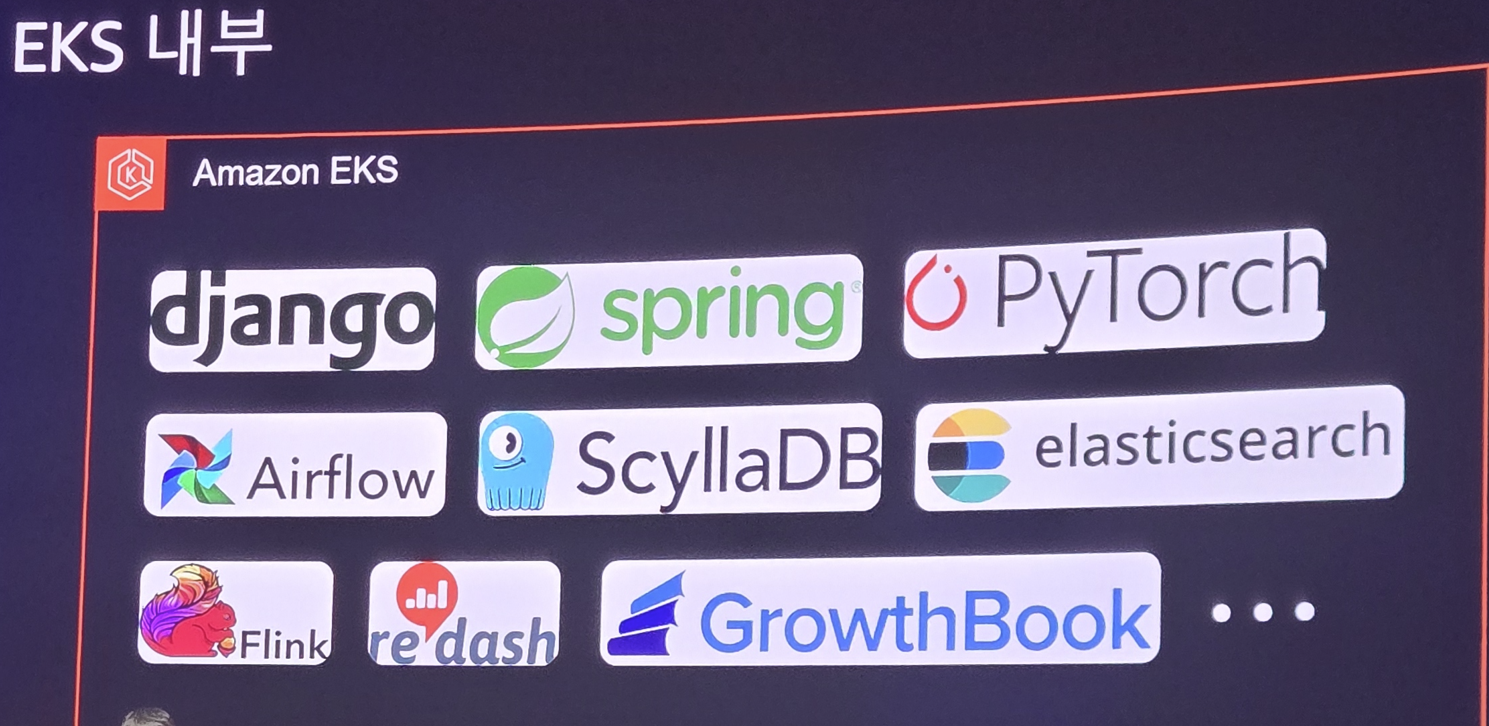

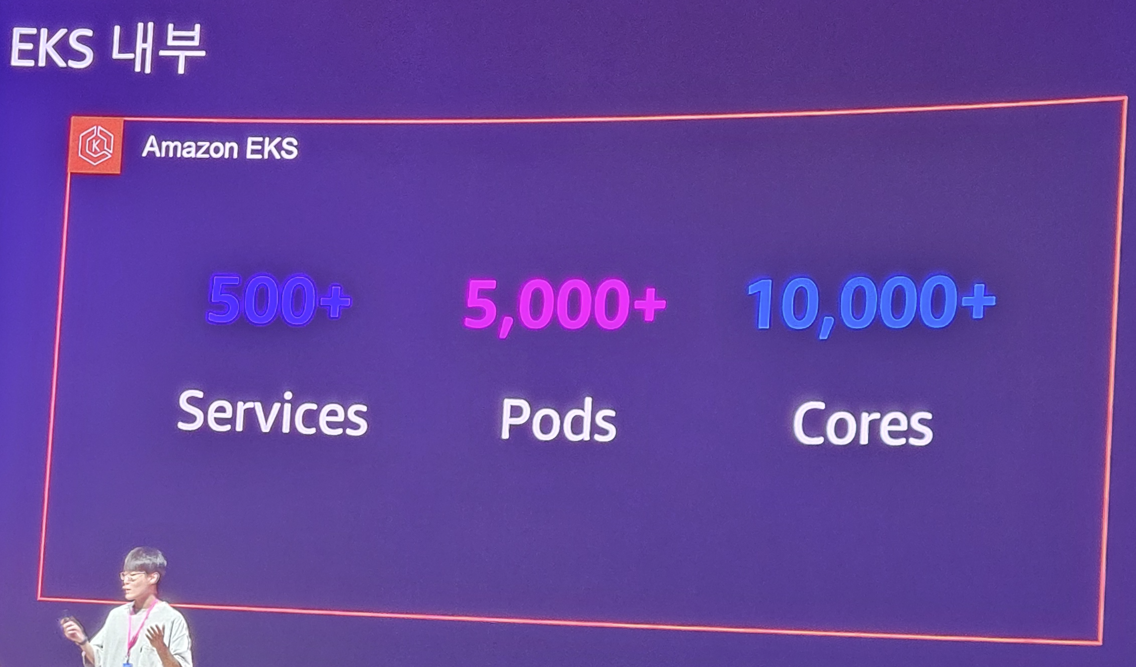

EKS에는 이런 서비스들을 올렸다고 하네요. 현재 500개의 서비스, 5000개의 POD, 10000 코어의 자원을 사용하고 있다고 합니다.

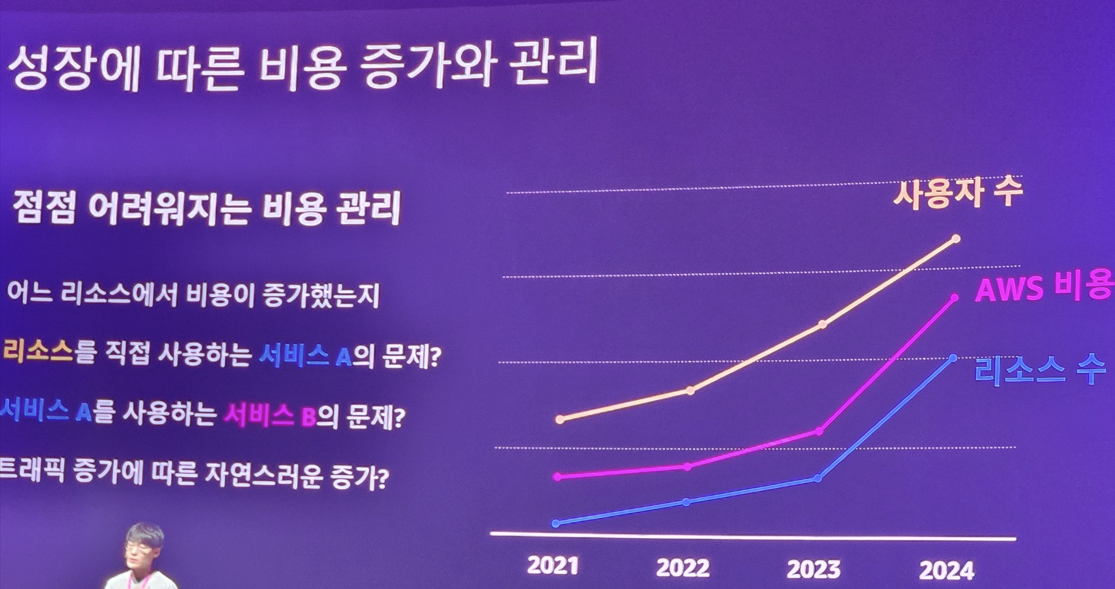

서비스가 잘되는건 좋은데.. 늘어나는 클라우드 인프라는 결국 비용도 상승이기 때문에, 이게 슬슬 부담스러워집니다.

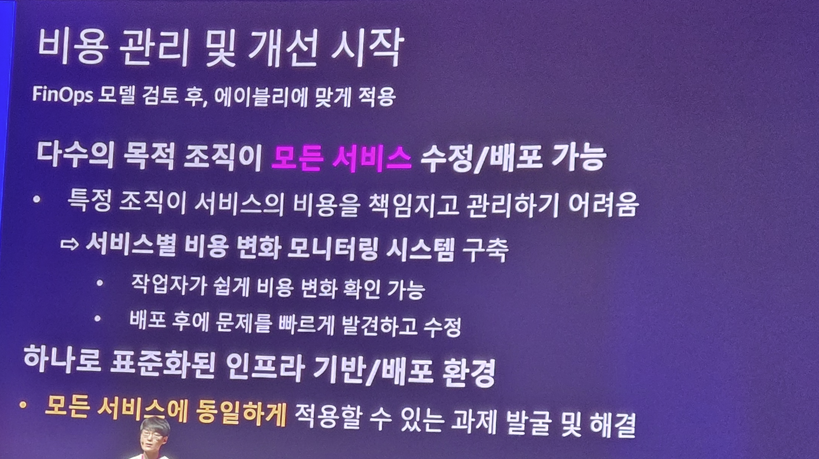

에이블리도 FinOps를 고민하고 개선을 시작하게 됩니다. 비용을 모니터링할 수 있는 시스템을 구축하고, 배포 후에도 지속 관찰하여 운영중에도 지속적으로 비용을 효율화 할 방법을 찾는것이죠 그런데 이런게 가능한건 하나로 "표준화된 인프라 기반/배포 환경"이 있었기에 가능한것입니다.

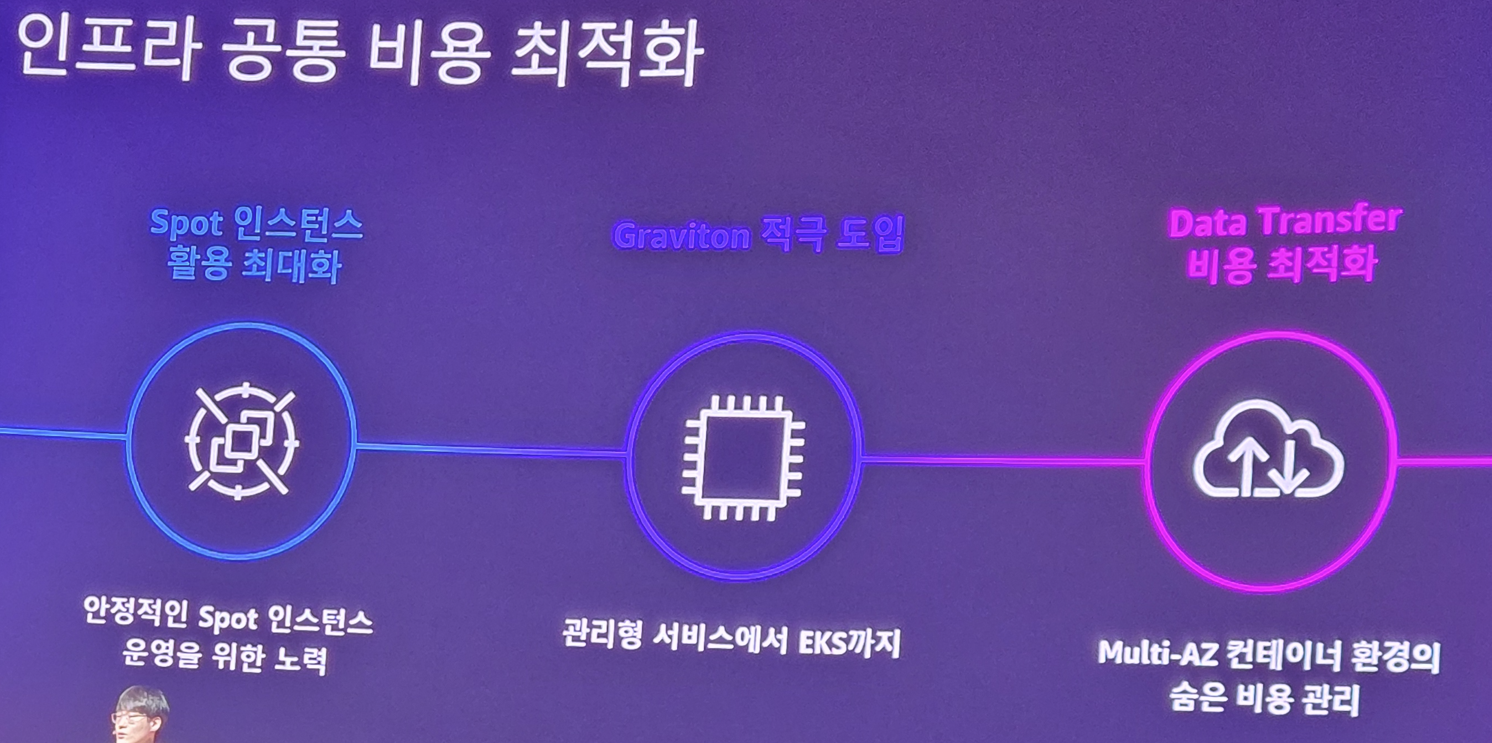

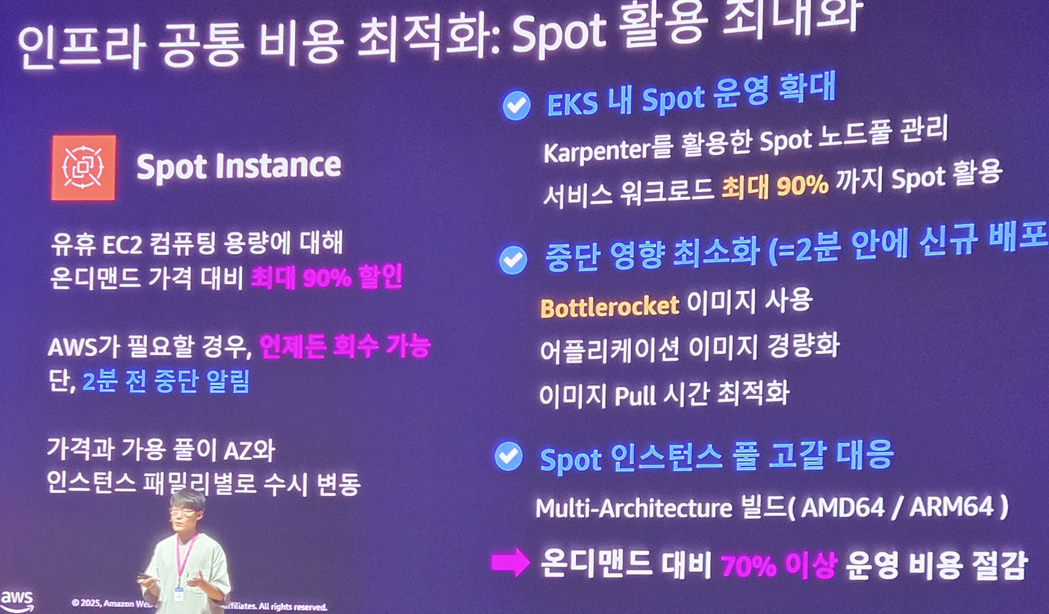

그리고 인프라 공통 비용을 최적화하는 방법을 고민합니다. 에이블리는 상대적으로 더 저렴한 Spot 인스턴스 활용을 적극적으로 쓰기로 계획하고, 문제가 없다면 더 싼 CPU인 Graviton 을 도입하기로 하며, 네트워크간 통신 시 데이터 전송 비용도 아낄 수 있는 방법을 최대한 찾게 됩니다.

고정 할당 방식의 자원이 아닌 필요할때 마다 그때그때 빌려 쓰는 Spot 자원은 상대적으로 더 저렴합니다. 그리고 이런 특성 때문에 사용량이 적을 경우 즉시 자원을 반납하여 더 효율적인 자원 사용이 가능해집니다. 이를 통해 운영 비용을 70% 이상 절감합니다.

아마존이 직접 만드는 클라우드 전용 CPU인 Graviton은 ARM 기반으로 더 적은 전기와 열을 발생시키때문에 상대적으로 비용이 적습니다. 또한 성능도 기존의 x86 과 크게 차이가 없죠. 호환성 문제만 없다면 적극 도입하는 선택을 합니다.

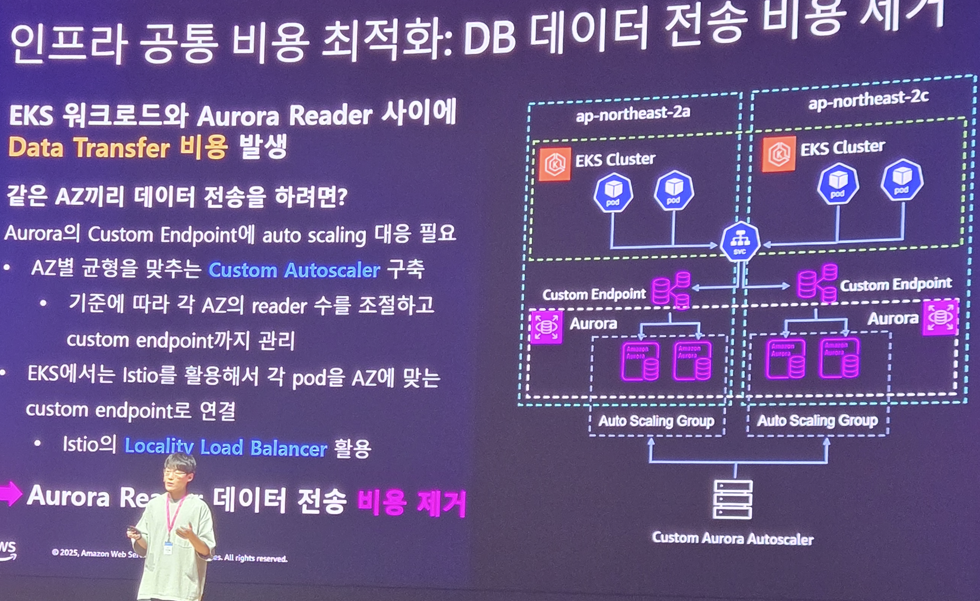

그리고 AWS의 경우 네트워크 비용도 만만치 않은데.. AZ를 넘어서는 통신시 발생되는 비용을 줄이기 위해 효율적인 아키텍처 디자인을 도입합니다.

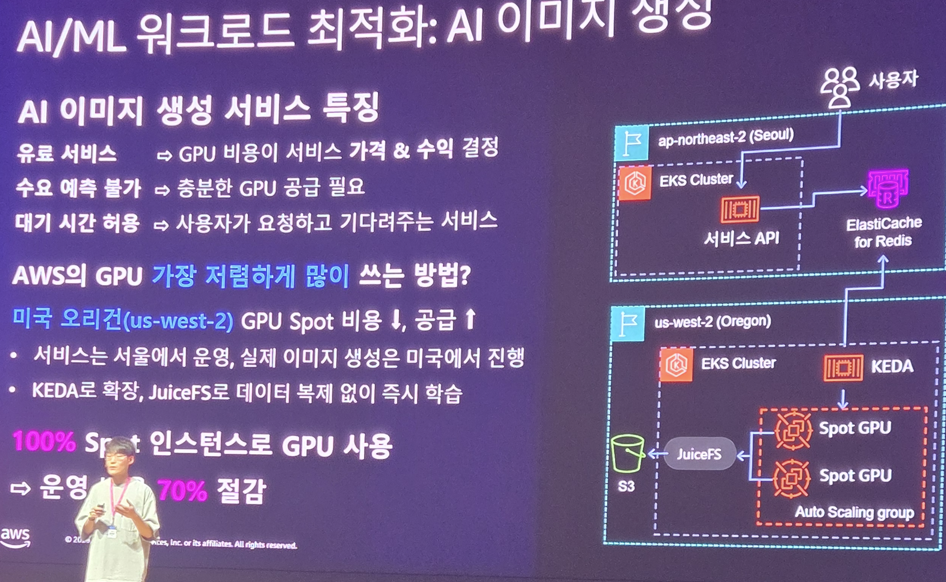

그리고 AWS의 경우 GPU 비용이 비싸다보니.. 학습에는 에이블리가 보유한 인프라를 사용하게 하고, 추가적으로 필요한 경우에는 AWS 서비스를 이용하게 합니다. 에이블리에서 만든 AI 서비스들은 빠른 응답을 요구하지 않기 때문에.. AWS의 GPU 를 쓰는데.. 이때도 상대적으로 더 싸게 쓸 수 있는 Oregon의 EKS 환경을 채택하게 됩니다.

오리건주의 EKS가 제일 싼지 몰랐네요

어쨋건 이런식의 극한의 비용 다이어트(FinOps)는 결과적으로 순이익 증가로 발생하게 되며.. 에이블리는 성장하는 기업이 될 수 있게 되었습니다.

대한항공의 AI 대전환: Amazon Bedrock 기반 AI 컨택센터 지식 검색 챗봇 구축 사례

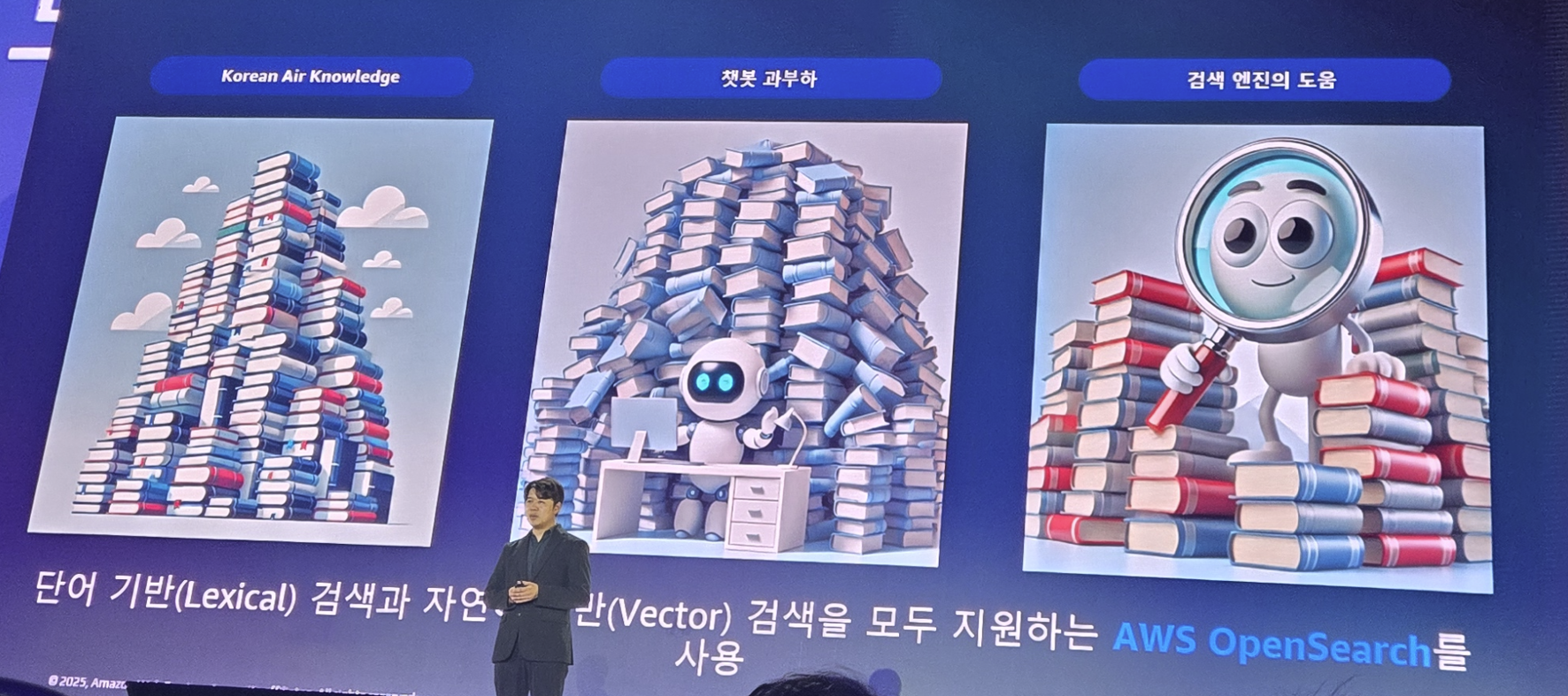

현재 업무에서 OpenSearch를 활용하는것을 고민하고 있는데... 대한항공에서 Opensearch를 활용하여 챗복으로 만들었다고 하여 듣게 되었습니다.

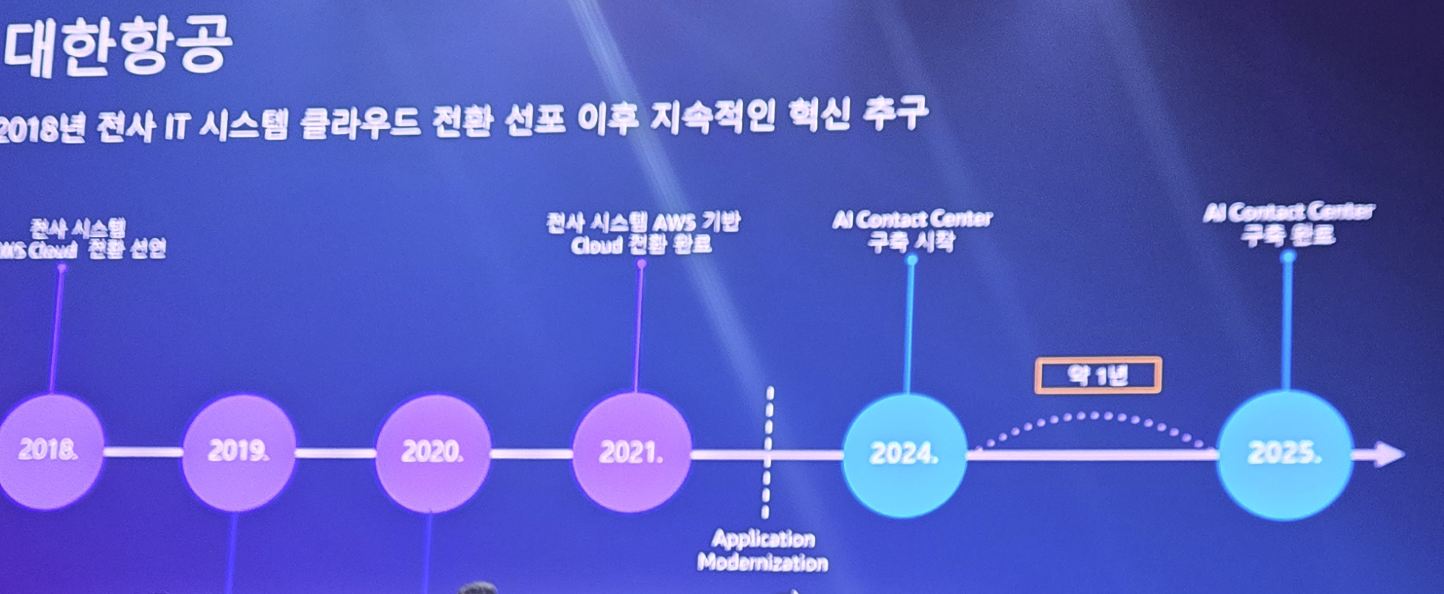

모든 기업들이 그렇듯이 대한항공 역시 IT 시스템을 클라우드 전환을 2018년부터 준비하게 됩니다.

그리고 그렇게 구축된 클라우드 환경에서 AI 도입을 1년만에 하게 되었고.. 그 AI 도입을 통해 상담원들을 위한 AI 서비스를 만들게 되었습니다.

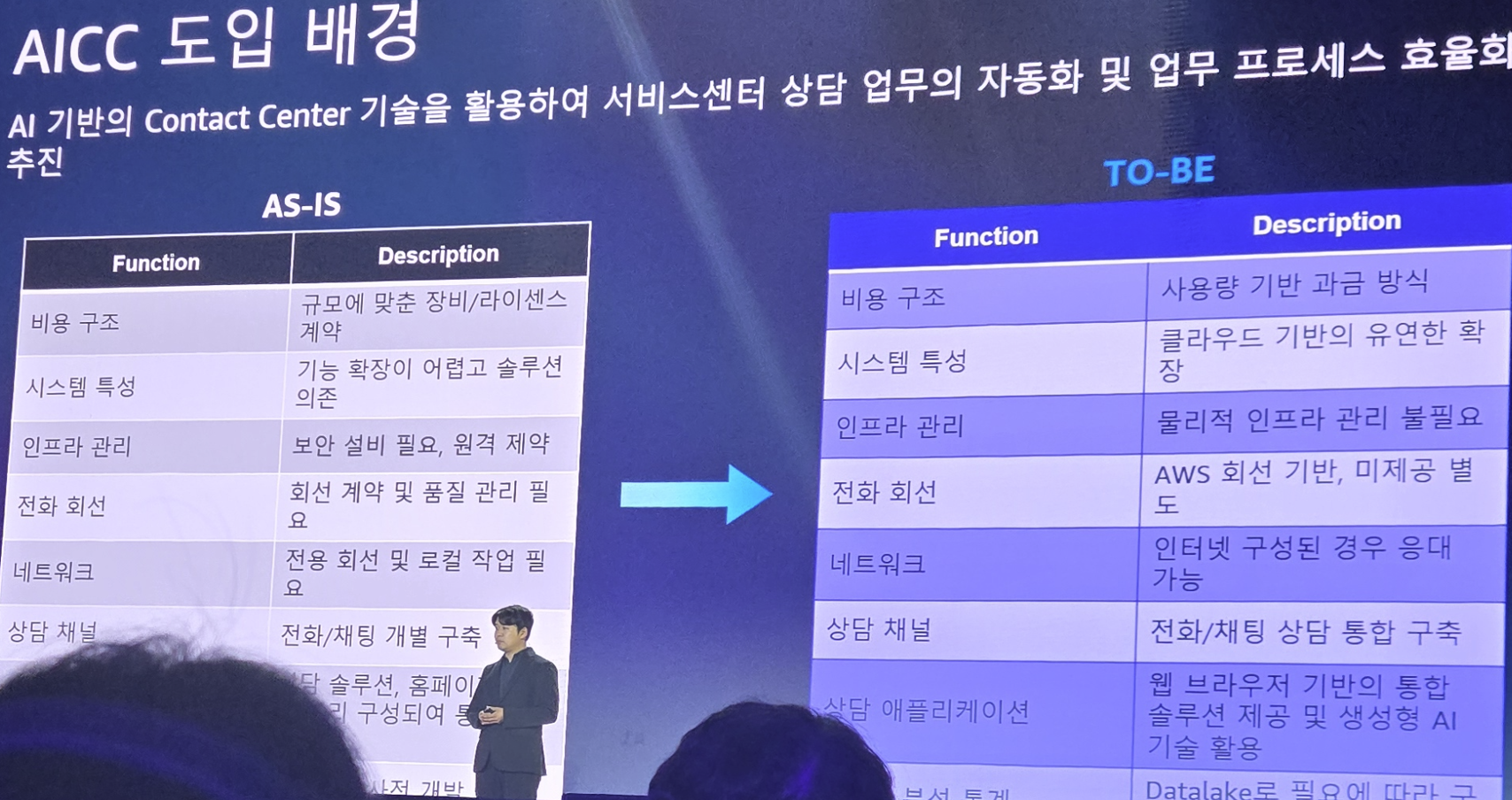

항공업 특성상 고객응대는 매우 중요합니다. 그런데 이런 고객 응대는 굉장히 많은 사람의 리소스가 필요합니다. 이러한 리소스를 효율적으로 줄일려면... 지금의 생성형 AI는 매우 필수불가결인 요소이죠

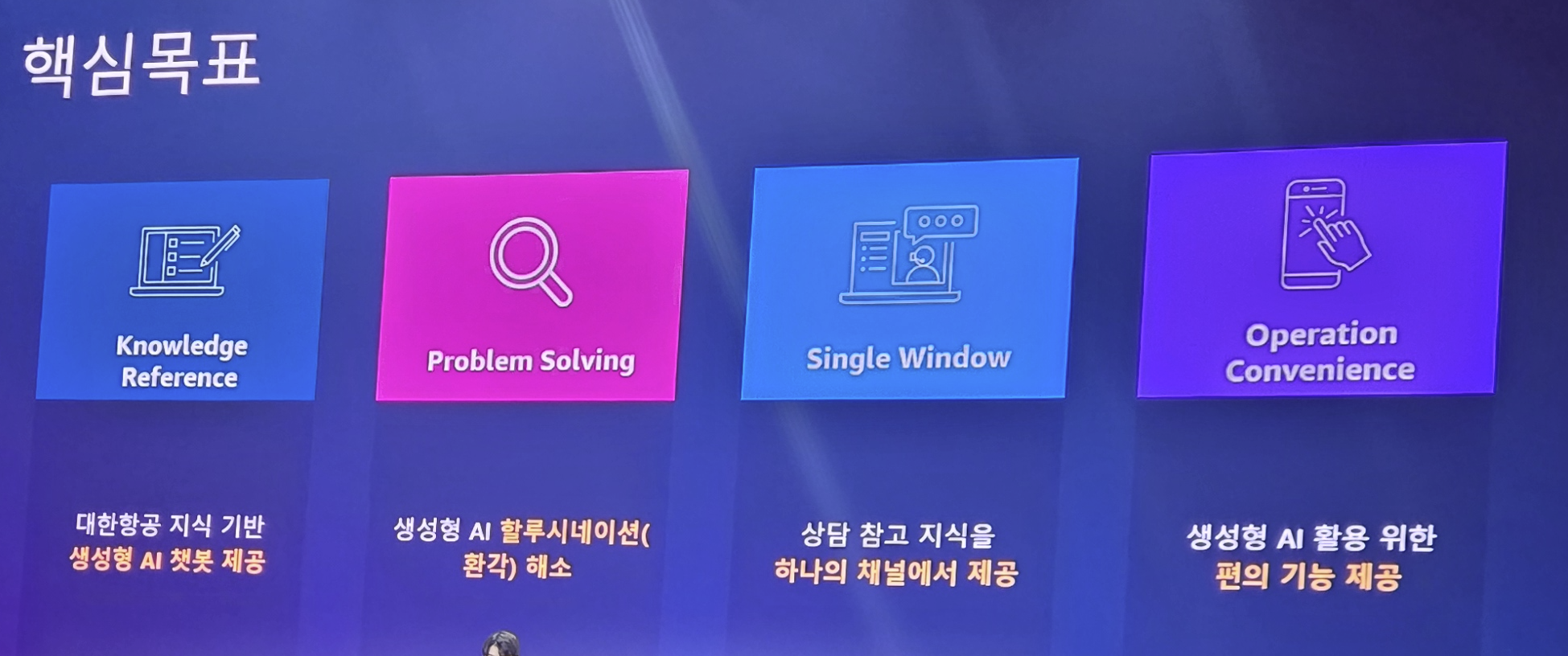

AI 기반의 고객 응대 서비스를 위해 다음과 같이 목표를 세우고

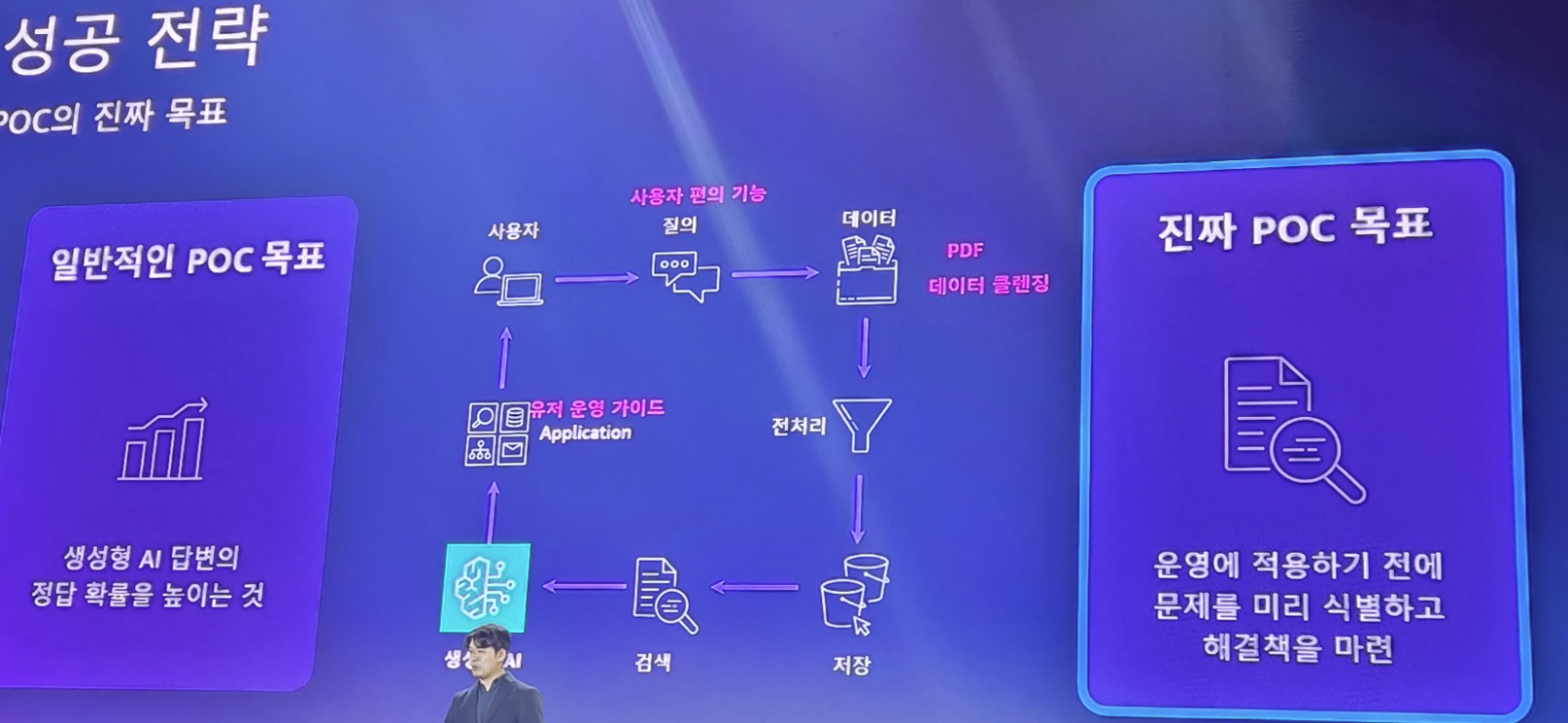

성공 전략을 디자인합니다.

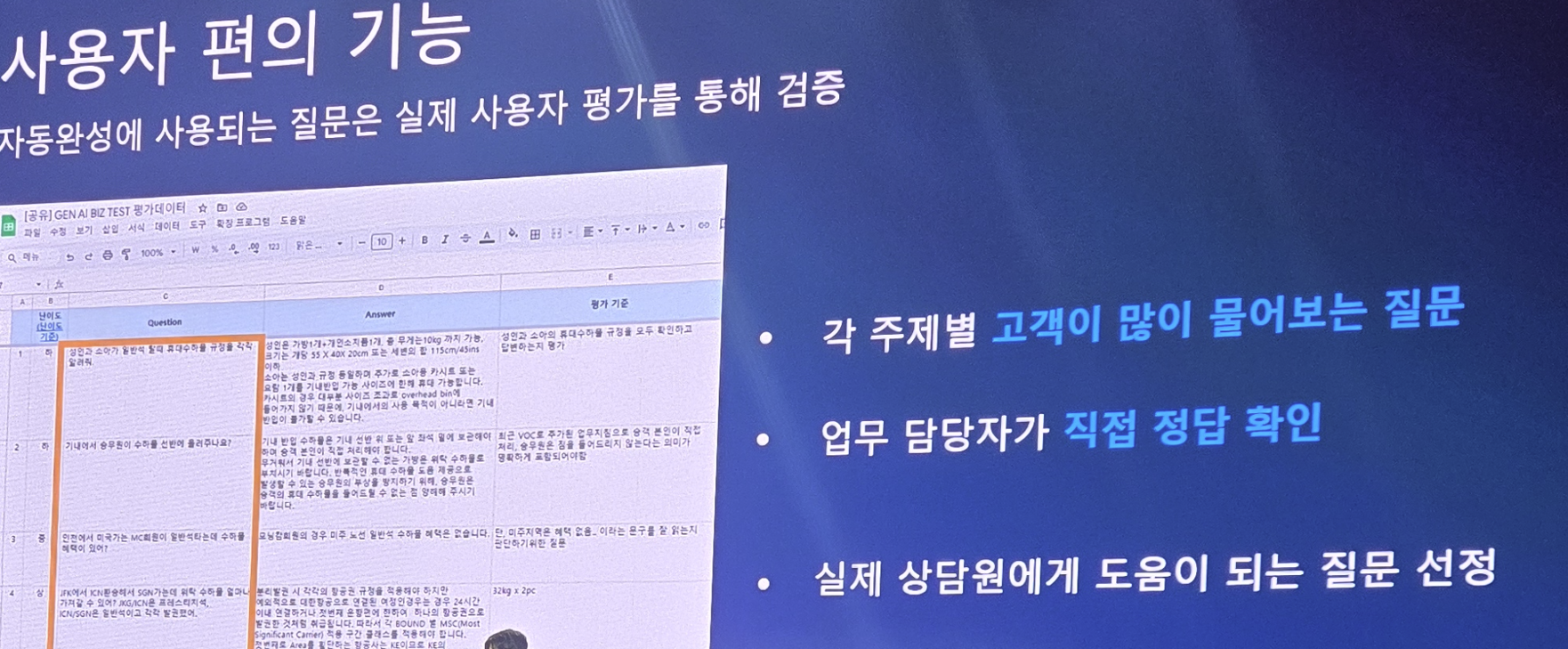

그리고 챗봇의 평가 체계로 실제 현업 담당자와 함께 만듭니다.

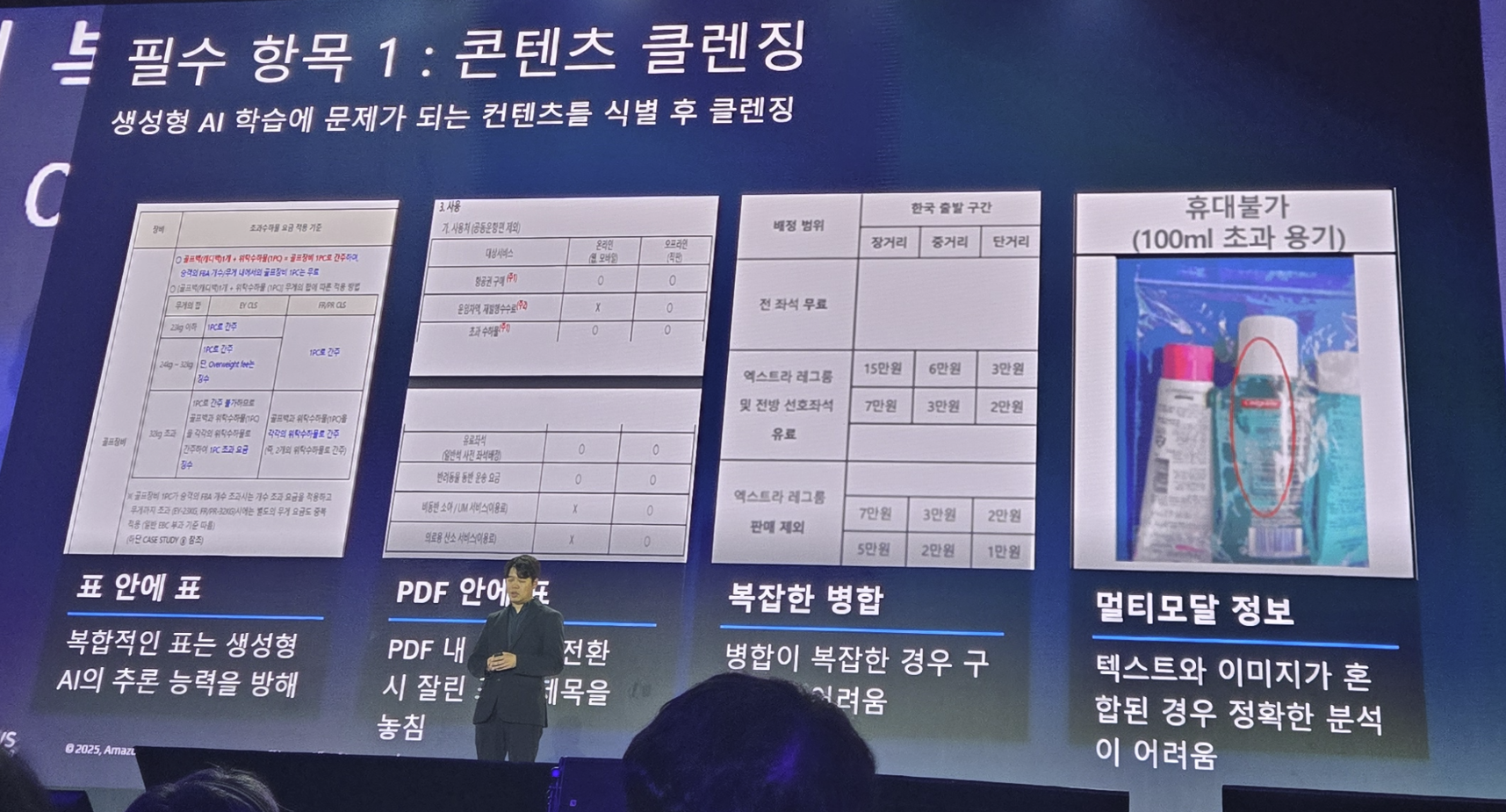

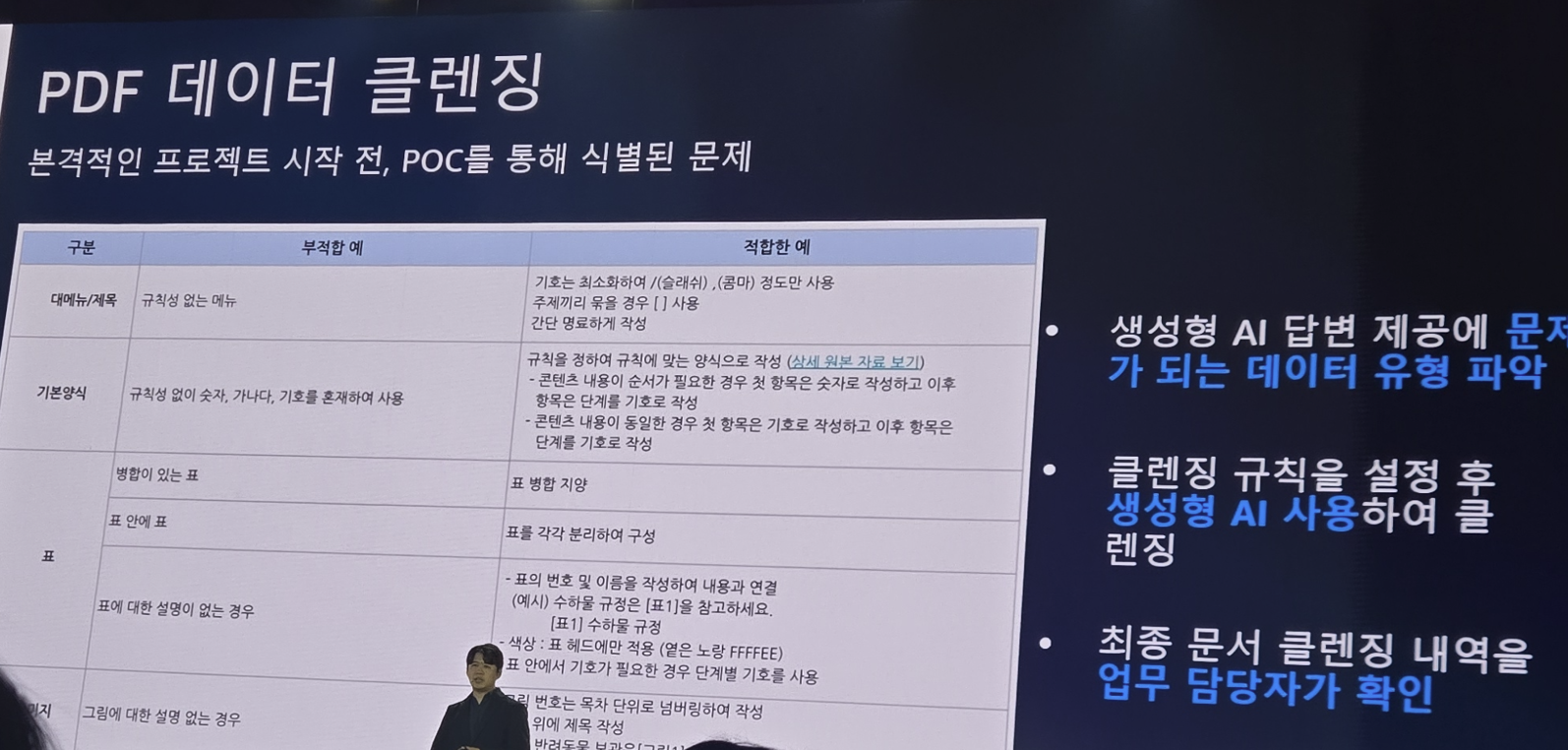

항공사의 고객 문의는 정말 다양하고.. 대응해야 할 답변도 엄청 많습니다. 이에 대한 메뉴얼은 PDF, 엑셀, 이미지등.. 다양한 형태로 존재하게 되는데.. 이러한 데이터는 LLM에서 편하게 쓰기 위해서는 클렌징 및 정규화 작업이 필요하게 됩니다.

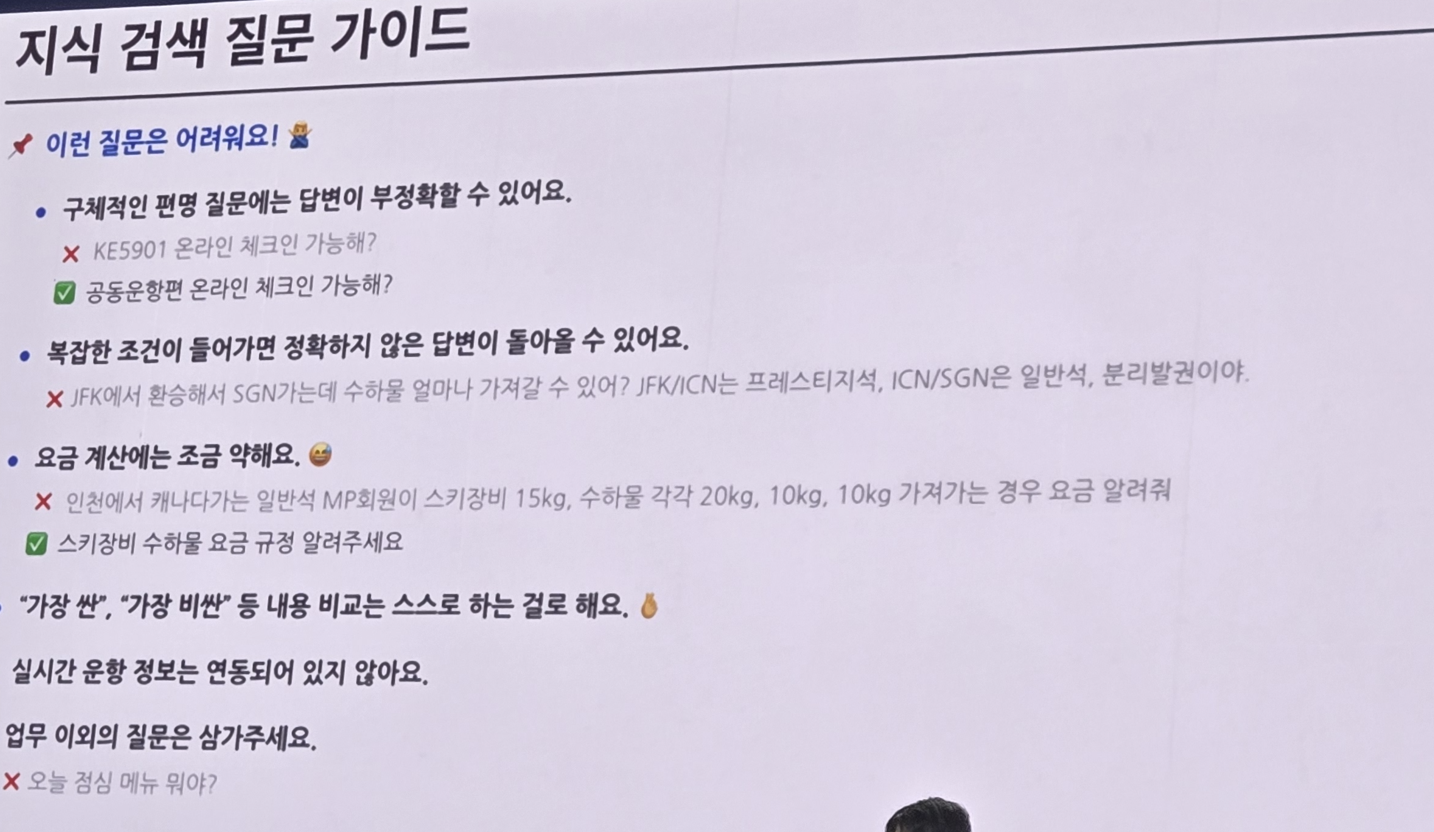

또한 고객 응대를 하는 직원들은 아직 생성형 AI의 답변 특성을 모르기때문에 AI를 잘쓰게 하기 위해 적절한 AI 가이드라인이 필요합니다.

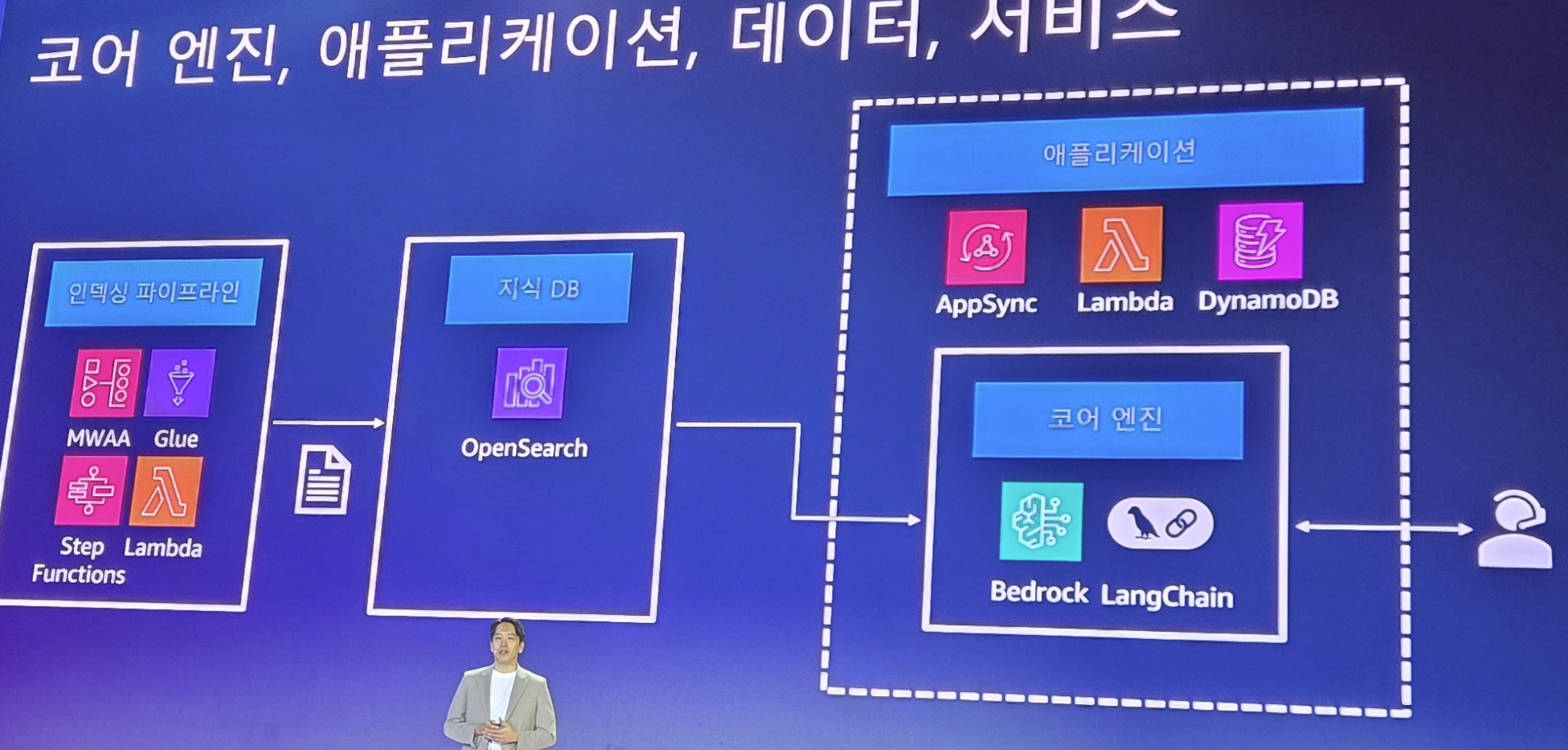

그리고 Chatbot 서비스를 위해서는 적절한 검색엔진 도입이 필요한데 AWS의 Opensearh를 선택하였다고 합니다.

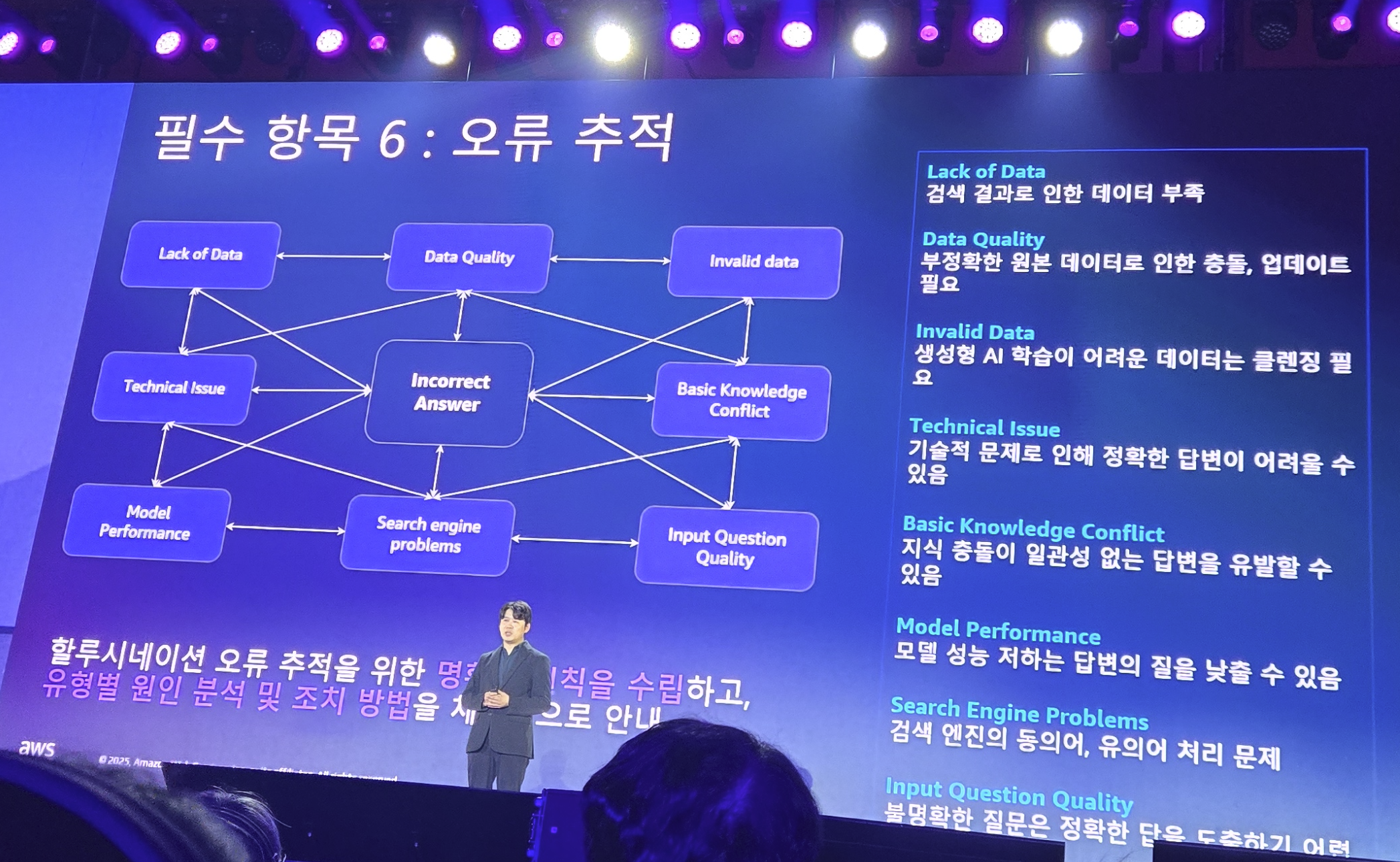

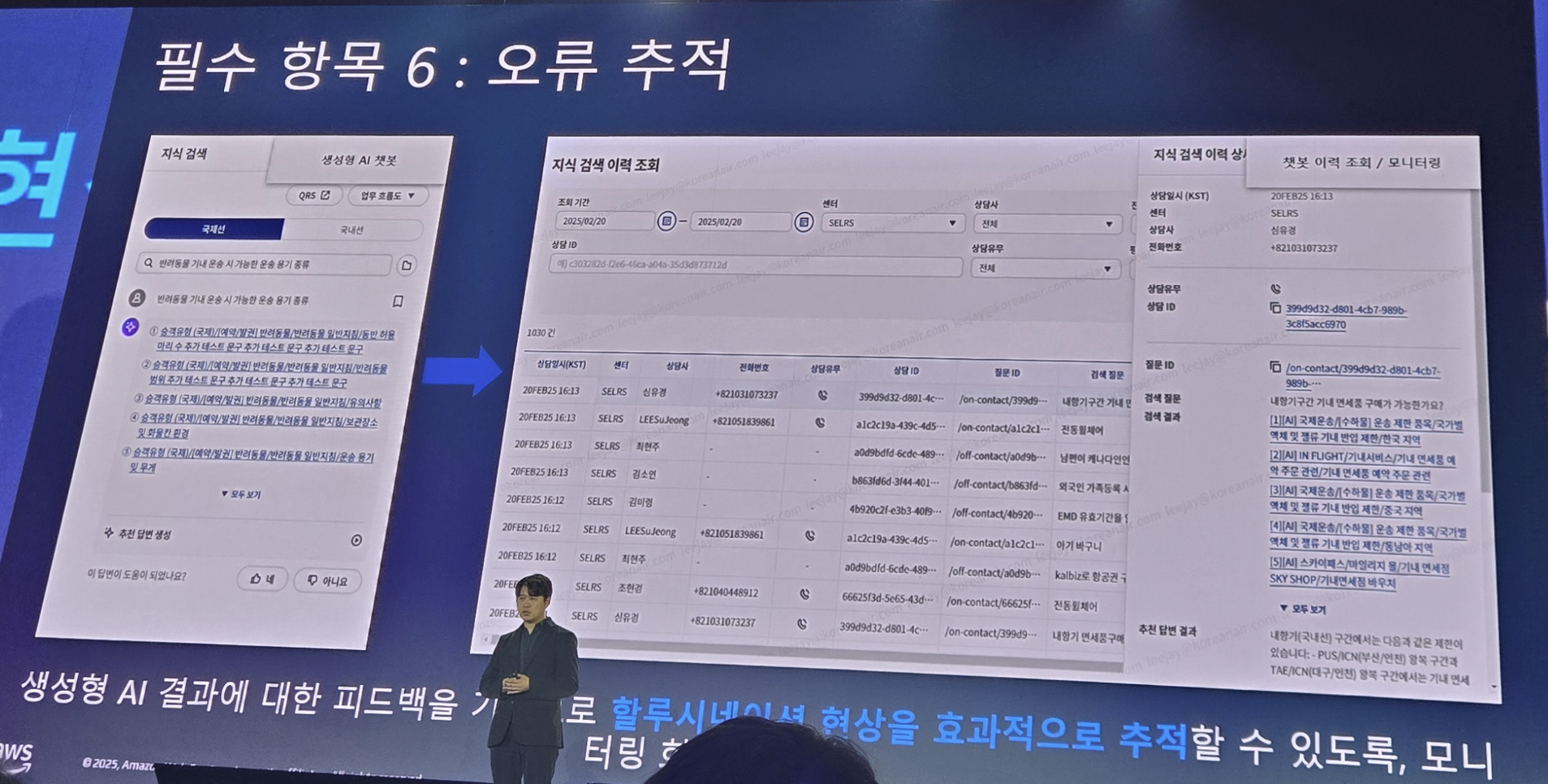

그리고 이러한 고객 응대 서비스에서는 잘못된 답변(LLM 환각)이 발생되면 안되기 때문에 이러한 문제를 진단할 수 있는 체계도 준비하게 됩니다.

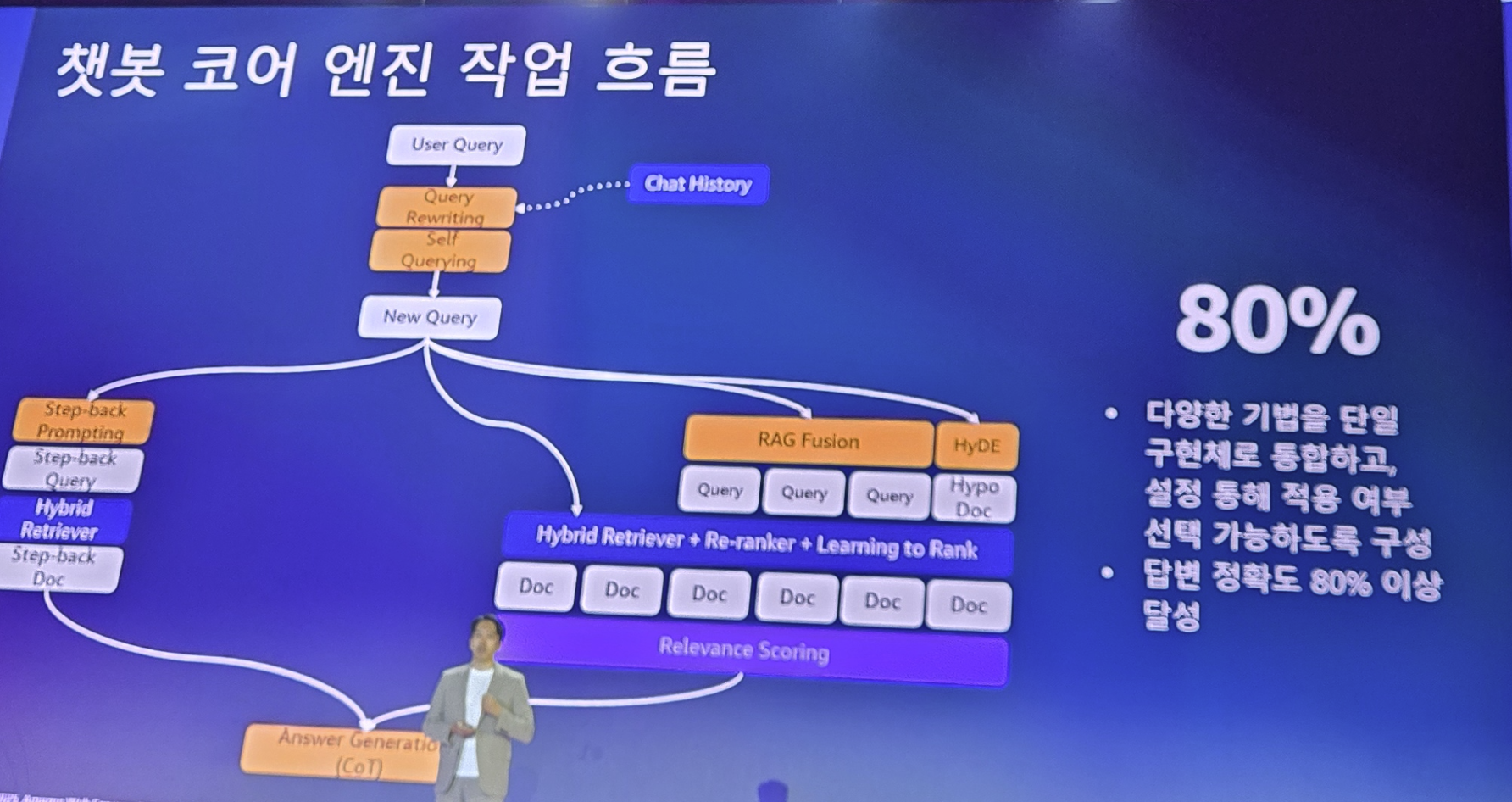

이러한 요소들을 모두 고려하여 다음과 같은 RAG 기반의 Chatbot 서비스를 디자인하게 됩니다.

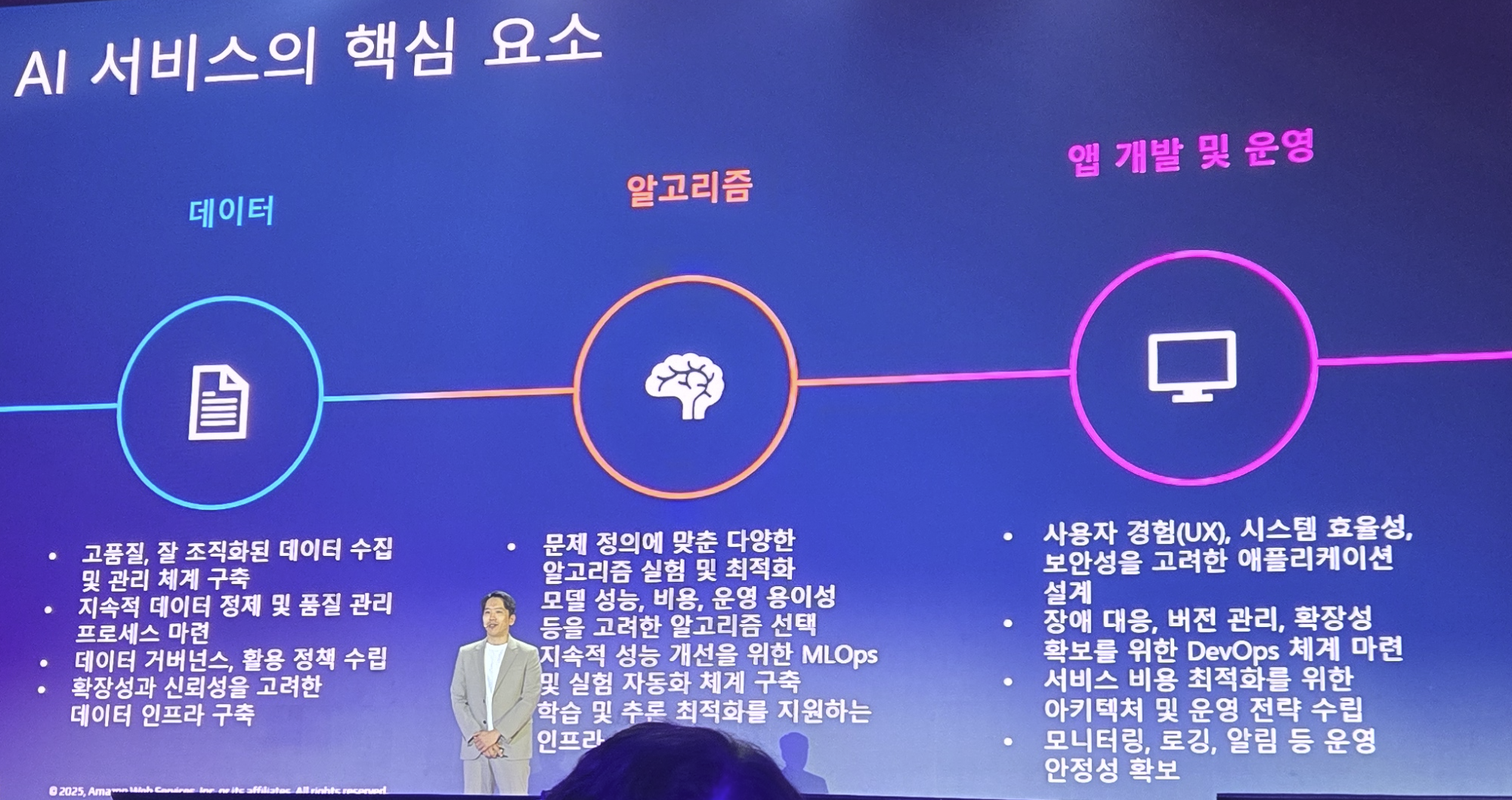

그리고 본격적으로 개발을 준비하는데.. 이러한 AI 서비스 개발을 위해서 필요로 한 준비가 잘 되었는지 다시한번 리뷰합니다.

- 잘 준비된 데이터가 있는가?

- 문제를 해결한 올바른 전략(알고리즘)을 준비하였는가?

개발 및 운영을 위한 인프라/체계가 준비되었는가? (DevOps)

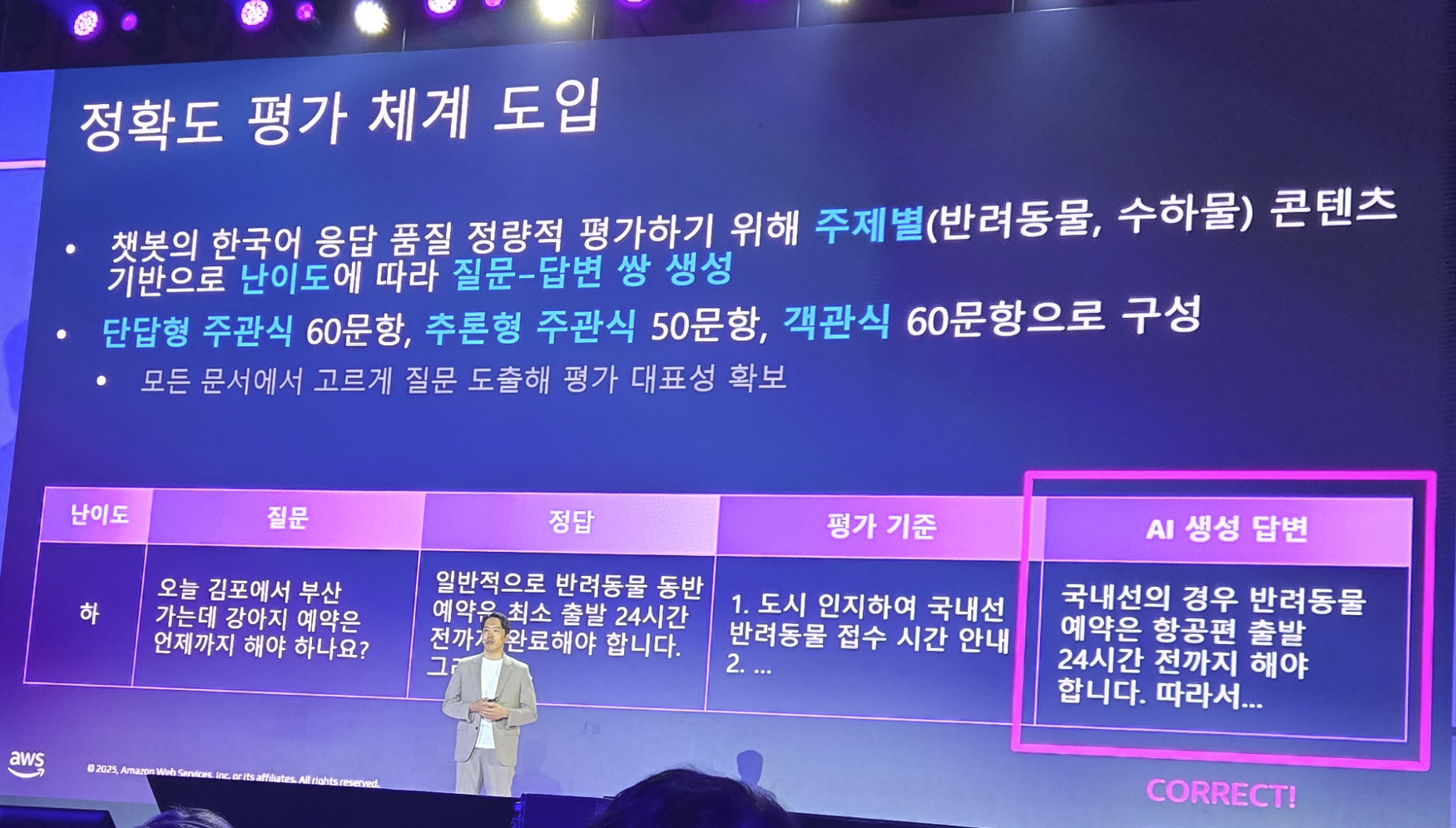

그리고 만들어진 AI 서비스를 위한 평가 체계 시스템에 대해서도 검토를 합니다.

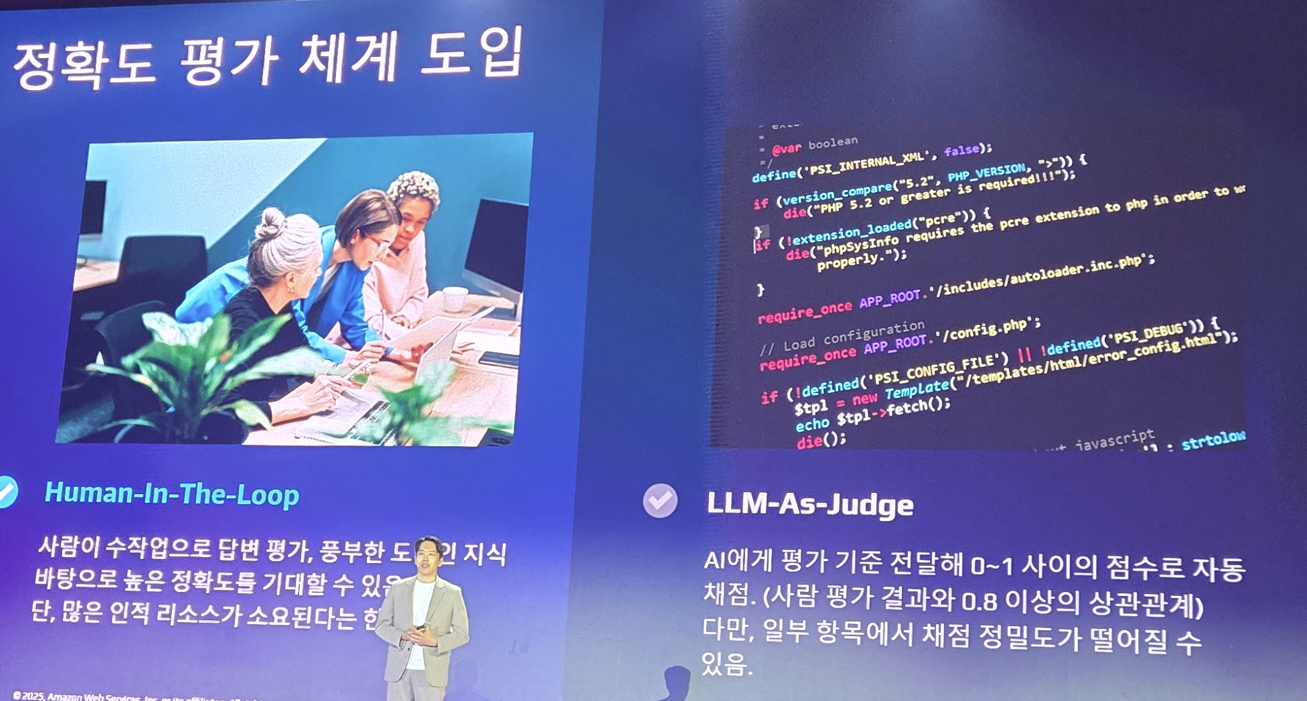

이 평가 체계는 두가지 방식이 있는데.. 사람이 하는 방법과 AI가 AI를 평가하는 방식입니다.

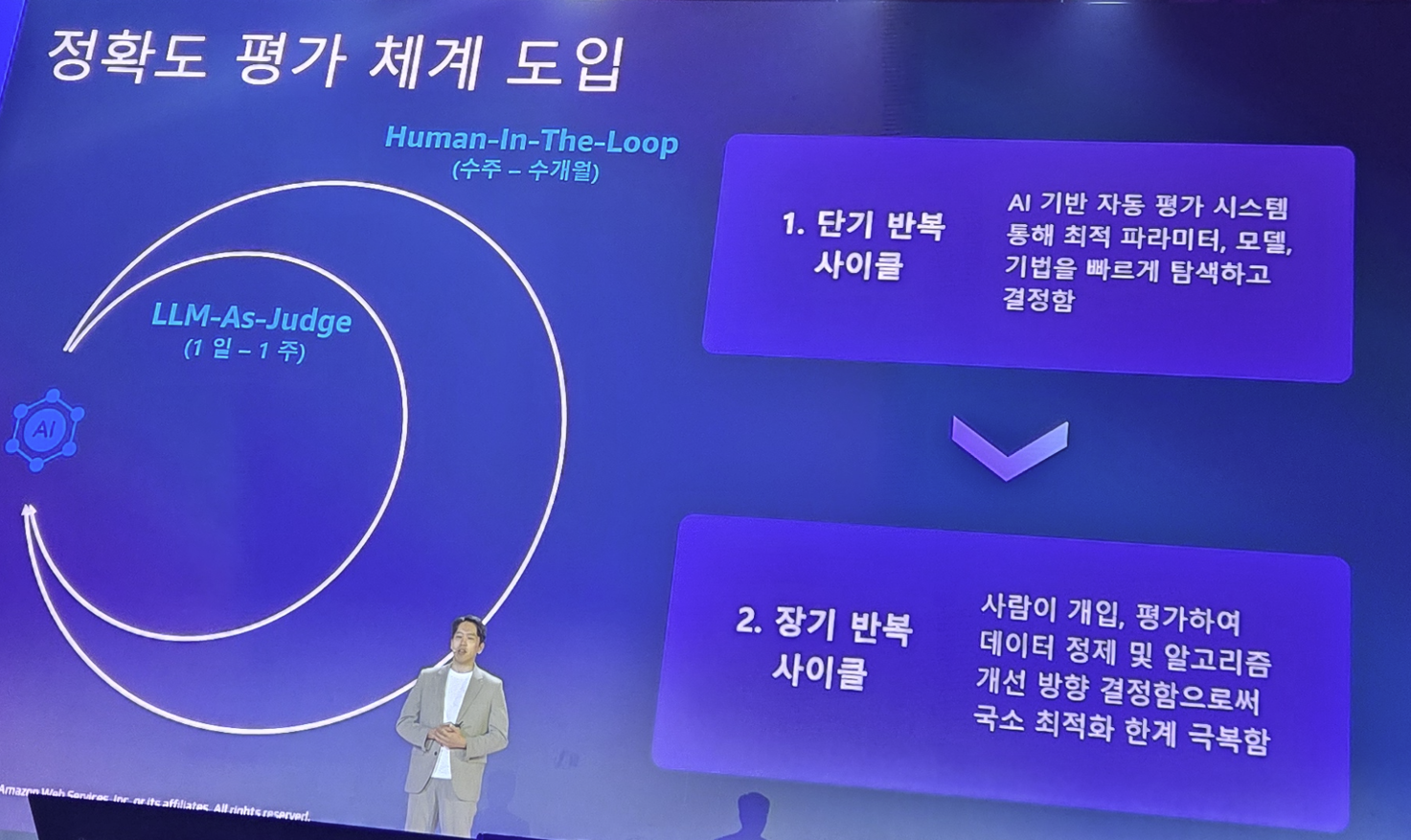

단기 사이클에서는 AI 평가를 진행하고, 장기 사이클에서는 사람의 평가를 이용합니다.

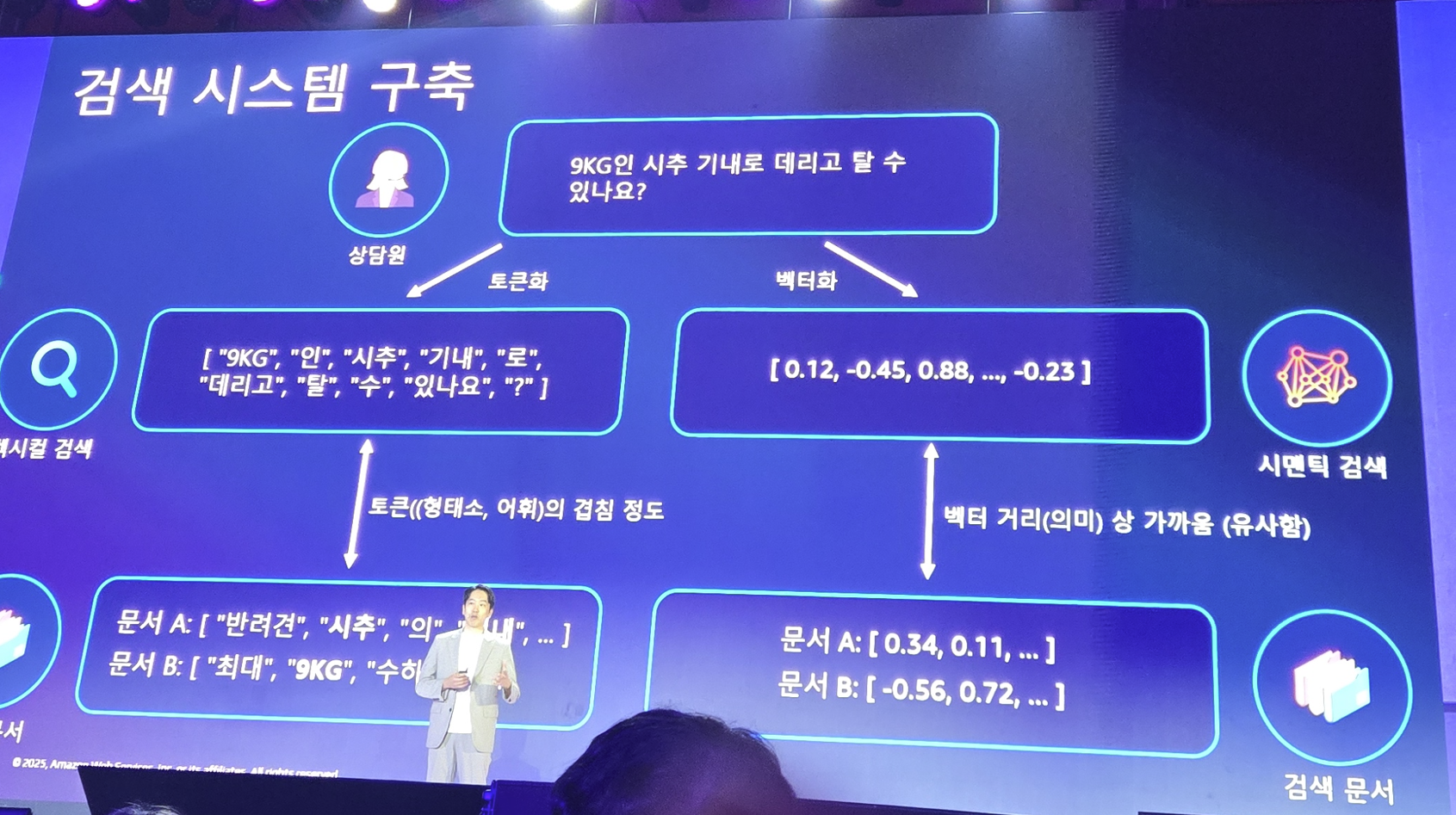

그리고 OpenSearch가 잘 검색할 수 있도록 벡터화를 신경씁니다.

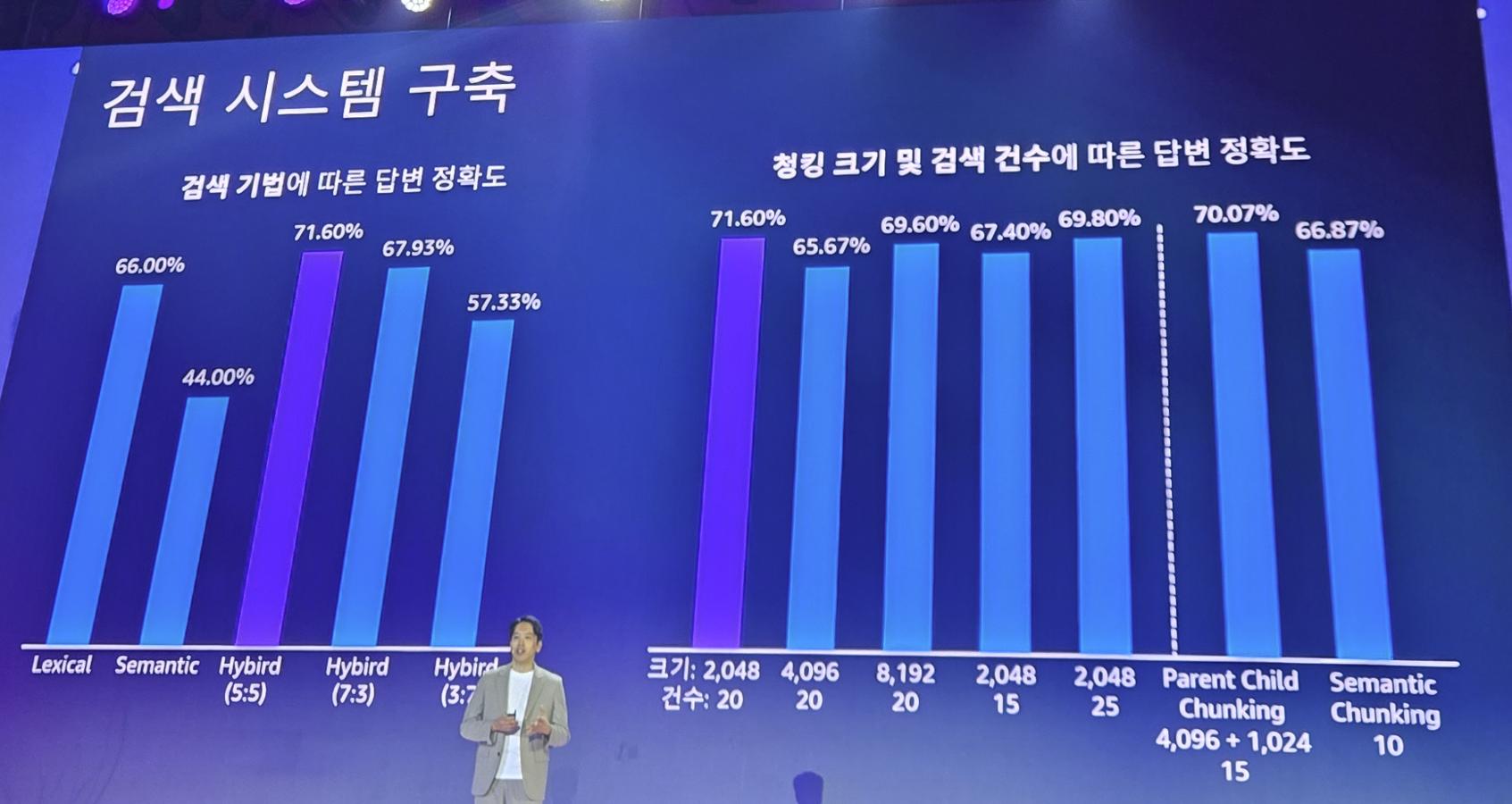

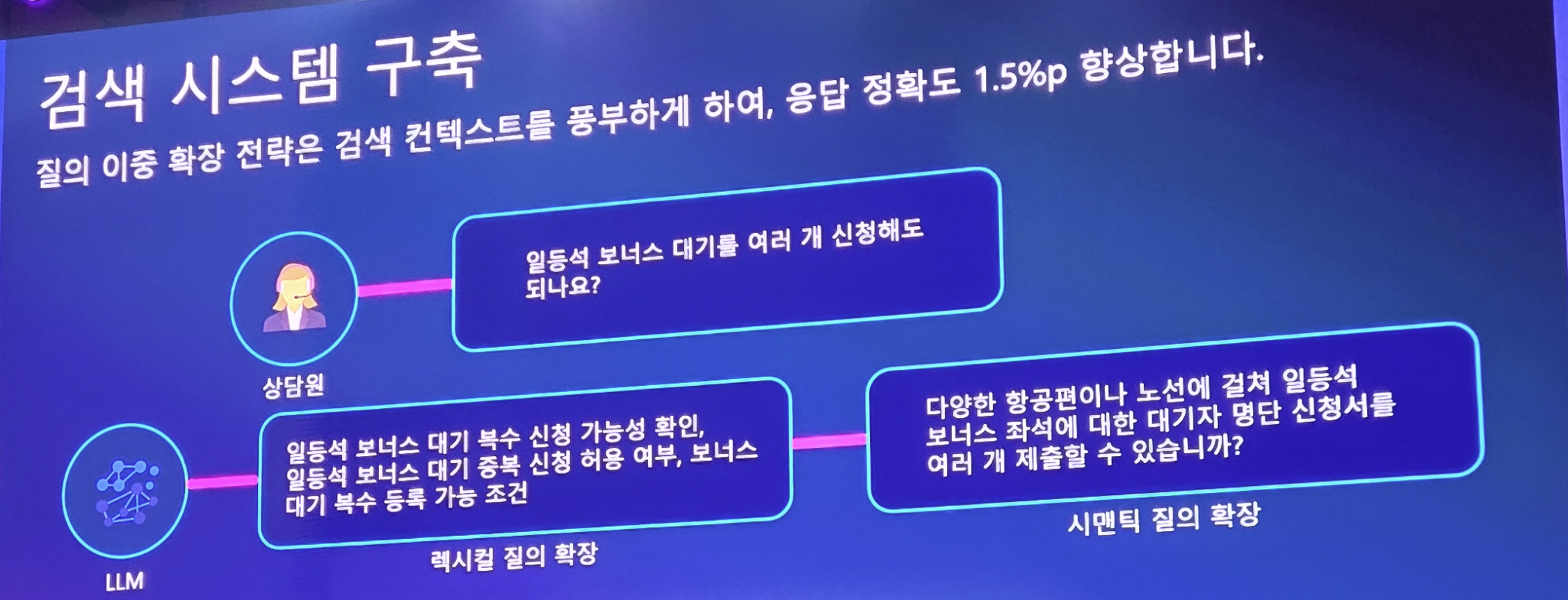

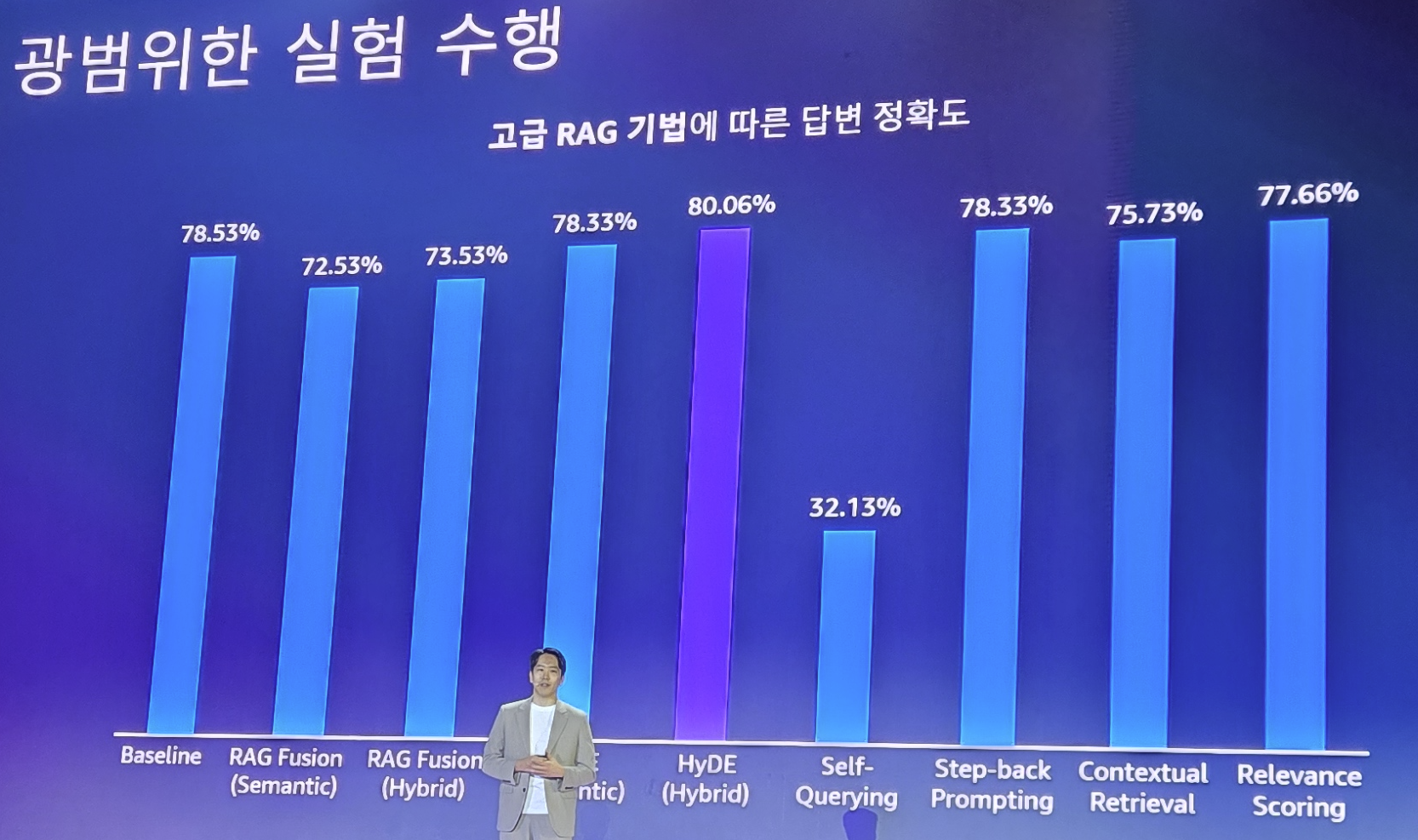

그리고 다양한 방법론을 시도를 하여.. 가장 높은 성능의 검색 방법론을 채택합니다.

대한항공은 Lexical과 Semantic 을 5:5 섞은 방법을 채택합니다.

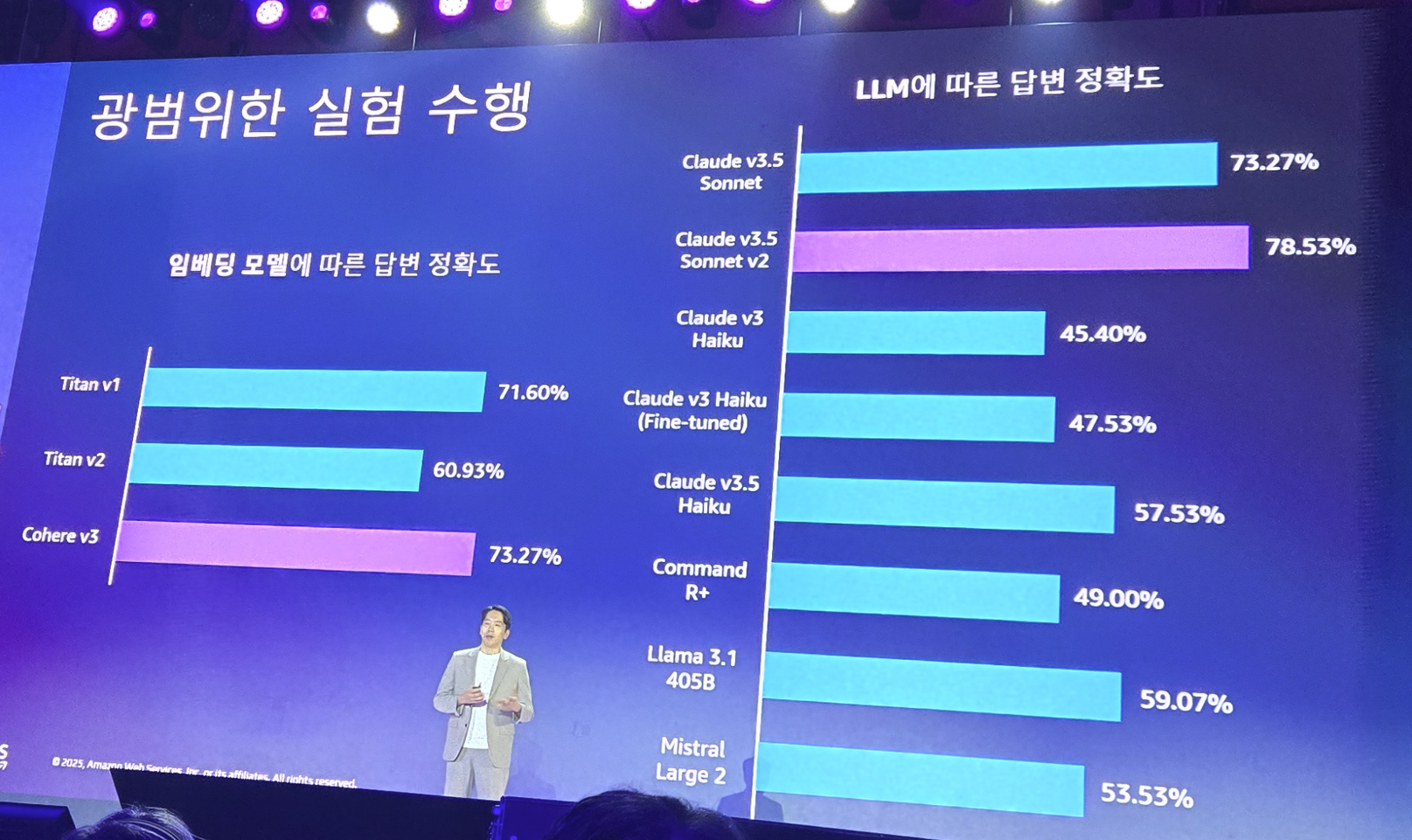

그리고 어떤 임베딩 모델과 LLM 모델이 좋을지도 실험을 합니다.

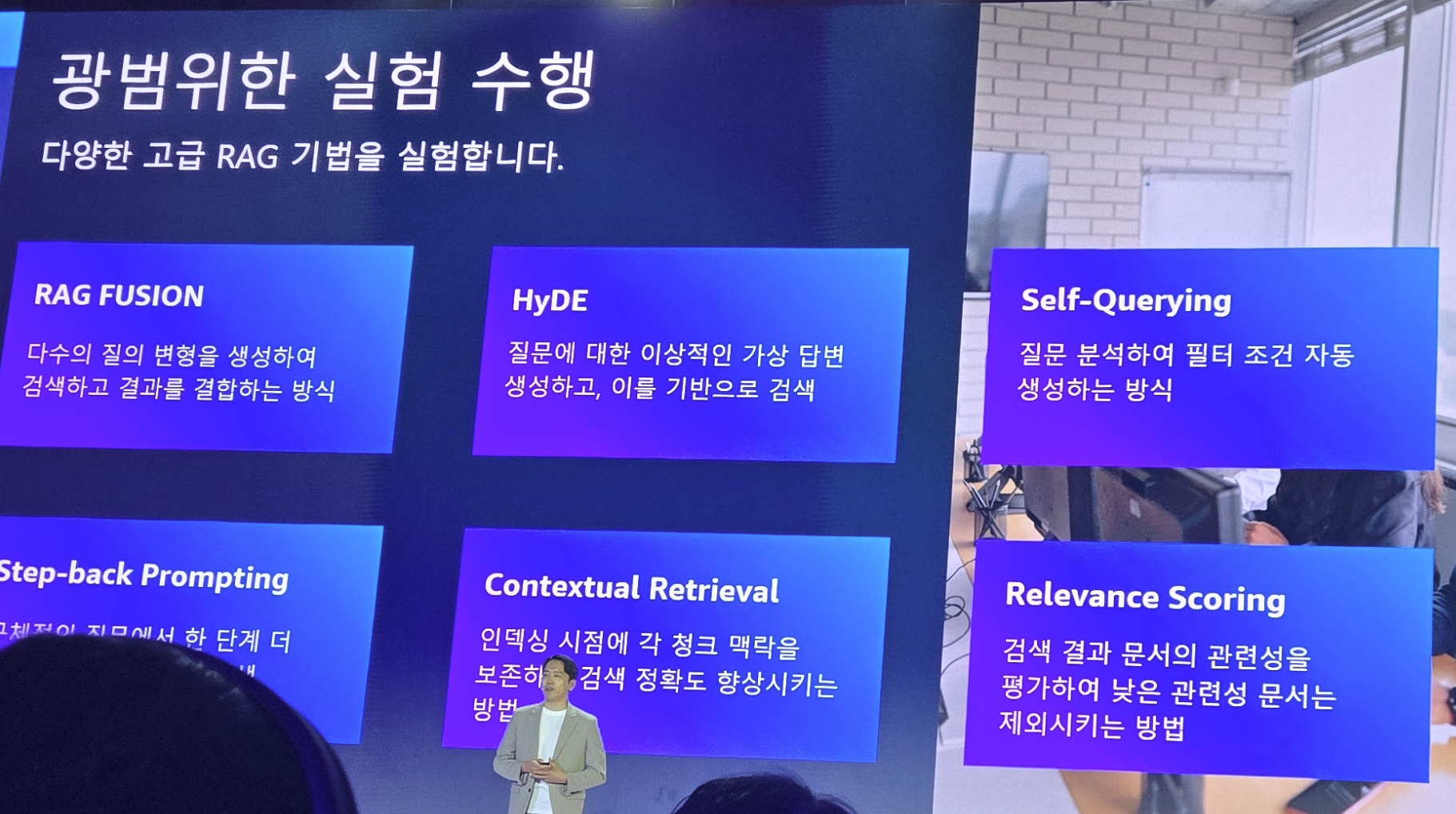

또한 RAG의 기법들도 다양하게 시도해봅니다.

대한항공은 HyDE를 선택하였습니다.

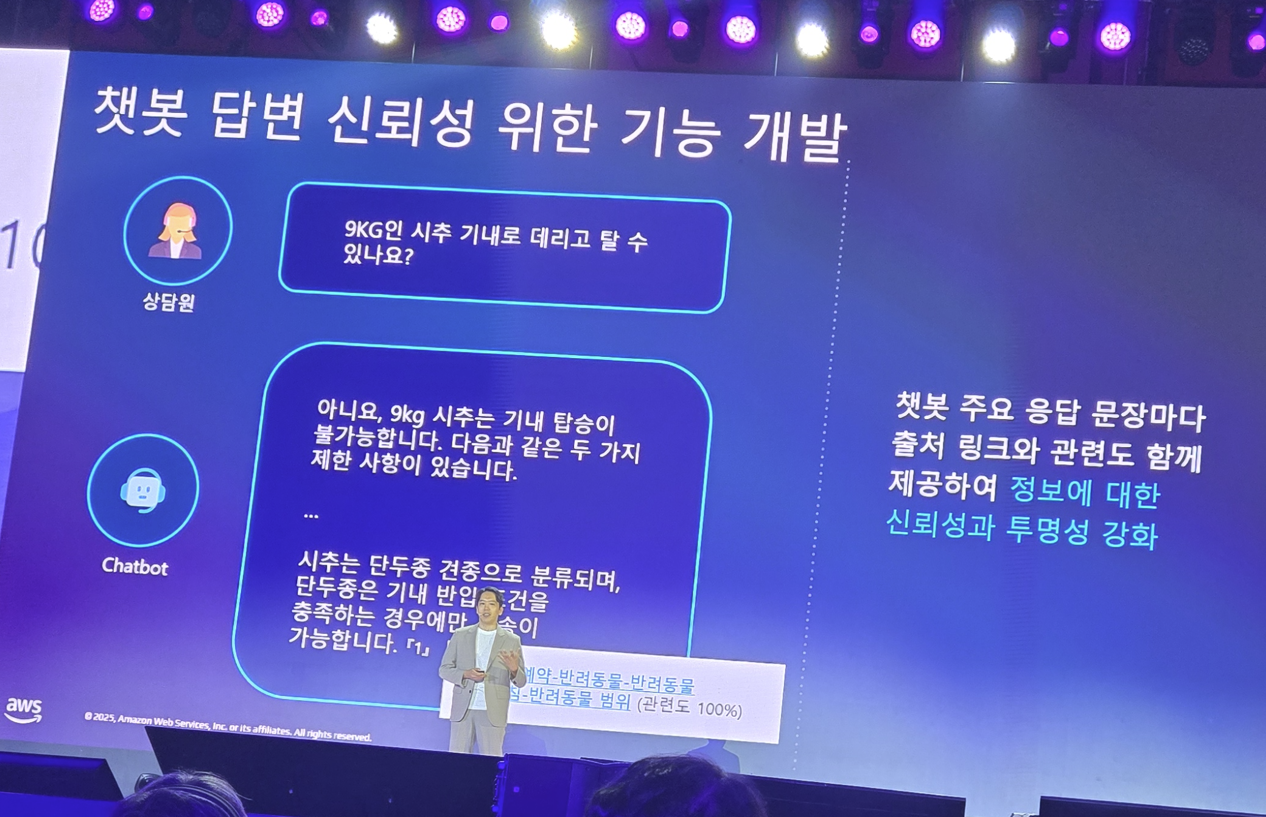

이를 통해 챗봇이 만들어졌는데, 기존 챗봇의 문제는 답변이 할루시네이션이 발생했는지 판별하기 어렵다는 문제가 있습니다. 그래서 챗봇 답변에는 항상 정보의 출처를 표기하게 합니다. (툴팁 방식)

이러한 많은 실험과.. 자신들의 데이터셋에 맞는 최적의 결과를 탐색하여 답변 정확도를 80% 달성합니다.

이러한 모든 서비스들은 AWS 위에서 동작합니다.

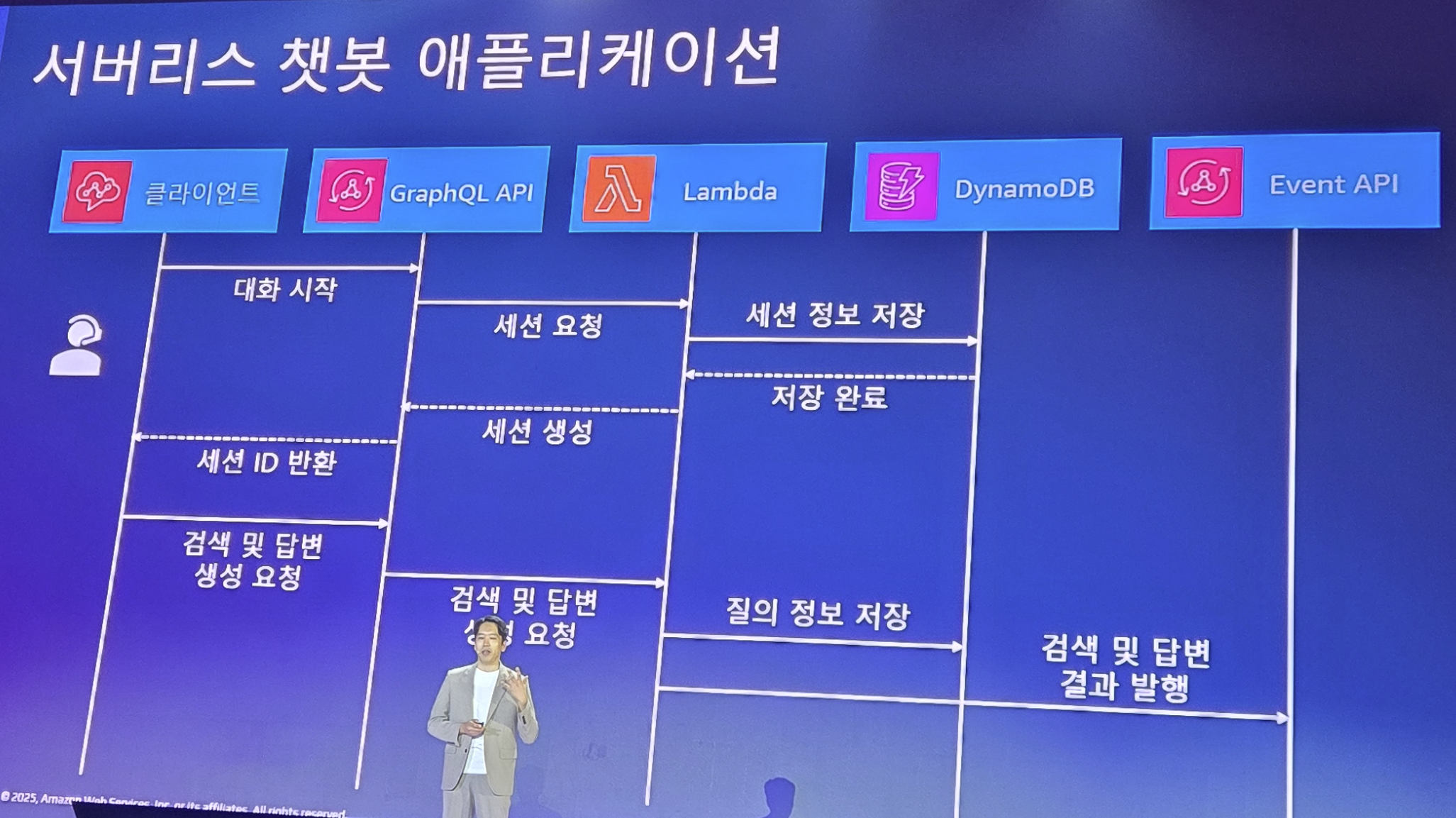

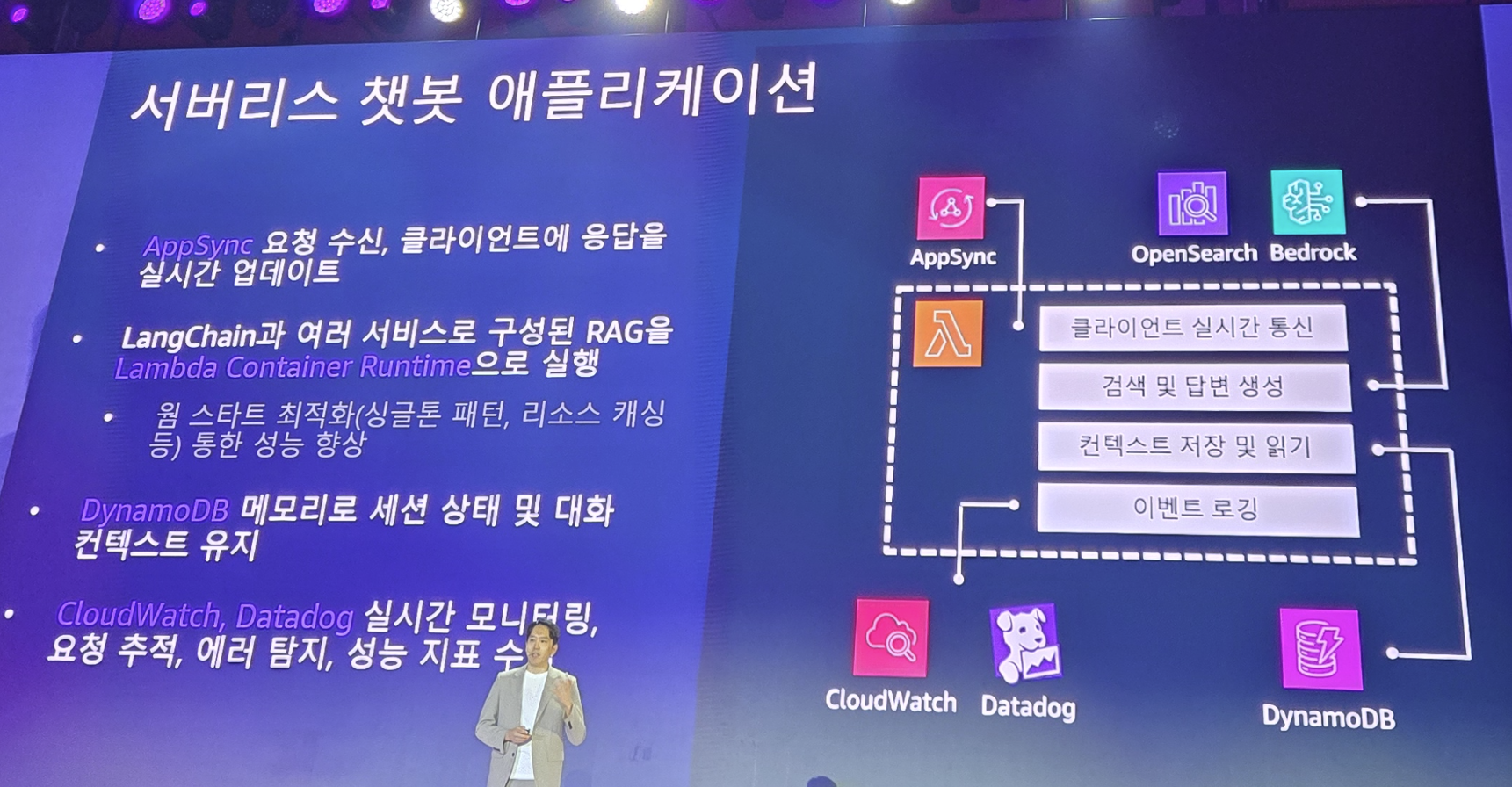

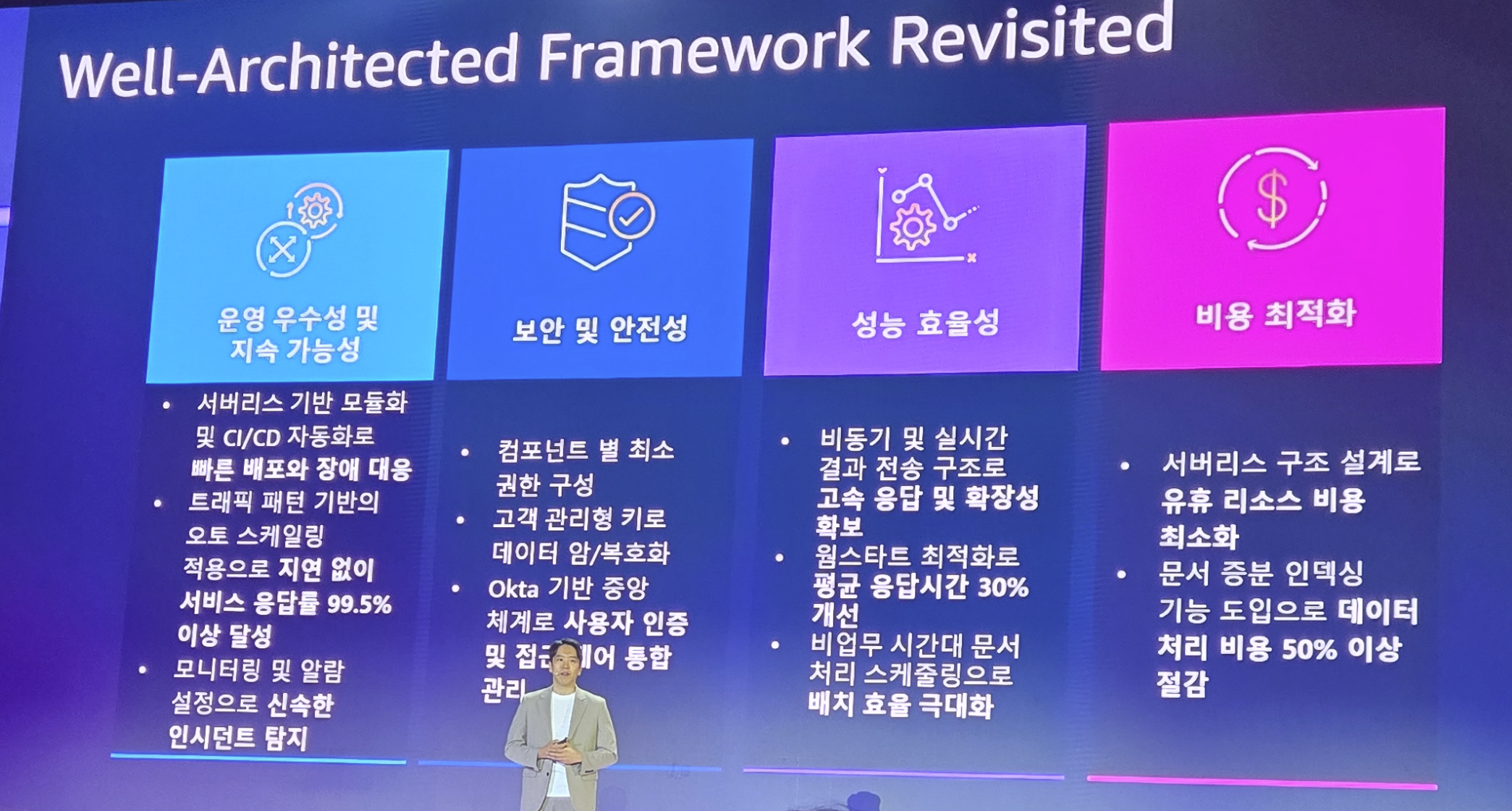

서버리스 기반의 아키텍처를 도입하여 비용도 효율화 시킬 수 있었습니다.

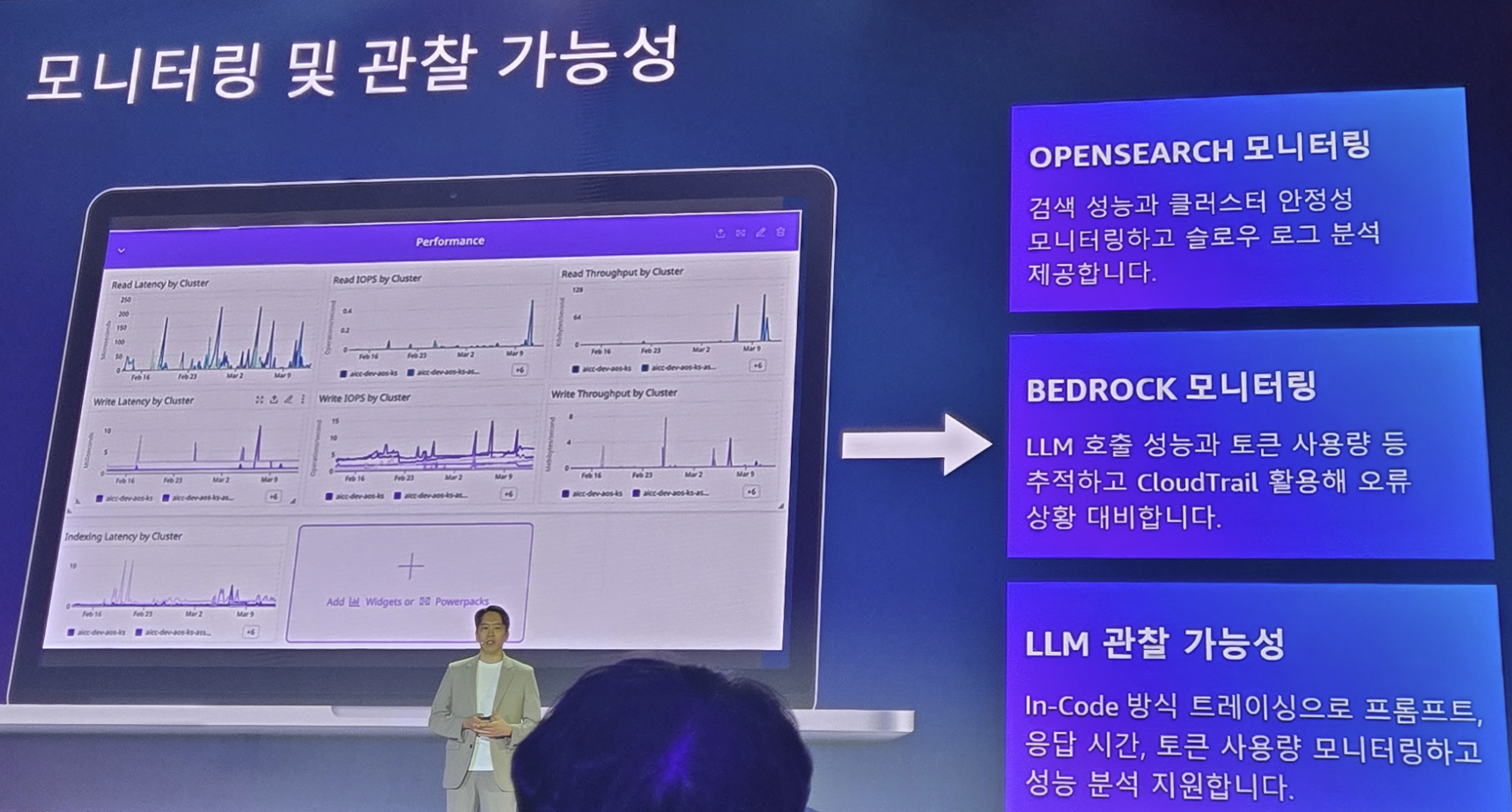

또한 관측 및 추적을 통해 오류를 파악하고, 성능을 관리할 수 있게 됩니다.

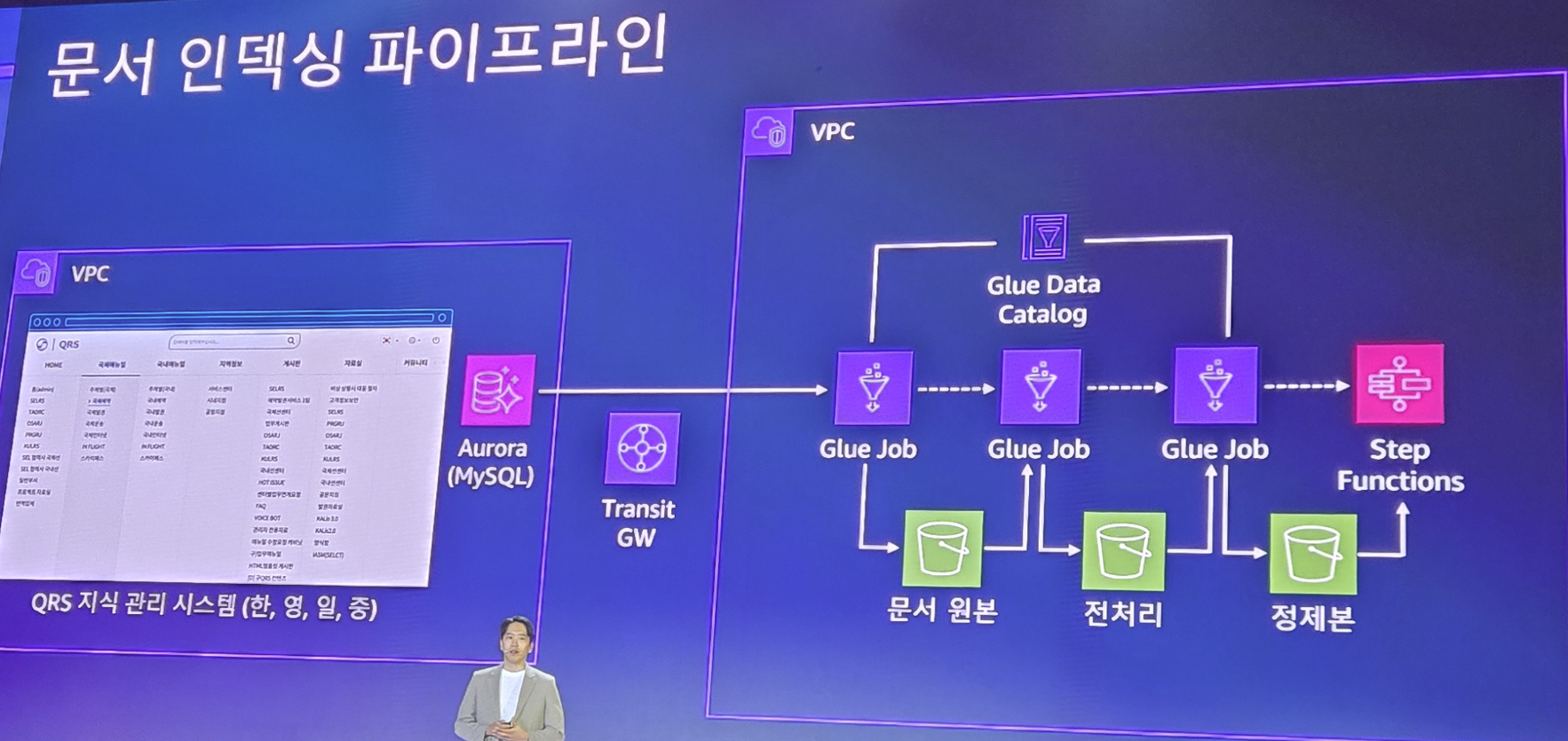

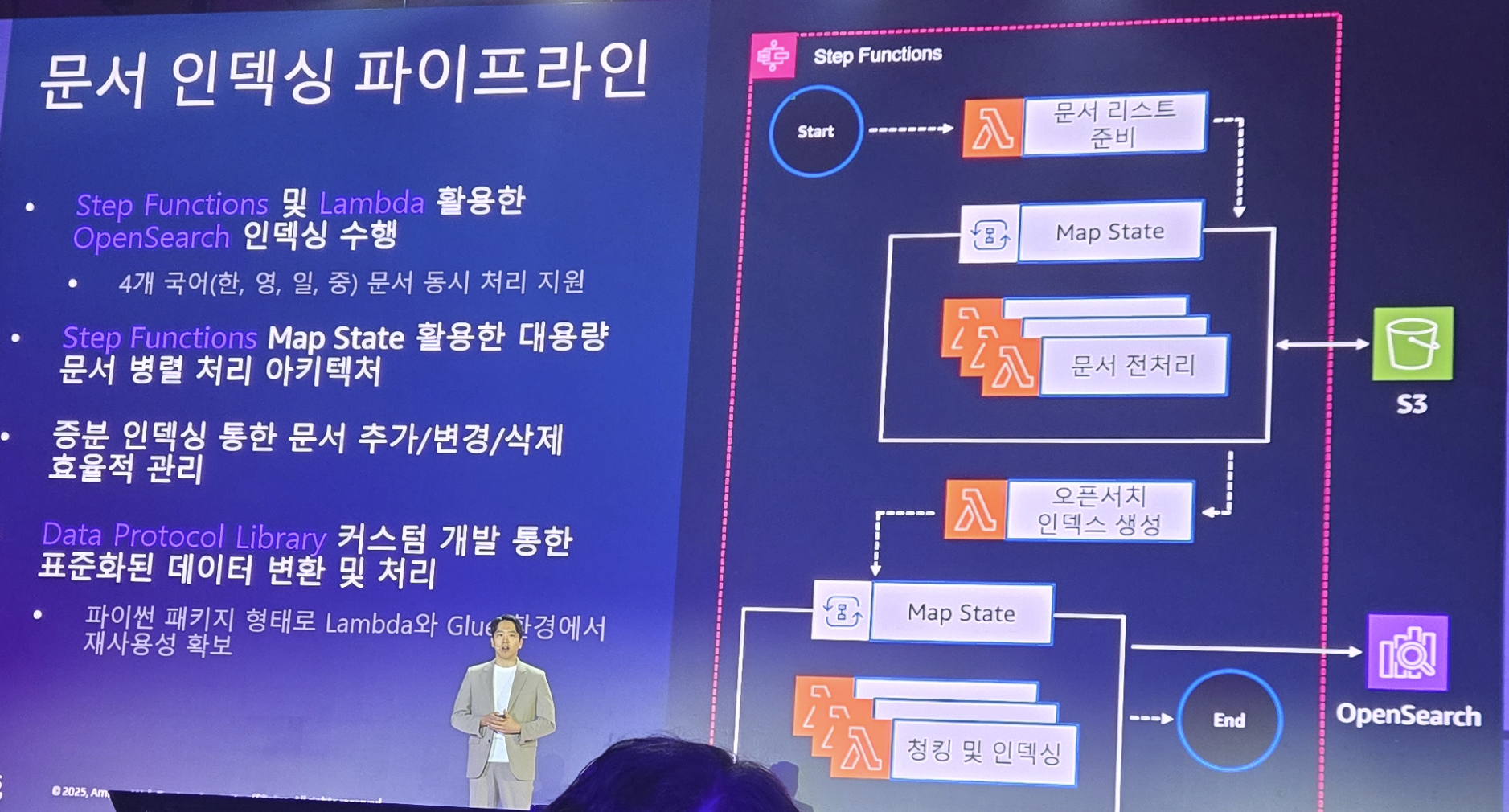

그리고 검색 엔진의 베이스가 되는 데이터들에 대해서도 인덱싱 파이프라인을 효율적으로 디자인하여 정보의 관리를 효율적으로 할 수 있게 합니다.

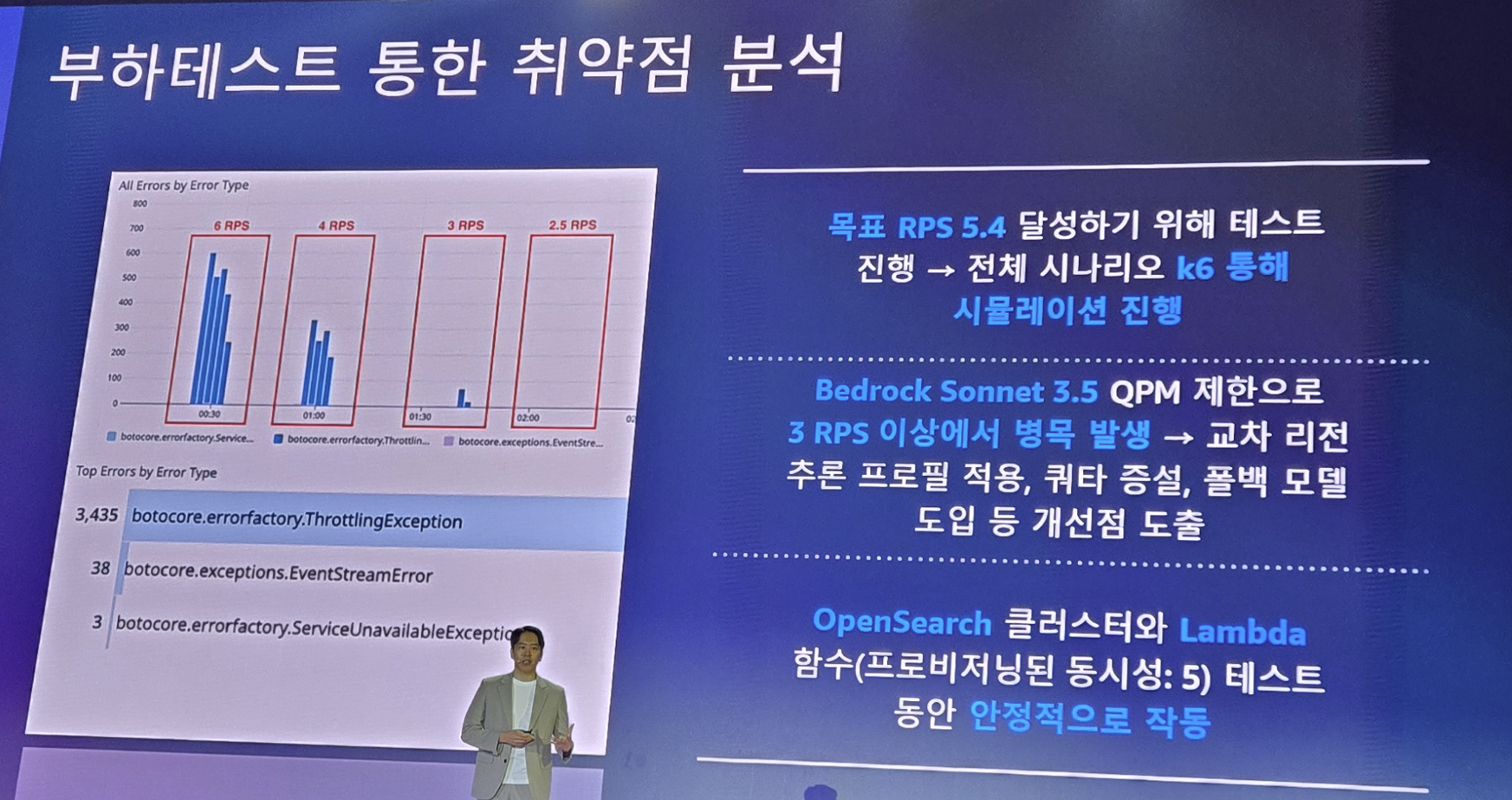

서비스 부하 테스트 도구인 k6를 사용하여, 부하 테스트도 진행하여 서비스 안정성도 향상 시킵니다.

모니터링 대시보드를 잘 만들어서.. 전체적인 상황을 파악하고, 이상을 사전에 감지하게 됩니다.

서버리스의 도입, 비용 최적화, 성능 효율성, 보안/안정성을 모두 챙긴 이러한 아키텍처들로 인해 서비스 응답률은 99.5%라는 성과와 응답 성능 향상 및 운영 비용 효율화를 달성할 수 있게 됩니다.

이렇게 제가 들은 1일차 세션을 모두 정리해봤습니다